磁共振成像( MRI )是一种有用的软组织或分子扩散成像技术。然而,获取 MR 图像的扫描时间可能相当长。有几种方法可以用来减少扫描时间,包括矩形视场( RFOV )、部分傅里叶成像和采样截断。这些方法要么导致信噪比( SNR )降低,要么导致分辨率降低。有关更多信息,请参阅k 空间教程:更好地理解 k 空间的 MRI 教育工具。

当使用采样截断技术以减少扫描和数据传输时间时,吉布斯现象也称为振铃或截断伪影,会出现在结果图像中。通常,通过平滑图像来消除吉布斯现象,从而降低图像分辨率。

在这篇文章中,我们探索了一种使用 NVIDIA Clara AGX 开发者套件的深度学习方法,以消除磁共振图像中的吉布斯现象和噪声,同时保持高图像分辨率。

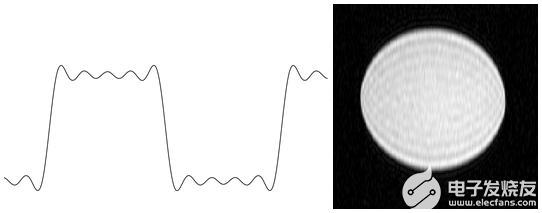

信号可以表示为频率和相位变化的正弦波的无限和。 MR 图像通过使用相对较少的 h ARM 电子近似,从而导致吉布斯现象的存在。图 1 显示了一个类似的一维情况,即仅用几个 h ARM 电子近似方波,右侧 MRI 模型中的吉布斯现象。

图 1 。(左)截断伪影,也称为吉布斯现象,仅使用五个 h ARM 源近似方波时显示:Wikipedia. (右)二维 MRI 模型中显示的吉布斯现象。

数据集和模型

我们扩展了现有的用于 Gibbs 和噪声消除的深度学习方法 dldegibbs 的工作。有关更多信息,请参阅扩散磁共振成像中 Gibbs 神经网络的训练与去噪。该白皮书的代码在/mmuckley/dldegibbs GitHub repo 中。

在他们的工作中,大约 130 万张模拟吉布斯现象和高斯噪声的 ImageNet 图像被用作训练数据。在我们的项目中,我们测试了 Muckley 等人开发的一些预训练 dldegibbs 模型,并使用开放图像数据集训练了我们自己的模型。我们最后用 MRI 扩散数据测试了不同的模型。

为什么要模拟吉布斯现象?

与其他网络相比,使用 dldegibbs 的一个好处是它不需要访问原始 MRI 数据和系统参数。该数据很难获得,因为该数据的存储要求很高,并且在图像重建后通常不会保留该数据。

另一个好处是不需要专有信息或与供应商签署研究协议。此外,还可以节省收集和分发医疗数据的时间,这可能是一项挑战。使用异构数据集(如 ImageNet 或 Open Images )对模型进行训练有可能使该方法应用于其他 MRI 序列或成像模式,因为训练数据本质上是对象不可知的。

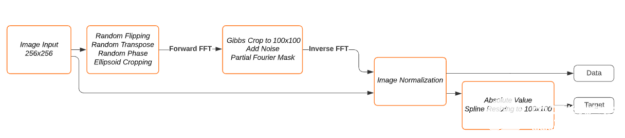

dldegibbs 的数据加载程序为每个加载的映像创建两个映像:一个训练映像和一个目标映像。在傅里叶域中模拟原始图像上的吉布斯现象生成训练图像。将调整原始图像的大小并将其用作目标图像。数据加载程序包括标准数据增强方法(随机翻转、裁剪),然后是随机相位模拟和椭圆裁剪。接下来,对原始图像进行 FFT 处理,进行 Gibbs 裁剪,添加复高斯噪声,并模拟部分傅里叶变换。最后,应用逆 FFT 对图像进行归一化处理。图 2 显示了模拟管道。

图 2 。吉布斯现象方框图与噪声模拟。

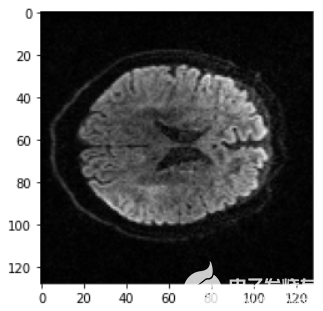

在这个项目中,我们使用了由 170 多万张训练图像组成的开放图像数据集。然后,我们在由 170 名患者( 996424 个轴向切片)[5]组成的磁共振扩散数据集上测试训练模型。图 3 显示了一个示例 MRI 扩散切片。

图 3 。测试集中使用的 MRI 扩散轴向切片示例。

结果

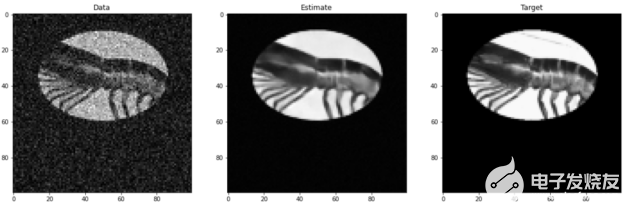

图 4 显示了使用 dldegibbs 模型测试的验证图像示例,该模型使用完全开放的图像训练数据集进行训练。图 5 显示了相应的错误。训练图像在傅里叶空间从 256 × 256 裁剪到 100 × 100 。该模型未模拟部分傅里叶成像。

图 4 。示例 dldegibbs 输入(数据)、输出(估计)和来自 Open Images 验证数据集的目标图像。

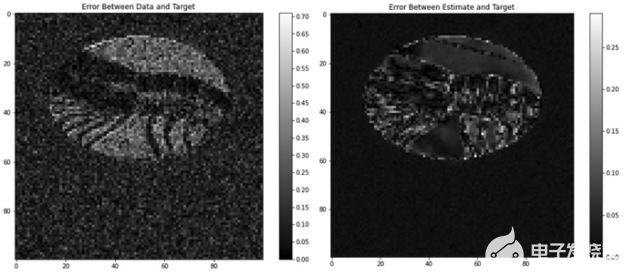

图 5 。数据输入和目标之间的误差(左)和估计输出和目标之间的误差(右)。

数据与目标之间的平均 MSE 为 13 。 2 ± 9 。 2% 。估计值与目标值之间的平均误差为 2 。 9 ± 2 。 7% 。对于此图像, dldegibbs 模型可使图像质量提高 10% 以上。

概括

在这篇文章中,我们提供了一个可以与 Clara AGX 开发工具包一起使用的解决方案,使用以下资源从 MR 图像中去除噪声和吉布斯现象:

一种商用数据集,称为 Open Images

一个开源的 ML 模型,称为 dldegibbs

关于作者

Emily Anaya 是 NVIDIA Clara AGX团队的实习生,致力于消除磁共振成像(MRI)中的吉布斯现象和噪音。她也是一名博士。斯坦福大学电子工程专业的候选人,她的顾问是克雷格·莱文博士。她的研究重点是解决正电子发射断层成像和磁共振成像(PET/MRI)组合中的光子衰减问题。

Emmett McQuinn 是 NVIDIA Clara AGX 团队的高级工程师。埃米特之前是一家助听器初创公司的创始工程师,领导机器学习和 DSP 团队,具有自主机器人、科学可视化和超低功耗神经网络芯片的工作经验。

审核编辑:郭婷

-

芯片

+关注

关注

459文章

51828浏览量

432227 -

神经网络

+关注

关注

42文章

4793浏览量

102029 -

NVIDIA

+关注

关注

14文章

5175浏览量

105254

发布评论请先 登录

相关推荐

交通运输领先企业率先采用NVIDIA Cosmos平台

NPU在深度学习中的应用

AI大模型与深度学习的关系

GPU计算主板学习资料第735篇:基于3U VPX的AGX Xavier GPU计算主板 信号计算主板 视频处理 相机信号

NVIDIA推出全新深度学习框架fVDB

深度学习模型量化方法

深度学习中的时间序列分类方法

深度学习中的无监督学习方法综述

深度学习与nlp的区别在哪

深度学习中的模型权重

深度学习常用的Python库

深度学习与传统机器学习的对比

深度解析深度学习下的语义SLAM

使用NVIDIA Clara AGX深度学习减少MRI扫描次数

使用NVIDIA Clara AGX深度学习减少MRI扫描次数

评论