NVIDIA 发布了基于 Jetson Xavier NX 模块的 NVIDIA Jetson Xavier NX 开发工具包 。 Jetson Xavier NX 以低于 15W 的功率,以紧凑的外形提供多达 21 台计算之巅,为边缘AI设备和自主机器带来服务器级性能和云原生工作流。

借助 Jetson Xavier NX 开发者工具包,您可以创建令人惊叹的人工智能驱动应用程序,并快速将深度神经网络( DNN )模型和流行的机器学习框架部署到该领域。 NVIDIA JetPack 4 . 4 开发者预览版 的初始软件支持包括 CUDA Toolkit 10 . 2 和 cuDNN 8 . 0 、 TensorRT 7 . 1 和 DeepStream 5 . 0 的预览版,以及用于机器学习的新 Docker 容器和预训练的 DNN 模型。

Jetson Xavier NX 基于 NVIDIA 开创性的 Xavier SoC ,可以并行运行多个复杂模型和多个高清传感器流。它包括以下功能:

具有 48 色张量的集成 NVIDIA volta384 核 Volta GPU

两个 NVIDIA 深度学习加速器引擎

七路 VLIW 视觉加速器

六核 NVIDIA Carmel 64 位 ARMv8 . 2 CPU

8-GB 128-bit LPDR4x

为了进一步简化边缘人工智能应用程序在生产环境中的部署, 预训练模型 将云原生技术引入 Jetson ,包括基于 Docker 的集装箱化,以及 Kubernetes 等硬件传递和编排服务,以及 NVIDIA NGC 注册表提供的 预训练模型 和 NVIDIA 。

Jetson Xavier NX 开发工具包

Jetson Xavier NX 开发工具包捆绑了一个开源的 参考载体板 和预装配的散热片/风扇,如图 2 所示,包括 19V 电源和基于 M.2 的 802.11 WLAN + BT 模块。除了可引导 microSD 卡插槽外,在载体底部还提供了一个 M . 2 Key-M NVMe 插槽,用于扩展高速存储。

因为 Xavier NX 模块向后兼容 Jetson Nano ( B01 ),它们的载体板有一些共同点 – 还包括双 MIPI CSI 摄像头连接器,以及四个 USB 3.1 端口、 HDMI 、 DisplayPort 、千兆以太网和一个 40 针 GPIO 头。

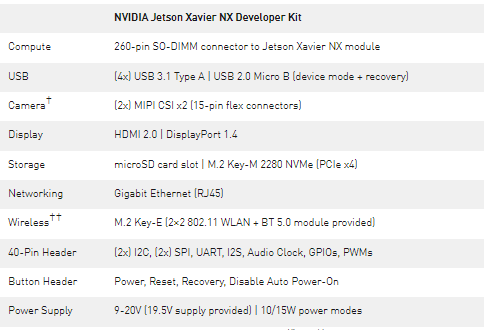

套件载体板的主要特性和接口如表 1 所示。有关 Jetson Xavier NX 计算模块的核心处理能力和规格的更多信息,请参阅 介绍世界上最小的人工智能超级计算机 Jetson Xavier NX post 和 Jetson Xavier NX 模块数据表 。

表 1 . Jetson Xavier NX 开发者工具包载体板连接和接口。

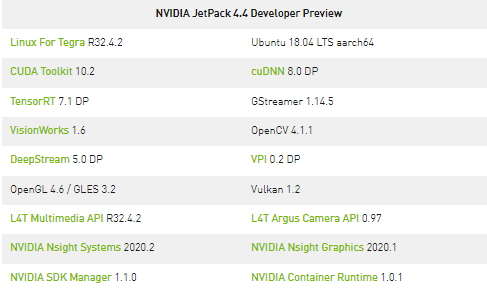

Jetpack4 . 4 开发者预览版

NVIDIA JetPack SDK 包含在Jetson上构建AI应用程序的库、工具和核心操作系统。Jetpack4.4开发者预览版增加了对JetsonXavierNX的支持。它包括CUDA Toolkit 10.2以及cuDNN 8.0、TensorRT 7.1、DeepStream 5.0的预览版,以及用于部署云原生服务的NVIDIA容器运行时,以及表2中所示的其他组件。 为流行的机器学习框架(如TensorFlow和Pythorch)预构建的包安装程序也可以在 Jetson ZOO 获取 , 还有 NGC 上 JetPack 的新框架容器

表 2 . NVIDIA Jetpack4 . 4 开发者预览版 SDK 中可用的软件组件。

为 Jetson Xavier NX 、 Jetson AGX Xavier 、 Jetson TX1 / TX2 和 Jetson Nano 下载 Jetpack4 . 4 开发者预览版 。在收到新的 Jetson Xavier NX 开发工具包后,请按照 入门 指南中的说明,使用 JetPack 映像闪存 microSD 卡。

这个开发者预览版可以用来安装和运行 Jetson Xavier NX 开发者工具包并开始应用程序开发,而生产 Jetpack4 . 4SDK 计划在今年夏天晚些时候发布。安装 JetPack 之后,您可以跟随一些 AI 驱动的 Jetson 社区项目 。

深度学习推断基准

Jetson 可用于将广泛流行的 DNN 模型和 ML 框架部署到边缘,并具有高性能的推断,用于实时分类和目标检测、姿势估计、语义分割和自然语言处理( NLP )等任务。

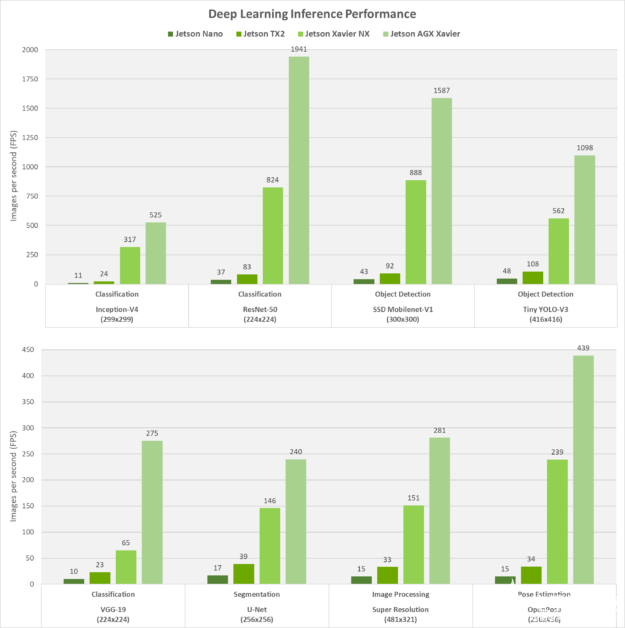

JetPack SDK 和 NVIDIA CUDA -X 对 Jetson 和 NVIDIA 离散的 GPU 的共同支持意味着您可以轻松地将性能和尺寸、重量和功耗(交换)消耗降低到 5W ,而无需重新编写应用程序。图 3 显示了 Jetson Nano 上流行的视觉 DNN 的推断基准, Jetson TX2 、 Jetson Xavier NX 和 Jetson AGX Xavier 以及 Jetpack4 . 4 开发者预览版和 TensorRT 7 . 1 。这些结果可以通过从 GitHub 运行开放的 jetson_benchmarks 项目来复制。

图 3 。用 TensorRT 来推断 Jetson 家族中各种基于视觉的 DNN 模型的性能。

在 Jetson Xavier NX 和 Jetson AGX Xavier 上, NVIDIA 深度学习加速器( NVDLA )发动机和 GPU 同时以 INT8 精度运行,而在 Jetson Nano 和 Jetson TX2 上, GPU 以 FP16 精度运行。 Jetson Xavier NX 的性能比 Jetson TX2 高 10 倍,功耗相同,占地面积小 25% 。

在这些基准测试期间,每个平台都以最高性能运行( MAX-N 模式用于 Jetson AGX Xavier , Xavier NX 和 TX2 为 15W , Nano 为 10W )。这些基于视觉的任务的最大吞吐量是在批大小不超过 15ms 的延迟阈值的情况下获得的。 – 否则,对于平台超过此延迟阈值的网络,批处理大小为 1 。这种方法在实时应用程序的确定性低延迟需求和多流用例场景的最大性能之间提供了平衡。

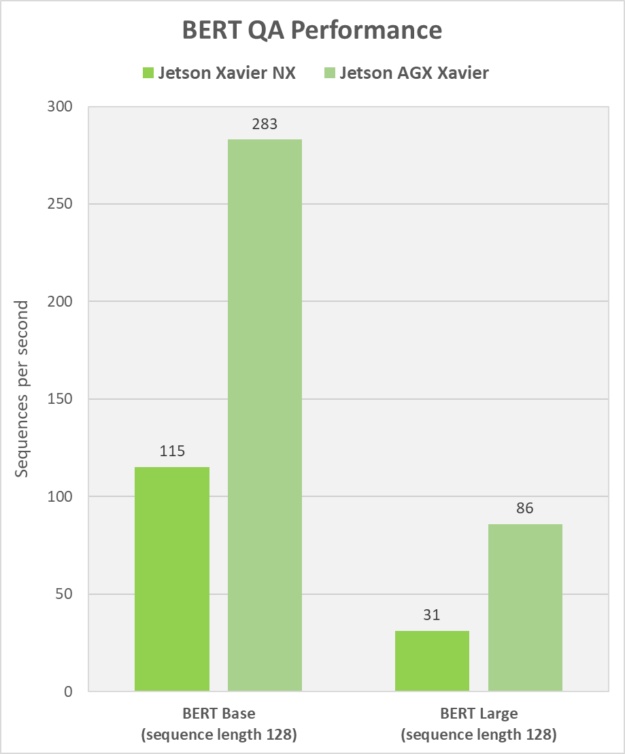

我们还为 BERT 提供问题回答方面的基准测试结果。 BERT 是一种多功能架构,在多个 NLP 任务(包括 QA 、意图分类、情感分析、翻译、名称/实体识别、释义、推荐系统、自动完成)中得到了广泛的应用,还有更多。

TensorRT 传统上过于复杂,无法在本地部署机载边缘设备,尤其是 BERT 大型变体。然而,在 BERT 中包含 BERT 的张量核心优化后, BERT 可以很容易地在 Jetson Xavier NX 和 Jetson AGX Xavier 上运行。

将 BERT 部署到边缘对于低延迟、智能人机交互( HMI )和会话式人工智能非常有用,正如本文后面的多容器演示的 chatbot 部分一样,它也在本地执行自动语音识别( ASR ),而不依赖云连接。

图 4 。 BERT Base 和 BERT 在回答问题时的运行时性能很高,使用 NLP 任务的 50ms 延迟阈值。

图 4 显示了 BERT Base 和 BERT Large 在回答问题时的运行时性能,使用了 NLP 任务的 50ms 延迟阈值。这些结果是以每秒的顺序来衡量的,其中每一个文本序列都是 BERT 回答的一个查询或问题。 BERT 在 Jetson 上的性能为用户提供了近乎即时的反馈,延迟低至 5 . 9ms ,这使得 BERT 处理可以与视频等其他实时处理流同时执行。

将云计算原生方法带到边缘

到目前为止,嵌入式和边缘设备的软件都是以单片系统的形式编写的。升级单片软件映像的复杂性增加了 bug 的风险,并使更新的节奏难以加快。对于具有人工智能的边缘设备来说,这一点尤其有问题,它需要频繁更新以维持快速的能力改进。现代对敏捷能力和零停机时间持续创新的期望要求改变嵌入式和边缘设备软件的开发和部署方式。

在边缘采用云本地的范例,如微服务、容器化和容器编排是前进的方向。

微服务架构、容器化和编排使云应用程序能够摆脱单一工作流的约束。现在, Jetson 正在将云原生转换思想引入 AI 边缘设备。

Jetson 是领先的人工智能边缘计算平台,拥有近 50 万开发者。它由 JetPack SDK 提供支持,该 SDK 具有与世界各地数据中心和工作站相同的 CUDA -X 加速计算堆栈和 NVIDIA 容器运行时。

通过 Jetson 的几个开发和部署容器、容器化框架和托管在 NVIDIA NGC 上的预先训练的 AI 模型,它可以作为 AI 应用程序开发的构建块。最新的 Jetson Xavier NX 以尽可能小的外形尺寸实现全功能、多模式人工智能应用。

我们欢迎使用云本地技术,使客户具有扩展业务所需的生命周期灵活性。可扩展软件开发加快了上市时间。为什么?因为当您不必同时更新其他应用程序组件时,更新产品生命周期的过程会变得不那么繁重。

多容器演示

Jetson Xavier NX 的 NVIDIA 多容器演示 展示了使用云本地方法开发和部署服务机器人 AI 应用程序的过程。服务机器人是一种自主机器人,通常与零售、酒店、医疗保健或仓库中的人互动。

视频。 Jetson Xavier NX 的云原生多容器演示,并行运行七个深度学习模型。

考虑一个服务机器人,它的目的是通过与购物者交互来改善零售百货公司的客户服务。机器人只有在能够执行包括人体识别、交互检测、人体姿态检测、语音检测和自然语言处理在内的许多计算任务时,才能为客户的查询提供有用的答案。机器人必须运行支持这些功能所需的多个人工智能模型。

有了云原生方法,人工智能模型可以独立开发,包含所有依赖项的容器化,并部署到任何 Jetson 设备上。

该演示程序在 Jetson Xavier NX 上同时运行四个容器,具有七个深度学习模型,包括姿势估计、面部和凝视检测、人物计数、语音识别和 BERT 问答。结果是,这些服务构建块容器可以轻松地修改和重新部署,而不会造成中断,从而提供零停机时间和无缝更新体验。

在没有牺牲所有数据流的计算能力的情况下,[zd-9]提供了一个传感器的计算能力。您可以使用 NGC 上托管的容器从 NVIDIA-AI-IOT/jetson-cloudnative-demo GitHub repo 下载演示。

在边缘计算领域实现下一个飞跃

计算性能、紧凑、省电的外形和全面的软件支持使 Jetson Xavier NX Developer Kit 成为创建高级 AI 驱动应用程序并部署到边缘的理想平台。

关于作者

达斯汀是 NVIDIA 的 Jetson 团队的开发人员布道者。 Dustin 拥有机器人和嵌入式系统方面的背景,他乐于在社区中提供帮助,并与 Jetson 一起参与项目。

Suhas Sheshadri 是 NVIDIA 的产品经理,专注于 Jetson 软件。此前,他曾在 NVIDIA 与自主驾驶团队合作,为 NVIDIA 驱动平台优化系统软件。在业余时间,苏哈斯喜欢读量子物理学和博弈论方面的书籍。

Sarah Todd 是 NVIDIA 嵌入式团队的营销经理。 Sarah 对推动人工智能应用程序实现真正的解决方案非常感兴趣,她负责边缘技术的营销,包括与 Jetson 平台相关的软件和硬件、自主机器和 NVIDIA 机器人技术。

Dustin Franklin 是 NVIDIA 的 Jetson 团队的开发人员布道者。 Dustin 拥有机器人和嵌入式系统方面的背景,他乐于在社区中提供帮助,并与 Jetson 一起参与项目。你可以在 NVIDIA Developer Forums 或 Github 上找到他。

Suhas Sheshadri 是 NVIDIA 的产品经理,专注于 Jetson 软件。此前,他曾在 NVIDIA 与自主驾驶团队合作,为 NVIDIA 驱动平台优化系统软件。

审核编辑:郭婷

-

传感器

+关注

关注

2554文章

51670浏览量

758356 -

NVIDIA

+关注

关注

14文章

5099浏览量

104289

发布评论请先 登录

相关推荐

云计算开发工具包的功能

最新Simplicity SDK软件开发工具包发布

基于EasyGo Vs工具包和Nl veristand软件进行的永磁同步电机实时仿真

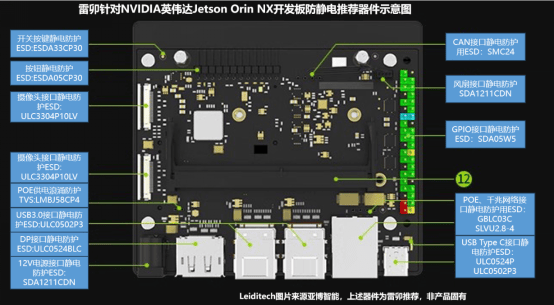

雷卯针对NVIDIA英伟达JETSON Orin NX开发板防静电推荐器件示意图

FPGA仿真工具包软件EasyGo Vs Addon介绍

NVIDIA Jetson-Xavier NX开发工具包的应

NVIDIA Jetson-Xavier NX开发工具包的应

评论