(文/程文智)不久前,AI性能基准评测平台MLPerf公布了2022年首次推理(Inference v2.0)测试成绩,NVIDIA的AI平台表现依然抢眼。

据MLPerf官方介绍,它是由来自学术界、研究实验室和相关行业的 AI 领导者组成的联盟,旨在“构建公平和有用的基准测试”,在规定的条件下,针对硬件、软件和服务的训练和推理性能提供公平的评估。每年组织AI推理和AI训练测试各两次,以对迅速增长的AI计算需求与性能进行及时的跟踪测评。MLPerf比赛通常分为固定任务(Closed)和开放优化(Open)两类任务,开放优化能力着重考察参测厂商的AI技术创新力,固定任务则因更公平地考察参测厂商的硬件系统和软件优化的能力,成为更具参考价值的AI性能基准测试。因此,目前MLPerf被看作是AI领域的风向标,谁能够在这个测试中取得更多的领先,谁的AI能力就越突出。

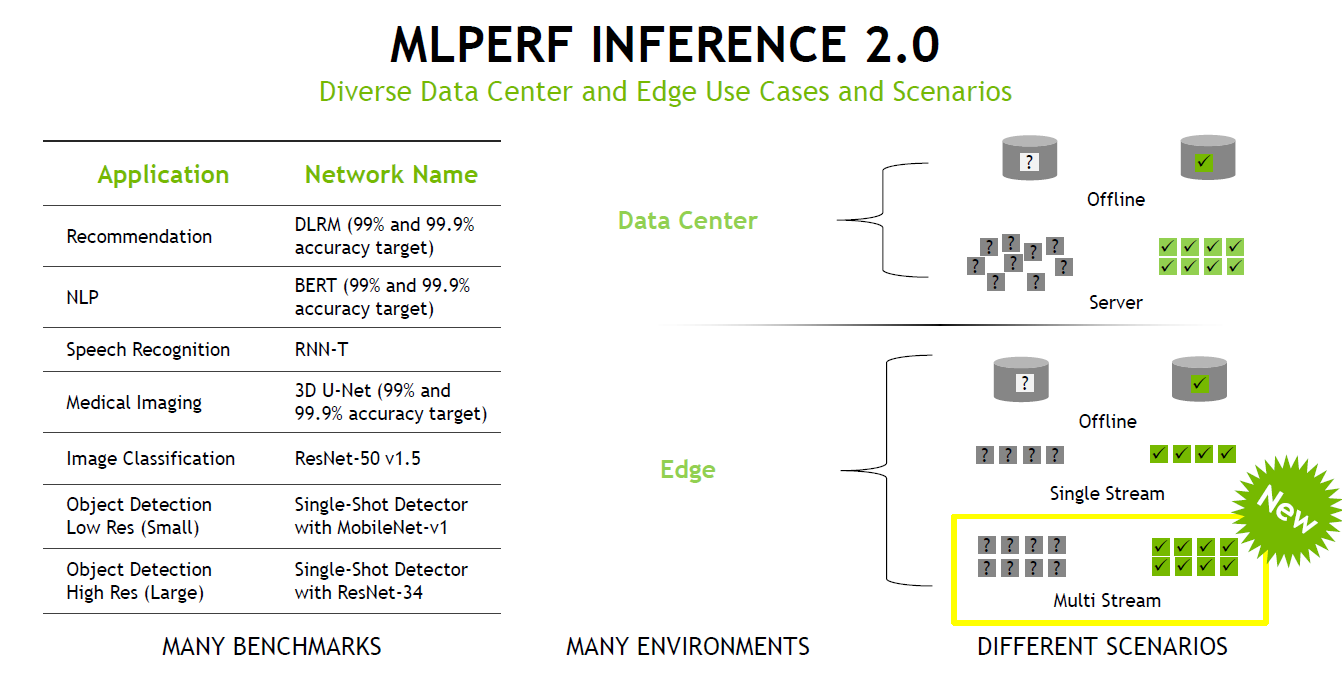

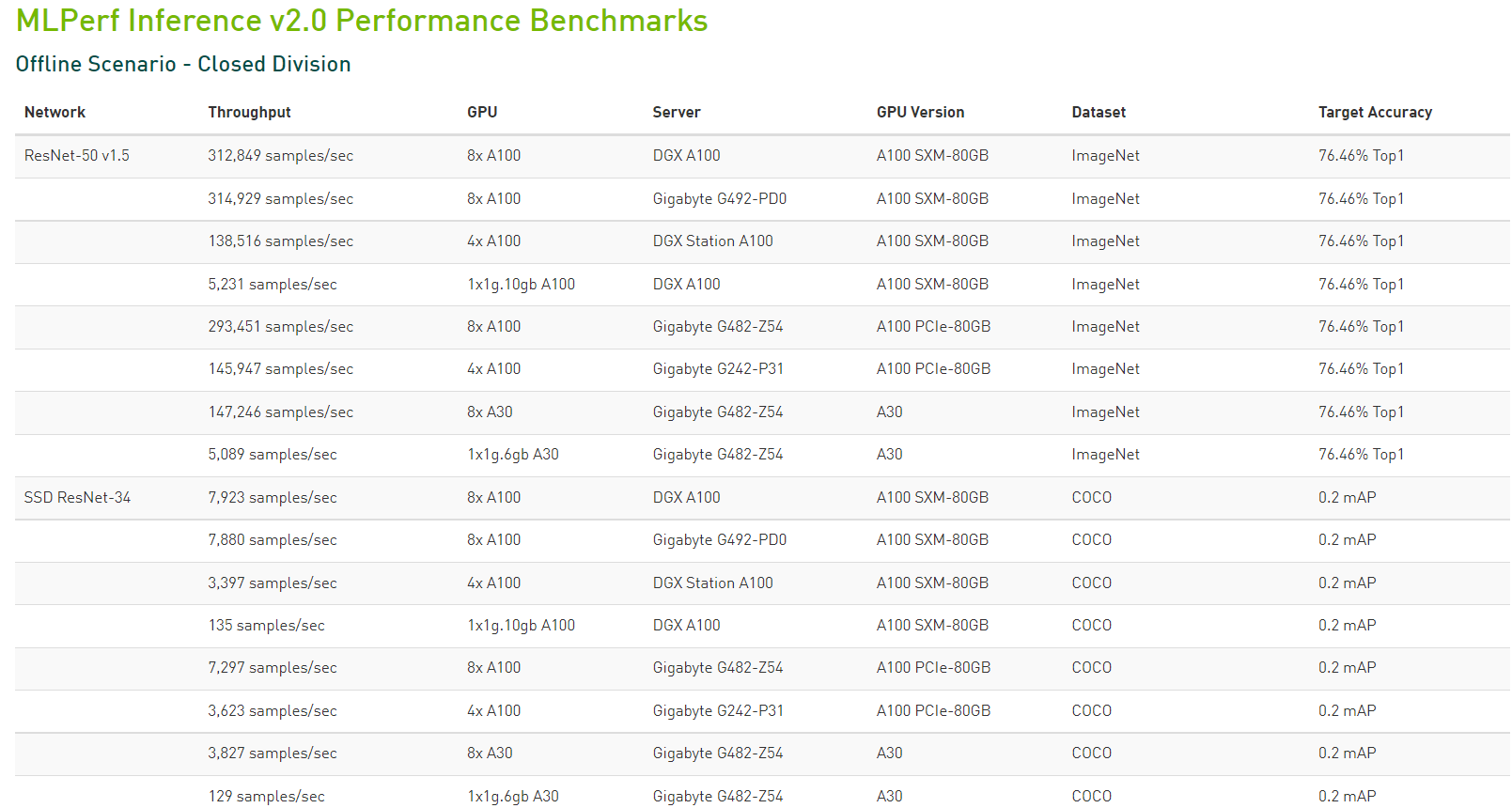

在最新一期的榜单中,浪潮、NVIDIA、英特尔、高通、阿里巴巴、戴尔、Deci.ai、Azure、富士通、技嘉、联想、宁畅、美超微、华硕、浙江实验室、及新华三等厂商参与了竞赛。评测以最新MLPerf Inference V2.0为基准,涵盖了图像分类、目标检测、医疗图像分割、自然语言处理、语音转文字和推荐系统6类AI应用场景,分为数据中心和边缘两类处理场景,每类场景都包含固定任务(Closed)和开放优化(Open)两类性能竞赛。其中,在最新的V2.0规范中,在边缘运算环境导入多资料流(Multi Stream)测试项目,测量边缘运算设备在多摄影机、多传感器场景的性能表现,以得到更贴近真实使用情况的数据。

据统计,本轮测试一共展示了超过3900 次性能测试和 2200 次功耗测试,分别是上一轮的2倍和6倍。根据公开的数据显示,本次测试中除了戴尔科技、富士通、技嘉、浪潮、联想、宁畅和美超微等外,华硕和新华三本次测试中首次使用了NVIDIA AI平台提交MLPerf结果。

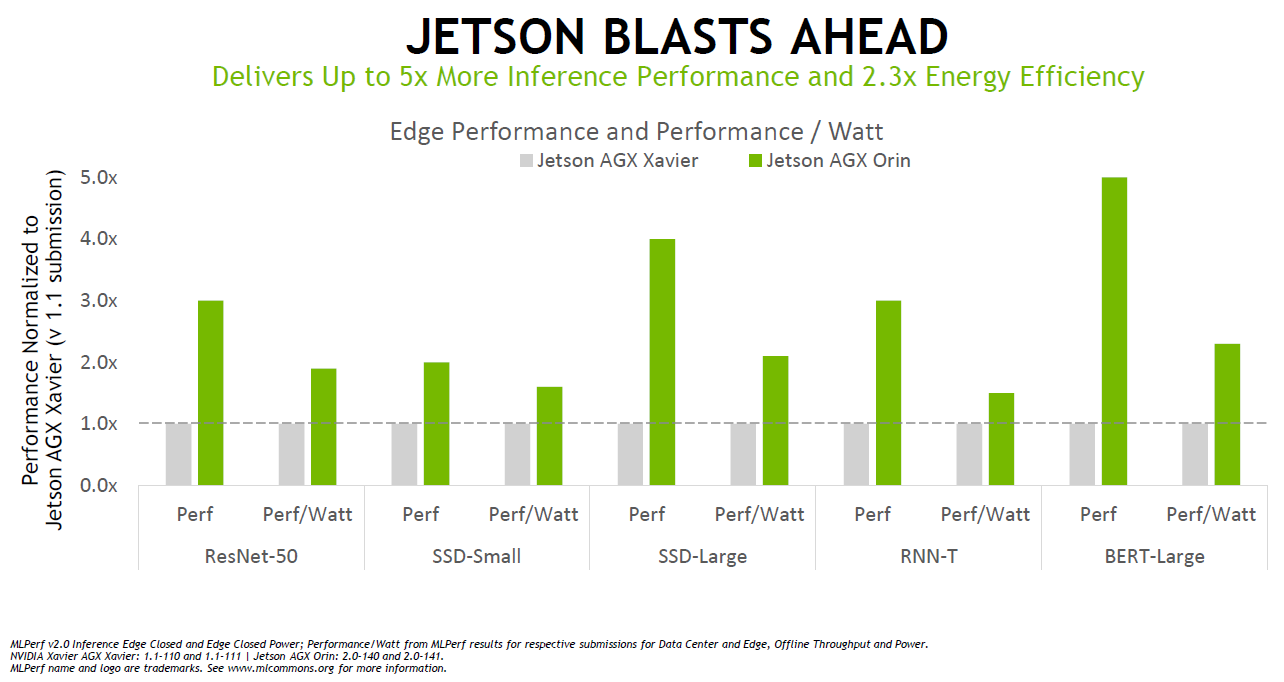

Jetson AGX Orin提升边缘AI性能,取得不俗成绩

值得一提的是基于NVIDIA Ampere架构的低功耗系统级芯片NVIDIA Orin首次参加MLPerf基准测试,就取得了不俗的成绩。在边缘AI领域,NVIDIA Orin预生产版本在六项性能测试中的五项处于领先地位,其运行速度比上一代Jetson AGX Xavier快了5倍,能效平均提高了2倍。

根据NVIDIA官网的介绍,Jetson AGX Orin 系列有32GB和64GB两个版本,该系列具有高达275TOPS的AI性能,由 Ampere GPU和深度学习加速器 (DLA) 提供支持。CPU配备了多达12个Arm Cortex A78AE内核。

Orin配备了其第三代Tensor Cores,可提高性能并支持稀疏矩阵。基于NVIDIA为 Xavier 所做的多处理器构建,它不仅具有 GPU 和CPU,还具有其他处理器,可以帮助从GPU和CPU卸载应用程序的某些部分。它包括一个专用于 AI 应用的深度学习加速器、一个用于计算机视觉应用和ISP的视觉加速器,以及一个视频解码和视频编码引擎。与 Xavier 相比,NVIDIA还为 Orin 带来了 LPDDR5 以提高带宽,传输速度可达204.8GB/s。 Orin 还具备丰富的IO连接,比如其具有多达22个PCIe4.0通道、4个千兆以太网、16个MIPI CSI通道,以及各种其他传感器接口等。

根据测试,Jetson AGX Orin提供了8倍于Jetson AGX Xavier的性能,Jetson AGX Orin是能够运行所有六项MLPerf基准测试的边缘加速器。凭借JetPack SDK,Orin可以运行整个NVIDIA AI平台,这个软件堆栈已经在数据中心和云端得到了验证,并且获得了NVIDIA Jetson平台100万名开发者的支持。

在应用方面,目前,Orin主要关注三大领域,分别为:工业、自动驾驶和医疗。Orin现已加入到用于机器人和自动化系统的NVIDIA Jetson AGX Orin开发者套件。包括亚马逊网络服务、约翰迪尔、小松、美敦力和微软Azure在内的6000多家客户使用NVIDIA Jetson平台进行AI推理或其他任务。

Orin也是NVIDIA Hyperion自动驾驶汽车平台的关键组成部分。据NVIDIA介绍,Orin可处理在自动驾驶汽车和机器人中同时运行的大量应用和深度神经网络,并且达到了ISO 26262 ASIL-D 等系统安全标准。而且,比亚迪近期已经宣布,他们将在其新一代自动驾驶电动汽车中使用内置Orin的DRIVE Hyperion架构。

Orin同样也是NVIDIA Clara Holoscan医疗设备平台的关键组成部分,且该平台可供系统制造商和研究人员用来开发新一代AI仪器。

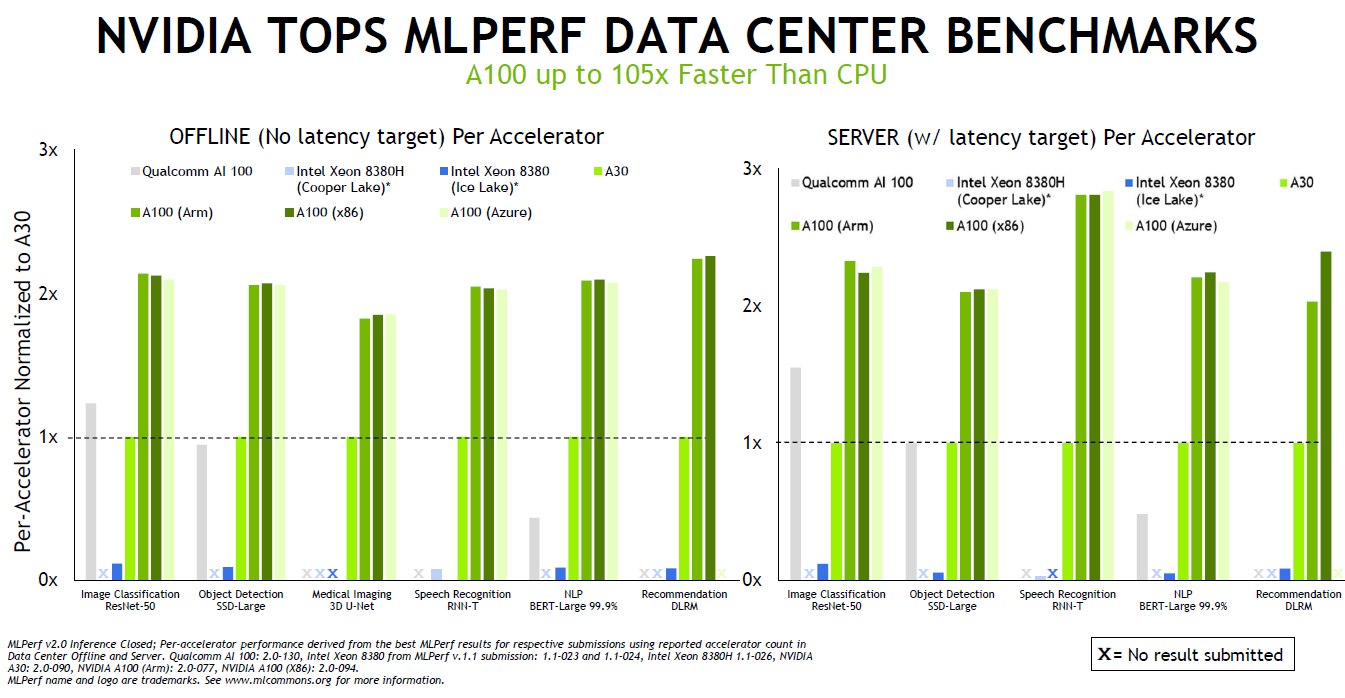

NVIDIA其他AI成果

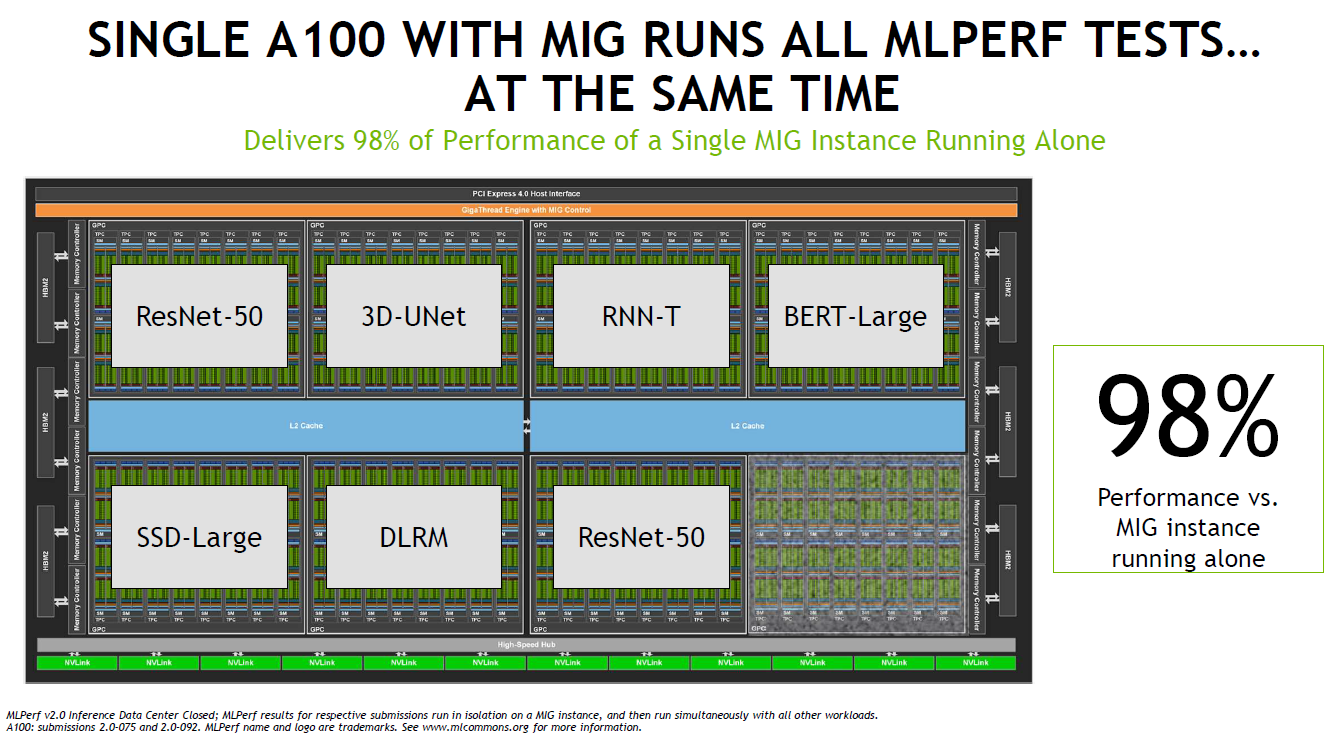

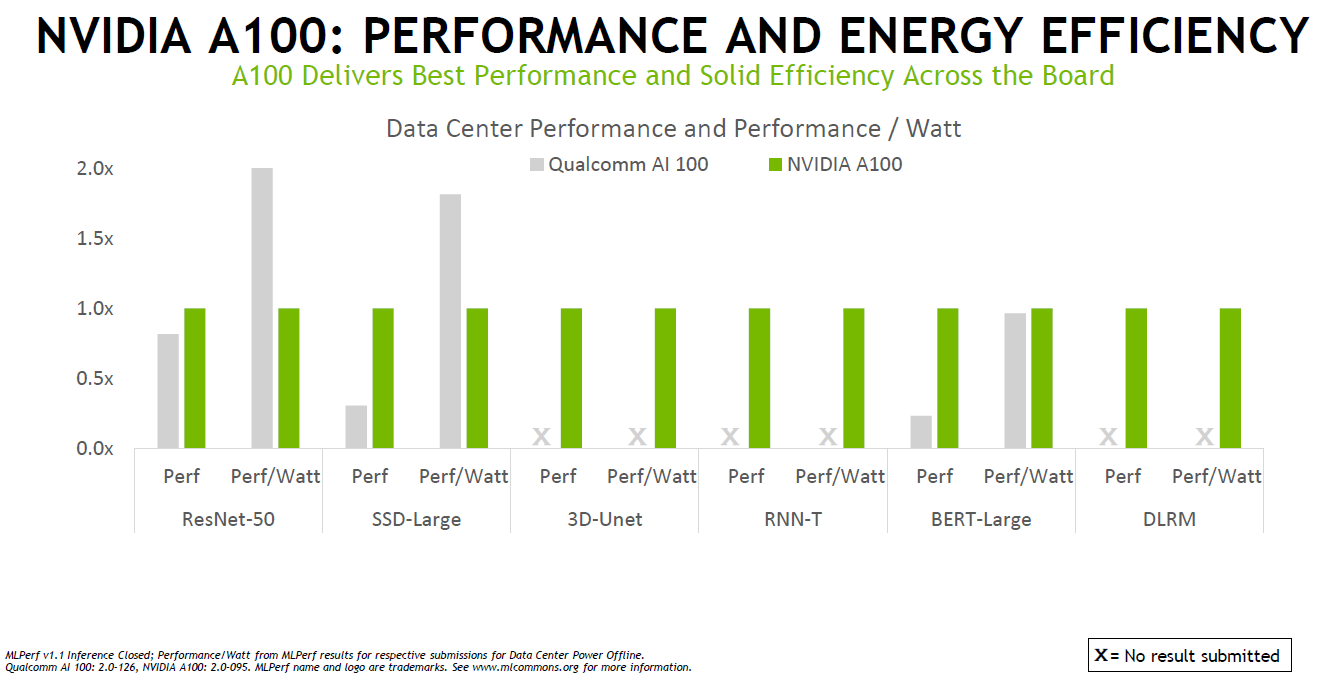

除了Orin之外,本轮MLPerf,验证了NVIDIA的多项成果,包括多实例GPU(MIG)、TensorRT等。比如MIG可提升每个 NVIDIA A100 Tensor 核心 GPU 的性能和价值。MIG可将 A100 GPU 划分为多达七个实例,每个实例均与各自的高带宽显存、缓存和计算核心完全隔离。管理员可以支持从大到小的各项工作负载,为每项工作提供规模适当的 GPU,而且服务质量 (QoS) 稳定可靠,从而优化利用率,让每位用户都能享用加速计算资源。

而根据实际测试结果,在使用7个实例时的性能为仅用一个实例的98%,这也意味着MIG可以充分利用GPU,避免了算力的浪费。

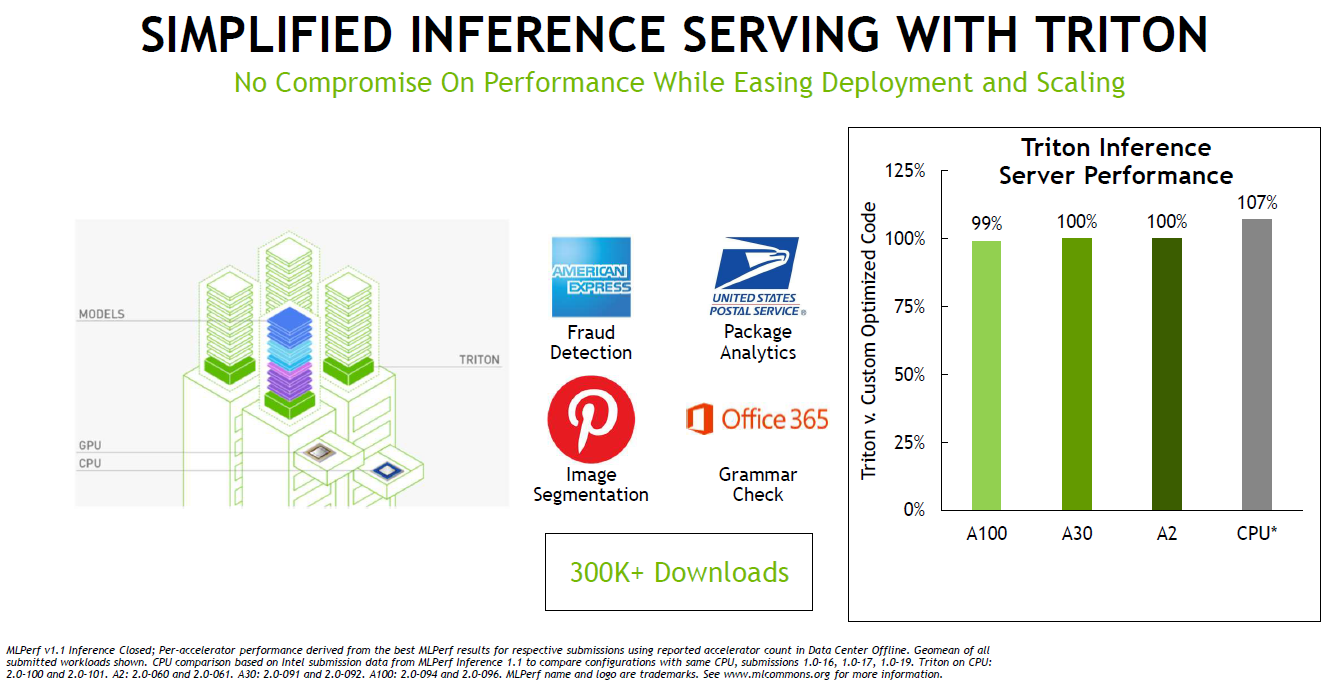

软件是性能提升的关键驱动因素,NVIDIA在AI推理方面的软件包括了用于优化 AI 模型的 NVIDIA TensorRT 和用于有效部署它们的 NVIDIA Triton开源推理服务软件。NVIDIA AI 推理和云高级产品经理David Salvator在媒体发布会上介绍了NVIDIA的Triton开源推理服务软件。

目前TensorRT广泛的优化GPU内核库已支持Jetson Orin,MLPerf中使用的插件已全部移植到Orin并添加到 TensorRT 8.4。Triton则Kubernetes紧密集成,可以管理GPU以及x86和Arm CPU上的AI推理工作,NVIDIA宣布,Triton现在可以只在CPU上运行,而无需GPU。

而也正是因为NVIDIA的跨平台管理能力,使A100在Arm和x86-64平台上的性能几乎相同。并且,通过NVIDIA的软件优化,AI性能在过去一年中就增长了高达50%。

结语

这几年,NVIDIA在AI领域一路狂奔,不仅仅在数据中心方面优势明显,在汽车、边缘计算方面也正推出优势产品,另外在他们还在准备推出工业级的AI产品,进入传统工业领域。AI正在不断渗透到人们生活的各个方面。

-

NVIDIA

+关注

关注

14文章

5087浏览量

103914 -

AI

+关注

关注

87文章

31845浏览量

270671 -

人工智能

+关注

关注

1797文章

47867浏览量

240836 -

推理

+关注

关注

0文章

8浏览量

7277 -

MLPerf

+关注

关注

0文章

35浏览量

657

发布评论请先 登录

相关推荐

WTS-100(V2.0 GNSS) 无线定位系统(GNSS) 彩页

ANSVG-G-A混合动态滤波补偿装置使用说明书 V2.0

从TMS320TCI648x DSP的EDMA v2.0迁移到EDMA v3.0

从EDMA v2.0迁移到TMS320DM644X DMSoC的EDMA v3.0

从EDMA v2.0迁移到EDMA v3.0 TMS320C64X DSP

浪潮信息AS13000G7荣获MLPerf™ AI存储基准测试五项性能全球第一

MLPerf V2.0推理结果放榜,NVIDIA表现抢眼

MLPerf V2.0推理结果放榜,NVIDIA表现抢眼

评论