1、PACS影像数据存储的挑战

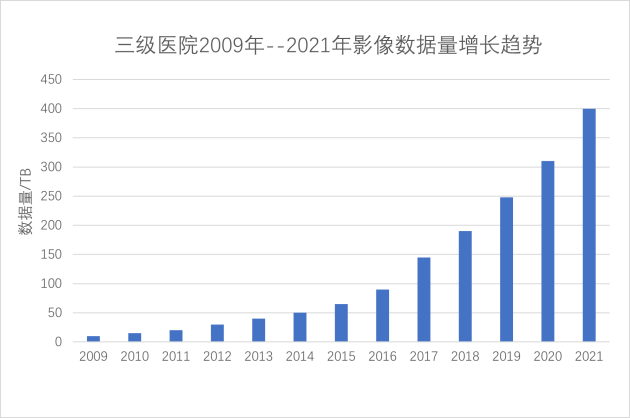

PACS影像数据占医院信息化数据总量的80%以上。随着CT/MR等检查设备分辨率的不断提高,如CT检查设备从早期的64排已经发展到256排,使用人工智能图像分析术后将扫描切层从5mm减小到1mm, 这些因素使得医院的PACS影像数据量急速增加。

急速增长的PACS影像数据量使得医院信息化面临如下严峻挑战:

(1)PACS调图时间长达1~2分钟

十年前,患者检查产生的图像大约几百张,医生调阅患者PACS图像只需要10秒左右。

目前患者一次检查产生的图像数量达到2000幅以上,调图时间普遍长达1到2分钟。调图卡顿是常态,严重影响了医生的工作效率。

(2)存储架构复杂,扩容运维困难

目前医院普遍采用在线/近线/离线三层架构,在线使用SAN存储,近线/离线使用SAN/NAS或对象存储。

SAN存储设备扩容困难,需要划分很多逻辑卷。使用小的逻辑卷,数据风险小,但盘符数量多,而Windows 服务器对盘符数量又有限制;使用大的逻辑卷,盘符数量少,但是数据安全风险大,一旦发生文件系统损坏,检查修复时间会长达几周。

传统存储设备的扩展能力有限,医院需要不断购买新的存储设备,需要不断做数据迁移,存储架构复杂,运维负担繁重。

2、性能瓶颈分析

PACS系统调图涉及到多个环节,包括PACS客户端软件、医生端电脑、网络、存储设备,它们都对性能有重要影响。

(1)PACS软件

本文不关注PACS软件的核心功能,只从PACS软件调图性能角度分析。PACS软件的并发度对调图性能有很大影响。比如,用4个线程同时调取4个图像文件,其性能就是1线程方式的4倍!

有一些厂商的旧版本PACS软件是单线程模式,这时PACS软件就是系统的主要性能瓶颈。对于这种场景,升级PACS软件就成为必须要做的工作。

(2)医生端电脑

医生端电脑硬件配置对PACS调图性能也有一定影响。如果启用了AI辅助分析,则CPU/GPU的配置对性能就很关键。

由于每位患者的PACS影像数据量都比较大,无法全部存储在内存,因此PACS软件都会把下载的PACS文件先写入本地硬盘,再从本地硬盘读取,本地盘的读写性能往往会成为瓶颈。

医生端电脑使用SSD固态盘会显著提升性能。

(3)网络带宽

从网络角度看,只要做到千兆到桌面,万兆到核心,网络就不会成为性能瓶颈。

PACS服务器到网络存储设备之间数据流量比较大,应使用万兆以太网,而不是千兆以太网,否则网络也会成为性能瓶颈。

(4)存储设备

在大多数场景下,PACS系统的调图性能瓶颈主要在于存储设备,而不在于PACS软件。目前普遍30~50幅/秒的调图速度就是传统存储设备的正常性能。

使用SAN存储设备时,承担数据管理功能的文件系统运行在Windows 服务器上,该服务器往往会成为性能瓶颈,大幅增加该服务器的内存会改善性能。

3、新一代PACS影像存储解决方案

上海霄云信息科技是国内软件定义分布式存储的引领者,为医疗PACS影像带来了创新的数据存储解决方案。

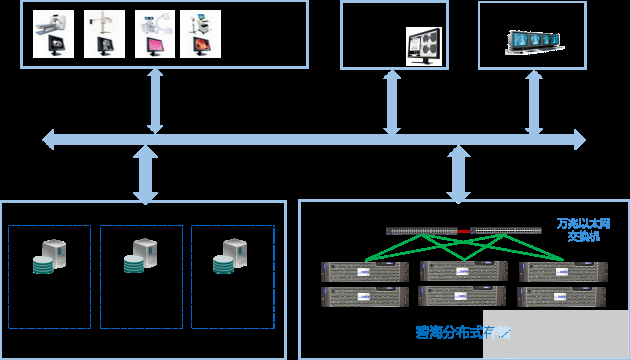

碧海分布式存储通过万兆以太网接入数据中心,现有网络架构无需调整。碧海分布式存储所有功能都采用冗余设计,避免单点故障,保证高可用。具有独有的智能自适应修复技术,在磁盘发生故障进行数据修复时可以保障业务性能不受影响。

新的方案具有如下优势:

(1)性能优异,PACS影像调图速度提升3倍以上

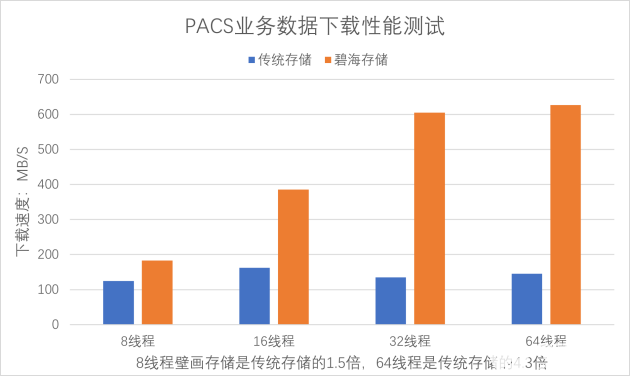

碧海分布式存储的性能显著优于传统集中式SAN和NAS存储,也高于某国际高端集群存储Ixxxxx。PACS影像调图速度可达到300幅/秒。

(2)一套存储,数据全部在线

经过实际测试,碧海分布式存储系统能够做到百亿级文件性能衰减小于5%(传统存储可管理文件数在亿级,Hadoop大数据平台可管理文件数在10亿级)。

对于PACS影像数据,100TB对应的文件数量约为2亿。目前国内大型三甲医院的历史PACS影像数据一般在500TB左右,文件数约为10亿。

因此,使用碧海存储可以将几十年的PACS影像数据全部存储到一套存储,PACS系统的存储架构得以极大简化,扩容与运维负担大幅减轻。

(3)国产自主研发,非开源存储软件,技术先进

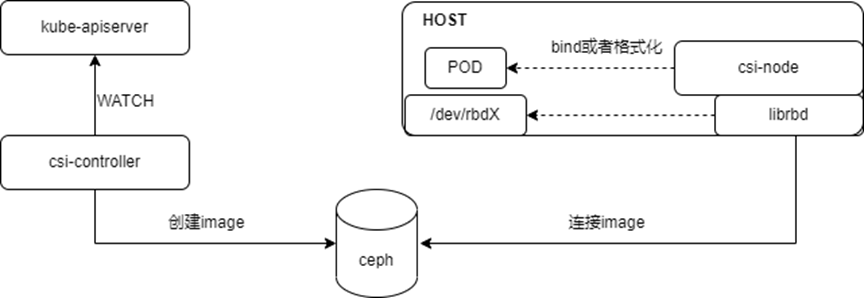

碧海分布式存储是如何实现高性能的呢?

分布式元数据管理

碧海分布式存储使用创新的技术,基于NoSQL分布式数据库技术管理分布式文件系统的元数据,消除了传统集中式存储的单点性能瓶颈。经过实际测试验证,能够存储百亿级以上的文件。

针对PACS海量小文件的定制优化

碧海分布式存储针对PACS小文件进行了深度定制优化,减少了小文件元数据规模,对于PACS影像等小文件场景,文件数可压缩到1/100;将小文件的读写合并后写盘,大幅提高了小文件读写性能。

高效SSD缓存设计

传统的SAN/NAS的SSD缓存方式在块设备底层实现,无法获得文件层的信息,比如哪些内容是目录,哪些是文件元数据inode等,只有当数据被反复多次访问时才会保持在SSD中,因此SSD缓存的命中率比较低。

碧海分布式存储系统在系统架构设计中融入了SSD缓存设计,将目录数据、文件元数据、热点数据全部保持在SSD中,大幅提高了SSD缓存的命中率,从而能够在节省成本的前提下大幅提高读写性能。

对象和文件互通访问,性能无衰减

碧海分布式存储的底层使用统一方式管理数据,文件和对象无需转换网关就能够互通访问,对象的读写性能和文件一样优异,突破了对象存储性能低的局限。

4、实践案例

上海市胸科医院是国内最大的胸外科三甲医院,所有的检查与诊断都需要拍片,对PACS系统的调阅要求高于很多综合性大型三甲医院,每年新增PACS数据量压缩后达到80TB。

之前使用高端存储HP 3Par,PACS影像调图速度为50幅/秒,影像科复核医生在阅片时会发生卡顿。

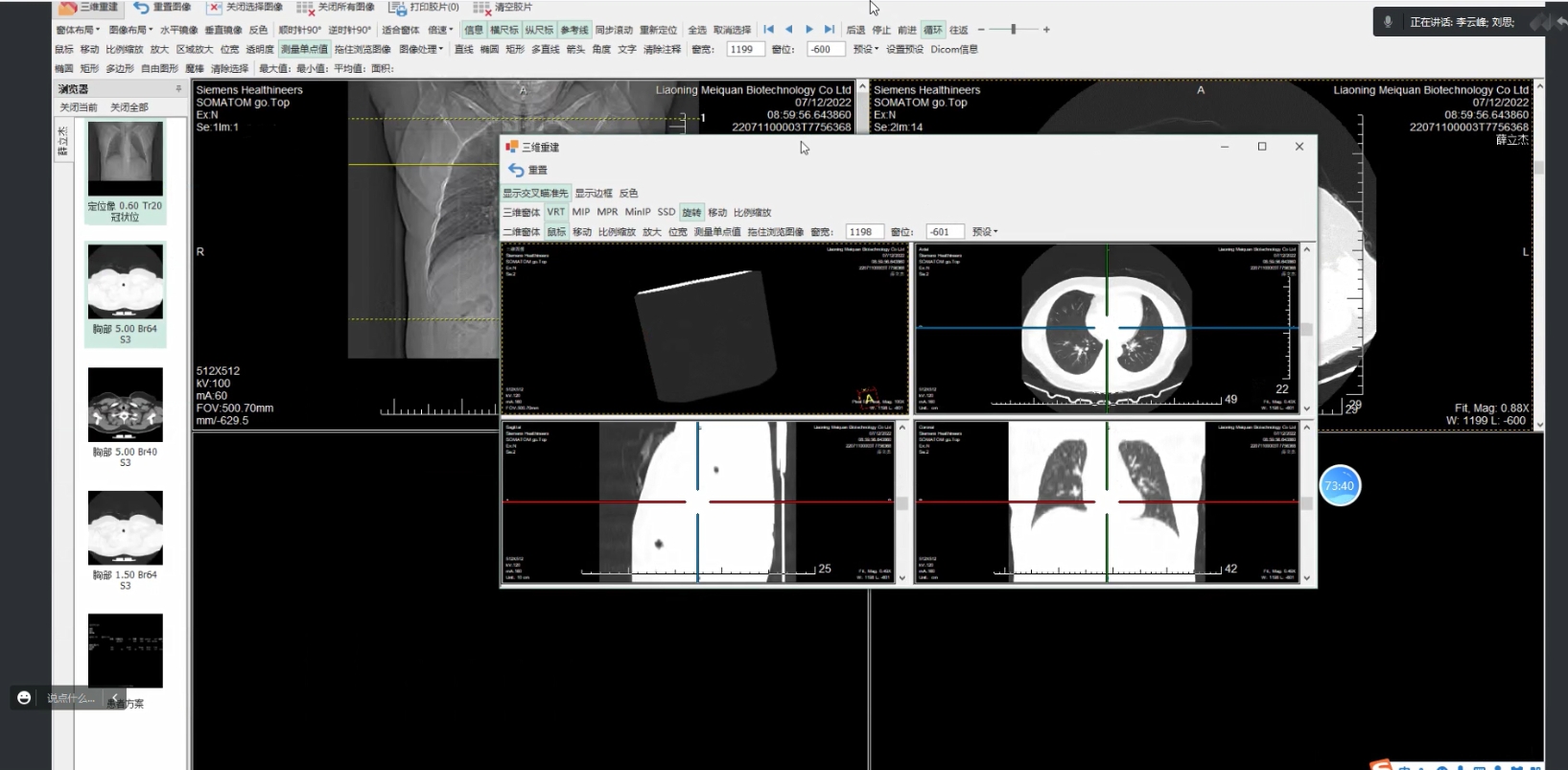

为了更好地支持一线医生的工作,上海市胸科医院信息科不断探索引进新的先进技术,组织PACS厂商卫宁健康与霄云科技一起分析攻关,PACS软件也进行了深度优化,增加了多种调图模式,并针对分布式存储的特点提高了并发调图线程数。

新的方案获得显著的提升效果。调图速度达到300幅/秒,1000幅的CT图像可在4秒内调阅完毕。影像科复核医生每天审核的报告数提升了50%。

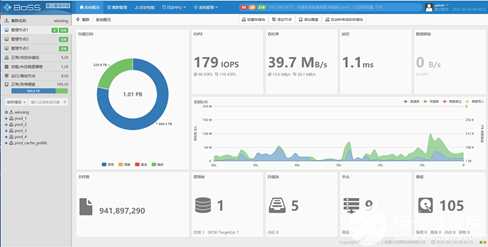

碧海分布式存储上线2年之后,将历史影像数据全部迁移到碧海分布式存储,实现了一套存储数据全部在线。截至2022年3月,在线数据量达到400TB,文件数达到9.4亿。

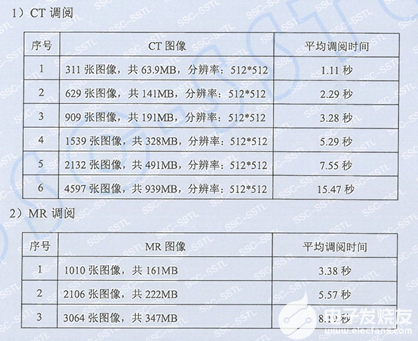

权威第三方测评机构在医院现场对PACS影像调图性能进行了评测,结果如下:

审核编辑:符乾江

-

存储

+关注

关注

13文章

4382浏览量

86289 -

数据管理

+关注

关注

1文章

301浏览量

19707

发布评论请先 登录

相关推荐

英特尔助力东软PACS&RIS赋能三维可视化与AI辅助诊断

东软发布新一代医学影像解决方案

边缘计算的技术挑战与解决方案

西部数据亮相P I SHANGHAI 2024:优质存储产品组合和丰富影像解决方案

液氮罐运输和存储温度监测解决方案

戴尔科技数据存储方案助力丽水市中心医院医疗存储影像系统升级

TPS65295完整 DDR4 存储器电源解决方案数据表

PACS影像数据存储的挑战及解决方案的介绍

PACS影像数据存储的挑战及解决方案的介绍

评论