科学家团队灵光一现,使用 GPU 加速深度学习展示如何实现全彩夜视系统。

在发布于《PLOS One》期刊的论文中,由 Pierre Baldi 教授和 Andrew Browne 博士领导的加州大学欧文分校研究小组描述了他们如何利用红外相机重建人脸照片的彩色图像。

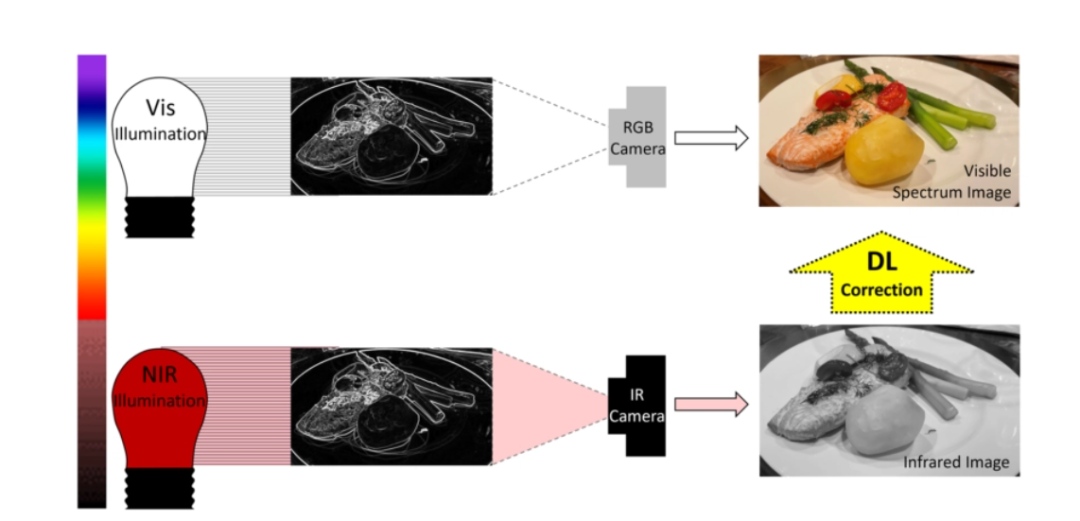

研究使用人类无法察觉的近红外照明采集光线,推动了红外相机图像预测和重建技术的发展。

该研究的作者解释说,人类能够看到的“可见光谱”是波长在 400 至 700 纳米之间的光。

普通的夜视系统依靠相机来采集光谱外人们看不见的红外光。

研究人员表示,相机所采集的图像会被转换到显示器上,显示器单色显示红外相机所拍摄的内容。

加州大学欧文分校的团队开发了成像算法,该算法依靠深度学习来预测人类在红外相机捕获的光线中将看到什么。

加州大学欧文分校的研究人员希望使用深度学习来预测红外光照明下的可见光谱图像

换言之,他们能够使用相机在人类完全看不见的环境中进行拍摄,并数字化渲染拍摄的图像。

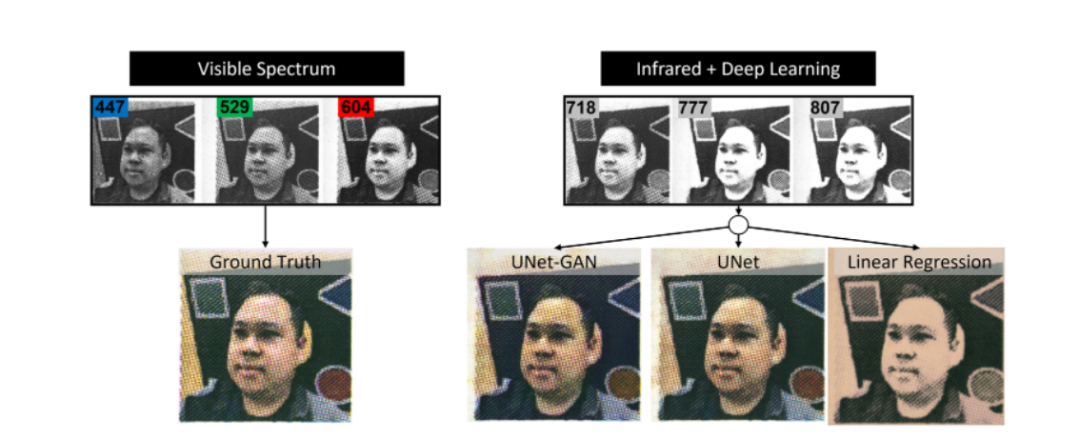

为此,研究人员使用了对可见光和近红外光敏感的单色相机来获取面部打印图像的图像数据集。

这些图像是在覆盖标准可见红光、绿光、蓝光以及红外波长的多光谱照明下采集的。

研究人员优化了具有类 U-Net 架构的卷积神经网络,根据近红外图像来预测可见光谱图像。该神经网络是弗莱堡大学大学计算机科学系最初为生物医学图像分割所开发的专用卷积神经网络。

左边是由红、绿、蓝三色输入图像组成的可见光谱基准真相图像。右边是UNet-GAN、UNet和线性回归根据三幅红外输入图像预测重建的图像。

该系统使用 NVIDIA GPU 和 140 张人脸图像进行训练,其中 40 张用于验证,20 张用于测试。

最终,该团队成功重现了红外相机在黑暗房间中拍摄的彩色人像。换言之,他们创造了能够在全彩夜视系统。

可以肯定的是,这些系统目前还无法实现通用。它们需要经过训练后才能预测不同种类物体的颜色,比如花或人脸。

尽管如此,该研究未来可能会完全实现全彩夜视系统,就像我们在白天所能看到的一样。有朝一日,或许它使科学家也能够研究对可见光敏感的生物样本。

审核编辑 :李倩

-

NVIDIA

+关注

关注

14文章

5021浏览量

103250 -

深度学习

+关注

关注

73文章

5507浏览量

121273 -

夜视系统

+关注

关注

0文章

17浏览量

5102

原文标题:拥有颜色的夜晚:研究人员用深度学习实现全彩夜视系统

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

《CST Studio Suite 2024 GPU加速计算指南》

深度学习工作负载中GPU与LPU的主要差异

使用GPU加速深度学习展示如何实现全彩夜视系统

使用GPU加速深度学习展示如何实现全彩夜视系统

评论