IT 世界正在向云转移,云是建立在 Kubernetes 管理的容器上的。我们认为,下一个合乎逻辑的步骤是使用数据处理器( DPU )加速这一基础设施,以提高性能、效率和安全性。

Red Hat 和 NVIDIA 正在构建一个集成的云就绪基础设施解决方案, Red Hat OpenShift 的管理和自动化,以及 NVIDIA BlueField DPU 。

红帽 OpenShift 的好处

许多流行的云基础设施项目使用 Kubernetes 管理的容器。然而,实施 Kubernetes 可能是一项艰巨的任务,尤其是对于那些无法投入专职人员成为 Kubernetes 专家的组织来说。

Red Hat OpenShift 为管理 Kubernetes 容器以及应用程序部署、更新和生命周期管理提供了一套强大的功能。 OpenShift 包括自动化和安全工具,以及受支持的开源模型,以使云基础设施更经济、可靠和可扩展。

根据 2021 的数据, 85% 以上的容器编排项目都使用了 Red Hat 调查, Kubernetes ,而 Red Hat OpenShift 是混合和多云 Kubernetes 部署的最流行选择。 OpenShift 是业界领先的企业 Kubernetes 平台,财富 500 强中超过 50% 的商业银行、电信公司和航空公司都使用该平台。

显然,大多数企业都想要一个受支持的 Kubernetes 模型, Red Hat OpenShift 是最受欢迎的选择之一。

DPU 的工作原理

DPU 卸载、加速基础设施工作负载,并将其与服务器的 CPU 隔离。例如, BlueField DPU 可以从 CPU 上卸载网络、网络虚拟化、数据加密和时间同步任务,并在特制的硅上运行。

其他基础设施软件,如远程管理、防火墙代理、网络控制平面和存储虚拟化,可以在 BlueField 的 Arm 处理器内核上运行。这样做可以释放服务器的 CPU 内核,而这些内核可以运行应用程序和租户工作负载。

该功能还将基础设施和安全工作负载隔离在单独的域中。结果是一组服务器以更快的网络运行更多的应用程序,提高了数据中心的效率和安全性。

在一个典型的云基础设施中,网络流量会穿越物理服务器和在这些服务器上运行的容器。这需要在每台服务器中都有一个分组交换解决方案,为了获得最大的效率,应用程序容器需要一种与 DPU 的加速网络卸载进行通信的方式。

传统的方法是通过 Kubernetes 和开放虚拟网络( OVN )访问开放虚拟交换机(开放虚拟交换机或 OVS )。 OVN 提供网络抽象,默认部署策略是在主机服务器的 CPU 上同时运行 OVN 和 OVS 。

然而,当网络速度超过 10 Gbps 时,这种方法会消耗大量 CPU 核。 Kubernetes 需要一个解决方案来在 DPU 上运行 OVN 和 OVS 功能,这样所有的数据包交换、报头重写、封装/去封装和数据包过滤都可以在网络硬件上完成,而不是在 CPU 上的软件中完成。

增加红帽和 NVIDIA 之间的网络集成

红帽和 NVIDIA 已经合作,将 OpenShift 的管理能力与 DPU 的加速能力相结合。

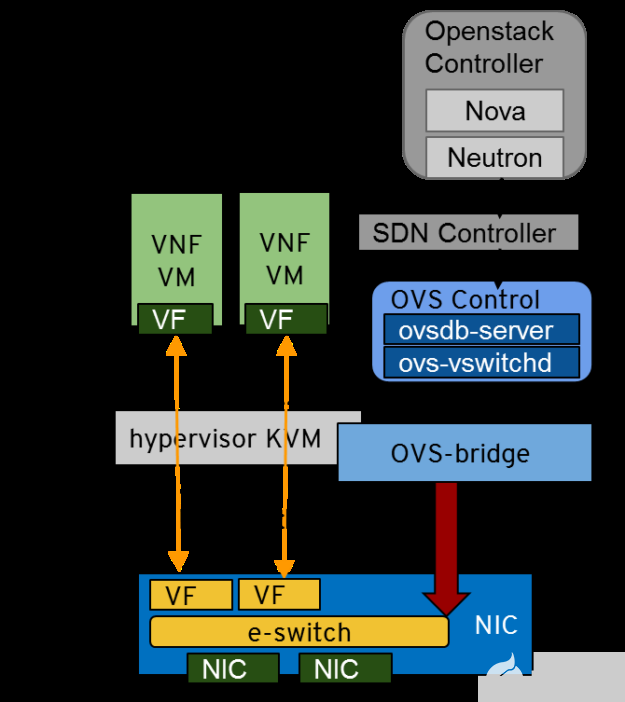

带有 Red Hat Enterprise Linux 的 整合的第一阶段始于 2018 年 将网络流量卸载到 NVIDIA ConnectX SmartNIC 。网络数据平面(使用 OVS 或 DPDK )在 SmartNIC ASIC 上运行,但网络控制平面仍完全在 X86 CPU 上的软件中运行。

图 1 。运行在 Red Hat Enterprise Linux 上的 OpenStack SDN 控制器通过 OVS 将网络数据平面卸载到 NVIDIA ConnectX SmartNIC ,而控制平面在 X86 CPU 上运行 。

2021 ,两家公司采取了下一步行动,将 Red Hat OpenShift 与 NVIDIA BlueField DPU 一起部署,并进行了性能基准测试。在 NVIDIA GTC 2021 年,我们 demonstrated 讨论了将网络转移到 DPU 的优势,并发表了一篇文章 通过将网络功能转移到 NVIDIA BlueField-2 DPU ,优化数据中心的服务器利用率 。

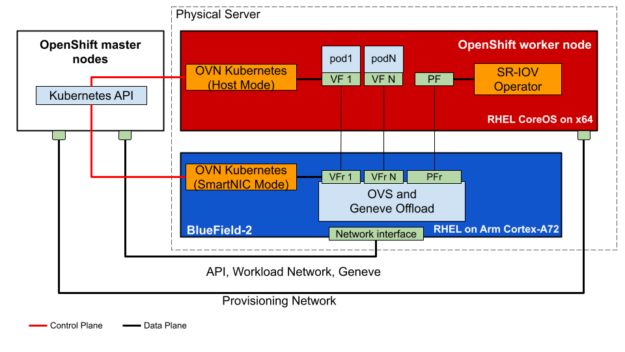

在这个解决方案中,带有覆盖卸载( OVS 和 Geneve 卸载)的网络数据平面和网络控制平面(在 OVN Kubernetes 吊舱中)在 DPU 上运行,并带有 Red Hat Enterprise Linux 。 OpenShift 的主要组件,包括 Red Hat Enterprise Linux CoreOS ,仍保留在 x86 CPU 上。

图 2 。运行在 Red Hat Enterprise Linux CoreOS 上的 Red Hat OpenShift 通过 OVN 和 OVS 将网络数据平面和控制平面卸载到 BlueField-2 DPU 。 DPU 在其 Arm 内核上运行 Red Hat Enterprise Linux 。

在图 2 中的部署场景中, BlueField-2 在以下方面起着重要作用:

Geneve (虚拟覆盖网络)封装/去封装

IPsec 封装/去封装

加密/解密路由

网络地址转换( NAT )

主机 CPU 和容器只看到简单的未封装、未加密的数据包, CPU 不需要执行任何这些任务,因为它们被卸载到 DPU 。这种负载水平将 CPU 利用率降低了 70% ,释放了每台服务器上的大量 CPU 电源,以运行额外的业务/租户工作负载。

在 DPU 上运行 OpenShift

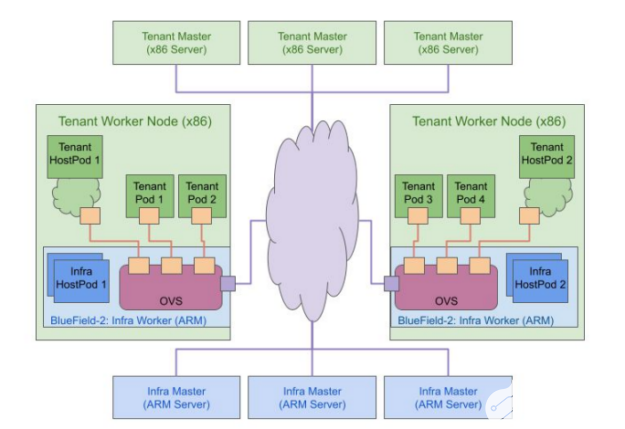

如 2022 年 GTC 所述 , Red Hat 和 NVIDIA 已经迈出了下一步,将 OpenShift (包括 Red Hat Enterprise Linux CoreOS )迁移到 BlueField DPU 的 Arm 内核上运行 Red Hat OpenShift 双集群设计 这包括独立的租户和基础设施集群。

Red Hat Enterprise Linux CoreOS 是 OpenShift 控制平面或主节点和工作节点支持的操作系统。这是 OpenShift 中执行调度、维护、升级和群集自动化的部分。它包括容器管理工具和安全加固,使其更能抵御黑客攻击,现在它可以在主机 x86 CPU 和 DPU Arm 内核上运行。

BlueField DPU 在各种主机服务器上运行 OpenShift OVS 和 OVN 容器以及 Red Hat Enterprise Linux CoreOS ,形成了一个基础架构工作集群。同时,在 x86 CPU 上运行的 OpenShift 管理租户吊舱和集群。

将 OpenShift 基础架构群集软件卸载到 BlueField Arm 内核上而不是主机 x86 内核上运行,可以节省额外的 x86 CPU 开销、更高的性能和更强的安全隔离。

图 3 。从 Red Hat OpenShift 4.10 开始,您可以在 x86 CPU 上运行 OpenShift 来管理租户,也可以在 BlueField DPU Arm 内核上运行 OpenShift 来管理集群基础架构。

云本机、软件定义的网络是 BlueField DPU 用例的一个很好的例子,在 BlueField DPU 环境中,OVN和OVS在 BlueField DPU 上运行并由其卸载。许多其他基础设施服务,如网络加密、防火墙代理、虚拟路由器、遥测代理等,也可以在 DPU 上运行,以获得更大的好处。

OpenShift 在 DPU 上卸载带来了显著的成本节约效益

为了了解 DPU 卸载对降低数据中心成本的影响, NVIDIA 和 Red Hat 为一个配备 51K 服务器的中型数据中心构建了一个 TCO 模型。我们认为该数据中心支持 100 万个应用程序,每个应用程序需要每秒 10 万个数据包( PPS )的交换性能。

我们考虑了 两种服务器部署方案 :有无 DPU :

没有 DPU 完全在软件中运行虚拟交换的服务器仅实现 350k PPS 。

使用 DPU 将 OVN 和 OVS 卸载到 DPU 的服务器的性能提高了 54 倍,达到每台服务器 1870 万个 PPS 。

将虚拟交换机卸载到 DPU 上也为每台服务器节省了八个 CPU 内核。基于此测试, TCO 模型产生了 6850 万美元的惊人资本支出节约 。 这些节约是通过减少 10K DPU 增强型服务器而实现的,这是因为每台服务器具有更高的网络性能和 CPU 核心节约。

我们看到,由于服务器占地面积较小而节省了电力,这最终导致基于 DPU 的服务器具有更好的 TCO 模型。随着我们将负载平衡器、防火墙、加密、 web 服务器等附加功能卸载到 DPU ,这些 TCO 节约将变得更好,最终为支持云计算的数据中心实现惊人的效率。

解决方案路线图和在 BlueField 上部署 OpenShift

在 BlueField 上运行 OpenShift 的双集群 OpenShift 体系结构现已在 OpenShift 4.10 中作为开发者预览版或早期试用版提供,预计将于 2022 年正式提供。

但 NVIDIA 和红帽队并没有就此止步。我们计划测试网络流量加密/解密的卸载,因为这是一项 CPU 密集型任务。

BlueField-2 DPU 可以以高达 100 Gbps 的速度卸载 IPsec 加密/解密,以高达 200 Gbps 的速度卸载 TLS 加密/解密。

BlueField-3 预计将以更高的速度支持 IPSec 、 TLS 和 MACsec 。

从 OpenShift 到 DPU 的线速加密卸载的实施将提高租户的数据安全性,并帮助您更接近零信任安全状态。

与 DPU 的其他潜在集成包括更复杂的软件定义的网络卸载、在 BlueField 上运行防火墙代理、精确时间同步、带数据包速度的视频流,以及使用 DPU 收集遥测数据。

蓝田 -2 DPU 现在可从 NVIDIA 获得,蓝田 -3 DPU 将于 2022 年晚些时候开始采样。此外, BlueField DPU 不久将在 NVIDIA LaunchPad 云服务中进行测试。

如果您想在运行 NVIDIA BlueField DPU 的 Red Hat OpenShift 上进行测试或开发,请使用 表明你的兴趣 。

总结

如果您的公司希望在数据中心采用云原生计算, NVIDIA BlueField DPU 、 Red Hat Enterprise Linux 和 Red Hat OpenShift 的组合将提供一个高效、创新的开放式混合云平台,具有新的安全功能。这个强大的平台提供硬件加速功能,以运行关键的软件定义的网络、存储和安全功能。

现在,可以分配更多的服务器资源来运行云本地工作负载,以及传统的业务应用程序。

关于作者

Ash Bhalgat 是 NVIDIA 网络业务部门的云和电信市场开发高级总监。他领导云和电信解决方案、技术营销和合作伙伴生态系统业务开发,以推动网络投资组合收入和市场份额增长。

John Kim 是 NVIDIA 网络事业部的存储市场总监,致力于帮助客户和供应商从高性能网络连接、智能网卡卸载和远程直接数据存取 (RDMA) 中获益,尤其是在存储、大数据和人工智能领域。John 是非常活跃的博主、会议演讲嘉宾和网络直播节目主持人,也是存储网络行业协会网络存储论坛 (SNIA NSF) 的主席。John的高科技生涯从 IT 支持人员和网络管理员开始,先后在NetApp 和 EMC等企业级软件公司以及存储供应商从事解决方案市场、产品管理和生态联盟工作。他于 2013 年加入 Mellanox,之后于 2020 年加入 NVIDIA。

审核编辑:郭婷

-

NVIDIA

+关注

关注

14文章

4986浏览量

103059 -

数据中心

+关注

关注

16文章

4778浏览量

72128 -

大数据

+关注

关注

64文章

8889浏览量

137443

发布评论请先 登录

相关推荐

NVIDIA SuperNIC推进现代AI基础设施发展

NVIDIA助力印度打造AI基础设施

智能驾驶所需的基础设施

NVIDIA NIM助力企业高效部署生成式AI模型

微软贝莱德成立AI基础设施投资基金

应用NVIDIA Spectrum-X网络构建新型主权AI云

IaaS+on+DPU(IoD)+下一代高性能算力底座技术白皮书

三星携手红帽成功构建全球首个CXL认证基础设施

三星电子宣布成功构建其首个红帽认证的CXL基础设施

宁畅推出“全栈全液”AI基础设施方案

垂直起降机场:飞行基础设施的未来是绿色的

NVIDIA 发布全新交换机,全面优化万亿参数级 GPU 计算和 AI 基础设施

使用Red Hat和NVIDIA构建集成云就绪基础设施方案

使用Red Hat和NVIDIA构建集成云就绪基础设施方案

评论