我们十分高兴地宣布,Torch-TensorRT 1.1.0 版本正式发布!

软件版本

PyTorch 1.11

CUDA 11.3(在 x86_64 上,默认设置下,兼容的 PyTorch Build 支持较新版本的 CUDA 11)

cuDNN 8.2.4.15

TensorRT 8.2.4.2

由于最近 JetPack 的升级和其发布流程的变化,Torch-TRTv1.1.0 版本不支持Jetson(Jetpack 5.0DP 或其他)。将在中期版本(Torch-TensorRT1.1.x)同时支持 Jetpack 5.0DP 和 TensorRT 8.4。

重要变更

HF BERT性能

算子和性能的进一步优化使 HF BERT 的性能比 V1.1 版本提升了 40%

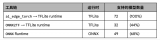

更多的算子

18 个新的 aten 算子转换器提高了 TensorRT 的模型覆盖范围和性能

查看全部 250+ 个算子

Triton 后端支持

21.12 版本以上的 Triton 现已支持 Torch-TensorRT

将在不久后提供工作流程教程

调试工具

上下文管理器现在允许使用更简洁清晰的调试工作流程

不支持的算子已降级为警告,建议使用上下文管理器进行调查

API 变更

max_batch_size 和 strict_types 由于在 TRT 中不被遵守已被删除

所有与 Torch-TensorRT 相关的 Bug 都应被归入新的 “MachineLearning – TorchTRT” nvbugs 模块。

原文标题:Torch-TensorRT 1.1.0 版本正式发布

文章出处:【微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

-

软件

+关注

关注

69文章

4968浏览量

87696 -

pytorch

+关注

关注

2文章

808浏览量

13249

原文标题:Torch-TensorRT 1.1.0 版本正式发布

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

解锁NVIDIA TensorRT-LLM的卓越性能

使用NVIDIA TensorRT提升Llama 3.2性能

TensorRT-LLM低精度推理优化

在设备上利用AI Edge Torch生成式API部署自定义大语言模型

Google AI Edge Torch的特性详解

魔搭社区借助NVIDIA TensorRT-LLM提升LLM推理效率

M8020A J-BERT 高性能比特误码率测试仪

韩国服务器的性能如何提升

Allegro X 23.11 版本更新 I PCB 设计:梯形布线的分析性能提升

AWG和BERT常见问题解答

艾体宝方案 | 管理开源软件包更新,提升开源安全性

软件算法赋能4D雷达性能提升

TC3x7如何更改DMU_HF_CONFIRM0以更新所需的BMHD?

Torch TensorRT是一个优化PyTorch模型推理性能的工具

Torch-TensorRT软件更新 HF BERT性能提升40%

Torch-TensorRT软件更新 HF BERT性能提升40%

评论