踩坑

手眼标定的算法网上是比较多的,但是很多都不好用。github上高赞的easy_handeye,试了一下,但是mycobot600没有提供moveit的配置,而我ROS基础不是很好,不太会修改示例代码。折腾了一段时间最终看到这个鱼香ROS,最终得到了不错的结果

1.配置

配置过程就不用说了,参考鱼香ROS

用深度相机的话需要安装深度相机的库github

需要控制机械臂还需要安装ROS库,参考博客

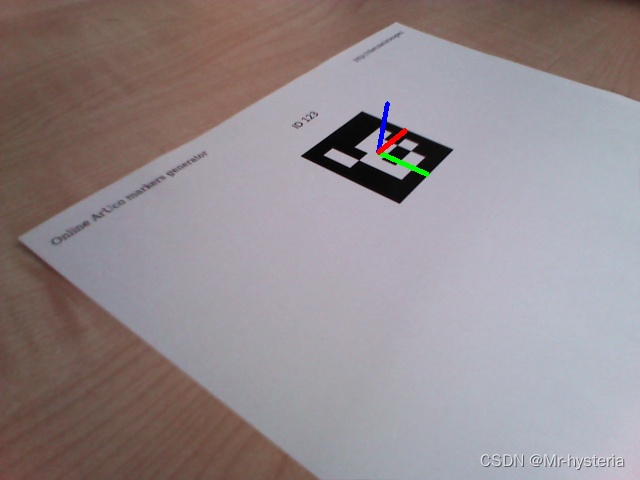

识别二维码需要安装aruco_ros

特别说明一些,鱼香ROS配置的时候,安装的opencv应该是pip3去安装的。配置过程可能有许多问题,百度解决即可

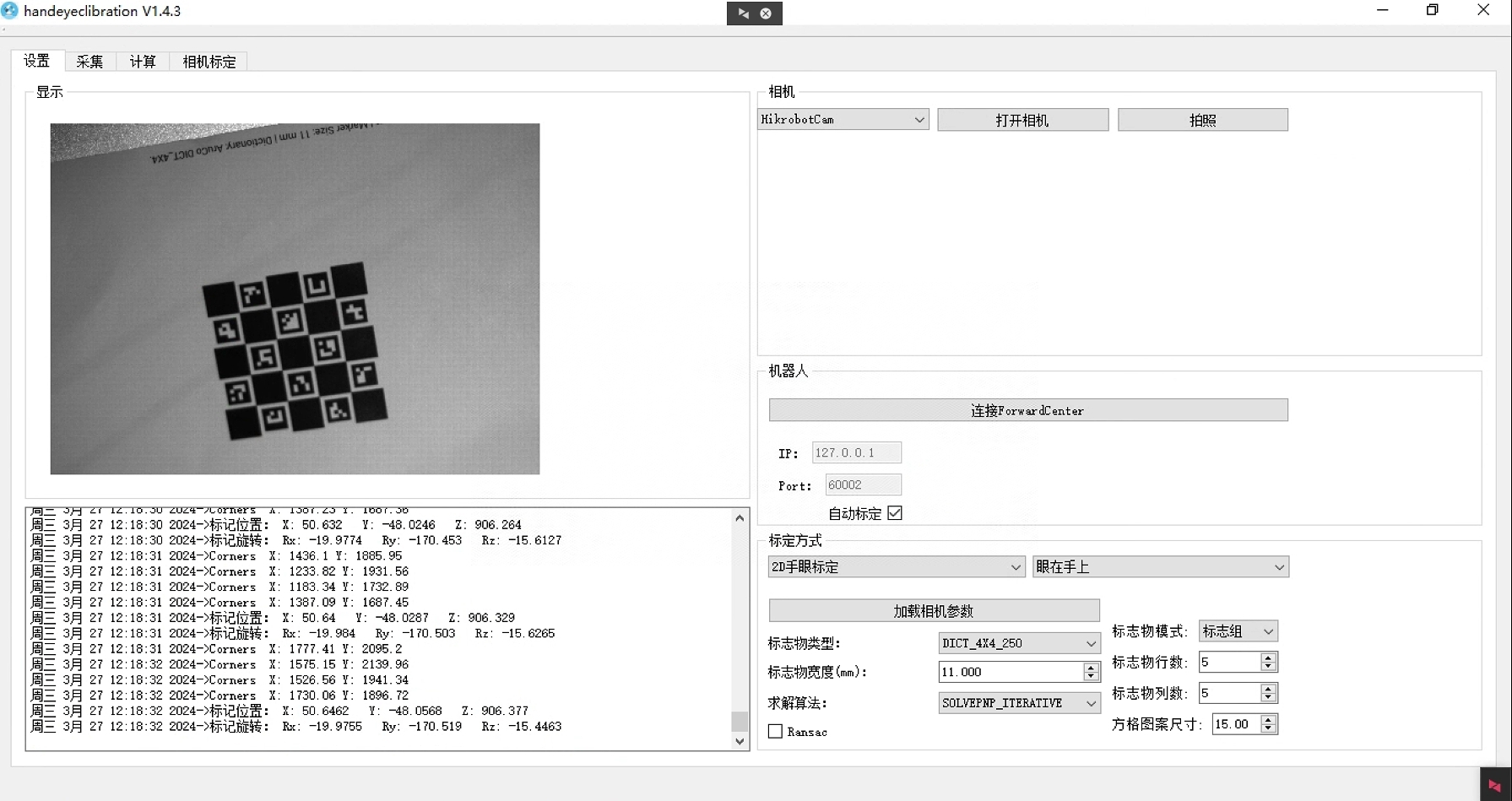

2.在线标定

用在线标定的方式比较简单,不用自己去配置姿态信息。

2.1启动相机

该launch文件已经把启动realsense的代码写入了,直接运行就好。

roslaunch handeye-calib aruco_start_realsense_sdk.launch

自己可以修改相机的参数,比如分辨率,帧率

其中分辨率不是随便改的,可以启动realsense-viewer查看相机支持的分辨率有哪些

realsense-viewer

2.2启动机械臂及通信

# 启动rviz

roslaunch mycobot_600 mycobot_600_slider.launch

# 启动通讯

rosrun mycobot_600 slider_600.py

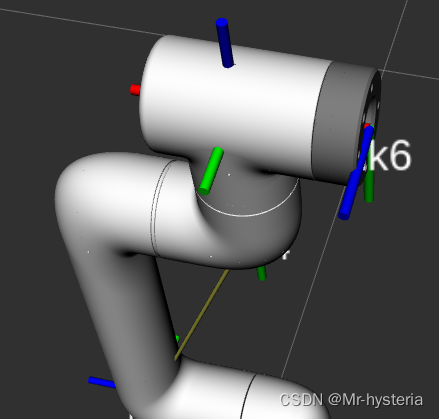

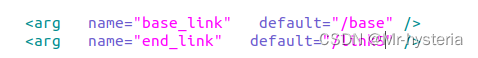

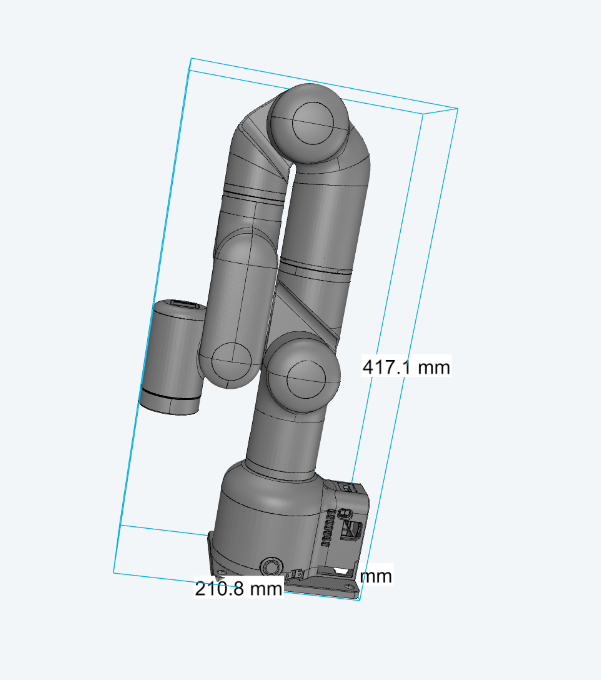

Rviz中的坐标,可以看出,基底坐标是base,末端坐标是link6

2.3启动手眼标定程序

修改src/handeye-calib/launch/online/online_hand_on_eye_calib.launch中的参数后,运行:

roslaunch handeye-calib online_hand_on_eye_calib.launch

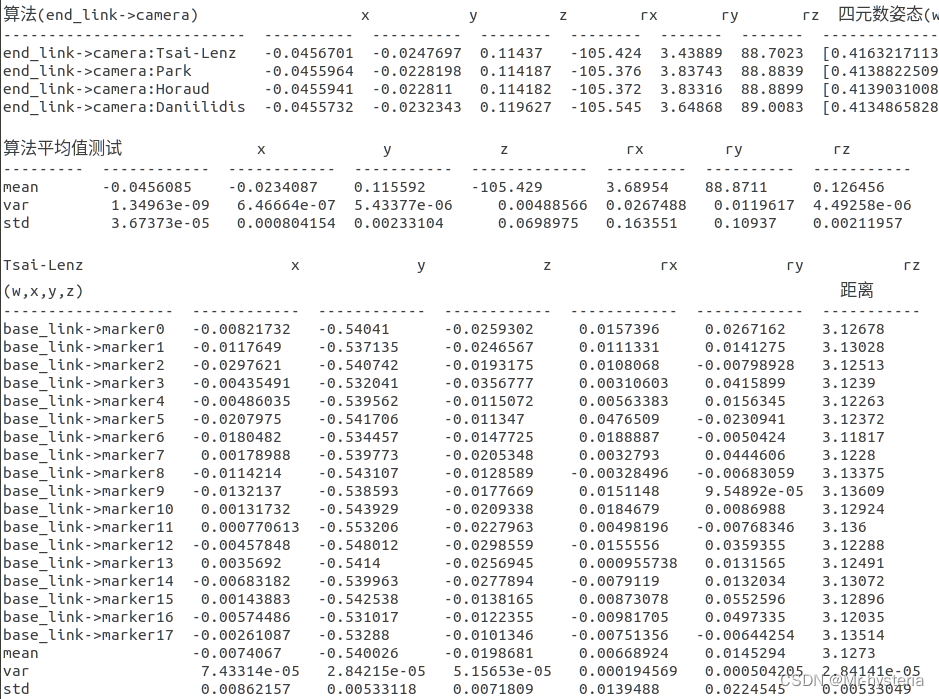

3.标定精度

相机与link5之间的坐标变化才是不变的

眼在手上的时候,板子与基座之间的变化是固定的,因此可以看他们的标准差来判断是否精确。std预计需要0.005以下才行

aruco码隔的近效果好,因此尽量使相机与二维码近一点,可以使用较小的二维码

多个角度拍摄

总结:多角度,小距离。(上下左右,左上,右上,左下,右下。)每个位置拍摄两组或者三组(末端尽量不动,其他关节进行组合)。效果还行,如下:

其他:

打开rviz可以清楚的看到有几个坐标及名称还有tf树之间坐标的关系(大象机器人是base..link6)

以下代码可以查看坐标之间的变化矩阵:rosrun tf tf_echo base link5

XYZ---红、绿、蓝色(rviz中)

numpy.linalg.LinAlgError: Eigenvalues did not converge(这个报错是因为自己拍摄的拍摄的照片以及数据存在很大问题)

眼在手上可以看base->marker的标准差(std),越稳定越好

审核编辑:符乾江

-

机器人

+关注

关注

210文章

28180浏览量

206311 -

python

+关注

关注

55文章

4778浏览量

84438 -

机械臂

+关注

关注

12文章

509浏览量

24485 -

ROS

+关注

关注

1文章

276浏览量

16961

发布评论请先 登录

相关推荐

大象机器人10月大事件回顾

abb机器人工具坐标系问题

AMD Kria™ KR 260套件+ROS 2快速开发机器人解决方案

大象机器人完成Pre-B轮融资,致力打造全新机器人生态!

技术融合与创新大象机器人水星Mercury X1人形机器人案例研究!

自动化革命:大象机器人的Mercury A1机械臂

机器人与视觉标定理论详解

大象机器人首发万元级水星Mercury人形机器人系列

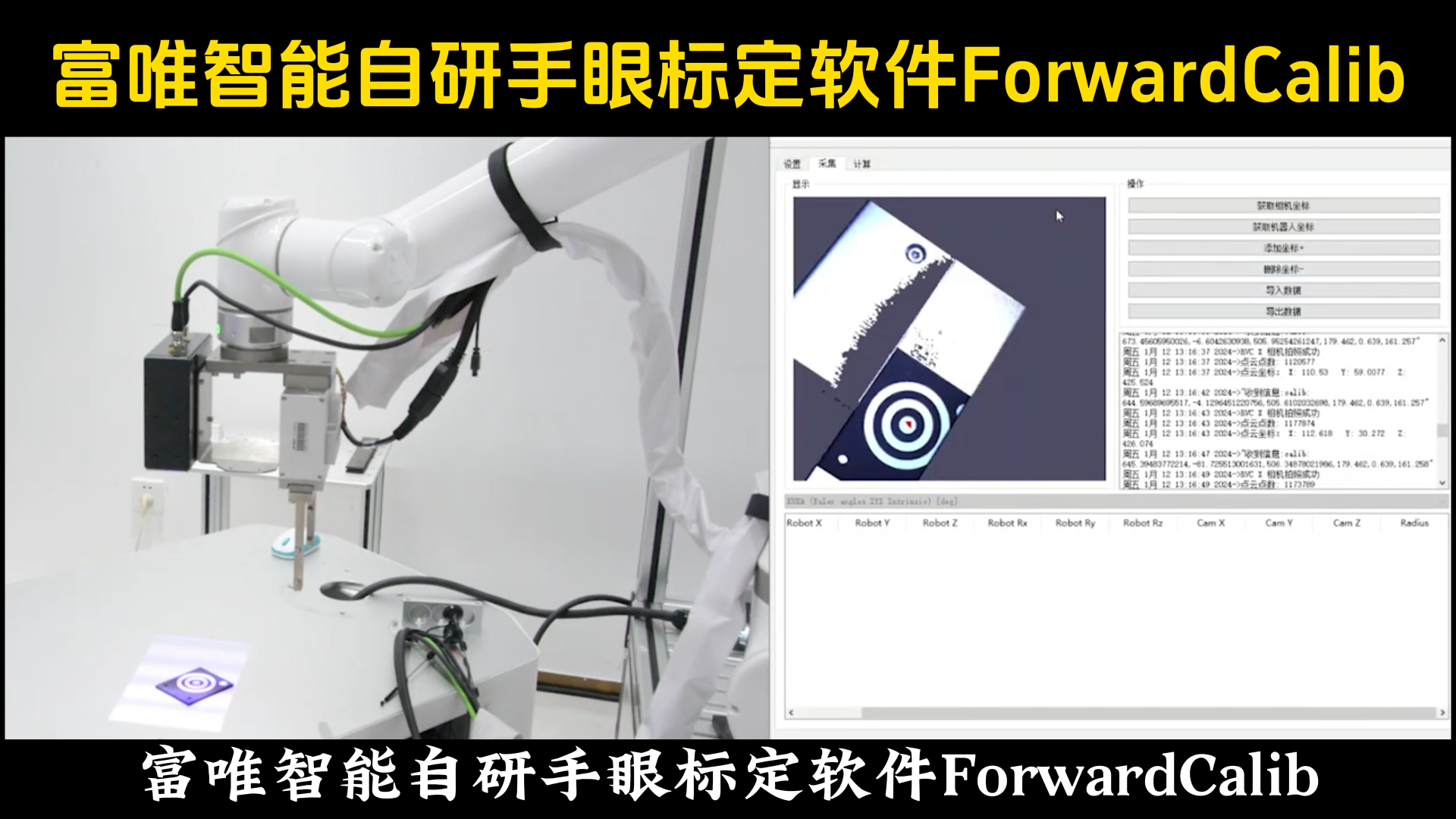

Realsense+大象机器人手眼标定方案详解

Realsense+大象机器人手眼标定方案详解

评论