借助 NVIDIA NGC 目录中的 GPU 优化容器,更快地开发和部署应用。

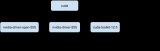

什么是容器?

容器是一种便携式软件单元,可将应用及其所有依赖项合并为一个软件包,该软件包不受底层主机操作系统限制。这样无需再构建复杂的环境,并简化了应用开发到部署的过程。

NVIDIA NGC 目录包含一系列用于深度学习、机器学习、可视化和高性能计算(HPC)应用的 GPU 优化容器,这些容器均已经过了性能、安全性和可扩展性测试。

NGC 目录中的容器的优势

轻松部署

内置库和依赖项可让您轻松部署和运行应用。

加快训练速度

TensorFlow 和 PyTorch 等 NVIDIA AI 容器每月会提供针对性能优化的更新版本,以便加快 AI 训练和推理速度。

运行位置不受限制

在 bare metal、虚拟机(VM)和 Kubernetes 上,将容器部署在任意位置(云端、内部私有云和边缘)的多 GPU/多节点系统上。

放心部署

容器经过常见漏洞和暴露(CVE)扫描(附有安全报告),并通过 NVIDIA AI Enterprise 得到了可选的企业支持。

性能优化

NVIDIA 构建的 Docker 容器每月都会更新,第三方软件也会定期更新,以提供所需的功能,便于您从现有基础架构中获得出色性能,并缩短找出解决方案的时间。

借助 BERT-Large 进行自然语言处理

BERT-Large 利用 VoltaV100 和 Ampere A100 GPU 上的混合精度运算和 Tensor Core,在保持目标准确性的同时缩短训练时间。

在单节点的 8x V100 (16GB) 和 A100 (40GB) 上使用 TensorFlow 时,BERT-Large 和训练的性能表现。混合精度。BERT 的批量大小:3 (V100)、24(A100)

用于图像处理的 ResNet50 v1.5

此模型使用 Volta、Turing 和 NVIDIA Ampere GPU 体系架构上的 Tensor Core 进行混合精度训练,以加快训练速度。

在单节点 8x V100 (16GB) 和 A100 (40GB) 上使用 TensorFlow 时,ResNet 50 的性能表现。混合精度。ResNet50 批量大小:26

用于深度学习的 Matlab

持续开发 Matlab 深度学习容器可提高训练和推理性能。

Windows 10,Intel Xeon E5-2623 @2.4GHz,NVIDIA Titan V 12GB GPU

用于各种工作负载的容器

AI 容器

TensorFlow

TensorFlow 是一个用于高性能数值计算的开源软件库。

PyTorch

PyTorch 是具有 Python 前端的 GPU 加速型张量计算框架。

NVIDIA Triton 推理服务器

NVIDIA Triton 推理服务器是一种开源推理解决方案,可更大限度地提高 GPU 的利用率和性能。

NVIDIA TensorRT

NVIDIA TensorRT 是一个C++ 库,可加快 NVIDIA GPU 上的高性能推理。

应用框架

NVIDIA Clara

用于医疗成像的 NVIDIA Clara Train 是一个应用框架,包含超过 20 个先进的预训练模型、迁移学习和联合学习工具、AutoML,以及 AI 辅助的标记数据。

DeepStream

DeepStream 是一款流分析工具包,可用于基于 AI 的视频、音频和图像理解和多传感器处理。

NVIDIA Riva

NVIDIA Riva 是一个应用框架,适用于在 GPU 上提供实时性能的多模态对话式 AI 服务。

Merlin Training

Merlin HugeCTR 是 NVIDIA Merlin 的组件,是一款专为推荐系统设计的深度神经网络训练框架。

HPC 容器

NAMD

NAMD 是一段并行分子动力学代码,旨在实现生物大分子系统的高性能模拟。

GROMACS 是一款热门的分子动力学应用,用于模拟蛋白质和脂质。

Relion

Relion 采用经验贝叶斯方法分析低温电子显微镜(cryo EM)。

NVIDIA HPC SDK

NVIDIA HPC SDK 是编译器、库和工具的综合套件,用于构建、部署和管理 HPC 应用。

点击阅读原文,了解更多 AI 和 HPC 容器相关内容

NVIDIA 深度学习培训中心

我们的 NVIDIA 深度学习培训中心还推出了 AI 和 HPC 容器及 NGC 相关课程,您可以复制链接查看课程详情。

使用容器实现高性能计算

学习使用容器化环境开发高性能计算(HPC)应用程序,降低编码的复杂性和可移植性,从而提高开发效率。

原文标题:DevZone | AI和HPC容器

文章出处:【微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

审核编辑:汤梓红

-

NVIDIA

+关注

关注

14文章

5107浏览量

104466 -

gpu

+关注

关注

28文章

4830浏览量

129778 -

容器

+关注

关注

0文章

500浏览量

22194

原文标题:DevZone | AI和HPC容器

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

0xmd公司通过NVIDIA GPU打造医疗AI解决方案

借助NVIDIA GPU提升鲁班系统CAE软件计算效率

《CST Studio Suite 2024 GPU加速计算指南》

Supermicro推出直接液冷优化的NVIDIA Blackwell解决方案

AMD与NVIDIA GPU优缺点

NVIDIA全面转向开源GPU内核模块

NVIDIA加速微软最新的Phi-3 Mini开源语言模型

NVIDIA推出两款基于NVIDIA Ampere架构的全新台式机GPU

NVIDIA全面加快Meta Llama 3的推理速度

利用NVIDIA组件提升GPU推理的吞吐

FPGA在深度学习应用中或将取代GPU

NVIDIA 发布全新交换机,全面优化万亿参数级 GPU 计算和 AI 基础设施

NVIDIA NGC目录中的GPU优化容器

NVIDIA NGC目录中的GPU优化容器

评论