在过去的三四年里,人工智能推理市场发生了巨大变化。以前,甚至不存在边缘人工智能,大多数推理能力都发生在数据中心、超级计算机或政府应用程序中,这些应用程序通常也是大型计算项目。在所有这些情况下,性能都是至关重要的,并且始终是重中之重。快进到今天,边缘人工智能市场与此截然不同,尤其是当它进入更多商业应用时。对于这些用例,主要关注点更多的是低成本、功耗和小尺寸;而更少关于原始性能。

通过硬件-软件协同设计平衡更好的性能

在查看推理芯片时,很明显一种芯片与另一种不同。设计师总是在他们的设计中做出选择,而好的选择会考虑他们的最终应用以及他们在这些应用中的限制。例如,当 Flex Logix 设计其第一个推理芯片时,它最初的大小是现在的 4 倍。我们很快意识到,芯片需要更小才能在成本更低、功耗更低、外形尺寸更小的边缘 AI 市场中占据一席之地。

有趣的是,大多数人最初认为大多数推理总是在数据中心完成。这种观点最终发生了变化,因为行业意识到它有太多的数据需要移动,因此,这些数据开始向边缘移动。随着 5G 开始出现,更清楚的是,不可能始终将原始数据发送到云端进行处理。显然,边缘必须有一定的智能才能解决 99.9% 的场景,而数据中心实际上只需要用于极端情况。一个完美的例子是安全摄像头。边缘 AI 需要能够确定是否发生了任何可疑活动以及周围是否有人。然后,如果发现任何有趣的东西,这些部分可以发送到数据中心进行进一步处理。然而,发送到数据中心的数据实际上只是整体推理的一小部分。边缘推理 AI 通常意味着要满足很多约束,有时如果你想运行非常大的复杂模型,你实际上只需要在很小一部分数据上运行这些模型。

早期边缘 AI 推理设计的另一个误解是,一刀切的方法就足够了。这也被证明是错误的,因为出现了展示其优势和力量的专用芯片。关键是围绕算法构建芯片,因为如果它真的能在算法上磨练,你可以获得更好的性能。正确的平衡实际上是像专用硬件一样获得最有效的计算,但在编译时具有可编程性。

可编程性是关键

该行业确实处于人工智能发展的风口浪尖。在接下来的几十年里,我们将在这个领域看到的创新将是惊人的。就像任何长寿的市场一样,您可以期待变化。这就是为什么不为某些客户模型设计超级专业的芯片变得至关重要的原因。如果我们今天这样做,那么当芯片在两年后到达客户手中时,模型可能会发生重大变化——客户的要求也会发生变化。这就是我们不断听到有关公司最终获得他们的人工智能推理芯片的故事的主要原因——然后发现它们的表现并没有像他们需要的那样。如果将可编程性内置到芯片架构中,则可以轻松解决该问题。

如今,在任何边缘 AI 处理器中,AI 的灵活性和可编程性都至关重要。客户的算法会定期发生变化,系统设计也会发生变化。随着 Edge AI 功能在主流中的推广,越来越清楚的是,芯片设计人员需要能够适应和改变客户模型,而不是根据他们“认为”的模型来选择它。我们一次又一次地看到这一点,这就是编译器如此重要的原因。编译器中有很多对最终用户隐藏的技术,这些技术是围绕分配资源以确保一切都以最少的功率高效完成的。

另一个被密切关注的关键特性是吞吐量。现在正在构建好的推理芯片,以便它们可以非常快速地通过它们移动数据,这意味着它们必须非常快速地处理这些数据,并且非常快速地将其移入和移出内存。通常,芯片供应商会抛出各种各样的性能数据,例如 TOPS 或 ResNet-50,但研究这些数据的系统/芯片设计人员很快就会意识到这些数据通常毫无意义。真正重要的是推理引擎可以为模型、图像大小、批量大小和过程以及 PVT(过程/电压/温度)条件提供多少吞吐量。这是衡量其性能表现的第一个衡量标准,但令人惊讶的是,很少有供应商提供它。

边缘人工智能向前发展

今天的许多客户都渴望吞吐量,并正在寻找能够以与他们现在使用的相同功率/价格为他们提供更高吞吐量和更大图像尺寸的解决方案。当他们得到它时,他们的解决方案将比竞争解决方案更准确和可靠,然后他们的市场采用和扩展将加速。因此,尽管今天的应用程序有数千或数万个单位,但我们预计随着推理的可用性,这种情况会迅速增长,从而提供越来越多的吞吐量/美元和吞吐量/瓦特。

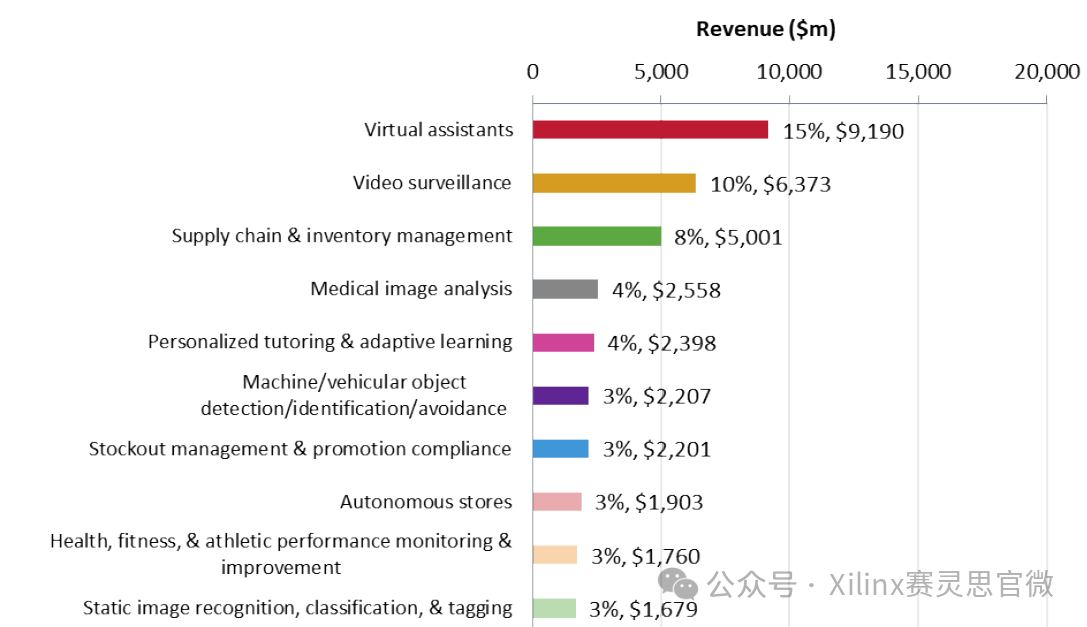

边缘人工智能市场正在迅速增长,芯片供应商也在这个市场上争夺一席之地。事实上,到 2020 年代中期,人工智能销售额迅速增长至数百亿美元,其中大部分增长来自边缘人工智能推理。没有人可以预测未来的模型,这就是为什么在设计时考虑到灵活性和可编程性更为重要

审核编辑:郭婷

-

处理器

+关注

关注

68文章

19391浏览量

230636 -

芯片

+关注

关注

456文章

51075浏览量

425863 -

AI

+关注

关注

87文章

31364浏览量

269769

发布评论请先 登录

相关推荐

生成式AI推理技术、市场与未来

新品| LLM630 Compute Kit,AI 大语言模型推理开发平台

边缘计算的未来发展趋势

李开复:中国擅长打造经济实惠的AI推理引擎

Imagination 引领边缘计算和AI创新,拥抱AI未来发展

MediaTek与NVIDIA TAO加速物联网边缘AI应用发展

如何基于OrangePi AIpro开发AI推理应用

边缘AI推理应用设计的发展

边缘AI推理应用设计的发展

评论