无论是在正式还是非正式讨论中,恩智浦员工经常会谈及功能安全和信息安全的相互作用。如果再涉及汽车和人工智能,这个话题可能会变得更加复杂。

在去年的博文《未来挑战:如何确保人工智能的安全》中,我们提到,恩智浦正在为安全的AI奠定坚实的基础,例如恩智浦有关算法道德和Auto eIQ的白皮书。

在寻求功能安全和信息安全的汽车AI方面,我们不是在孤军奋战。在德国,德国联邦信息安全办公室 (BSI) 和采埃孚 (ZF) 携手德国认证机构汉德集团 (TUV Nord),正合力探索如何在汽车上测试AI。德国人工智能研究中心 (DFKI) 和TUV SUD也在研究AI系统的汽车性能测试。

虽然尚不清楚这些测试的具体要求,但我们将在现有的基础上再接再厉。

未来汽车如何利用机器学习和人工智能

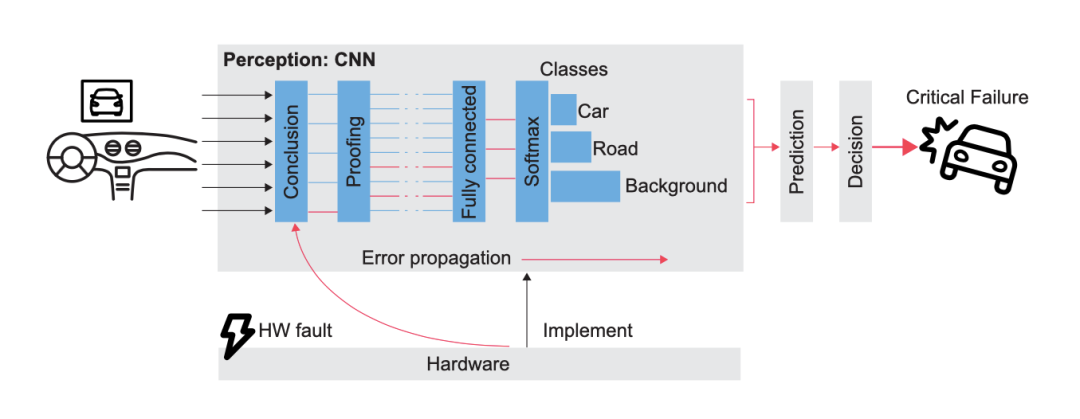

在推理方面,我们相信未来汽车将利用AI和机器学习来提供安全相关的功能。正因如此,我们与ANITI和ONERA合作,研究基于AI的系统中随机硬件故障的影响。这项工作在功能安全标准(如ISO 26262)确立的先进水平之上,因为这些标准明确将机器学习排除在外。

功能安全框图

本次合作的一个重点领域就是故障注入。故障注入技术可用于以下3个目的:

1

验证安全机制的有效性

2

证明特定设计对随机硬件故障的稳健性

3

在现场验证设备能够检测出可预见的故障

确定边缘随机硬件故障的影响与机器学习模型之间的联系,这是在现实世界中构建信任所必需的关键一环。如果没有构建信任,我们就无法使用机器学习和AI来实现自动驾驶汽车所需的安全相关功能。

如何利用功能安全构建信任?

就构建信任而言,我们知道,不久后的将来,在运行人工智能安全功能的汽车中,完全按照机器学习模型运行不足以保障驾乘人员的安全。在这种情况下,硬件本身的重要性转移到了模型的质量。

评估与模型的平均性能有关的指标是常见做法。而典型的方法是用准确率来定义正确分类的比率。在目标检测中 (雷达的必备功能),通常选择以mAP为指标。除了目标的正确分类,mAP还涵盖了衍生边界框的质量。

观看恩智浦半导体

汽车4D成像雷达演示

但是,我们认为要构建对模型的信任,这还不够。这些指标可能仅因为检测目标的形状较为罕见,便无法区分奇怪的错误与可以理解的人为失误。

此外,如果出现奇怪的错误,需要了解造成错误的原因才能加以解决。即使预测是正确的,它也可能基于不正确的偏见,而这是人们希望避免的。

如何理解AI算法?

为了解决这些问题,我们需要采用适当的方法打开AI算法的“黑匣子”,让人类能够理解这些预测。Grad-CAM就是这种神经网络方法的一个有趣的例子。Ramprasaath R.Selvaraju等人于2019年发表了一篇论文,其中解释了如何将特征图与其梯度相乘,以此确定输入的哪些部分对模型的预测最重要。这为用户提供了一个非常有价值的工具,可以更好地了解模型学到了什么,进而得出预测。

这也会增加人们对模型的信任,并有助于开发人员发现在训练集中发现模型缺点,然后加以解决。

作者给出了一个示例,人们训练了两种模型分别用来识别医生和护士。Grad-CAM提供了一个覆盖图(类似于热图),告诉人们使用图片的哪些部分来做出判断。在第一个模型(“有偏见”)中,模型使用面部特征来识别。这是我们不希望看到的情况,鉴于训练集存在偏见(女护士照片和男医生照片较多),模型可能会判断照片中是“护士”。经过分析和再训练后,第二个模型可根据其他要素做出决策。Grad-CAM用于验证是否需要这些要素(如听诊器)。

这个例子可以很容易地推算至与安全相关的功能。在驾驶员监测系统检测的情况下,Grad-CAM可以确保驾驶员疲劳标记的训练无偏见。

恩智浦继续投资打造功能安全和信息安全的AI解决方案。通过构建对训练数据的信任,确保ML模型的完美执行(即使是在随机硬件故障的情况下),恩智浦致力于朝着光明、安全的未来前行。

原文标题:汽车AI的功能安全和信息安全:新课题需要新解法!

文章出处:【微信公众号:NXP客栈】欢迎添加关注!文章转载请注明出处。

-

人工智能

+关注

关注

1791文章

47274浏览量

238479 -

机器学习

+关注

关注

66文章

8418浏览量

132629 -

AI算法

+关注

关注

0文章

251浏览量

12261

原文标题:汽车AI的功能安全和信息安全:新课题需要新解法!

文章出处:【微信号:NXP客栈,微信公众号:NXP客栈】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

芯盾时代中标宝鸡市金台医院零信任安全认证网关

Minitab常用功能介绍 如何在 Minitab 中进行回归分析

简单认识芯盾时代零信任业务安全平台

化工企业安全生产管控平台的构建与应用

芯盾时代为汇丰石化集团构建用户身份与访问管理平台

什么是汽车ISO 26262功能安全标准?

Akamai将生成式AI嵌入零信任安全解决方案

森林环境监控系统方案应用功能

以守为攻,零信任安全防护能力的新范式

带启用功能的150mACMOS超低智商和IGND LDO稳压器数据手册

STM8L152C6芯片的引脚复用功能怎么配置啊?

芯盾时代中标中国联通某省分公司 以零信任赋能远程访问安全

什么是零信任?零信任的应用场景和部署模式

nfc功能怎么用 NFC的五大实用功能

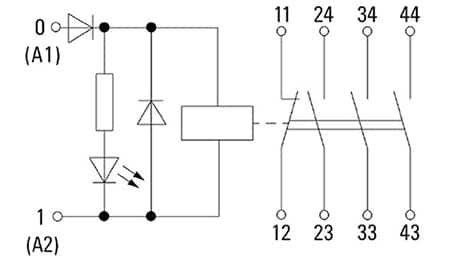

利用继电器模块提升功能安全

如何利用功能安全构建信任

如何利用功能安全构建信任

评论