从网络安全的角度来看,在工厂车间使用人工智能和机器学习既有优点也有缺点。两者都可以帮助改进对威胁和攻击的监控、检测和预防,尤其是对于工业 4.0 端点。但是依赖这些技术的智能制造系统可能会被不法分子探测和操纵。

人工智能驱动系统漏洞的一个众所周知的例子是深度伪造:由深度学习技术创建的伪造图像、视频和文本。在人眼看来,它们与原件一模一样;只有人工智能可以检测差异。

McAfee Labs 在讨论其 2020 年威胁预测报告的博客中指出,威胁行为者已使用该技术试图操纵公众舆论,但面部识别安全系统也很容易受到攻击。伪造的图像可以成功地欺骗这些人工智能驱动的系统解锁智能手机或允许入侵者使用伪造的 ID 进入建筑物。

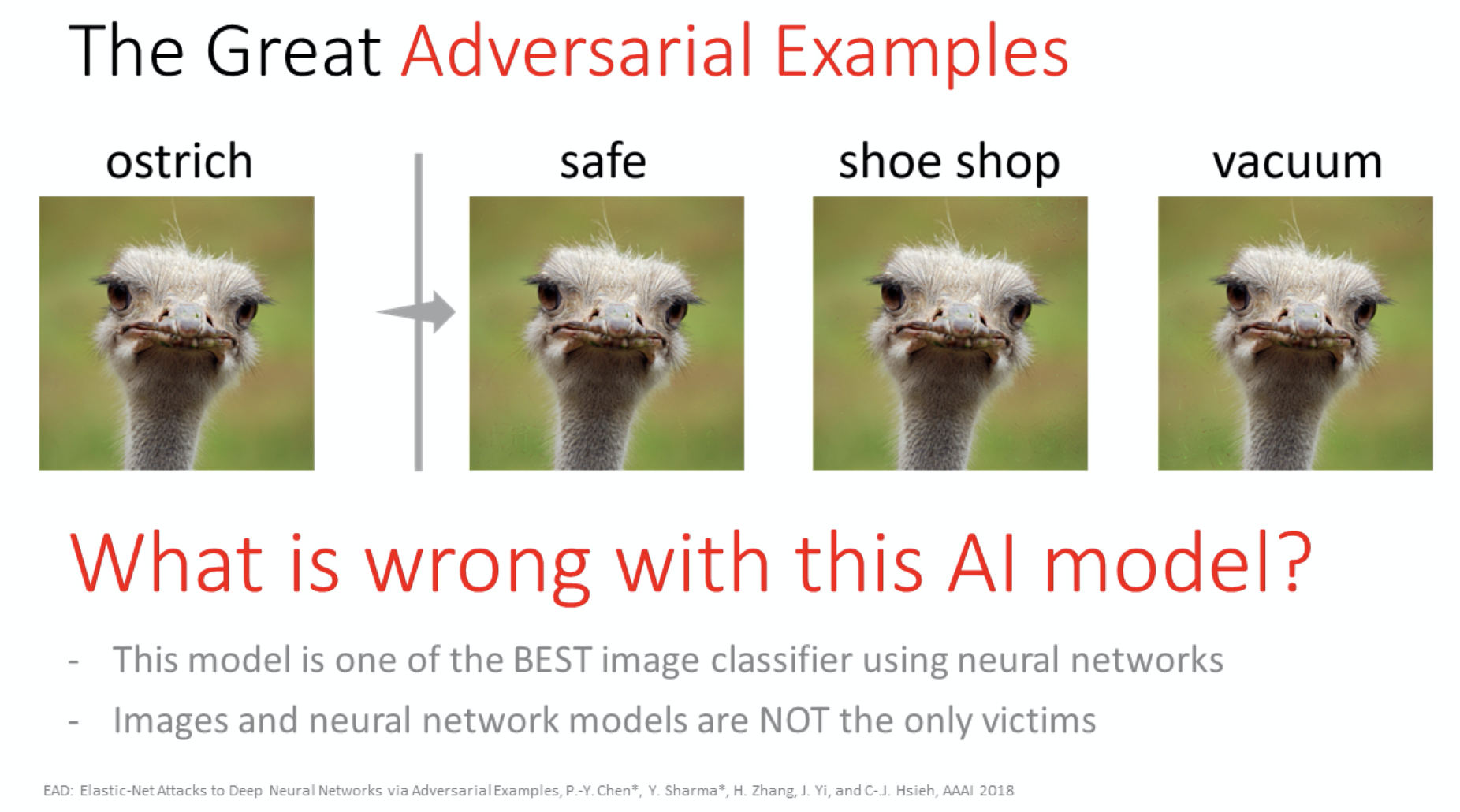

当机器模型受到损害时,它可能会错误分类与通常正确分类的图像只有最细微差别的示例,而人眼看不到差异。(来源:IBM)

所谓的“对抗性机器学习”或 AML 通常是由不良行为者实施的,但它也是网络安全研究人员和供应商与他们作斗争的工具。当攻击者使用时,AML 可能包括毒化用于模型训练的数据。图像识别和自然语言处理 (NLP) 系统都容易受到攻击。或者可以透露训练数据并推测工业或公司机密。

AML 还可以包括通过多种方法模仿有效的用户配置文件,包括通过产生与现有实际声音剪辑 99% 相同的音频波形来欺骗自动语音识别系统。相反,它们包含伪造的短语。

Rensselaer-IBM AI Research Collaboration 的首席科学家 Pin-Yu Chen 告诉EE Times,白帽黑客和研究人员可以使用 AML 来对抗对手,并通过使模型更加健壮来改进基于 AI 的技术。“例如,在计算机视觉中,它可以帮助改进基于神经网络的深度学习模型,以生成更好的数据并获得非常高质量的图像,”他说。

智能制造系统的漏洞

智能制造的网络安全挑战很多。

ARC 咨询集团网络安全服务副总裁 Sid Snitkin 告诉EE Times,在工业 4.0(也称为数字化转型)中,“每个人都希望访问一切:设备、数据存储和云中的应用程序” 。“整个想法是利用设备的这种连接性来做你甚至还没有想到的新事情。但所有这些连接都打开了新的安全漏洞,这可能意味着操作受到威胁,因为从安全角度来看,你不知道数据来自哪里或另一端的去向。”

根据 Darktrace 网络情报和分析主管 Justin Fier 的说法,可见性是工厂车间智能制造和 AI/ML 面临的最大网络安全挑战,因为无法保护你看不到的东西。“在实施工业 4.0 技术之前,您需要了解安全后果是什么。但我们倾向于先部署工业 4.0 技术,然后才考虑安全性。”

缺乏可见性对于供应链中的环节尤其重要。Snitkin 说,英特尔公司等公司正在将安全性构建到他们的硬件模块中。“但设备最大的问题是软件供应链,这是一个非常重要的问题。您正在开发的软件包使用其他来源的软件,但只有在主软件包需要补丁时才会收到警报。”

趋势科技的 Federico Maggi

由于工业制造系统仍被设计为封闭系统,因此它们被分配了与分配给高价值企业目标的不同类型的保护。“设计人员假设攻击者永远无法直接连接或直接破坏这些系统,”趋势科技高级威胁研究员 Federico Maggi 指出。“这可能是真的,但攻击者可以通过间接方式找到方法并进入目标系统。”

趋势科技 5 月份发布的一份报告显示,即使是孤立的智能制造系统也可能包括由外部顾问和员工定制设计的工业物联网设备。这些反过来又包含定制设计的软件,其中包括第三方组件。“从设计和编程 IIoT 设备的人到最终包含该部分的机器的关系链非常长,很容易失去对链中所有环节的控制,”Maggi 说。“攻击者可以通过利用最薄弱的链接轻松注入恶意组件并导致机器发生故障。”

这份名为“智能制造系统攻击”的报告是对意大利工业 4.0 实验室中模拟商品生产的安全分析,包括威胁和防御。该实验室制造玩具手机的基本原理与成熟的智能制造车间所用的基本原理相同。这些供应链弱点是该报告的主要发现之一。

工厂车间的 AML

Darktrace 的 Fier 表示,AML 的目标要么是用于制造和其他系统的人工智能,要么是模仿人类操作员的行为,然后进行大规模攻击。“例如,鱼叉式网络钓鱼活动可能会使用 NLP 来模拟和伪造电子邮件,使它们看起来是由真人发送的。”

趋势科技威胁研究经理 Rainer Vosseler 表示,在智能制造中,机器学习被用于多个领域,包括异常检测。“即使你在 AML 假设下进行操作,你的数据也必须足够好和足够可信,以便在某个时候将其提供给模型。由于流入系统的数据可以被操纵,攻击者也可以操纵模型。”

根据IBM 博客,一些机器学习模型容易受到 AML 的攻击,甚至最先进的神经网络也是如此。受损的模型错误地分类了与通常正确分类的图像仅有微小差异的示例。

Fortinet 的 FortiGuard 实验室的安全洞察和全球威胁联盟负责人 Derek Manky 解释说,特别是在运营技术 (OT) 方面,ML 对分配的任务非常具体。例如,基于 Windows/X86/PC 的界面以及许多基于 ARM 的威胁仍然存在多种特定于 OT 的威胁。“因此,机器学习模型必须学习和理解从 Linux 代码到 ARM 代码到 RISC 代码以及许多其他代码的所有内容,”Manky 说。“现在一个固有的问题是,我们如何根据不同的 OT 协议和系统或环境连接这些不同的模型?这是下一代:联合机器学习,一个分析所有这些协议和系统或环境的系统。”

IBM 陈品宇

IBM 的 Chen 表示,对抗性 AI 在现实世界中已经发生了一些损害。“一个典型的例子是自动驾驶,很容易修改停车标志并欺骗系统,这样自动驾驶汽车就不会停在需要停下的地方。”

他说,由于人工智能的开发和实施速度如此之快,用户无法及时了解已开发的内容,以及可以做什么和不可以做什么。“我们的工作是确定这一点,以便用户可以对技术抱有现实的期望,并对部署的影响更加谨慎。” 由于用户可能对实施 AI 过于乐观,IBM 创建了新的情况说明书,告诉他们部署它的风险是什么。

用人工智能对抗人工智能

在网络安全中使用机器学习的主要原因很简单:它可以异常快速地处理数据,至少从人类的角度来看是这样。它也是动态的,而不是像更传统的网络安全方法那样基于规则,因此算法可以更容易地自动化并更快地重新训练。例如,云服务提供商正在将 ML 技术整合到他们自己的网络安全防御中。

一些公司正在合作生产为特定工业部门量身定制的人工智能驱动的网络安全解决方案。例如,西门子去年表示,它正在将 OT 安全方面的专业知识与 SparkCognition 在DeepArmor Industrial人工智能方面的专业知识相结合。该网络安全工具为发电、石油和天然气以及输配电中的远程能源端点提供防病毒、威胁检测、应用程序控制和零日攻击防护。

对抗 ALM 的大部分工作是由网络安全公司基于使用人工智能和机器学习的产品来完成的,以帮助改进对威胁和攻击的监控、检测和预防,特别是对于 IoT 和 IIoT 设备等端点。例如,Darktrace 的与协议无关的工业免疫系统可以了解跨 OT、IT 和 IIoT 环境的“正常”情况。据该网站称,其基于机器学习的 Antigena 网络“可以以机器速度和外科手术精度中断攻击,即使威胁是有针对性的或完全未知的” 。

Fier 说,由于对手肯定在进行自己的 AML 研究,因此公司必须投资于 AI 防御。“它不再是最前沿的——它是堆栈中的必备品。检测和缓解的时间过去是 200 天,但现在不是了。” 由于人工智能的处理速度非常快,“如果人工智能对你不利,你很可能永远看不到它,或者你玩得太晚了,你永远无法恢复,”他说。“这就是为什么我认为AI对抗AI是最好的对决。”

Fortinet 的网络安全也是人工智能驱动的。Manky 说,需要三件事来防范 AML 攻击和攻击者。“首先,你需要处理能力,这已经不是什么挑战了。接下来,您需要数据——以及新的可靠数据,来自不同来源的大量数据,包括我们从全球部署的近 600 万台安全设备中获得的数据。第三个要素是时间。你真的需要走在曲线的前面,尤其是在处理新兴或已经存在的垂直行业时,比如 OT。”

Fortinet 的 Derek Manky

陈说,像 IBM 这样的公司正在开发更好的人工智能技术,以根据数据收集缺陷了解导致漏洞的原因。“我们扮演着与白帽黑客类似的角色:我们在产品推出之前识别漏洞并了解对市场的道德影响。”

对抗性攻击可能发生在模型开发的三个阶段中的任何一个阶段:收集数据、训练模型或在现场部署模型。有不同的对策和技术来解决每个问题。IBM 的模型清理服务描述了好的模型,然后返回一个干净的模型。另一项服务为稳健模型提供基准。

即将推出:人工智能驱动的恶意软件?

不幸的是,使模型对攻击更健壮通常意味着牺牲性能,因为更健壮的模型也不太灵活。此外,深度学习模型复杂且难以集成。“我们不知道模型如何解决任务这一事实使得我们更难知道它是否安全,”Chen 说。“我们怎么知道它真的学会了如何解决问题?”

另一个障碍是试图跟上简单的攻击量。与安全研究一样,“如何才能使补丁足够可靠、足够安全,以应对未来的攻击?” 陈问。一个答案可能是一个认证过程,例如 IBM 正在开发的一个。它可以对 AI 系统的安全区域或操作区域进行分类,这对于用于关键工作的 AI 尤其重要。

Darktrace 的 Fier 警告说,基于人工智能的恶意软件可能很快就会出现。“虽然人工智能驱动的恶意软件还没有完全发挥作用,但我们开始看到它出现了——它即将出现,”他说。“据我们所知,对抗性 AI 或 ML 在 [工业控制系统] 领域还没有出现。但我设想在你的 ICS 环境中存在一个恶意软件,在采取下一步行动之前从中学习。对工业领域影响最大的可能是扩大损害。”

但到目前为止,大多数攻击都使用自动化,而不是机器学习,Fortinet 的 Manky 说。“这是个好消息,因为自动化比 ML 更容易击败。我们每天看到 200 万个病毒进入我们的实验室,其中大部分是微不足道的自动化。但我们开始看到一些 ML 和 AI 逃避安全的迹象,所以它肯定会到来。”

审核编辑 黄昊宇

-

AI

+关注

关注

87文章

32331浏览量

271431 -

工业系统

+关注

关注

0文章

63浏览量

16583

发布评论请先 登录

相关推荐

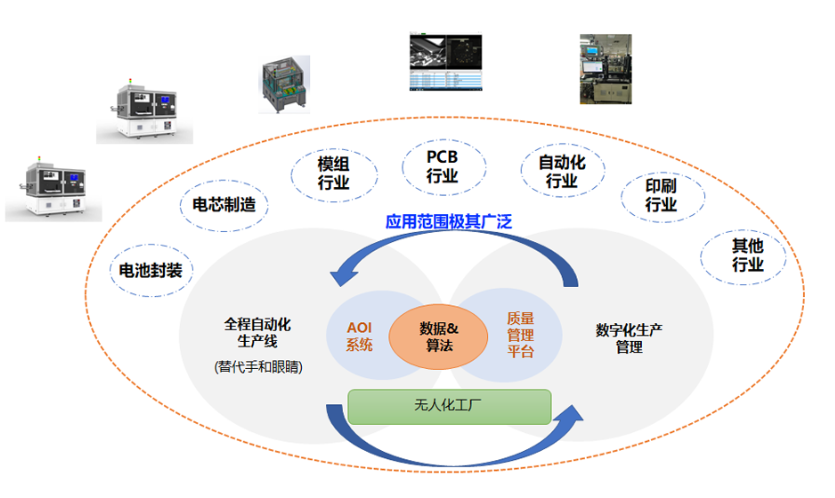

数据驱动AI工具在哪

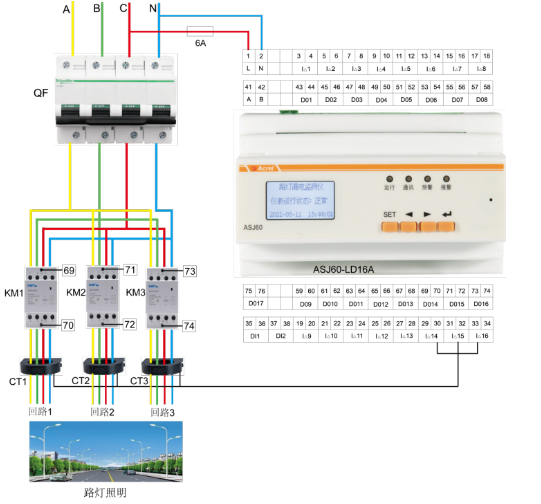

路灯漏电会导致哪些安全隐患

工业谐波治理新利器:ANAPF有源滤波器

交流断电后内部的电容可能会损坏吗

英特尔在CIIF 2024上引领AI驱动的工业智能新时代

小驱动带大电机会有什么问题

槽型光电开关可能会受哪些因素的干扰

电力系统为什么会产生谐振,怎么处理?

步进电机失步可能因素

松下伺服驱动器故障代码介绍

Deepfakes 可能会危及 AI 驱动的工业系统

Deepfakes 可能会危及 AI 驱动的工业系统

评论