在过去的两年里,人工智能已经从学术奇迹转变为全球大趋势。某种形式的机器学习将彻底改变几乎所有事物——消费、汽车、工业、电子的每个领域——除此之外,还会以我们还不知道的方式影响社会和我们的生活。

这对行业意味着,几乎每个处理器供应商都将机器学习视为会下金蛋的鹅。竞争正在将自己的方法定位为正确的解决方案,以加速最具潜力的领域中的特定工作负载:数据中心之外的机器学习,或边缘的人工智能。

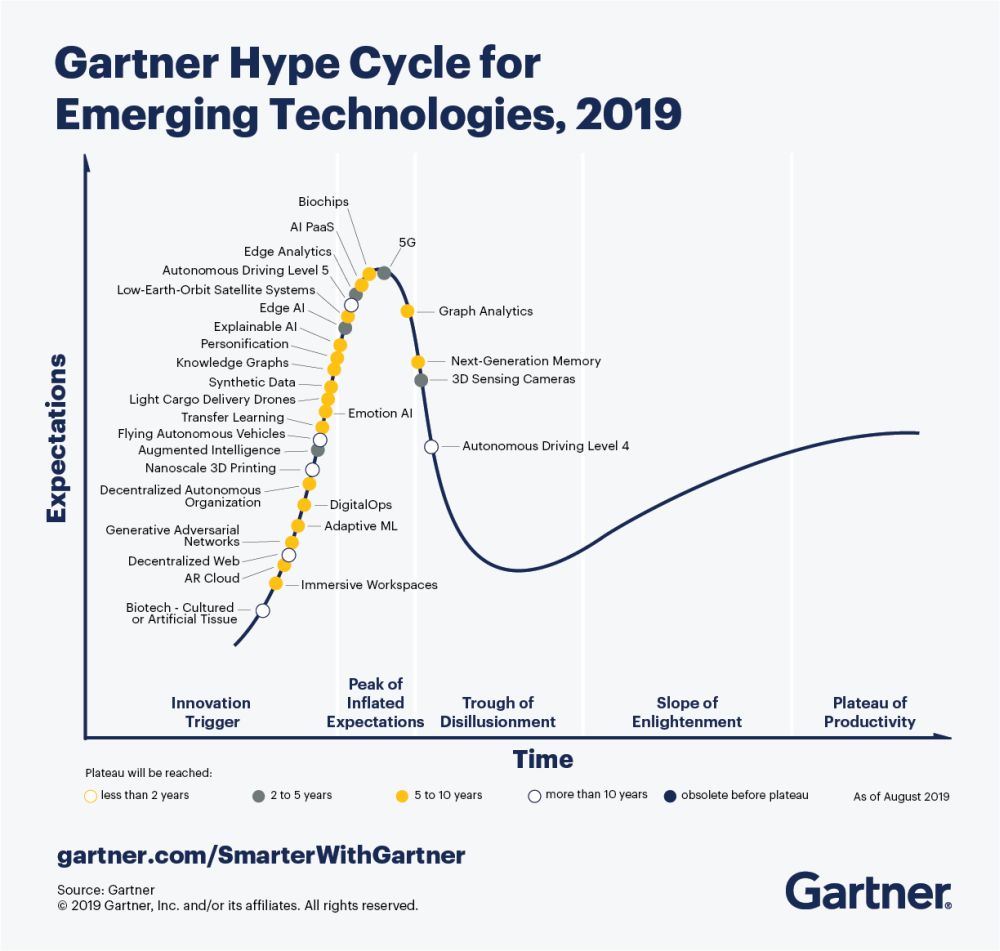

边缘的人工智能有很大的希望,因为它几乎可以应用于所有电子设备,从可以看到路上行人的自动驾驶汽车到响应语音命令的咖啡机。需要延迟、数据隐私、低功耗和低成本的任意组合的应用程序最终将迁移到边缘的 AI 推理(请注意,“边缘 AI”是 Gartner 图表上的唯一 AI 点,距今不到 5 年)。

今年的 Gartner 新兴技术炒作周期。Edge AI 距离“生产力的高原”还有两到五年的时间。(图片:Gartner)

AI 推理的工作负载是特定的:它们需要对大量低精度数据进行大规模并行处理,内存访问成为瓶颈。大多数(如果不是全部)类型的处理器都试图弯曲自己以适应这些要求。

现有技术是 GPU——今天实际上是一个公司的细分市场。幸运的是,GPU 的单指令多数据 (SIMD) 架构是为加速计算机图形而开发的,结果证明它非常适合 AI 工作负载。英伟达正在尽可能地利用这一浪潮,为数据中心和自动驾驶开发人工智能超级计算机,以及用于边缘设备的缩小版本。

其他人也都想分一杯羹。长期以来一直用于加速数学算法的 FPGA 供应商正在改进他们的产品以适应边缘 AI 处理。Xilinx 采用域特定架构的概念并与之一起运行,将可编程逻辑与其他计算类型相结合,以允许针对新工作负载定制数据流。与此同时,莱迪思的目标是低功耗设备中的图像处理。

还有许多初创公司将他们的新颖架构作为下一件大事。它们的范围从内存处理器技术(Mythic、Syntiant、Gyrfalcon)到处理器近内存技术(Hailo);从可编程逻辑 (Flex Logix) 到 RISC-V 内核(世界语、GreenWaves);从非常小的(Eta Compute)到超大规模(Cerebras,Graphcore)。大多数用于边缘的人工智能。当它们与英伟达和英特尔等公司对抗时,是否有足够的利基市场来支持它们?时间会证明一切。

还有一些初创公司从另一个方向解决了这个问题:调整人工智能工作负载以在微控制器等传统硬件上更有效地运行。PicoVoice 和 Xnor 等公司正在寻找新的方法来利用现有设备的指令集来执行矩阵乘法。

结合谷歌在 TensorFlow Lite 上的工作——一种将机器学习模型缩小到可以安装到微控制器上的编译器——这无疑将为不需要联网的声控设备等东西打开闸门——连接做推理。

面对新型加速器芯片组的嵌入式开发人员将不得不学习如何使用它们。软件是这个难题的重要组成部分。更传统的 CPU、MPU 和 MCU 显然在这方面处于领先地位。

虽然围绕一个新的软件平台建立一个开发者社区并非不可能,但这并不容易。英伟达花了十年时间将其 GPU 软件平台 CUDA 打造为今天的成功。任何进入这个领域的人都需要构建库和工具包,并通过会议和论坛努力教育开发人员。所有这些都会使初创公司的有限资源紧张。

灵活性是成功秘诀的另一个重要因素。虽然今天的图像处理模型依赖于卷积神经网络 (CNN),但不同类型的神经网络适用于其他应用,例如语音识别,并且学术界一直在提出新的神经网络概念。高级网络可能需要更复杂的数据流方案。为加速当今的 CNN 而开发的硬件可能过于专业,无法加速未来的网络平台。因此,应将 AI 工作负载的性质视为一个移动目标,在灵活性和性能之间取得适当平衡,这对于面向未来至关重要。

争夺这个空间的战斗才刚刚开始。获胜者将是选择正确的利基市场并努力追求的公司,投资于软件堆栈和教育行业,并为这个快速发展的行业保持一定的灵活性。当然,要以合适的价格做这一切。

审核编辑 黄昊宇

-

人工智能

+关注

关注

1792文章

47443浏览量

239020

发布评论请先 登录

相关推荐

在边缘设备上设计和部署深度神经网络的实用框架

启明云端2024火山引擎FORCE原动力大会·冬正在进行中,共赴AI探索未来科技盛宴

边缘人工智能的竞赛正在进行中

边缘人工智能的竞赛正在进行中

评论