收集数据从未像现在这样容易。只需单击几下,您就可以启动并运行,配备云必须提供的所有最佳数据技术,准备好囤积所有可能的数据。很难相信就在十年前,情况发生了巨大的不同。事实上,大规模收集数据只是最大的公司的一种选择,这些组织既能负担得起昂贵的服务器(这是存储所有数据的唯一可行选择),又能负担得起少数能够做到最好的工程师其中,在数据科学只是一个新兴领域的时代。

如今,幸运的是,生成数据不再只是一项企业运动。事实上,多亏了物联网 (IoT),无论好坏,我们现在都变成了小型大数据工厂。到 2020 年,一个人将负责每秒生成 1.7 MB 的数据。即使是现在,仅一辆自动驾驶汽车每天就会产生 11TB 的数据。而且这种趋势没有减弱的迹象。相反:它只会增长。

对于所有数据爱好者来说,这显然是个好消息。不久前,收集高质量的数据集是一项繁重而艰巨的任务。尽管如此,我们总是想要更多。如果您的全新深度学习模型似乎“仅”达到 92% 的准确率,那么最简单、最容易找到的借口就是指责数据。“我的数据集不够大”,我们漫不经心地告诉我们的老板。“但如果我们再等几个星期,这个模型将是你见过的最好的模型!”

这似乎提出了一个重要问题:实际上有多少数据才足够?但它实际上提出了一个更重要的问题:多少数据太多了?

有趣的是,我们在机器学习圈中并不经常听到这个问题,即使我们真的应该听到。虽然大数据是一个巨大的机会,但它也是一个巨大的 40 zettabyte 责任。如果数据确实是新的石油,我们需要把类比推到极限:数据是一种极其有利可图的资源,但也像石油一样,需要提炼。未能克制自己不受控制的使用使我们处于危险之中。简而言之,我们今天使用和考虑数据的方式是非常不可持续的,这一事实仍然几乎没有达到集体意识。

也许,只是也许,这是错误的对话。也许大数据毕竟不是人工智能的真正答案。

让我们退后一步,想想我们真正收集的是什么。回到数字化的早期,数据收集确实成本更高,所以我们选择了我们的位置。我们更负责任,更认真。随着生成和收集数据变得越来越容易,对质量的关注越来越少,而数量成为云存储、云计算、GPU 机器、大规模数据管理和传输系统等新技术的自然副产品。很快,数据变成了一种商品,但随着数据和数据存储的不断升级,没有人提出一个简单的问题:我们为什么要收集这些?它甚至有意义吗?

随着模型构建的商品化,数据护城河似乎是人工智能差异化的明显答案,但我们都错过了大局吗?数据时代。它变得陈旧。最终,即使我们被诱使相信数据和信息是两个截然不同的事物,但并非所有数据都是 平等的。毕竟,一个十几岁的少年在发到 Instagram 之前自拍了 20 张自己的照片,这肯定与可搜索的医学文献目录不同。

只要我们坚信硬件的进步将使我们免受数据灾难的影响,这一切似乎都不是问题。数据存储越来越便宜,计算能力也越来越容易获得。只有当数据的生成被工程师跟上摩尔定律的能力所抵消时,这才是真的。即使他们可以无限期地做到这一点,请考虑以下问题:如果并非所有数据都具有同等的信息性,那么处理子数据或冗余数据有什么意义?

我可以通过我的电脑屏幕听到数百名数据科学家的声音,他们抗议说,更大的训练集是他们痛苦的答案。毕竟,难道几代专家没有一次又一次地告诉我们,数据越多越好吗?

事实并非如此简单。显然,获得高质量、足够大的数据集是机器学习取得进展的关键。然而,如果医生告诉你生病了,急需大量摄入维生素C,你难道不想认真地确定哪些食物确实含有上述维生素,而不是冲到你的厨房,吃掉你能在那里找到的每一种食物吗?毫无疑问,吃下冰箱或食品储藏室里的所有食物最终会让你获得一些急需的维生素C,但在这个过程中,你也会消耗很多空热量。不幸的是,今天我们处理机器学习的方式似乎需要相当于营养师的干预。

这似乎是一个愚蠢的类比,但这里有一些分量。例如,认为功能更强大的GPU机器最终会让我们摆脱困境的观点是有严重缺陷的,就像认为暴饮暴食会帮助我们摄入维生素一样。实际上,我们收集的很多数据不仅与我们试图使用它训练的模型冗余或无关,而且往往对这些模型有害。例如,过度增长的训练集通常是不平衡的,可能会导致过度拟合。一些极端的异常值实际上可能会导致模型“忘却”数据可能被错误标记、错误收集或错误。

这就提出了一个重要的问题:如果数据科学家最适合就哪些数据可能对模型学习更有用提供反馈,那么为什么他们仍然几乎不参与旨在收集数据的硬件设备的设计,而且很少有机会提供数据收集过程本身的反馈?

答案实际上比最初看起来更简单:正如营养学家根据不同客户的独特营养需求向他们提供不同的建议一样,数据科学家也只能建议针对特定用例收集哪些数据。简而言之,在训练给定模型的背景下,信息量最大的数据实际上可能与另一个模型完全无关,这使得在源位置对数据进行不可知分类具有挑战性。

硬件显然无法解决所有这些问题。它无法确定哪些数据行正在降低模型的准确性。它无法弄清楚哪些是多余的。它不能重新标记错误的数据点。换句话说,存储太多数据并不能解决存储太多数据带来的问题。我们需要专注于创建一个额外的智能层,能够从渣滓中分类有意义的数据。我们需要开始关注那些从较小的、经过整理的数据集构建出色模型的数据科学家。我们需要明白,是的,您可以过度喂食您的模型。

数据的未来并不存在于容纳每个数据点的巨大服务器场中,而不管哪些数据点实际上是有用的。它存在于小型智能数据中。它是基于数据质量及其与用例相关性的深思熟虑的方法,而不是主要基于数量的草率方法。对于我们这些没有无休止的标签和服务器预算的人来说,它更容易获得。换句话说,它既更智能,也更民主。

这是我们都可以落后的。

Jennifer Prendki是 Alectio 的创始人兼首席执行官。这家公司是她相信好的模型只能用好的数据建立的直接产物,而盲目地使用越来越大的训练集的蛮力方法是进入人工智能的障碍如此之高的原因。在创立 Alectio 之前,Jennifer 是 Figure 8 的机器学习副总裁、数据标签的先驱、Atlassian 的首席数据科学家和沃尔玛实验室搜索团队的数据科学高级经理。她拥有索邦大学粒子物理学博士学位。她最喜欢的口号是:“并非所有数据生来都是平等的”、“数据是新塑料”和“智能数据 > 大数据”。

审核编辑 黄昊宇

-

数据

+关注

关注

8文章

6884浏览量

88816 -

物联网

+关注

关注

2903文章

44257浏览量

371152

发布评论请先 登录

相关推荐

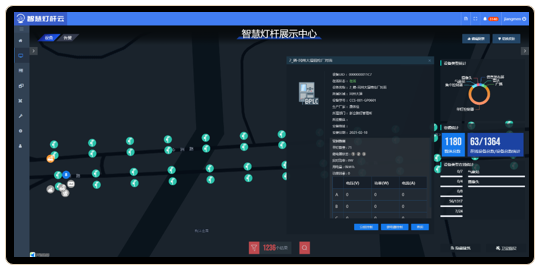

智能数据:物联网的下一个前沿

智能数据:物联网的下一个前沿

评论