InfiniBand(直译为“无限带宽”技术,缩写为IB)是一个用于高性能计算的计算机网络通信标准,是世界领先的超级计算机的互连首选。基于NVIDIA InfiniBand的端到端网络可实现极低的延迟,以及高数据吞吐量和传输速率。

InfiniBand网络主要用于高性能计算(HPC)场景,通过高速的InfiniBand技术,将业务负载由单机运行转化为基于多机协作的高性能计算集群。采用了InfiniBand网络技术,使得高性能集群的性能得以进一步地释放和优化。

作为未来算力的基本单元,高性能的数据中心也越来越多地采用InfiniBand网络方案,尤其是在超算中心中应用最为广泛。

本文中出现的与NVIDIA产品相关的图片或视频(完整或部分)的版权均归NVIDIA Corporation所有。

01

NVIDIA Quantum-2 InfiniBand平台:400Gb/s NDR InfiniBand网络互连

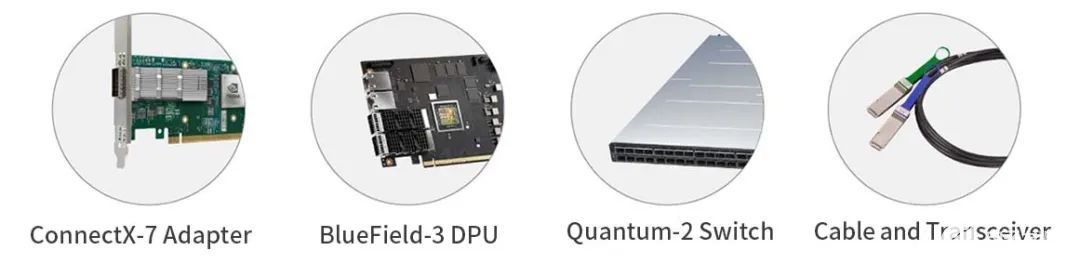

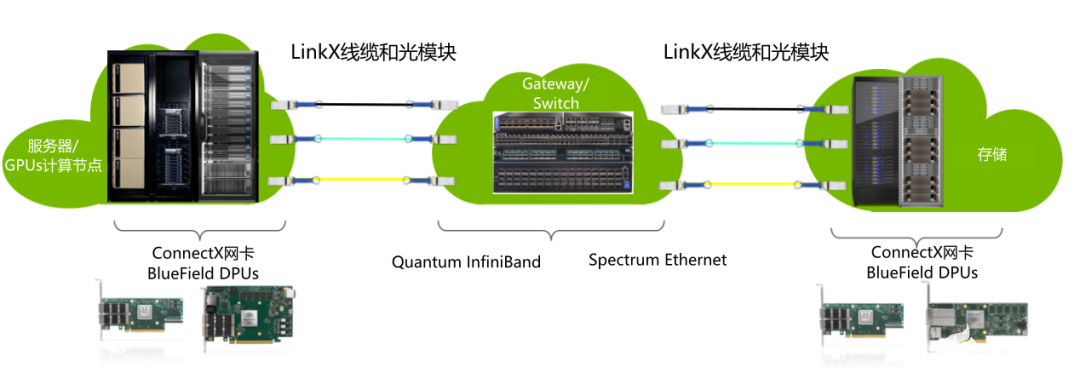

NVIDIA所提供的InfiniBand系列产品主要包括网卡、DPU、交换机以及LinkX线缆和光模块,速率从100Gb/s EDR到200Gb/s HDR再到最新的400Gb/s NDR。NVIDIA最新发布的Quantum-2 InfiniBand平台继续创造高性能网络的更高纪录,包括NVIDIA Quantum-2交换机、ConnectX-7网卡、BlueField-3 DPU、LinkX线缆和光模块,一同构成了面向新一代高性能计算、人工智能、机器学习、大数据、云计算、Web 3.0和存储平台的完整400Gb/s NDR InfiniBand网络互连基础设施。

NDR InfiniBand凭借其最高的数据吞吐量、极低的延迟和智能的网络计算加速引擎,可为要求最苛刻的计算和数据应用提供世界领先的性能和可扩展性。

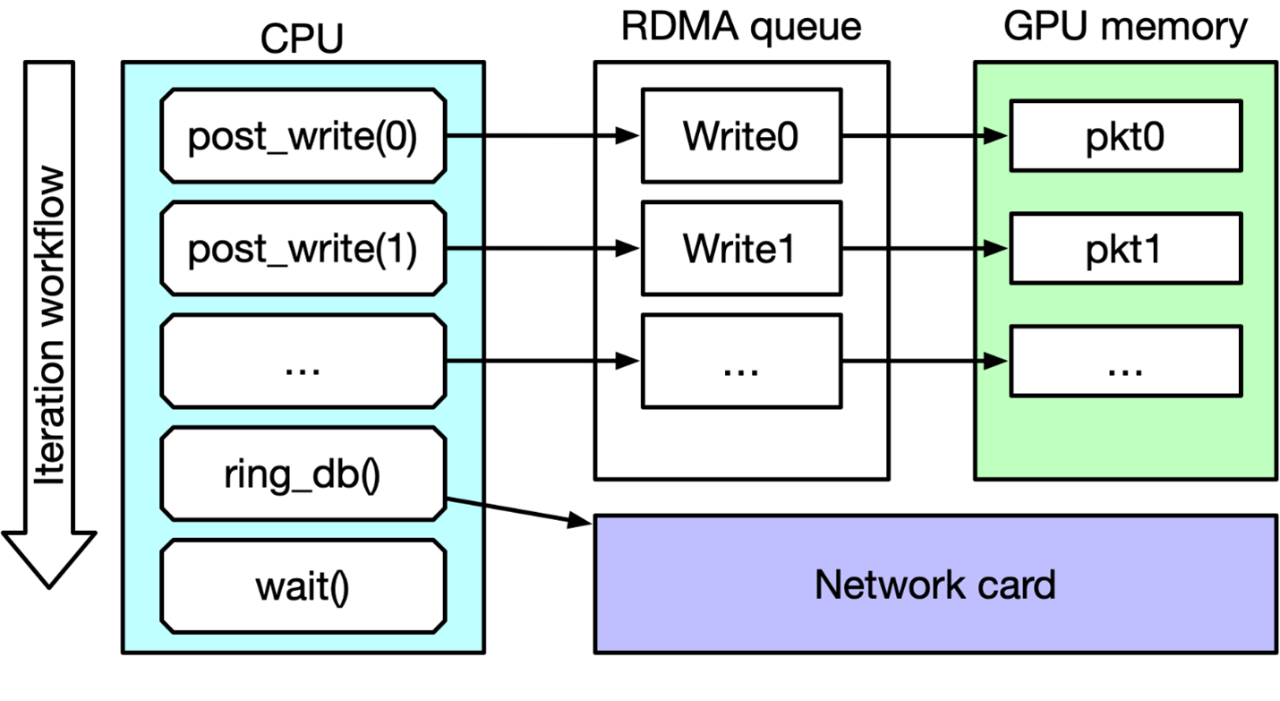

NVIDIA Quantum-2 InfiniBand平台不但能够实现GPU Direct RDMA对AI业务至关重要的技术。其中BlueField-3 DPU增加了DPA 引擎(Data-Path Accelerator)来对特定流量进行编程和加速。ConnectX-7 VPI系列IB网卡对各种通信模型基于网络的计算进行了专门优化,提高了All reduce 和 All-to-All等通信时的通信效率。凭借单端口每秒400Gbps的高吞吐量,NVIDIA Quantum-2 InfiniBand将端口速率提高一倍,网络物理端口数量增加1.5倍。Quantum-2平台的系统容量提升至上代产品的5倍,支持的数据中心的规模提升了6.5倍,而数据中心网络的能耗则降低了36%。

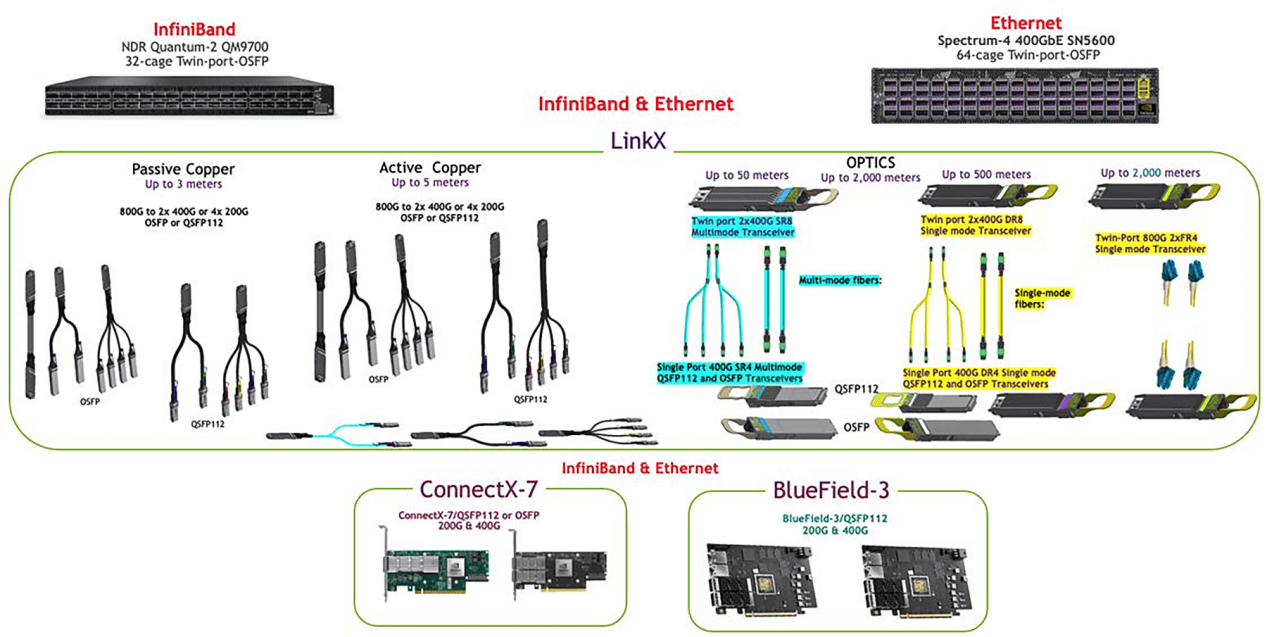

NVIDIA Quantum-2的盒式交换机,芯片采用7nm工艺,包含570亿个晶体管,配有64个400Gbps端口,通过Split线缆以提供多达128个200Gbps端口。交换机的双向总吞吐量为51.2Tb/s,具有超过每秒665亿数据包的标志性包转发能力。同时,Quantum-2平台提供不同端口数的模块化交换机系统,可以支持多达2048个,系统容量超出上一代5倍。基于NVIDIA Quantum-2交换机ASIC的盒式交换机和模块化交换机系统提供了全面的InfiniBand交换互连接解决方案,支持各种InfiniBand网络拓扑,包括Fat Tree、DragonFly+、多维 Torus等。

NVIDIA Quantum-2平台在主机端提供两个网络选项,ConnectX-7网卡和BlueField-3 DPU。ConnectX-7基于7nm工艺,包含80亿个晶体管,其数据传输速率是上一代的两倍,通过RDMA、GPU Direct Storage、GPU Direct RDMA和网络计算加速应用,充分发挥网络的能力。BlueField-3采用7nm工艺,包含220亿个晶体管,提供16个64位ARM CPU,基于数据IO的业务部署,提供加速、卸载和隔离的能力,优化了数据中心基础设施的架构。

为了打造完整的端到端400Gb/s InfiniBand 基础架构,NVIDIA Quantum-2还提供了LinkX解决方案,为用户提供一系列不同类型的400Gb/s DAC线缆(高速铜缆)、AOC线缆(有源光缆)以及光模块产品,以构建复杂的基础设施,可以为选择的拓扑结构提供最大的灵活性,针对不同的连接场景,提供全套的线缆模块方案。

NVIDIA LinkX拥有完善的产品体系,可提供不同的方案组合(光模块、DAC/AOC直连以及分支高速线缆),速率包括EDR(100G)、HDR(200G)和NDR(400G),外形尺寸涵盖QSFP28、QSFP56以及OSFP。

LinkX产品在NVIDIA“端到端”网络系统中发挥了最佳的效果和独特的功能,除了满足InfiniBand贸易协会 (IBTA) 标准外,LinkX产品在出厂之前完成了100% 真实业务测试,确保线缆模块的品质,从底层支持InfiniBand网络实现高性能。NVIDIA LinkX产品的低误码率、低延时、低功耗和高可靠性等特点可以与NVIDIA交换机和网卡产品完美适配,在具有严格要求的超级计算机和超大规模系统中提供了最优的传输效率。

02

构建InfiniBand网络出现的常见问题

目前市面上有部分客户在构建InfiniBand网络时使用了第三方的光模块、高速线缆等连接件产品,然而却在实际应用中出现了大量的问题,主要表现为:

1、网络链路不稳定:出现链路震荡现象

2、传输延时高:在推理、训练等业务负载下,大大延长训练周期

3、功耗高:产品发热异常,严重时甚至可能损坏设备

4、产品质量良莠不齐:经常出现大批量无法使用的情况

纳多德NADDOD——作为NVIDIA网络产品Elite Partner (精英级别合作伙伴),致力于为客户提供高品质高性能光网络解决方案,在为客户搭建高性能网络方案的过程中,收到不少因使用第三方InfiniBand连接件而出现售后问题的反馈,导致用户网络延迟甚至中断,额外增加了客户处理售后问题所花费的时间成本。

结合大量真实案例中出现的情况,纳多德NADDOD建议在InfiniBand网络中使用的连接件(DAC/AOC线缆、光模块),一定要选用NVIDIA LinkX原厂线缆,以最大程度地保证连接件与设备之间的适配性,以及保障网络的稳定传输与高可靠性。

审核编辑 黄昊宇

-

NVIDIA

+关注

关注

14文章

5105浏览量

104446 -

InfiniBand

+关注

关注

1文章

29浏览量

9231 -

英伟达

+关注

关注

22文章

3872浏览量

92441

发布评论请先 登录

相关推荐

支持PCIe5.0,杰和科技B760主板IB5-8131亮点都在这

MX2412H高速复用器芯片的应用EUVIS

基于 400Gbps 100G-PAM4 OSFP 和 QSFP112 的线缆和光模块之IB网络连接

RS232接口数据传输稳定性

简单认识NVIDIA网络平台

IB Verbs和NVIDIA DOCA GPUNetIO性能测试

基于100G-PAM4技术的LinkX 线缆

稳定可靠的网络连接解决方案

光纤布线如何保证数据可靠传输

网络解码矩阵:医院高清视频传输的可靠保障

NVIDIA LinkX 助力IB网络高速稳定与可靠传输

NVIDIA LinkX 助力IB网络高速稳定与可靠传输

评论