随着人工智能领域的发展,这些设备的计算量和功耗都在增加。随后,边缘设备上的处理负载随着系统架构的性能和复杂性而显着增长。因此,更高分辨率的图像和更复杂的算法被灌输到系统中,随着对人工智能处理的需求不断增加,需要进一步优化以实现高 TOPS 性能。

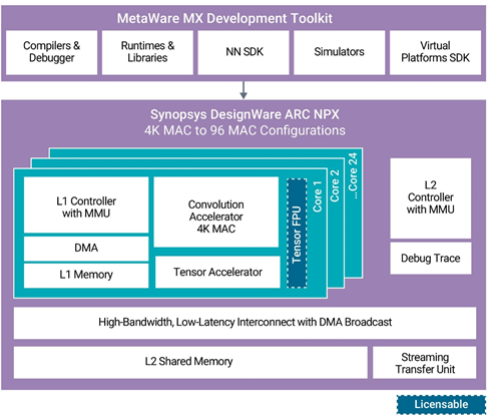

Synopsys 发布了神经处理单元 (NPU)、知识产权 (IP) 内核和工具链,以满足 AI 片上系统 (SoC) 中日益复杂的神经网络模型的性能需求。其新的 DesignWare ARC NPX6 和 NPX6FS NPU IP 可处理实时计算的需求,同时为 AI 应用消耗超低功耗。此外,该公司的新 MetaWare MX 开发工具提供了一个完整的编译环境和自动神经网络算法分区,以最大限度地提高最新 NPU 上应用软件开发的资源效率。

使用新的 DesignWare ARC NPX6 和 NPX6FS NPU IP 以及 MetaWare MX 开发工具包,设计人员可以利用最新的神经网络模型,满足不断升级的性能预期,并加快其下一代智能 SoC 的上市时间。ARC NPX6 NPU IP 系列包括众多处理深度学习算法覆盖的产品,包括对象识别、图像质量增强和场景分割等计算机视觉任务,以及音频和自然语言处理等更大的人工智能应用。设计中的单个内核可以从 4K MAC 扩展到 96K MAC,以实现超过 250 TOPS 的单个 AI 引擎性能和超过 440 TOPS 的稀疏性。

NPX6 NPU IP 包含对多达 8 个 NPU 的多 NPU 集群的硬件和软件支持,稀疏度为 3500 TOPS。由于硬件和软件中的高级带宽功能以及内存层次结构(每个内核中包含 L1 内存和访问通用 L2 内存的高性能、低延迟连接),因此可以扩展到大量 MAC 数量。对于受益于神经网络内的 BF16 或 FP16 的应用,提供了一个可选的张量浮点单元。

图片来源:新思科技

MetaWare MX 开发工具包为应用软件开发提供软件编程环境,包括神经网络软件开发工具包 (NN SDK) 和虚拟模型支持。NN SDK 自动将使用 Pytorch、Tensorflow 或 ONNX 等流行框架训练的神经网络转换为 NPX 优化的可执行代码。

其概念是,NPX6 NPU 处理器 IP 可随后用于制造各种产品,从几 TOPS 到数千 TOPS,所有这些都可以使用单个工具链编写。

NPX6 NPU IP 的主要特点:

可扩展的实时 AI/神经处理器 IP,性能高达 3,500 TOPS,支持 CNN、RNN/LSTM、转换器、推荐网络和其他神经网络。

电源效率(高达 30 TOPS/W)在业界是无与伦比的。

1-24核卷积加速器,增加4K MAC/核

支持张量算子集架构并允许变量激活 (TOSA) 的张量加速器

软件开发套件

自动混合模式量化工具

降低带宽的架构和软件工具特性

通过并行处理各个层来减少延迟。

DesignWare ARC VPX 矢量 DSP 无缝集成。

生产力很高。MetaWare MX Development Toolkit 支持 Tensorflow 和 Pytorch 框架以及 ONNX 交换标准。

此外,ARC NPX6FS NPU IP 符合 ISO 26262 ASIL D 标准,用于随机硬件故障检测和系统功能安全开发流程。这些处理器具有符合 ISO 26262 的特定安全机制,可处理下一代区域设计的混合关键性和虚拟化需求,以及完整的安全文档。

ARC MetaWare MX 开发工具包包括神经网络软件开发工具包 (SDK)、编译器和调试器、虚拟平台 SDK、运行时和库以及高级仿真模型。它提供了一个统一的工具链环境来加速应用程序开发,并在 MAC 资源之间智能地划分算法以进行优化处理。MetaWare MX 安全开发工具包包含安全手册和安全指南,可帮助开发人员满足 ISO 26262 标准并为安全关键型汽车应用的 ISO 26262 合规性测试做准备。

使用 NPU 集群加速边缘 AI 应用程序

为了满足 AI 应用日益增长的性能和复杂需求,NXP NPU IP 内核提供了高性能、可扩展的实时 AI 和神经处理 IP,高达 3500 TOPS 支持各种神经网络,如 CNN、RNN/LSTM、变压器、和推荐网络。

此外,它通过并行处理各个层来减少延迟。此外,高效的 MetaWare MX 开发工具包支持 Tensorflow 和 Pytorch 框架以及 ONNX 交换格式。

审核编辑:郭婷

-

变压器

+关注

关注

159文章

7258浏览量

134765 -

神经网络

+关注

关注

42文章

4751浏览量

100443 -

AI

+关注

关注

87文章

29892浏览量

268177

发布评论请先 登录

相关推荐

嵌入式和人工智能究竟是什么关系?

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

risc-v在人工智能图像处理应用前景分析

FPGA在人工智能中的应用有哪些?

人工智能神经元的基本结构

意法半导体ST Edge AI Suite人工智能开发套件上线

人工智能神经网络系统的特点

人工智能神经网络芯片的介绍

Rebellions选择 arteris作为其下一代神经处理单元,瞄准生成人工智能

您是否了解边缘人工智能这一概念?

施耐德电气携手英伟达推进边缘人工智能和数字孪生技术突破性变革

BrainChip与MYWAI建立合作,助力边缘人工智能解决方案

意法半导体加快边缘人工智能应用,助力企业产品智能化转型

用神经处理单元集群改造边缘人工智能

用神经处理单元集群改造边缘人工智能

评论