自然语言处理(简称NLP)被誉为“人工智能皇冠上的明珠”、“实现通用人工智能(AGI)的钥匙”。

当自然语言处理技术遇到司法系统,会擦出怎样的火花?

在这里先跟大家分享一个“常识”:

据我国的法律,给出的量刑大都是一个区间,而不是具体值,比如判刑3年到5年。

那么究竟是3年、4年还是5年,需要法官对具体问题进行具体分析。

其出发点是好的,但实际却让一些经验欠缺的法官左右为难:判久了对被告不利,判的时间不足对受害者又不够公平。

不过现在嘛,法官的这个烦恼可以先放放了,因为有一项AI前来“搭把手”。

这个AI背后的主要技术,其实就是自然语言处理,它可以提取出当前案件中的诸多要素,将其和其他类似案件的要素作对比,最终分析得出具体建议值。

NLP技术在司法领域的应用

事实上,除了能够辅助法官量刑外,现在“NLP+司法”的应用已不胜枚举。

因为司法系统的构造可不简单:它包括公安、检察院、法院、司法局、律师,当然还有民众。

对于不同的群体和场景,需要采用不同的方案和技术。

例如,在庭审场景下,有AI帮忙做笔录那就省事儿多了,还可以大幅提升庭审效率。

于是“语音识别自动生成庭审笔录”不就来了吗?

目前,科大讯飞的语音识别自动生成庭审笔录已经覆盖了29个省份的法庭,平均使庭审时长缩短了30%,为复杂庭审缩短时长还达到了50%。

此外,对公安、检察院、法院比较熟悉的朋友可能知道,很多案件都有厚厚一叠卷宗,手动编目、分类费时费力,现在这种活儿也可以交给AI来处理了,文字OCR技术在这里大显身手。

编目完成后,还有重头戏:阅卷。当然,AI又被派上了用场,它可以辅助办案人员阅读卷宗,例如:要素索取、结果呈现。

然后到了案件中至关重要的一部分:证据。

事实上,证词和线索往往都来自不同的个体,很多时候都会不出现证据不一致等情况,为此让人工分析推理,是件非常淘神费力的事情。

而AI现在可以辅助办案人员校验证据了,具体来说,就是AI单个人提供的笔录等进行校验,并且对不同人给出的信息进行对比、矛盾审查。

这背后涉及到实体识别、指代消解、语义角色和依存关系分析等NLP技术延伸出来的方法。

对于上述提到的卷宗、笔录等法律文本,AI还能自动发现文本中的错别字词和语法错误。

为实现这样的效果,讯飞采用了BERT中文全词Mask(BERT-Chinese-wwm)模型,这是一个哈工大和讯飞联合发布的全词覆盖中文BERT预训练模型。

除此之外,面向普通大众,讯飞还发布了法律自动问答AI助手“法小飞”;还有基于案情的律师推荐AI等。

以上,都是科大讯飞副总裁、AI研究院副院长,北京研究院院长王士进分享的讯飞“NLP+司法”案例。

NLP的进展与挑战

前文展示了“NLP+司法”的应用,下面就NLP这项技术展开谈谈。

在本部分正式开始前,先来看一段有趣的对话吧(据说这是道外国人中文语言水平考试题):

B:没什么意思,意思意思。 A:你这样就没意思了。 B:哎呀,小意思,小意思。 A:你这人可真有意思。 B:哎呀,其实也没有别的意思。 A:那我就不好意思了。 B:是我不好意思。

请问这里的“意思”都是什么意思?(Doge)

其实,这里的“意思”二字可以看作一个符号,这个符号背后承载的信息非常丰富。

一词多义、多词一义等问题,本质上是形式和背后含义之间存在多对多的映射关系的问题,或者可以理解成在一个广阔空间内进行搜索的问题。

我们认为,怎么处理好这些关系,是自然语言处理的最核心的困难。

哈尔滨工业大学教授、人工智能研究院副院长车万翔如是说道。

但如果没有任何限制,在一个非常大的空间内进行搜索,其复杂性相当高。这个该怎么解决?

车教授介绍称,一般是用“知识”进行约束,这里打双引号的原因是:提到知识,一般会认为是某些规则、逻辑、符号知识;而这里指的是更广义的知识。

广义的知识有多种分类法,这里主要将其分为3种来源。

其一,就是狭义的知识,包括语言、常识(很难从文本中挖到)和世界知识(可以从文本中挖到),世界知识可以拿知识图谱等来表示。

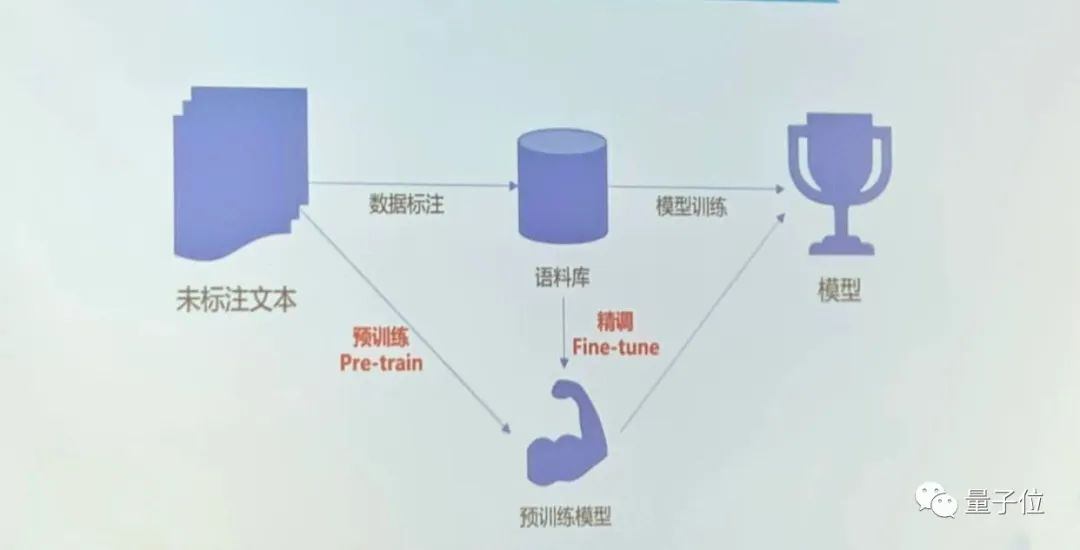

其三,是数据,包括有标注的、无标注的数据和伪数据。当下爆火的预训练模型就使用了大量的未标注数据。

首先可通过未标注数据预训练一个模型;接着用语料库去精调这个模型,从而使目标模型变得更强大。

当下普遍认为,对于几乎所有AI系统,如果没有新的知识、算法或数据输入,这个系统本身很难提高。

当然也有人提出,怎么感觉有例外——比如DeepMind的AI棋手AlphaZero,就是通过自我博弈来学习精进的。

对此,车教授解释道,这种游戏场景比较特殊,因为它本身是一个封闭的系统,能够下棋的位置毕竟有限,且还有人为制定的胜负标准,所以在条条框框之下,机器自由发挥的空间并不算特别大。

但像NLP就不一样了,哪句话说得好,哪句话说得不好,其实没有一个明确的判定标准,这种情况下,左右博弈就没有奇效了。

说到这里,现在 NLP用到了知识、算法和数据,那NLP之后还会朝哪个方向发展?或者说,NLP下一步还会用到什么?

要回答这个问题,不妨先纵观一下人工智能自1956年诞生以来的发展简史。(你就会发现一些有意思的规律)

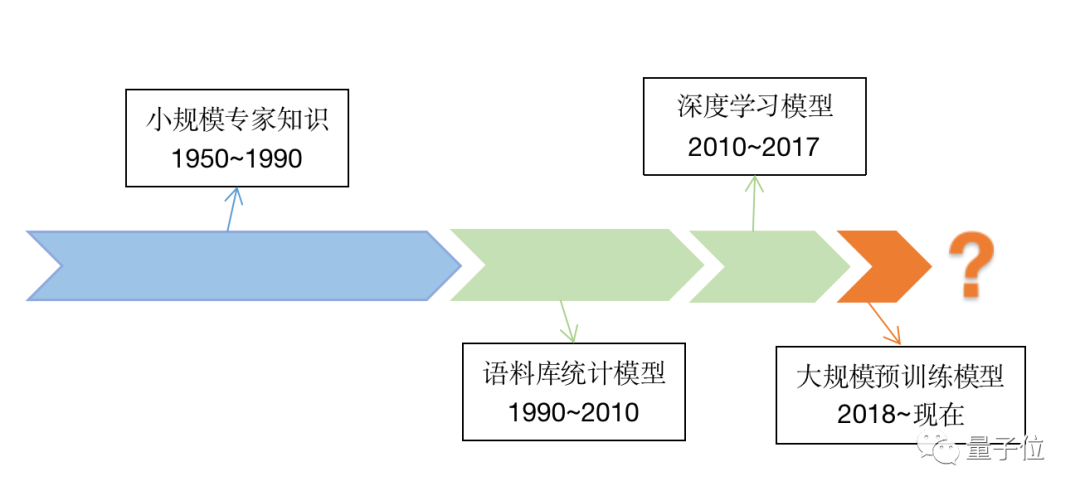

上世纪50年代至上世纪90年代期间,主要关注的是小规模专家知识;从上世纪90年代到2011年前后,更关注的是算法设计;从2010年到2017年,迎来了深度学习的热潮,数据的重要性愈发凸显。

而自2018年谷歌推出BERT至今,大规模预训练模型成了当下热词。

不难发现,此前,后一个阶段的时间几乎是前一阶段的一半,所以……(手动狗头)

说回大规模预训练模型,车教授指出,当前大模型的“同质化”趋势越来越明显,当然这可不是什么不好的事,我们可以用“通用性”来理解。

无论是 NLP 任务还是CV任务等,现在都有一套“万金油”模型:Transformer,基本可以统一解决很多问题。此外,现在模型的规模越来越大,而且模型的表现和其规模确实呈正相关。所有有观点认为,随着模型规模的增大,还可能会涌现出令人惊讶的AI。正如俗话所说:量变引起质变。

车教授表示,模型的“同质化”和“规模化”趋势是不可逆转的,未来还会继续这样走下去。

至于NLP目前遇到的问题,其实也算是人工智能发展过程中的问题,比如说易用性、高效性、鲁棒性、可解释性、推理能力等。(篇幅有限,这里就先不展开了)

车教授提出,未来可能除了数据外,还会使用更广泛的“知识”,而这种“知识”的来源可以被概括成“体验”,体验来自于人机交互等场景。

NLP相关问题更多探讨

围绕自然语言处理的机遇和挑战,几位学界和企业界的大佬展开了一场主题Panel。

大模型的工业实用前景

首先,纵观前沿科技和当今的工业界不难发现,虽然自2020年GPT-3诞生以来,大模型的参数已达千亿级别;但在工业实操中,尚未看到超大模型的广范应用。

其中一个重要的原因是,大模型的训练数据和一些工业领域的真实数据差别明显。

大模型的实用前景到底如何目前十分具有争议——有乐观者认为:未来大模型也能成为NLP 的基础模型;也有消极的观点表示:这更像各巨头集合算法算力、大数据等优势搞的一个军备竞赛而已。

现场的几位专家对大模型的实用前景都未持消极态度,不过他们的具体想法也不尽相同。

学术界这边,中国科学院自动化研究所的刘康研究员发言称:

大模型确实是个好东西,但与其把大模型看成一种资源,不如把它看成一种技术规范、一种工具。

比如,在一些小数据场景下,能够快速把已有的一些知识经验迁移到新的任务。就像人拿到一个不会用新产品时,通过阅读产品说明书,然后就很快学会使用该产品了。

清华大学副教授刘知远的研究方向之一就是大模型。他指出,一方面,在实践中发现,中文的数据质量比英文的差太多。

这不仅是规模问题,数据质量也不太行。最终效果就是,在实际训练过程中,对中文素材去完重、去完垃圾后,所剩的数据非常有限。

所以,如何为模型训练收集更多高质量的中文数据,是个重要议题,也是一件任重道远的事儿。

另一方面,刘知远教授认为,要提升大模型的实用性,下一代大模型必须具备这样的特性:

随着模型的规模的增长,其计算量要呈现一个亚线性的增长趋势,否则系统很难承受。就像我们的人脑也学习了很多东西,但在回忆具体某概念时,脑子一般不用把很多知识点都过一遍。

企业界这边,京东科技语音语义创新算法负责人、高级总监吴友政提到,当下大伙儿热议的大模型并不一定要参数量达到千亿级才算。

除了“大”之外,Transformer和自监督也是大模型的两个核心概念。更重要的是,Transformer和自监督在工业界已有广泛应用,很多企业的线上系统虽然没有千亿参数,但参数量也能达到亿级了。

当然,百亿、千亿级模型的工业应用场景,还需要漫长的探索。

举个例子,在实际应用中,可控性往往也是一个重要指标。虽然像GPT-3这样的模型在生成开放故事方面表现很好,但怎么基于现有的知识生成更加可控的文本依然值得研究。

对千亿大模型的工业应用,科大讯飞研究院执行院长刘聪干脆直言道:

对企业来说,投产比太高。(即性价比太低)

他认同“超大模型可以提高相关技术领域天花板”的观点,就像前面提到的,把它作为一种范式是OK的。

刘聪还补充道,在教育、医疗、司法等场景下(这很讯飞),模型的可解释性是至关重要的。

用大白话讲,就是要说清楚模型内部到底发生了什么,才产生出这样的结果,否则计算机通过模型给出的判定很难让人信服。

然而,现在很多千亿模型内部还处于“黑盒”状态,有些原理不仅是现在看不透,而且由于其庞大的体量和错综复杂的结构,以后也很难解释清楚。

大模型处理多模态数据的前景

除了大模型的工业应用外,大模型处理多模态数据的前景也是个有意思的议题。

大家应该知道(至少能意会到),人脑可以轻松处理多模态的数据,从中学习和解耦各种复杂信息,并且让各种模态的数据高度协同作用。

说人话,比如当俩人交谈时,除了说出来的言语,还有语气、语速、神态、肢体语言等也在传递着不同维度信息,就像有人说“好好好”可能是在真心夸赞,也可能是——

读取并处理各种信息,对咱们聪明的大脑来说一般没啥问题,但是对于计算机,是否也能轻松解决?

哈工大车万翔教授表示,这应该没有些人想象的那么困难。

前面他用“同质化”一词形容了当今各个大模型的发展趋势,再说一次,这里的“同质化”不是贬义词——

现在,文本、语音、图像都可以用Transformer这套东西来表示;反之,用Transformer能更容易地整合不同模态信息。所以,像“语音+文本+图像”这样的多模态预训练模型其实已经数不胜数了。

此外,例如DeepMind的Gato,足足在604个不同的任务上进行了训练,训练数据还包括游戏里的建模动画、模拟的机器人运用场景等。最终,这个“全才”AI不仅可以看图写话、和人类聊天,还可以把雅达利游戏玩得飞起,并且能操控机械臂。

清华刘知远教授补充道,他认为多模态模型的“模态”可以更加多样化,例如用户行为就是一种值得大模型学习的数据。

他提到OpenAI今年发布的网页版GPT(WebGPT),可以把用户通过搜索引擎来回答问题的行为序列作为Transformer的输入,并对其训练,然后模型就学到了一个新技能——根据问题去网上搜索答案。

企业界这边,科大讯飞的刘聪指出,在应用场景中有刚需的多模态模型,公司会优先投入研发。

刘聪以语音交互问题举例:虽然在常规场景下,语音交互的技术已经相当成熟了;但是在车载、鸡尾酒会等嘈杂环境中,怎么判断某人正在对A还是B,在对人还是对机器说话?

在这种复杂的交互场景下,语音和视觉信息等结合,可以显著提升模型的准确性。

在大伙儿对多模态大模型积极表态之时,刘康研究员则提出了在科研过程中遇到的一个问题:

用Transformer这个万金油来建立各个模态之间的关联,看似是个近乎完美的方案,但实际极大的依赖于背后数据之间的关系。

举个简单的例子,数据之间是对应关系还是互补关系?比如,给出一段新闻数据,里面的图片可能是上下文讲述的内容,也可能是对文字的补充(就像上面那个表情包)。

所以,刘康研究员认为,除了模态种类还需多样化外,不同模态之间的逻辑关系也是未来值得研究的方向之一。他建议,把采集的数据映射到背后的知识库上,通过知识来处理各种模态的关系。

大模型的可解释性

前文提到,模型的可解释性在一些特定场景下非常重要,而且打破砂锅问到底是一众科研人的求知态度。

所以尽管前路渺茫,许多人仍在虔诚地探索着,希望有朝一日能解释清楚超大模型运行过程中的各种原理。

不过,“深度学习大模型天然就不具有可解释性。”哈工大车万翔教授分享了他之前看到的这种观点。他提到,机器并不像人的思维那样运行。

想追求可解释性,在浅层模型上更容易找到。当然,浅层模型的精度一般比深度学习模型差远了。

车教授认为,高精度和可解释性本身就是矛盾的。所以根据具体场景和需要选择不同模型就好了。

比如,让机器给学生作文打分,总得说清楚为什么得出这个分数吧。也就是要讲明白为模型设置了多少feature,如:典故、排比、修辞方式、逻辑性等。这里浅层模型就更适用。

刘康研究员也认为,要去搞清楚深度学习模型黑盒部分的原理,宛如走进一条死胡同。

现在的研究者主要采用两种手段试图解释深度学习模型黑盒内发生了什么:

一种是观察分析输入哪些内容或获得更多权重;另一种是用可解释的浅层模型无限逼近黑盒模型,然后用浅层模型的结果来近似解释黑盒模型。

然而这两种方法本本质上也只是模拟,还是没解释黑盒模型的机制到底是怎么样的。此外还有个重大问题:即使做了解释,也几乎是不可验证的,这样就没法判断解释是否真的靠谱。

也有人对此观点持不同态度——清华刘知远教授就认为,深度学习模型还是具有可解释性的,只不过别之前的浅层模型复杂多了,需要用到更复杂的模型和机制。这些东西还需探索,但非完全不可逾越的。

从产业角看来看大模型的可解释性问题,京东吴友政和科大讯飞刘聪都表示:

要结合各行业场景的需求来分层看待可解释性,部分简单场景其实不太需要深度可解释性,而教育、医疗等用户关切过程的重大社会场景则会对可解释性提出更高的要求 。

对于那些对可解释性有特别需求之处,先弄清楚到底需要对哪些点进行“解释”,除了用大模型之外,还可以结合其他知识运用类的技术。

刘聪还补充道,人机协同也是很重要的一种方式。当机器不能独立Perfect时,那就先与人合作呗,用户的行为或许也能为模型可解释性提供一定帮助。

审核编辑 :李倩

-

深度学习

+关注

关注

73文章

5506浏览量

121258 -

自然语言处理

+关注

关注

1文章

619浏览量

13578 -

nlp

+关注

关注

1文章

489浏览量

22052

原文标题:NLP,能辅助法官判案吗?

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NLP技术在司法领域的应用

NLP技术在司法领域的应用

评论