牛津大学的一个团队从巴甫洛夫的狗中汲取灵感,设计了一个基于光子学的神经网络。

受 19 世纪初巴甫洛夫经典条件反射实验的启发,牛津大学的研究人员最近创造了一种片上光学处理器,它可能为人工智能 (AI) 和机器学习 (ML) 的前所未有的进步打开大门。

牛津声称其新系统提供了先进的数据集相似性检测。与在电子处理器和传统神经网络上运行的传统机器学习算法不同,Oxford 的系统在无反向传播的光子网络上运行,并利用了巴甫洛夫联想学习。

在巴甫洛夫的狗身上寻找灵感

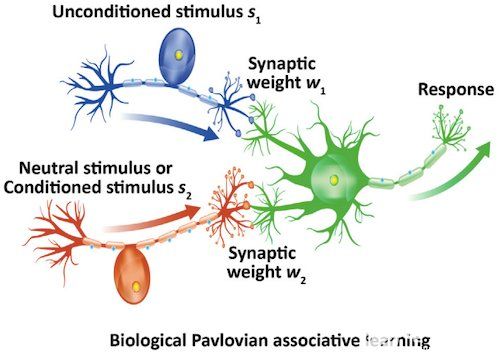

经典条件反射是关联两种感觉刺激以实现相同反应的过程。这个过程包括感觉和运动神经元。当感觉神经元接收到感觉信号时,运动神经元会产生感觉密集的动作。

Ivan Pavlov 在 1900 年代初发现了这个概念,他观察到,当他通过教狗将铃铛的声音与食物联系起来时,他可以通过按铃来诱导狗流涎。联想学习过程将刺激s 2(即铃声)与自然刺激s 1(即食物的视觉或气味)相关联,以触发狗的相同反应(即流涎)。

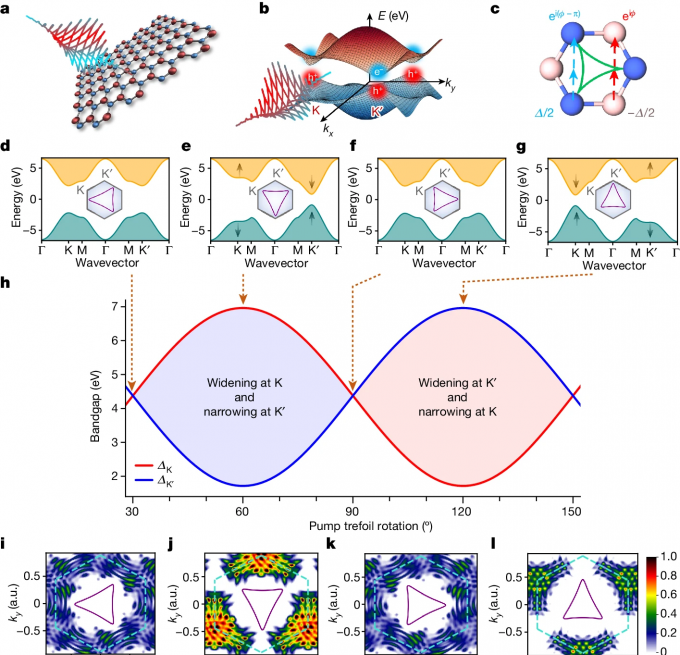

巴甫洛夫联想学习。图片由Optica和 Tan 等人提供

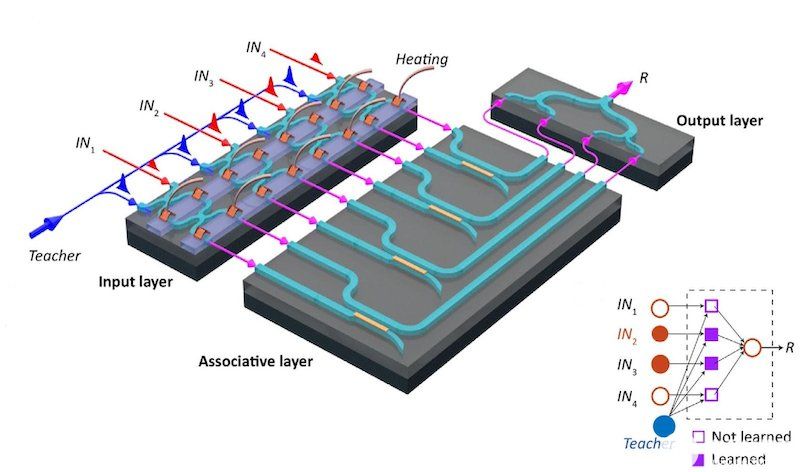

牛津大学的研究人员将这一概念应用于简化的神经回路,具有两个关键作用:1)收敛并关联两个输入;2)存储这些关联的记忆以供以后参考。这项研究的核心是一种称为联想单子学习元素(AMLE)的东西。AMLE 包括一个设备,可以有效地执行经典条件反射的基本联想学习过程,以推进 AI/ML。

关于联想一元学习元素

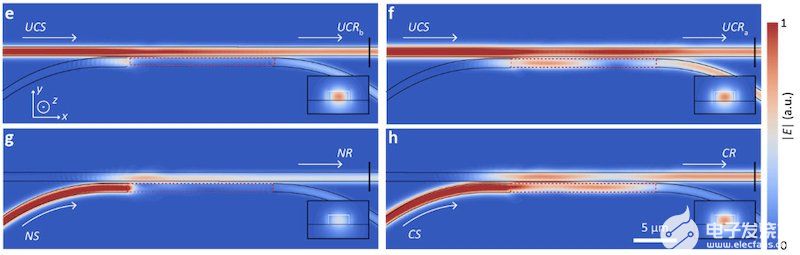

AMLE 将相变材料薄膜与两个耦合波导集成以实现联想学习。该材料(Ge 2 Sb 2 Te 5 (GST))有效地调制波导之间的耦合。GST 以两种状态存在,非晶态或晶态,影响波导之间的耦合量。

在结晶状态下,刺激s 1和s 2没有显示任何形式的关联。然而,刺激(或输入)在它们同时到达时开始关联,从而导致非晶化 GST。GST 越多异形化,刺激s 1和s 2关联的越多,导致几乎无法区分的输出,称为学习阈值。AMLE 使用光子关联学习来提供一个独特的机器学习框架,以解决一般学习任务。

AMLE学习前后的电场分布。图片由Optica和 Tan 等人提供

AMLE 消除了反向传播,提高了计算速度

传统的神经网络密集型 AI 系统在学习过程中需要大量数据集,这导致处理和计算成本增加。这些传统的神经网络利用反向传播来实现高精度的人工智能学习。

根据牛津大学的说法,AMLE 消除了反向传播的需要,使用记忆材料来学习模式并关联数据集中的相似特征。无反向传播技术可加快 AI/ML 模型训练。例如,虽然传统的基于神经网络的 AI 系统在使用多达 10,000 个兔子/非兔子图像训练其模型后识别兔子,但无反向传播技术 (AMLE) 可以通过五个兔子/非兔子图像对获得类似的结果显着降低处理和计算成本。

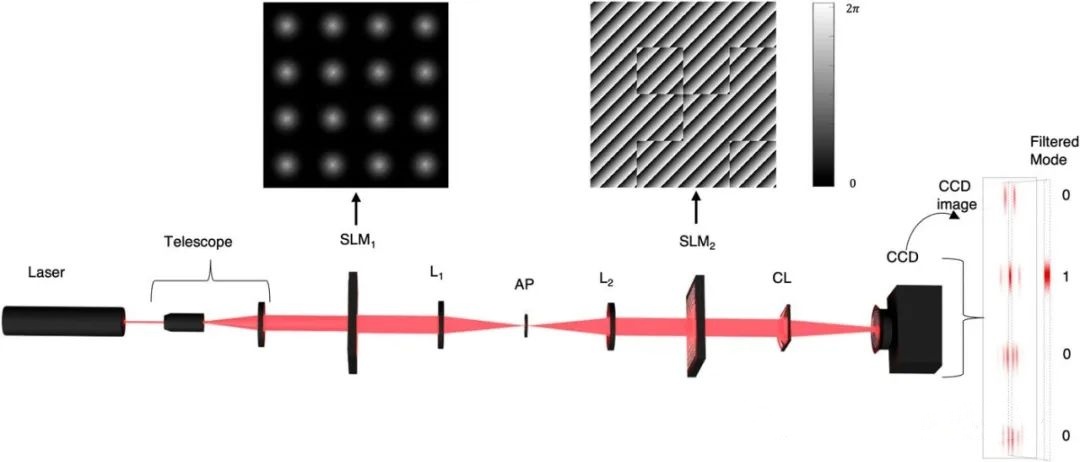

AMLE 还利用波分复用来提高计算速度。此功能允许 AMLE 在各种基于单通道的波长上发送多个光信号,从而消除反向传播。AMLE 使用光来发送和接收数据,这一过程称为并行信号处理,从而产生更高的信息密度和更快的模式识别速度。

AMLE 研究的合著者郑教授表示,虽然这种新开发的设计不能完全替代传统的神经网络,但它可以补充它们。在大量和更简单的数据集学习任务中,AMLE 设备显着加快了光学处理速度。

在光子平台上构建 AMLE

牛津大学的研究人员在光子平台上实施了 AMLE。使用该平台,该团队展示了无反向传播的单层权重人工神经网络架构的可行性和有效性。

研究人员观察到,如果输入以已经建立的光学延迟同时应用,则关联两个不同的输入可以产生相似的输出。这些输入之间的关联可以允许关联多个数据流,包括单个元素上的各种波长——特别是在没有光信号干扰的情况下。

根据牛津大学的说法,这项研究可能会为下一代机器学习算法和架构创新设定优先级。

审核编辑 黄昊宇

-

神经网络

+关注

关注

42文章

4771浏览量

100719 -

AI

+关注

关注

87文章

30746浏览量

268896

发布评论请先 登录

相关推荐

研究人员利用激光束开创量子计算新局面

嵌入式和人工智能究竟是什么关系?

《AI for Science:人工智能驱动科学创新》第6章人AI与能源科学读后感

AI for Science:人工智能驱动科学创新》第4章-AI与生命科学读后感

《AI for Science:人工智能驱动科学创新》第二章AI for Science的技术支撑学习心得

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得

risc-v在人工智能图像处理应用前景分析

人工智能ai4s试读申请

名单公布!【书籍评测活动NO.44】AI for Science:人工智能驱动科学创新

FPGA在人工智能中的应用有哪些?

研究人员利用人工智能提升超透镜相机的图像质量

研究人员利用定制光控制二维材料的量子特性

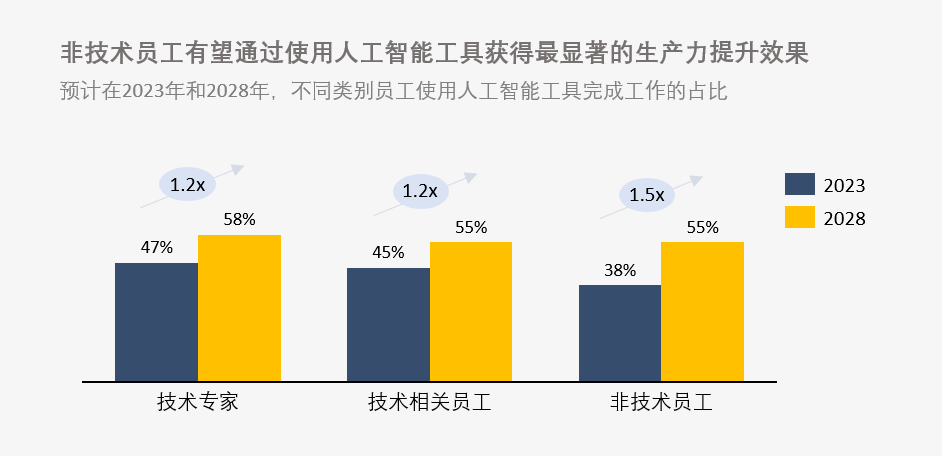

新研究表明:掌握人工智能技能的员工薪资增幅有望超过30%

受巴甫洛夫启发,研究人员利用光将经典条件反射带入人工智能

受巴甫洛夫启发,研究人员利用光将经典条件反射带入人工智能

评论