电子发烧友网报道(文/李弯弯)近日,英伟达高端GPU对中国供应受到限制的消息,引起热议。8月31日,英伟达发布公告称,美国通知公司向中国出口A100和H100芯片将需要新的许可证要求,同时DGX或任何其他包含A100或H100芯片的产品,以及未来性能高于A100的芯片都将受到新规管制。

9月1日,英伟达方面又表示已经获得出口许可。尽管如此,美国这番操作必然引起国内相关企业的警惕,接下来中国的互联网、云服务厂商可能会积极自研芯片,或者更多采用国内企业提供的算力芯片,然而目前国内的算力芯片能力如何呢?

A100和H100出口限制,对中国有何影响

英伟达是全球GPU领域的绝对龙头,A100是其2020年推出的数据中心级云端加速芯片,拥有540亿晶体管,采用台积电7nm工艺制程,支持FP16、FP32和FP64浮点运算,为人工智能、数据分析和HPC数据中心等提供算力。

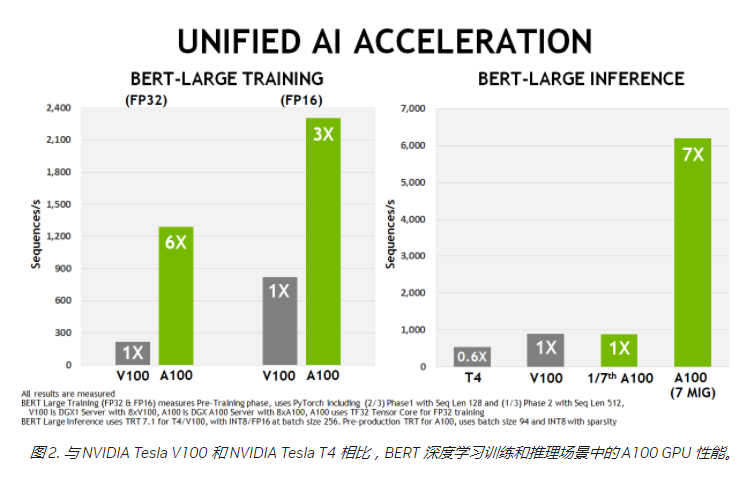

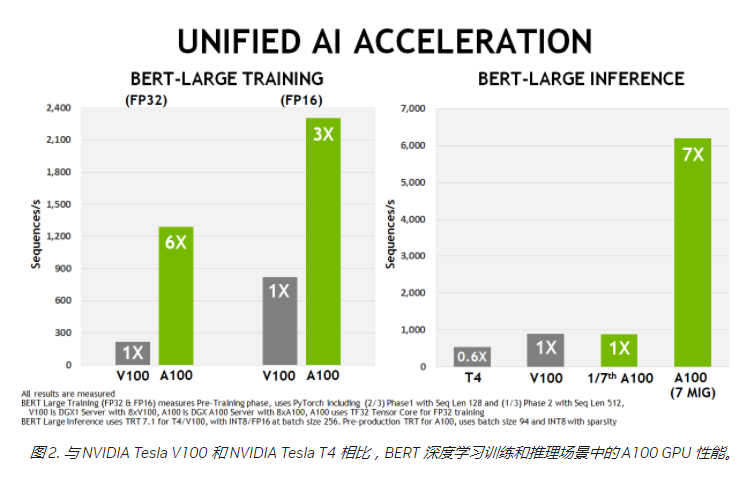

相比于上一代V100,A100在AI训练和推理、HPC上性能都有很大的改进。据英伟达在今年8月透露,特斯拉采用了7000块A100芯片升级了其用来训练自动驾驶系统的超算中心。

H100是英伟达今年3月发布的最新一代数据中心GPU,集成800亿晶体管,采用台积电定制的4nm工艺,预计在今年下半年正式发货,英伟达CEO黄仁勋此前表示,这款GPU具有超强的计算能力,20个H100 GPU便可承托相当于全球互联网的流量。相比于A100,H100在FP16、FP32和FP64计算上比A100快三倍,非常适用于当下流行且训练难度高的大模型。

如果A100和H100芯片出口受到限制,对中国有何影响?目前国内高端场景基本采用英伟达的A100,包括OEM厂商浪潮、联想等,云服务公司阿里、腾讯、百度等,对于即将量产的H100,国内主流厂商也已经预定,如阿里云、百度云和腾讯云等,而且目前国内没有能够与其相对标的硬件产品,如果限制,这些厂商在一些高端的应用上将无法买到可替代产品。

不过有行业分析师表示,如果出口限制,确实只是对一些高端厂商的应用有影响,而在更普遍的应用场景中,英伟达的产品并不在限制的范围,而且国内也有可替代的产品。

国产算力芯片如何突围

从长远来看,加速算力芯片的发展是必然的,那么国内算力芯片的能力怎样,如何突围呢?目前服务器加速,主要采用的是GPU芯片,占比接近90%,另外则是ASIC、FPGA等。

GPGPU芯片广泛用于商业计算和大数据处理,如天气预报、工业设计、基因工程、药物发现、金融工程等,在人工智能领域,使用GPGPU在云端运行模型训练算法,可以显著缩短海量训练数据的训练时长,减少能源消耗,从而进一步降低人工智能的应用成本。

不同应用领域,对芯片计算能力及运算精度要求也有所不同,比如用于商业计算和大数据处理(CAE仿真、物理化学、石油勘探、生命科学、气象环境等),需要双精度浮点、单精度浮点、32位整型运算;人工智能(模型训练、应用推理),要求混合精度浮点、半精度浮点、16位整型、8位整型运算。

近几年国内不少企业在这方面取得进展,包括海光信息、壁仞科技、燧原科技、摩尔线程等。

海光信息成立于2014年,不久前在科创板上市,海光信息的产品包括通用处理器(CPU)和协处理器(DCU),海光DCU属于GPGPU的一种。

海光DCU 8000系列,典型功耗260-350W,支持INT4、INT8、FP16、FP32、FP64运算精度,支持4个HBM2内存通道,最高内存带宽为1TB/s、最大内存容量为32GB。海光DCU协处理器全面兼容ROCm GPU计算生态,由于ROCm和CUDA在生态、编程环境等方面具有高度的相似性,CUDA用户可以以较低代价快速迁移至ROCm平台。

可以看到,海光DCU是国内唯一支持FP64双精度浮点运算的产品,英伟达的A100、H100都支持FP64,从这一点来看,海光DCU在这方面是比较领先的。

壁仞科技今年8月发布的首款通用GPU BR100,集成770亿晶体管,支持FP16半精度浮点运算,在这方面相比英伟达、海光DCU较弱,不过据该公司介绍,BR100的16位浮点算力能达到1000T以上,8位定点算力达到2000T以上,超过英伟达的A100。

另外燧原科技此前发布的第二代人工智能训练产品邃思2.0,支持从FP32、TF32、FP16、BF16 到INT8运算,单精度FP32峰值算力40 TFLOPS,单精度张量TF32峰值算力160 TFLOPS。

天数智芯的BI芯片,集成240亿晶体管,采用7纳米先进制程,支持FP32、FP16、BF16、INT8等多精度数据混合训练,单芯算力每秒147T@FP16。

另外值得关注的还有,寒武纪2021年11月发布的第三代云端AI芯片思元370,相比于上一代芯片,思元370全面加强了FP16、BF16以及FP32的浮点算力,在全新MLUarch03架构和7nm先进工艺加持下,8位定点算力最高为256TOPS。

对比来看,目前国内厂商的芯片水平,相比于英伟达的A100和H100是存在差距的。不过在国内市场需求和美国出口限制的背景下,这些芯片厂商具有足够的技术和经验积累,去实现进一步的突破。

那么国内的芯片厂商需要如何突围呢?难度肯定是大的,燧原科技创始人赵立东在日前世界人工智能大会的论坛上谈到,国际巨头用几代人、数十年的时间投入积攒下的技术实力,我们想靠两代和几十名工程师就超越,是不可能的。

要缩短差距,除了资金、人力等的高密集投入外,也需要有更快的更迭,还有就是架构创新,赵立东认为,唯有架构实现原始创新,才能真正拥抱开放生态,使产业得到健康发展。

另外与国外芯片执着于先进的制程,国内不少厂商开始通过更先进的封装工艺、异构芯片等来寻求突破。比如寒武纪思元370采用chiplet技术,在一颗芯片中封装2颗AI计算芯粒(MLU-Die),每一个 MLU-Die 具备独立的AI计算单元、内存、IO以及 MLU-Fabric控制和接口,通过MLU-Fabric保证两个MLU-Die间的高速通讯,可以通过不同MLU-Die组合规格多样化的产品,为用户提供适用不同场景的高性价比AI芯片,壁仞科技今年8月发布的GPU BR100GPU芯片也采用了Chiplet技术。

小结

整体而言,美国限制英伟达高端GPU芯片A100和H100的出口,短期来看对中国的影响不是很大,反而对于国内算力芯片的发展或许具有促进作用。

从目前国内芯片厂商的产品来看,与英伟达A100和H100存在差距,不过也有海光信息、壁仞科技等在某些方面已经取得突破的企业,未来想要超越仍然存在困难,然而却让人相信一点点取得突破是有可能的。

9月1日,英伟达方面又表示已经获得出口许可。尽管如此,美国这番操作必然引起国内相关企业的警惕,接下来中国的互联网、云服务厂商可能会积极自研芯片,或者更多采用国内企业提供的算力芯片,然而目前国内的算力芯片能力如何呢?

A100和H100出口限制,对中国有何影响

英伟达是全球GPU领域的绝对龙头,A100是其2020年推出的数据中心级云端加速芯片,拥有540亿晶体管,采用台积电7nm工艺制程,支持FP16、FP32和FP64浮点运算,为人工智能、数据分析和HPC数据中心等提供算力。

相比于上一代V100,A100在AI训练和推理、HPC上性能都有很大的改进。据英伟达在今年8月透露,特斯拉采用了7000块A100芯片升级了其用来训练自动驾驶系统的超算中心。

H100是英伟达今年3月发布的最新一代数据中心GPU,集成800亿晶体管,采用台积电定制的4nm工艺,预计在今年下半年正式发货,英伟达CEO黄仁勋此前表示,这款GPU具有超强的计算能力,20个H100 GPU便可承托相当于全球互联网的流量。相比于A100,H100在FP16、FP32和FP64计算上比A100快三倍,非常适用于当下流行且训练难度高的大模型。

如果A100和H100芯片出口受到限制,对中国有何影响?目前国内高端场景基本采用英伟达的A100,包括OEM厂商浪潮、联想等,云服务公司阿里、腾讯、百度等,对于即将量产的H100,国内主流厂商也已经预定,如阿里云、百度云和腾讯云等,而且目前国内没有能够与其相对标的硬件产品,如果限制,这些厂商在一些高端的应用上将无法买到可替代产品。

不过有行业分析师表示,如果出口限制,确实只是对一些高端厂商的应用有影响,而在更普遍的应用场景中,英伟达的产品并不在限制的范围,而且国内也有可替代的产品。

国产算力芯片如何突围

从长远来看,加速算力芯片的发展是必然的,那么国内算力芯片的能力怎样,如何突围呢?目前服务器加速,主要采用的是GPU芯片,占比接近90%,另外则是ASIC、FPGA等。

GPGPU芯片广泛用于商业计算和大数据处理,如天气预报、工业设计、基因工程、药物发现、金融工程等,在人工智能领域,使用GPGPU在云端运行模型训练算法,可以显著缩短海量训练数据的训练时长,减少能源消耗,从而进一步降低人工智能的应用成本。

不同应用领域,对芯片计算能力及运算精度要求也有所不同,比如用于商业计算和大数据处理(CAE仿真、物理化学、石油勘探、生命科学、气象环境等),需要双精度浮点、单精度浮点、32位整型运算;人工智能(模型训练、应用推理),要求混合精度浮点、半精度浮点、16位整型、8位整型运算。

近几年国内不少企业在这方面取得进展,包括海光信息、壁仞科技、燧原科技、摩尔线程等。

海光信息成立于2014年,不久前在科创板上市,海光信息的产品包括通用处理器(CPU)和协处理器(DCU),海光DCU属于GPGPU的一种。

海光DCU 8000系列,典型功耗260-350W,支持INT4、INT8、FP16、FP32、FP64运算精度,支持4个HBM2内存通道,最高内存带宽为1TB/s、最大内存容量为32GB。海光DCU协处理器全面兼容ROCm GPU计算生态,由于ROCm和CUDA在生态、编程环境等方面具有高度的相似性,CUDA用户可以以较低代价快速迁移至ROCm平台。

可以看到,海光DCU是国内唯一支持FP64双精度浮点运算的产品,英伟达的A100、H100都支持FP64,从这一点来看,海光DCU在这方面是比较领先的。

壁仞科技今年8月发布的首款通用GPU BR100,集成770亿晶体管,支持FP16半精度浮点运算,在这方面相比英伟达、海光DCU较弱,不过据该公司介绍,BR100的16位浮点算力能达到1000T以上,8位定点算力达到2000T以上,超过英伟达的A100。

另外燧原科技此前发布的第二代人工智能训练产品邃思2.0,支持从FP32、TF32、FP16、BF16 到INT8运算,单精度FP32峰值算力40 TFLOPS,单精度张量TF32峰值算力160 TFLOPS。

天数智芯的BI芯片,集成240亿晶体管,采用7纳米先进制程,支持FP32、FP16、BF16、INT8等多精度数据混合训练,单芯算力每秒147T@FP16。

另外值得关注的还有,寒武纪2021年11月发布的第三代云端AI芯片思元370,相比于上一代芯片,思元370全面加强了FP16、BF16以及FP32的浮点算力,在全新MLUarch03架构和7nm先进工艺加持下,8位定点算力最高为256TOPS。

对比来看,目前国内厂商的芯片水平,相比于英伟达的A100和H100是存在差距的。不过在国内市场需求和美国出口限制的背景下,这些芯片厂商具有足够的技术和经验积累,去实现进一步的突破。

那么国内的芯片厂商需要如何突围呢?难度肯定是大的,燧原科技创始人赵立东在日前世界人工智能大会的论坛上谈到,国际巨头用几代人、数十年的时间投入积攒下的技术实力,我们想靠两代和几十名工程师就超越,是不可能的。

要缩短差距,除了资金、人力等的高密集投入外,也需要有更快的更迭,还有就是架构创新,赵立东认为,唯有架构实现原始创新,才能真正拥抱开放生态,使产业得到健康发展。

另外与国外芯片执着于先进的制程,国内不少厂商开始通过更先进的封装工艺、异构芯片等来寻求突破。比如寒武纪思元370采用chiplet技术,在一颗芯片中封装2颗AI计算芯粒(MLU-Die),每一个 MLU-Die 具备独立的AI计算单元、内存、IO以及 MLU-Fabric控制和接口,通过MLU-Fabric保证两个MLU-Die间的高速通讯,可以通过不同MLU-Die组合规格多样化的产品,为用户提供适用不同场景的高性价比AI芯片,壁仞科技今年8月发布的GPU BR100GPU芯片也采用了Chiplet技术。

小结

整体而言,美国限制英伟达高端GPU芯片A100和H100的出口,短期来看对中国的影响不是很大,反而对于国内算力芯片的发展或许具有促进作用。

从目前国内芯片厂商的产品来看,与英伟达A100和H100存在差距,不过也有海光信息、壁仞科技等在某些方面已经取得突破的企业,未来想要超越仍然存在困难,然而却让人相信一点点取得突破是有可能的。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

芯片

+关注

关注

455文章

50712浏览量

423105 -

gpu

+关注

关注

28文章

4729浏览量

128885

发布评论请先 登录

相关推荐

《算力芯片 高性能 CPUGPUNPU 微架构分析》第3篇阅读心得:GPU革命:从图形引擎到AI加速器的蜕变

在数据挖掘工作中,我经常需要处理海量数据的深度学习任务,这让我对GPU架构和张量运算充满好奇。阅读《算力芯片》第7-9章,让我对这些关键技术有了全新认识。

发表于 11-24 17:12

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】--了解算力芯片GPU

着色器(Pixel shader)是图形流水线中算力相当强大的功能单元,因为它可以为每个片段执行复杂的计算,从而为最终渲染的图像添加细节和视觉效果。

DirectX API推动 GPU 演进

发表于 11-03 12:55

存算一体架构创新助力国产大算力AI芯片腾飞

在湾芯展SEMiBAY2024《AI芯片与高性能计算(HPC)应用论坛》上,亿铸科技高级副总裁徐芳发表了题为《存算一体架构创新助力国产大算力

GPU算力租用平台是什么

GPU算力租用平台是一种基于云计算的服务模式,它允许用户通过互联网按需租用高性能GPU资源,而无需自行购买、部署和维护这些硬件。

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】--全书概览

、GPU、NPU,给我们剖析了算力芯片的微架构。书中有对芯片方案商处理器的讲解,理论联系实际,使读者能更好理解

发表于 10-15 22:08

名单公布!【书籍评测活动NO.43】 算力芯片 | 高性能 CPU/GPU/NPU 微架构分析

这个想法被否决了,因为投入较大、难以落地,且客户对算力的认同远不及今天这种高度。

这几年间其实我们联系甚少,但是作者一直没有脱离对芯片的应用和关注。特别是目睹GPU从消费电子转向

发表于 09-02 10:09

算力服务器为什么选择GPU

随着人工智能技术的快速普及,算力需求日益增长。智算中心的服务器作为支撑大规模数据处理和计算的核心设备,其性能优化显得尤为关键。而GPU服务器也进入了大众的视野,成为高性能计算的首选。那

青云科技联手摩尔线程,构建国产算力繁荣生态

随着大数据模型与各行业深度整合,以GPU为代表的智能算力需求持续攀升。同时,政府出台多项扶持政策,积极推行“人工智能+”战略,激励AI芯片行业创新发展,以更好地赋能各行各业。

Sora算力需求引发业界对集结国内AI企业算力的探讨

据周鸿祎观察,Sora视频分析所需算力恐远超千亿规模模型。因而,考虑到如今国内芯片供应受限,算力问题至关重要。事实上,Meta已有约50万台

高端GPU芯片拉警报,国产算力芯片能力如何?

高端GPU芯片拉警报,国产算力芯片能力如何?

评论