一、“光计算”背景

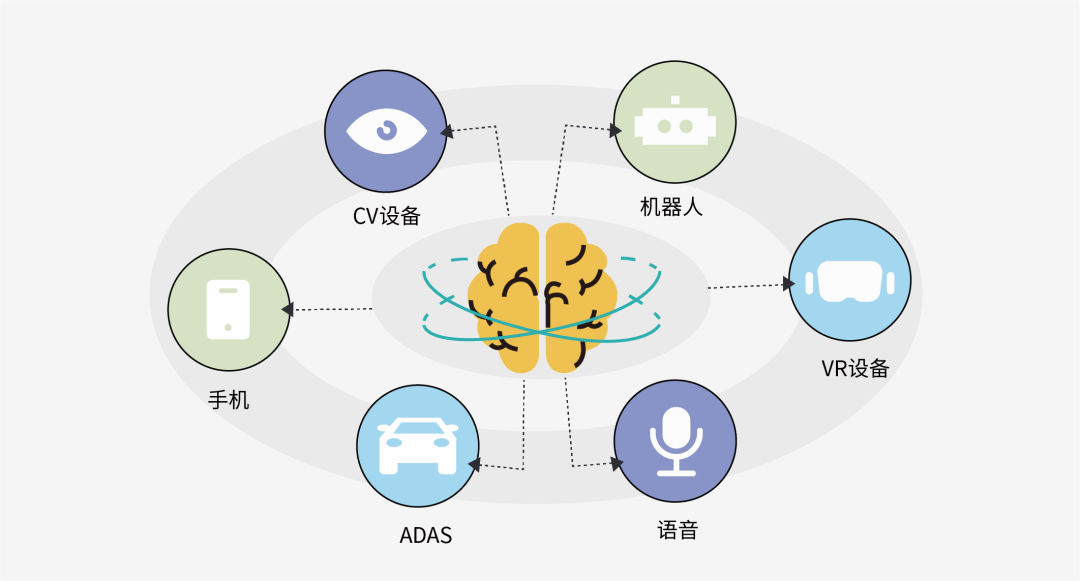

现如今,“大数据”(Big Data)时代提供了海量的数据,人工智能(artificial intelligence,AI)在自动驾驶,智能教育,语音识别等领域中的应用越来越广泛。人工神经网络(Artificial Neural Network,ANN)算法相关的机器学习(Machine Learning,ML)技术,作为AI领域中重要的计算模型,为AI的发展提供了动力,推动人类社会进入智能化时代。

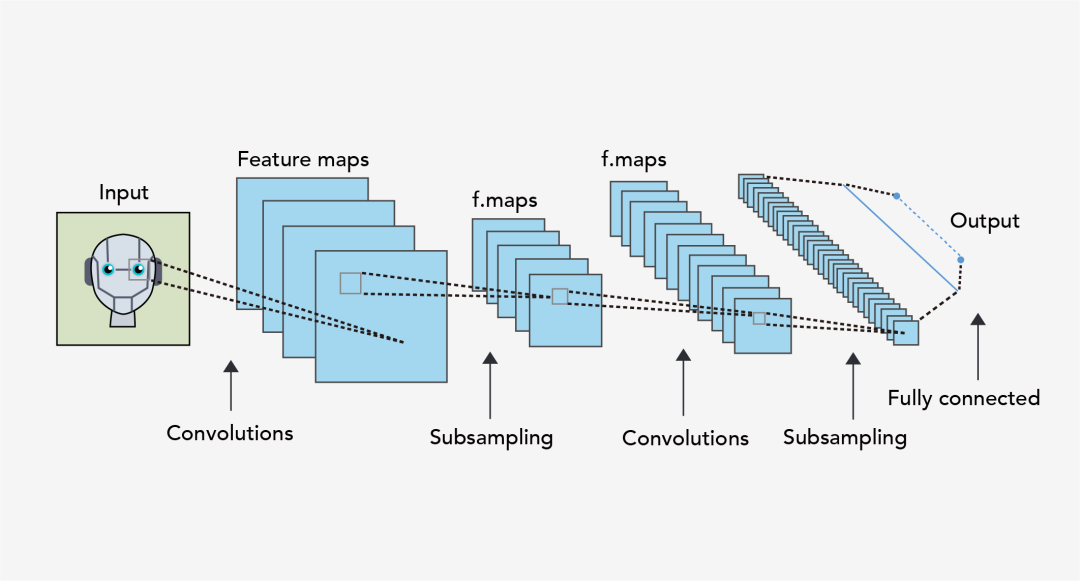

但人工神经网络强烈依赖于矩阵乘法,其训练和推理过程本质上是对矩阵参数进行调制、优化后与外界传输的数据进行数学乘法。但在目前,随着神经网络的规模不断扩大(深度学习模型的规模每3.5个月就翻一番),训练量也不断增大,需要更密集的矩阵计算,因而对算力的需求正在以惊人的速度增长。

图1 人工智能应用场景

图2 神经网络架构示意图

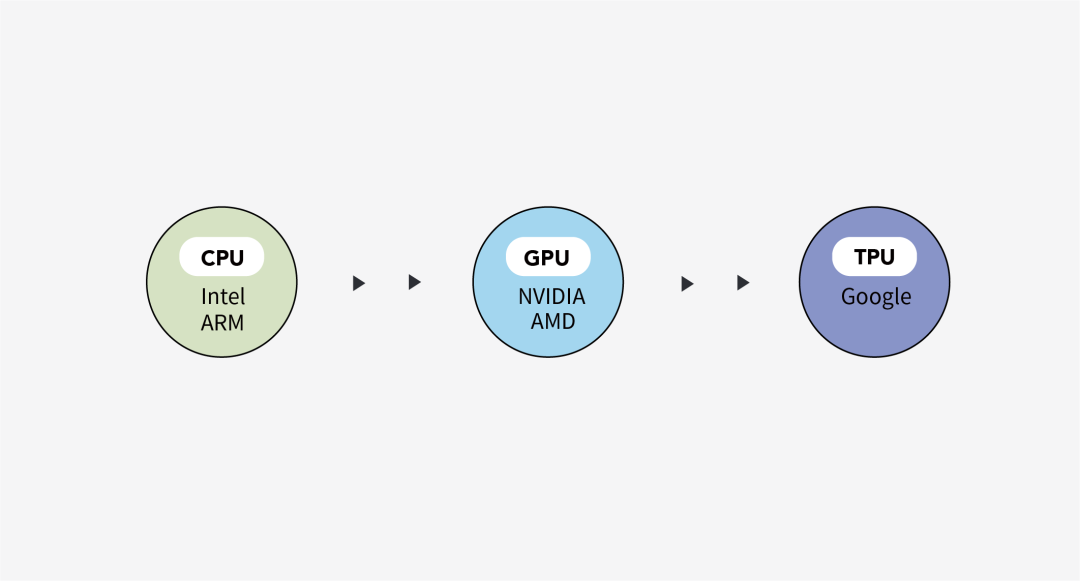

而现阶段应用于神经网络的商用硬件主要包括两类:一类是通用芯片,如中央处理器(CentralProcessing Unit,CPU)、图形处理单元(GraphicProcessing Unit, GPU)等;另一类是一些神经网络加速器如张量处理单元(TensorProcessing Unit, TPU)和可编程门阵列(FieldProgrammable Gate Array, FPGA)等。

最初,普遍采用通用芯片(CPU)进行矩阵运算,然而随着需要计算的数据量的不断增长,由于CPU算术逻辑单元(Arithmeticand Logic Unit,ALU)的面积较小,并且CPU自身的逻辑运算和控制电路也较为复杂,因而导致CPU已无法支撑大数据量带来的大量重复性的矩阵乘法运算。因而主流硬件厂商开始将注意力转向GPU:GPU采用的是流处理的方式,利用空间并行性,可以大大提高运算速度。

但随着GPU的不断迭代,其运算速度已经进入了万亿次每秒(Teraflop)的范围,也已接近其理论极限。为了进一步提高硬件的算力,各大厂商开始了对神经网络加速器的研究。2016年,谷歌推出了TPU,采用了片上内存以及脉动阵列设计,可在8位低精度下进行整数运算,相比于GPU具有更高的计算速度和更低的能耗。此外,在2017年,Intel也推出了面向数据中心的FPGA加速产品,可根据本身需求进行编程。

图3 典型的商用硬件

但是,上述这些架构全部基于传统的微电子芯片,随着工艺技术向工艺尺寸的极限逼近,芯片的集成度不断增加,“摩尔定律”将不再适用,即很难通过提升集成度提升芯片性能。另外,由于目前的电子计算硬件采用的处理器的逻辑单元和存储单元是分立的冯·诺依曼(VonNeumann)结构,这种结构存在冯·诺依曼“瓶颈”(vonNeumann bottleneck),即:当算力达到一定量级时,访问存储单元的速度远远小于逻辑单元处理数据的速度,即使采用多核并行架构也无法突破速度的极限。

二、“电”向“光”的转变

为了突破电子芯片的一系列弊端,相关研究者们开始考虑从“电”向“光”的转化,利用光子(photon)作为硬件的载体,用光计算去代替传统电子计算中的计算密集型操作,从而提高算力,降低能耗。

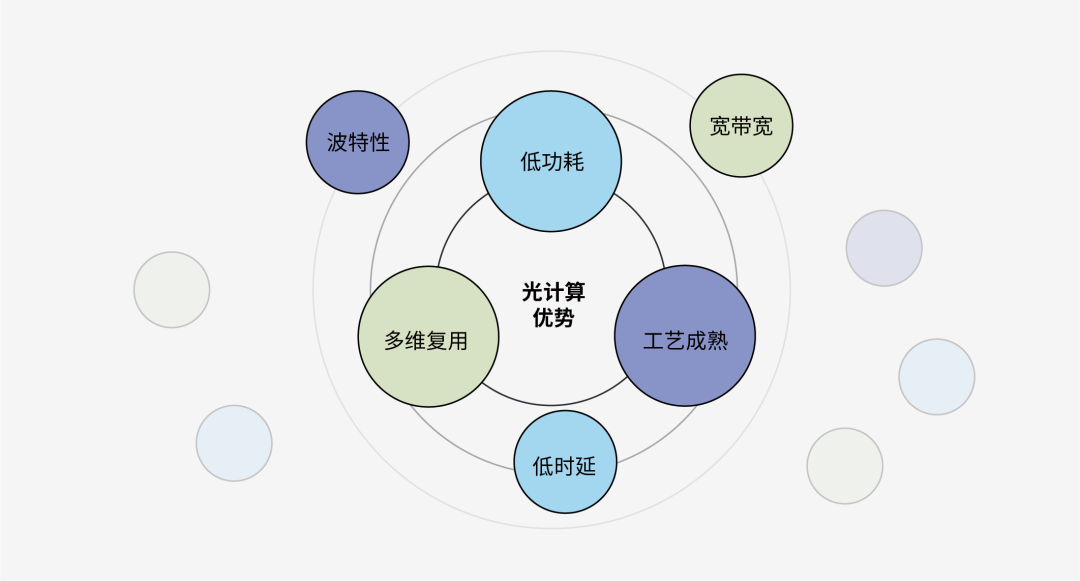

光可以来做载体主要是因为其有以下优势:首先,光子是玻色子,其物理特性决定了其不易被扰动;而电子是费米子,容易被扰动。其次,光信号具有高速率的特点,可以保证足够高的计算速度,几乎没有延迟。此外,光波可以通过时间、空间、波长、偏振、模式进行复用,提供天然的并行计算能力。最后,光学器件(尤其是无源器件),几乎不消耗任何能量,解决了困扰高性能计算的能耗问题。

图4 光计算的主要优势

三、全光 VS 光电混合

目前,根据神经元内信号的物理表现,光作为硬件的载体的方式可分为两大类:光-电-光(光电混合)与全光。

全光的方式即依赖于许多材料中出现的半导体载流子或光敏性,不涉及将神经元信号表表示为电流的过程。例如,德国明斯特大学Feldmann 在2019年提出了一种包含140个相变微环光开关的神经网络结构,可实现简单的英文字母识别。但从目前来看,相变材料自身通常有一定的使用寿命限制,从而导致该硬件难以长期工作;并且相变材料通常对应的响应速度也较慢,难以实现足够高的计算速度;除此之外,利用光敏性的实现也存在着一系列问题。总的来说,由于光学元件的精度要求大,进行逻辑运算成本也高,在处理信号的方面没有电信号来得方便,这些限制了全光运算的发展,导致全光难以取代电成为计算硬件的主流。

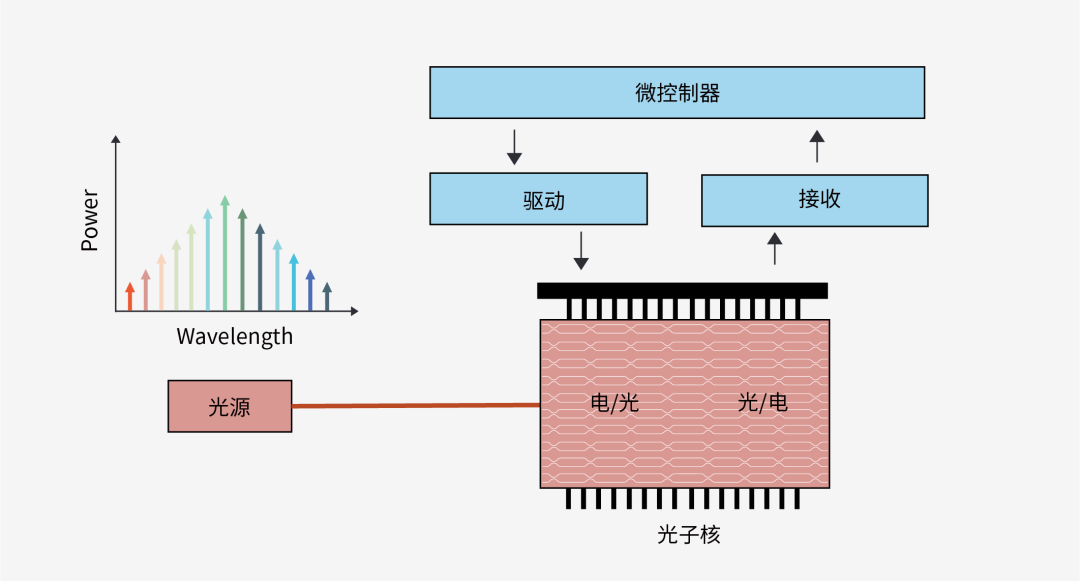

图5 光电混合计算示意图

而光电混合计算更像是取光和电两者所长的结果。举例来说,一个具体的实现方式是保持输入数据仍然是数字信号,首先用数模转换器转成模拟电信号去驱动光芯片上的光调制器,矩阵计算则是用光信号完成,之后的非线性运算则需把光信号再转回到数字信号进行。事实上,虽然这样的来回光电信号切换增加了功耗,但对于光芯片内的距离来说,光损耗几乎可以忽略不计。因此,光连接中不存在像电连接中与每个连接长度成正比的能量成本,而是预先耗费从电领域转换到光领域再返回的能量成本,因而只要E/O/E转换的成本低于在相同距离上给金属线充电的成本,光电混合计算就能在效率上击败电计算。综上所述,现阶段的商用硬件,光电混合计算仍是最佳选择。

图6 光子核架构示意图

四、硅基光电子计算

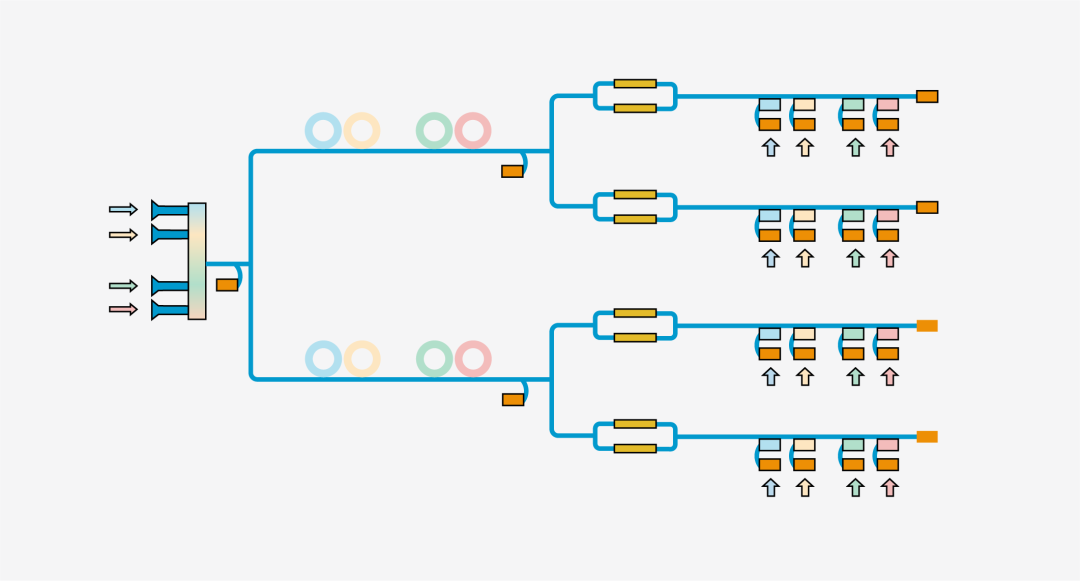

而要具体实现光电混合计算,首先要考虑光芯片的平台。传统光电子芯片主要基于InP等三五族平台,而大部分微电子器件基于硅的平台,如果要把这些不同材料平台的器件集成到一起往往是非常困难的。因此,相关研究者们再次将目光投向了在微电子领域并取得了成功——具有一系列优势的硅材料:首先,硅材料的地表储存量十分巨大,其材料成本十分低廉;其次,硅材料的折射率较大(约为3.5左右),可以获得更小的弯曲半径以实现结构非常紧凑的集成光学器件;此外,硅材料的机械性能、耐高温能力非常好,便于各种加工和封装。最后,最重要的是相比于传统的三五族器件,集成度更好,并且与互补金属氧化物半导体(COMS)工艺兼容。

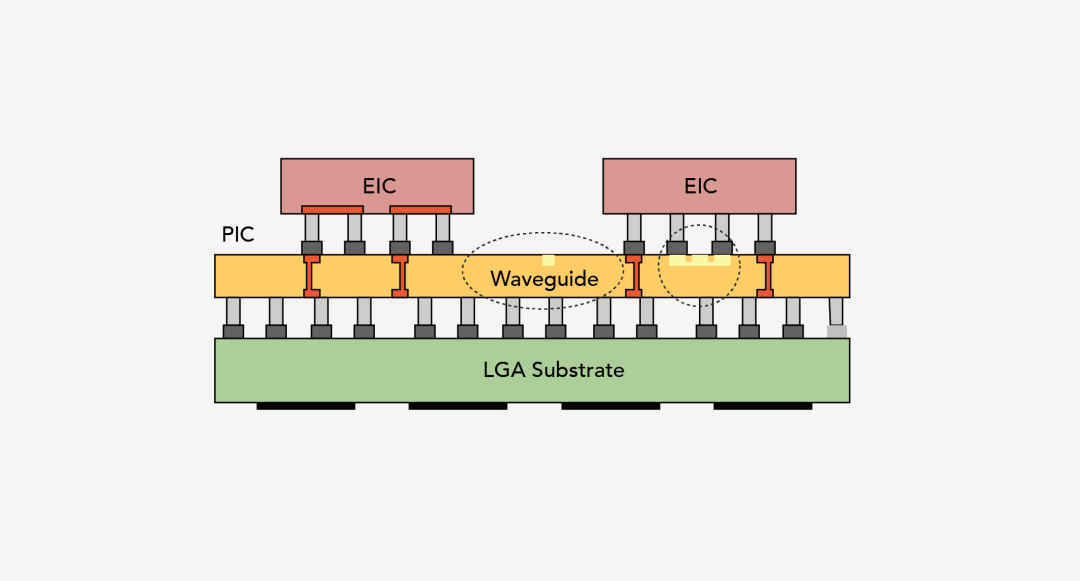

目前,硅基光电子技术不断发展。国内外众多高校和企业都在研究硅基光子学,并在技术优势和现实需求的推动下,许多高性能的光学关键器件:波导(Waveguide)、光耦合器(Coupler)、偏振分束器、模式转换器、高速电光调制器、滤波器(Filter)、锗探测器、光开关均有报道,其中大部分部件的性能已经达到甚至超过同期商业化的产品,为商用光电混合计算的实现提供了先决条件,进而将由电芯片和硅光芯片通过2.5D或3D封装堆叠组成光电混合计算的硬件推向市场。

图7 硅基光电计算封装示意图

总结来说,硅基光电混合技术既利用了光技术的优点,同时又可以结合电领域的技术进行数据处理,最终实现在提升计算速度的同时也可以降低运行功耗。而在未来的发展过程中,硅基光电子混合集成芯片一定会为人工智能领域以及计算硬件带来重大的产业升级。

-

神经网络

+关注

关注

42文章

4765浏览量

100605 -

硬件

+关注

关注

11文章

3273浏览量

66144 -

人工智能

+关注

关注

1791文章

46927浏览量

237783

原文标题:“曦”科技|计算范畴下硅光的优势

文章出处:【微信号:曦智科技,微信公众号:曦智科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

深度评测:云计算平台的优势和不足

光伏逆变器负载的功能和优势

NPU在边缘计算中的优势

华迅光通AI计算加速800G光模块部署

云服务器主要应用行业及优势

云计算的优势与应用

国产光耦合器的应用优势

国产光耦合器的应用和优势浅析

探索达林顿光耦在光伏储能领域的创新应用与优势

硅光芯片与传统芯片的区别

边缘计算网关的优势有哪些?

光隔离探头相对差分探头的优势

40G多模光模块QSFP-40G-SR4优势及应用领域介绍

光计算的主要优势

光计算的主要优势

评论