在软件和硅中复制人脑是人工智能(AI)研究的长期目标。虽然神经形态芯片在能够同时运行多个计算方面取得了重大进展,并且既能计算也能存储数据,但它们还远未达到模拟大脑的能源效率。

人工智能计算是非常耗能的,但所消耗的能量大部分不是计算本身。能量密集型部分是在AI芯片内的内存和计算单元之间移动数据。为了解决这个问题,一组研究人员开发了一种新的内存计算(CIM)芯片原型,消除了这种分离的需要。他们在8月17日发表在《自然》杂志上的论文中声称,其原型展示了现有人工智能平台效率的两倍。之所以称为NeuRRAM,是因为它使用一种称为电阻式随机存取存储器(RRAM)的RAM,这种48核RRAM-CIM硬件支持多种神经网络模型和架构。

该论文的第一作者、斯坦福大学研究员Weier Wan表示,与传统内存相比,RRAM有很多优点。其中之一是在同一硅片区域内具有更高的容量,从而可以实现更大的AI模型。它也是非易失性的,意味着没有电源泄漏。他补充说,这使得基于RRAM的芯片成为边缘工作负载的理想选择。研究人员设想,NeuRRAM芯片可以在低功耗的边缘设备上有效地处理一系列复杂的人工智能应用,而不依赖于与云的网络连接。

为了设计NeuRRAM,团队必须权衡效率、多功能性和准确性,而不牺牲其中任何一项。Wan说:“主要创新是我们使用了一种新型的模数转换方案,因为这被认为是CIM芯片能源效率的主要瓶颈。我们发明了一种新的方案,它是基于感应电压,而以前的方案是基于感应电流。电压模式感应还允许在单个计算周期内提高RRAM阵列的并行性。”

他们还探索了一些新的体系结构,如可转置神经突触阵列(TNSA),以灵活地控制数据流方向。Wan解释道:“为了精确性,关键是算法和硬件协同设计。这基本上允许我们直接在这些AI模型中建模硬件特征。”这反过来又允许算法适应硬件非理想性并保持精确性。换言之,Wan总结道,他们优化了整个堆栈,从设备到电路,从架构到算法,设计出一款高效、通用、准确的芯片。

加州大学圣地亚哥分校研究员Gert Cauwenberghs是这篇论文的合著者之一,他说:“内存计算的大多数进展都局限于软件级的演示,基本上是使用一系列突触。但在这里,我们将其放在堆栈的水平层。”

NeuRRAM在手写数字识别任务中实现了99%的准确率,在图像分类任务中达到了85.7%,在谷歌语音命令识别任务中达到84.7%,在图像恢复任务中,图像重建错误减少了70%。研究人员总结道:“这些结果可以与现有的数字芯片相媲美,这些数字芯片在相同的比特精度下进行计算,但可以大幅节省能源。”

将NeuRRAM与Intel的Loihi 2神经形态芯片(800万神经元Pohoiki Beach系统的组成部分)进行比较,研究人员表示,他们的芯片具有更好的效率和密度。圣母大学(University of Notre Dame)另一位合著者兼研究员Siddharth Joshi补充道:“基本上,Loihi是一个标准的数字处理器,带有SRAM库和特定的可编程ISA(指令集)架构。它们使用了一种更为von Neumann–ish式的架构,而我们的计算是在位线本身上进行的。”

最近的研究还认为,包括Loihi在内的神经形态芯片可能具有比AI更广泛的应用范围,包括医疗和经济分析,以及量子计算需求。NeuRRAM的制造商同意这一观点,认为内存计算架构是未来的发展方向。Cauwenberghs补充道,NeuRRAM的可扩展性在架构方面表现得很好,“因为我们有这个并行的核心阵列,每个核心独立进行计算,这就是我们如何实现具有任意连接的大型网络的方法。”

研究人员表示,现在考虑商业化还为时过早。虽然他们认为芯片的高效硬件实现与内存计算是一个成功的组合,但广泛采用仍将取决于降低能效基准。

“我们正在继续努力整合学习规则,”Cauwenberghs报告说,“这样未来的版本将能够通过RRAM技术的进步进行循环学习,从而实现大规模的增量学习或产品学习。”Wan还补充道,为了实现商业化,RRAM技术必须更容易为芯片设计者所用。

-

芯片

+关注

关注

455文章

50692浏览量

423029 -

人工智能

+关注

关注

1791文章

47155浏览量

238136 -

RRAM

+关注

关注

0文章

28浏览量

21346

原文标题:新型AI芯片 其能效或是替代品的两倍

文章出处:【微信号:IEEE_China,微信公众号:IEEE电气电子工程师】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

安世半导体将举行理想二极管与负载开关线上研讨会

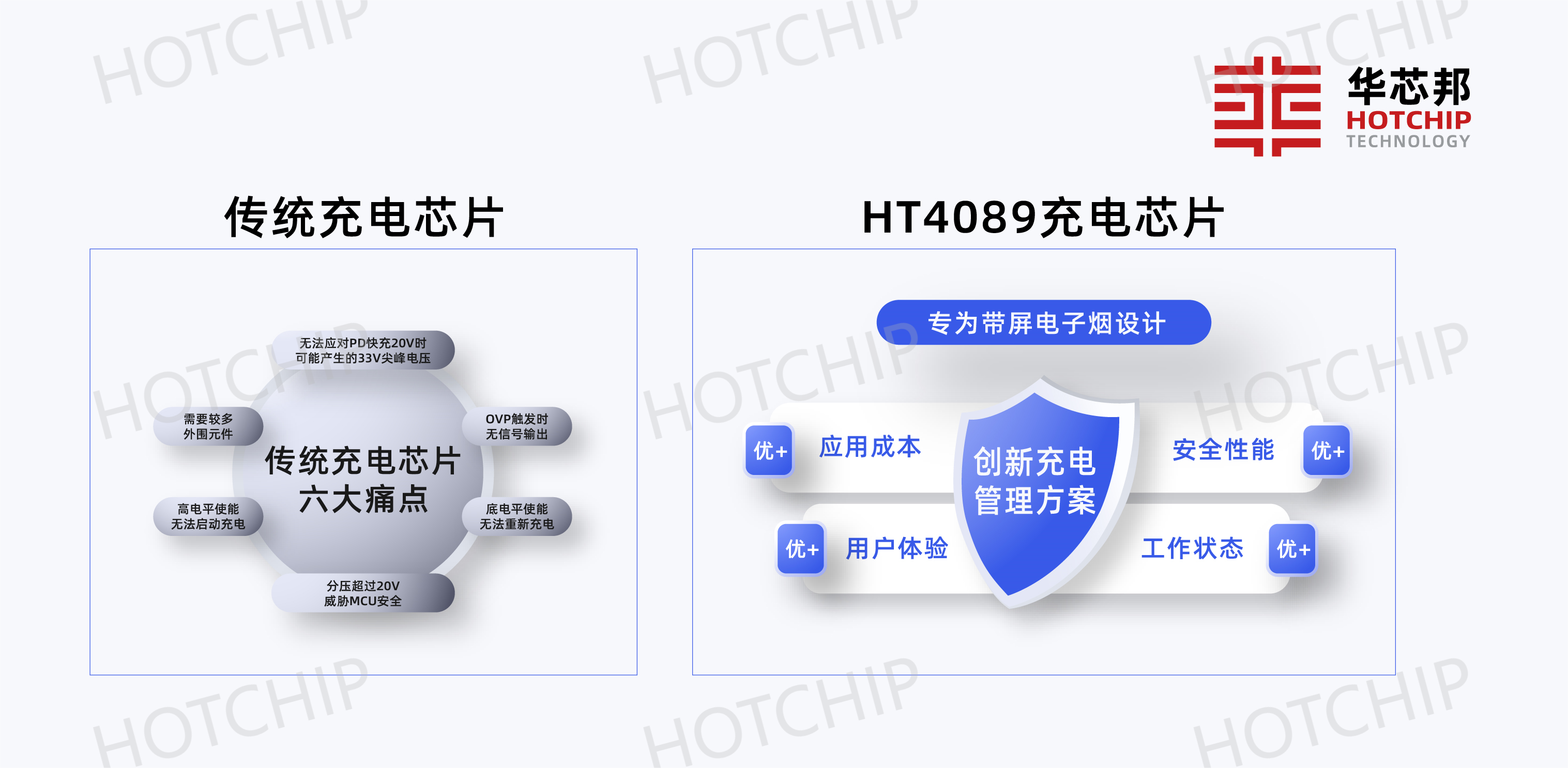

HT4089应用带屏电子雾化器成为电子烟优化锂电池充电管理核心芯片IC理想选择

如何选择适合的buck电路芯片

Orin芯片与边缘计算结合

负载开关芯片-负载开关电路芯片

ARMxy ARM物联网边缘计算网关支持Node-RED用于云边端一体化

天拓四方:边缘计算网关的选择策略

如何选择合适的边缘ai分析一体机解决方案

RRAM的芯片成为边缘工作负载的理想选择

RRAM的芯片成为边缘工作负载的理想选择

评论