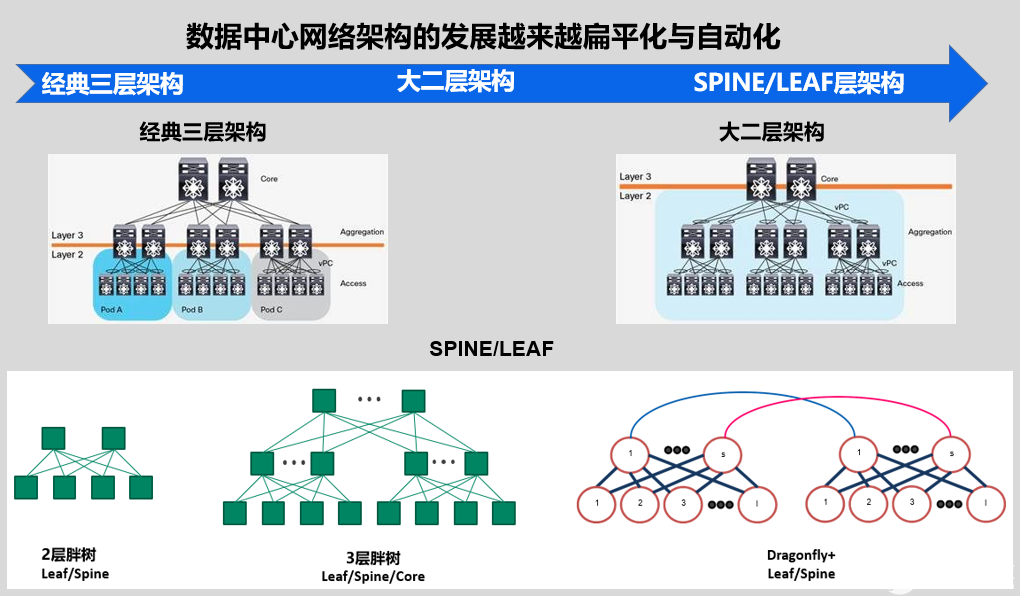

随着5G、云计算、AI等技术的不断演进,SDN与NFV或者其他虚拟化网络技术在数据中心进行应用。数据中心经历了从经典三层架构、大二层网络架构、再到Spine/Leaf的叶脊架构,数据中心网络架构的发展越来越扁平化与自动化。

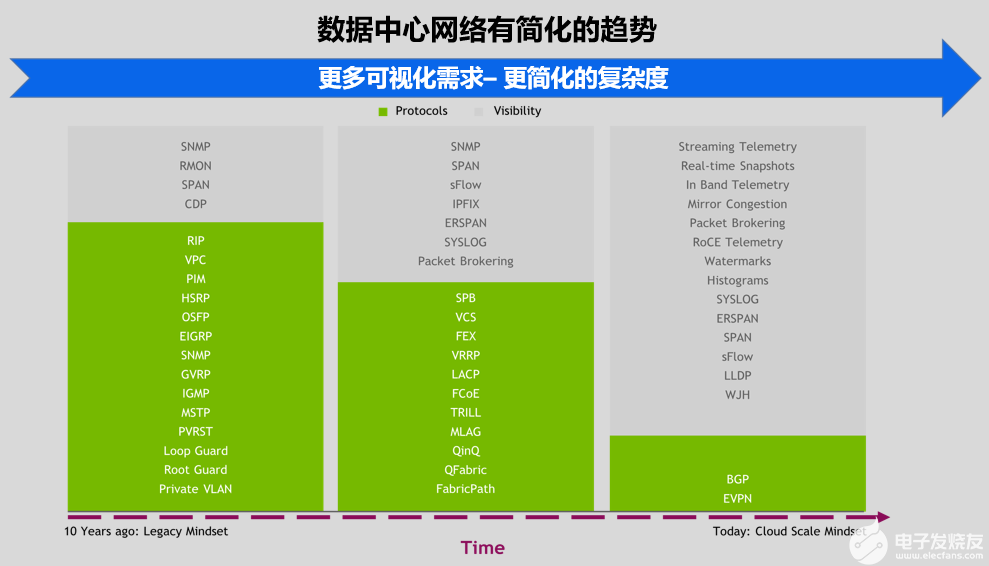

另外,数据中心有简化的趋势,数据中心网络新设计正在从2层转向3层。当前最先进的数据中心只是运行BGP、EVPN和BFD协议来进行快速的故障转移。

数据中心越先进,运行的协议就越少,配置文件就越短。然而,这种简化趋势主要是需要更多的可见性,因为聪明的人想要看到他们的网络内部发生了什么。随着网络变得越来越大、越来越快,精明的IT管理人员正在使用更少的协议,但目标是更多的遥测和监控技术,以实现更好的可见性。

面对数据中心的网络结构的发展变化,纳多德在已有大量项目方案的实际经验基础上,介绍五种新方法,来帮助用户优化企业的数据中心网络架构:

用VXLAN替换VLAN

使用ARP抑制来减少广播流

用EVPN Multihoming替换MLAG

使用ECMP和UCMP 处理流量平衡

利用自适应路由解决流量极化问题

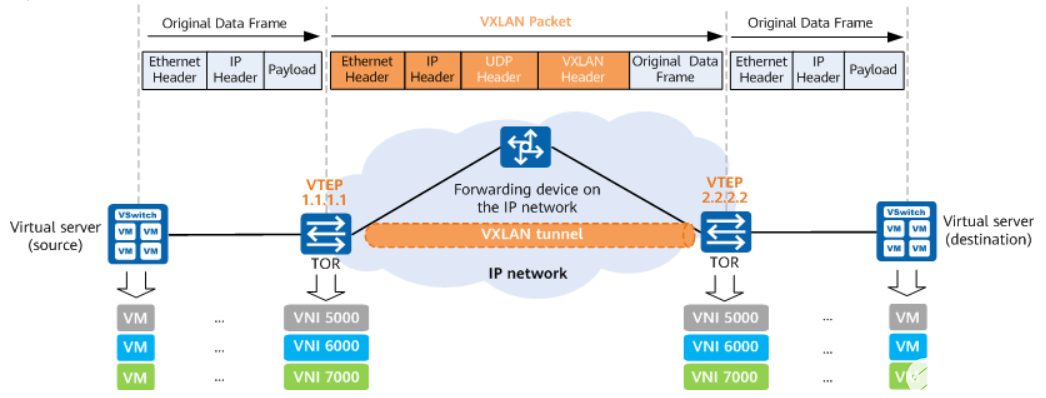

1.用VXLAN替换VLAN

VXLAN(Virtual eXtensible Local Area Network,虚拟扩展局域网)是由IETF定义的NVO3(Network Virtualization over Layer 3)标准技术之一,采用L2 over L4(MAC-in-UDP)的报文封装模式,将二层报文用三层协议进行封装,可实现二层网络在三层范围内进行扩展,同时满足数据中心大二层虚拟迁移和多租户的需求。

传统2层网络具有以下缺点:

它依赖生成树协议(STP),导致带宽利用率、冗余和多路径的能力受到生成树功能的限制。

它只能在一个子网内运行,当使用MLAG时 ,冗余通常仅限于两个设备。

任何路径级冗余都需要链路聚合控制协议(LACP),这是端口的标准冗余技术。

如上图所示,VXLAN克服了传统2层网络的缺陷,允许网络管理者在3层路由结构上进行优化。用户仍然可以实现2层网络的覆盖,但由于使用EVPN作为控制平面,因此不再需要生成树来进行控制平面收敛。EVPN通过BGP地址簇来交换MAC信息,而不是低效的广播泛洪和学习。此外,VXLAN使用24位ID ,可定义多达1600万个虚拟网络,而VLAN只有12位ID,仅限于4094个虚拟网络。总之,VXLAN通过MAC-in-UDP的报文封装,实现了二层报文在三层网络上的透传,在云端上架起了一道道无形的“彩虹”,解决了云计算中虚拟化带来的一系列问题。

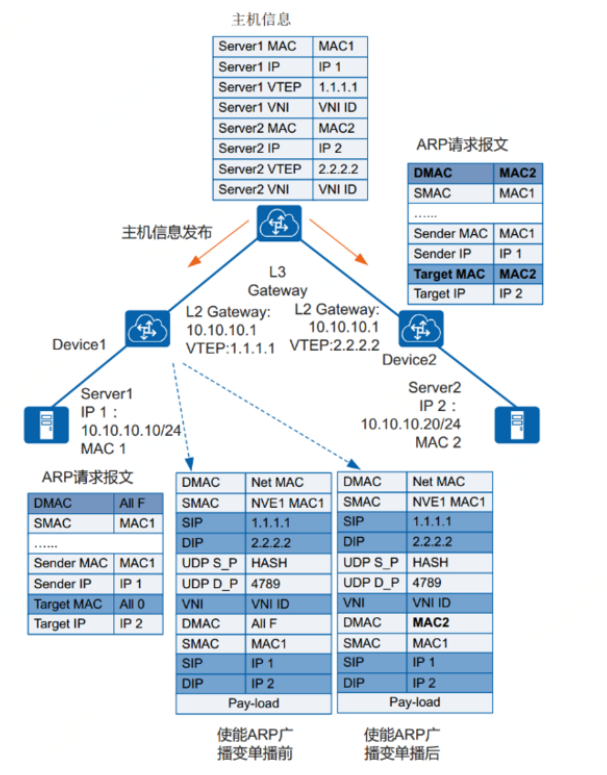

2. 使用ARP抑制来减少广播传播

在部署VXLAN的数据中心中BUM报文可以通过ARP抑制进一步优化。通常是在EVPN中使用头端复制的方式(具体体现是在桥中添加mac地址为全0的FDB表项进行头端复制)来进行实现。当有很多的ARP广播请求报文的时候,容易造成广播泛滥。采用ARP抑制可以有效限制广播ARP报文的数量。

如上图所示,VXLAN三层网关通过动态学习终端租户的ARP表项,再根据ARP表项生成主机信息(包括主机IP地址、 MAC地址、 VTEP地址和VNI ID),并将主机信息通过MP-BGP或BGP EVPN对外发布,使其他的BGP邻居可以学习到主机信息。因此部署ARP抑制可以优化覆盖网络控制平面的,获得更快的地址解析速度。它还减少了网络中的广播流量,因为ARP抑制减少了向VXLAN基础设施中的每个VTEP发送ARP请求的需要。

3. 用 EVPN Multihoming(EVPN-MH(EVPN多宿主))替换MLAG

在某些场景中,VXLAN环境中仍然需要MLAG来实现冗余多宿主机的连接。EVPN-MH是一个摆脱现有专用MLAG解决方案的机会,它提供双活服务器冗余支持,因为专用MLAG解决方案的扩展范围不超过一个设备冗余级别。

EVPNMultihoming特点

无需在TOR交换机之间建立Peerlink链路或交换机间链路

允许两个以上TOR交换机成为一个冗余组

提供单个BGP-EVPN 控制平面

允许多供应商互操作性

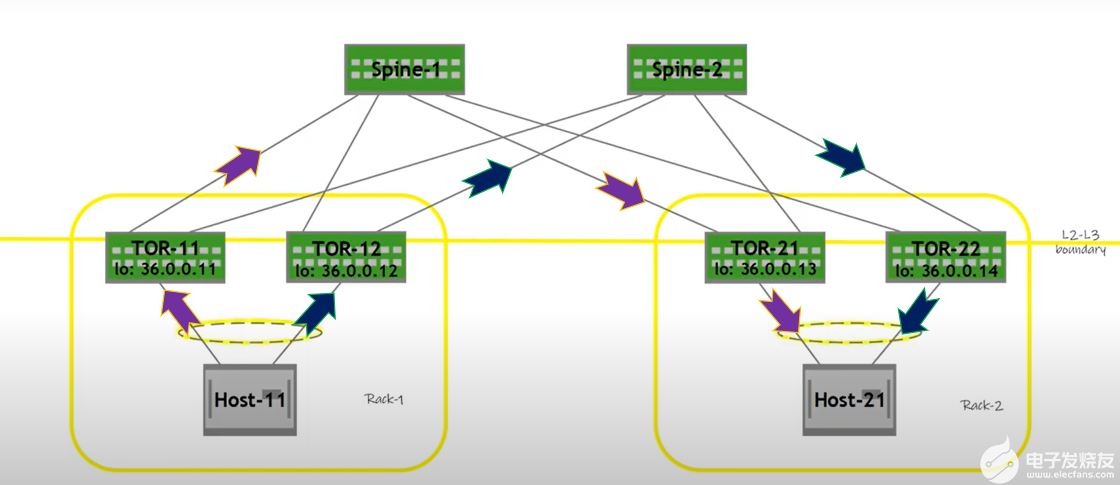

如上图所示,VXLAN有助于消除MLAG所需的背靠LEAF到SPINE交换机连接的需要。EVPN-MH进一步消除了Server到TOR交换机连接中对MLAG的任何需要。

Multihoming 使用EVPN消息与宿主机进行通信,并使用主机连接信息动态构建与服务器的2层邻接关系。当MLAG需要LAG ID时,Multihoming使用以太网段ID。接口映射到用于作为与同一终端主机逻辑连接的以太网段(Ethernet Segment)。

此外,通过在交换机中使用标准协议构造冗余,转向使用EVPN-MH可以提高网络供应商的互操作性。由于EVPN底层使用开放标准协议BGP ,任何通过RFC规范实现EVPN-MH的供应商都可以成为以太网段的一部分。

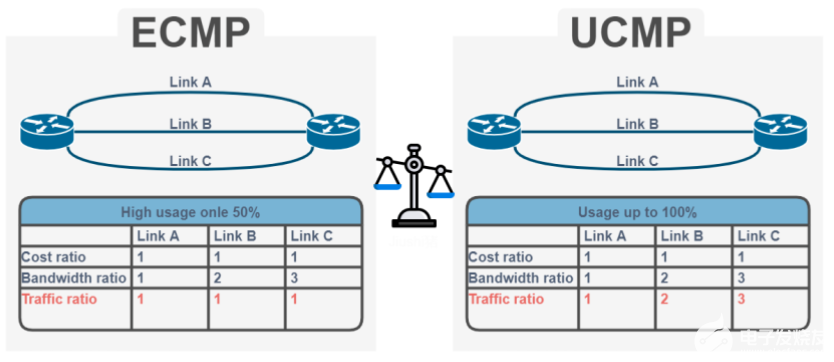

4. ECMP和UCMP处理流量平衡

ECMP(等价多路径路由)即存在多条到达同一个目的地址的相等开销的路径。它是大多数3层路由协议中的标准功能,在这些协议中,在所有可用的下一跳上行链路中实现平衡的等价路由。2层控制平面技术(如:生成树)仅允许通过依赖外部技术(如:LACP)实现同等价负载分担。

ECMP是3层路由中的原生功能,它使您能够提高网络设备的效率。

在某些情况下,ECMP可能会导致转发效率低下,特别是在部署全面的3层解决方案时,在网络中的任何位置都使用点对点L3链路,甚至到主机。在这种情况下,您可能希望在使用链路数量以外的指标来平衡流量。UCMP(非平衡链路负载均衡)在这里很有用,因为它使用BGP标记创建跨跃点的流量分布,以便更好地与应用程序分布相匹配。UCMP区别于传统ECMP,其最大特点是利用权重值来区别对待带宽的使用,使得两条不同带宽的出口,可根据带宽大小不同来承担不同的数据流量传输.

5. 通过自适应路由解决流量极化问题

自适应路由是现有InfiniBand技术在以太网交换上的实现。自适应路由监控链路带宽、链路利用率、交换机缓冲区和ECN/PFC ,将转发到ECMP组的流量选择拥塞程度最低的端口进行传输,拥塞程度基于出口队列负载进行评估,确保 ECMP组在不考虑“熵”级别的情况下保持良好平衡。

“熵”是一种衡量流经既定网络的流量的丰富性和多样性的方法。

例如:当您有数千个从全球各地的客户端随机连接的流时,您的网络被称为有high entropy(高熵)。然而,当您只有少数大型流时(这在 AI 和存储工作负载中经常发生),大型流会控制带宽,因此会出现 low entropy(低熵)。这种低熵流量模式也称为“大象流”分布,在许多数据中心工作负载中都很明显。

当使用静态 ECMP 的传统技术,您需要“高熵”来将流量均匀地分布在多个链路上,而不会出现拥塞。然而,在“大象流”场景中,多个流可能出现在同一条链路上,从而创建一个超过线路带宽的流量热点或微突发。这会导致拥塞、延迟增加、数据包丢失和重传。对于许多应用程序,性能不仅取决于网络的平均带宽,还取决于流完成时间的分布。完成时间分布中的长尾或异常值可能会显著降低应用程序性能。

因此,通过自适应路由技术利用其灵活的网络拓扑适应性,对于 CLOS(或叶/脊椎)等典型拓扑,到既定目标的各种路径间距相同时,交换机通常拥塞最小的端口传输数据包。当在路径间距不同的其他拓扑中,交换机倾向于通过最短路径发送流量。如果拥塞发生在最短路径上,则选择拥塞最小的备选路径。这确保了网络带宽得到有效利用。自适应路由的目标是将网络管理员从手动调整干预中解放出来,让基础网络处理聚合流负载均衡的优化工作。

以上我们介绍了数据中心网络中可用的优化方案。这些优化有助于减少基础设施上不必要的控制流量,并且可平衡现有物理链路上的流量,充分利用所有可用链路带宽。

纳多德NADDOD利用自有光连接件与NVIDIA的网络硬软件产品资源和技术优势,可为客户提供更丰富、更灵活、更优质的产品技术解决方案,为用户业务赋能。纳多德NADDOD光网络整体解决方案如下图所示:

面对数据中心的网络结构的发展变化,纳多德NADDOD作为NVIDIA网络产品Elite Partner,实现光连接+NVIDIA 网络产品与解决方案强强联合,充分发挥双方产品技术、市场覆盖与生态优势,在技术领先竞争力与产品整体方案丰富度上优势互补,为数据中心、高性能计算、边缘计算、人工智能等应用场景提供更具优势与价值的光连接产品和整体解决方案,大幅提高客户业务加速能力。

审核编辑:汤梓红

-

数据中心

+关注

关注

16文章

4855浏览量

72341 -

网络结构

+关注

关注

0文章

48浏览量

11175 -

5G

+关注

关注

1356文章

48503浏览量

565718

发布评论请先 登录

相关推荐

NIDA发布《智算数据中心网络建设技术要求》

Meta AI数据中心网络用了哪家的芯片

诺基亚扩展与微软Azure的数据中心网络供应协议

数据中心布线标准有什么

华为星河AI产品及解决方案覆盖全面,涵盖园区、广域、数据中心及网络领域

华为联合IEEE面向全球发布L4数据中心自动驾驶网络白皮书

HNS 2024:星河AI数据中心网络,赋AI时代新动能

港灯打造了面向未来的下一代电力数据中心网络

CloudFabric3.0超融合数据中心网络全新升级,携手共筑算力新联接

锐捷网络携数据中心、以太全光等创新解决方案亮相2024MWC

是德科技推出AI数据中心测试平台旨在加速AI/ML网络验证和优化的创新

借助光连接与网络产品利器,实现数据中心网络优化

借助光连接与网络产品利器,实现数据中心网络优化

评论