电子发烧友网报道(文/周凯扬)在AI和大数据时代到来之后,GPU单兵作战就变成了奢望,以现在的数据中心和超算为例,动辄就是成千上万张GPU,庞大的GPU网络在交换机和光模块的支持下代表了这个计算时代下最高的算力。但并非只有数据中心和超算里的GPU才需要这样的扩展性,嵌入式GPU和专业GPU同样如此。

物理限制的嵌入式GPU随着各种传感器的性能持续走高,譬如多线激光雷达、高分辨率的图像传感器等,我们对边缘计算单元尤其是GPU的需求也在持续增加。但在实现的过程中,我们还有一些物理限制没法消除,像是尺寸、重量和功耗等。

为了解决这一系列问题,美国政府和行业方案提供商们成立了SOSA联盟,以求开发开放的标准和最好的方案来实现高性价比、互操作性强的传感器系统。如何克服这些负载计算工作量提升带来的挑战,又能不增加宝贵的物理资源呢?答案自然还是将GPU、DPU等技术集成到嵌入式结构中去。

这类嵌入式GPU并非用来单独售卖,而是交给合作伙伴整合到不同的边缘计算系统中,比如研华、凌华、EIZO、Mercury Systems等,然后交付给美国空军、洛克希德·马丁这类军事、航空、工业客户。

即便选择了嵌入式结构,也还有着不少的路线,比如GPU、FPGA和ASIC等等。SOSA联盟主席,来自美国空军的Ilya Lipkin表示,如果想要更快的运行速度,快速部署软件,自然是选择GPU最好。但他们也面临着空间的问题,因为嵌入式GPU往往会被塞到3U或者6U的服务器里,他们想要做到更小的体积,甚至是手掌大小,可这样一来就不得不牺牲带宽、容量。

所以,虽然嵌入式GPU仍然在这些嵌入式传感系统中可以保持领先地位,但他们并没有像获得数据中心那样不算严格的空间要求。目前的MXM嵌入式GPU可以做到PCIe GPU五分之一的尺寸,但这对于嵌入式GPU的扩展性来说还不算完美。在边缘计算上,反倒是一些FPGA和ASIC方案在能耗比和扩展性上占优,如果嵌入式GPU不能做到更强大的扩展性,很有可能会被后来者颠覆。

显卡交火时代的结束不管是最新发布的RTX4090消费级显卡,还是RTX 6000这样的专业显卡,都象征了英伟达在新架构GPU上的又一次创新。在台积电4N工艺的加持下,无论是晶体管数目还是CUDA核心都做到了极致。

然而,原本变成了专属英伟达高端消费显卡和专业显卡的交火技术NVLink,在RTX4090和RTX 6000上却无处可寻,难不成英伟达彻底放弃显卡交火技术,也就此放弃NVLink了?根据英伟达CEO黄仁勋的说法,他们省下了NVLink连接器的空间,释放了更多的空间来处理更多的AI计算。

在上一代显卡的NVLink中,通过连接两块英伟达显卡,使用高端显卡和专业显卡的专业系统能够获得更高的带宽和双倍的显存容量。这样的提升对于个人或专业用户来说是极大的提升,那么为何英伟达会放弃NVLink呢?笔者也在英伟达GTC的一次分享会议上提出了这一问题。

英伟达方面表示,就RTX 6000这类专业显卡而言,他们取消NVLink后省下了足够的空间,塞入了更多的计算单元来提升单卡的性能。与此同时,虽然这些专业显卡的NVLink支持被取消,不代表英伟达放弃了这一技术。英伟达决心将NVLink的重心放在数据中心产品上,比如Grace CPU、Hopper GPU,他们通过NVLink Die to Die和Chip to Chip的互联可以实现更好的扩展性。

但这确实象征着一个时代的结束,过去AMD的交火和英伟达的SLI也是两家竞争最火热的一项技术,可随着AMD放弃了交火支持,英伟达的SLI在换成NVLink后如今也迎来了终结。

但显卡交火的落幕也情有可原,且不说这种互联方式的受众群体一再变少,要想享受到显卡交火的性能也需要软件追加更新支持。或许专业显卡的目标还是追求单卡性能就好,多卡互联的支持还是让给数据中心吧。

-

传感器

+关注

关注

2554文章

51593浏览量

757870 -

gpu

+关注

关注

28文章

4810浏览量

129613 -

显卡

+关注

关注

16文章

2473浏览量

68387 -

AI

+关注

关注

87文章

32082浏览量

270970

原文标题:GPU在不同形态下的扩展性问题

文章出处:【微信号:elecfans,微信公众号:电子发烧友网】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

GPU加速计算平台的优势

GPU云计算服务怎么样

2024年GPU出货量增长显著,超越CPU

借助NVIDIA GPU提升鲁班系统CAE软件计算效率

《CST Studio Suite 2024 GPU加速计算指南》

深度学习工作负载中GPU与LPU的主要差异

基于FPA的软件工作量综合评估研究与实践

降压转换器电容器集成可减少满足CISPR 25 5类标准所需的工作量

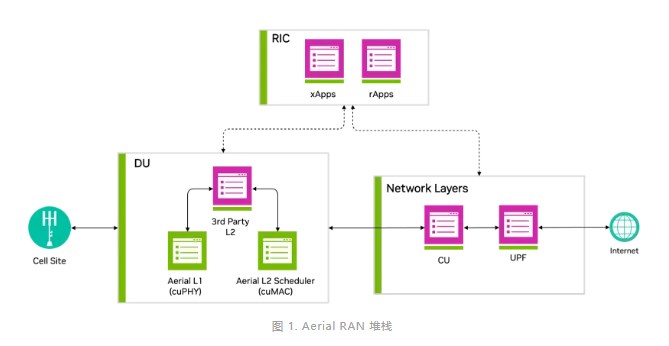

借助NVIDIA Aerial CUDA增强5G/6G的DU性能和工作负载整合

大模型时代,国产GPU面临哪些挑战

GPU如何克服负载计算工作量提升带来的挑战

GPU如何克服负载计算工作量提升带来的挑战

评论