自动语音识别( ASR )研究通常侧重于高资源语言,如英语,它由数十万小时的语音支持。最近的文献重新关注更复杂的语言,如日语。与其他亚洲语言一样,日语有大量的基本字符集(普通白话中使用了 3000 多个独特的字符),并提出了独特的挑战,例如多个词序。

这篇文章讨论了最近提高日语 ASR 准确性和速度的工作。首先,我们改进了 Conformer ,这是一种最先进的 ASR 神经网络架构,在训练和推理速度方面取得了显著的改进,并且没有精度损失。其次,我们增强了一个具有多头部自我注意机制的纯深度卷积网络,以丰富输入语音波形的全局上下文表示的学习。

语音识别中的深度稀疏整合器

Conformer 是一种神经网络体系结构,广泛应用于多种语言的 ASR 系统中,并取得了较高的精度。然而, Conformer 在训练和推断方面都相对较慢,因为它使用了多头自我注意,对于输入音频波的长度,其时间/内存复杂度为 quadratic 。

这妨碍了它对长音频序列的高效处理,因为在训练和推断过程中需要相对较高的内存占用。这些激励了稀疏 关注高效 Conformer 构建。此外,由于注意力较少,内存成本相对较低,我们能够构建一个更深的网络,可以处理由大规模语音数据集提供的长序列。

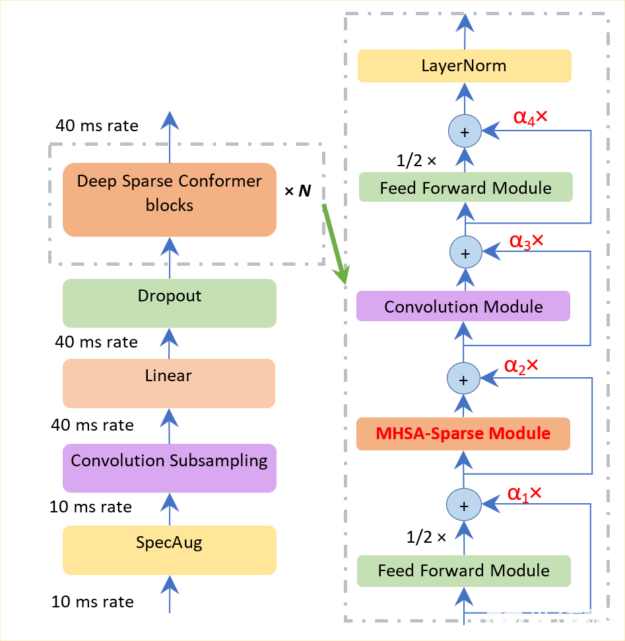

图 1.深度稀疏 Conformer 的编码器模型架构

如图 1 所示,我们在两个方向上改进了 Conformer 长序列表示能力:稀疏和深入。我们使用一个排名标准,只选择一小部分占主导地位的查询,而不是整个查询集,以节省计算注意力得分的时间。

在执行剩余连接时,使用深度规范化策略,以确保百级 Conformer 块的训练。该策略包括使用一个函数来贴现编码器和解码器部分的参数,该函数分别与编码器层和解码器层的数量相关。

此外,这种深度规范化策略可确保成功构建 10 到 100 层,从而使模型更具表现力。相比之下,与普通 Conformer 相比,深度稀疏 Conformer 的时间和内存成本降低了 10% 到 20% 。

用于语音识别的注意力增强型 Citrinet

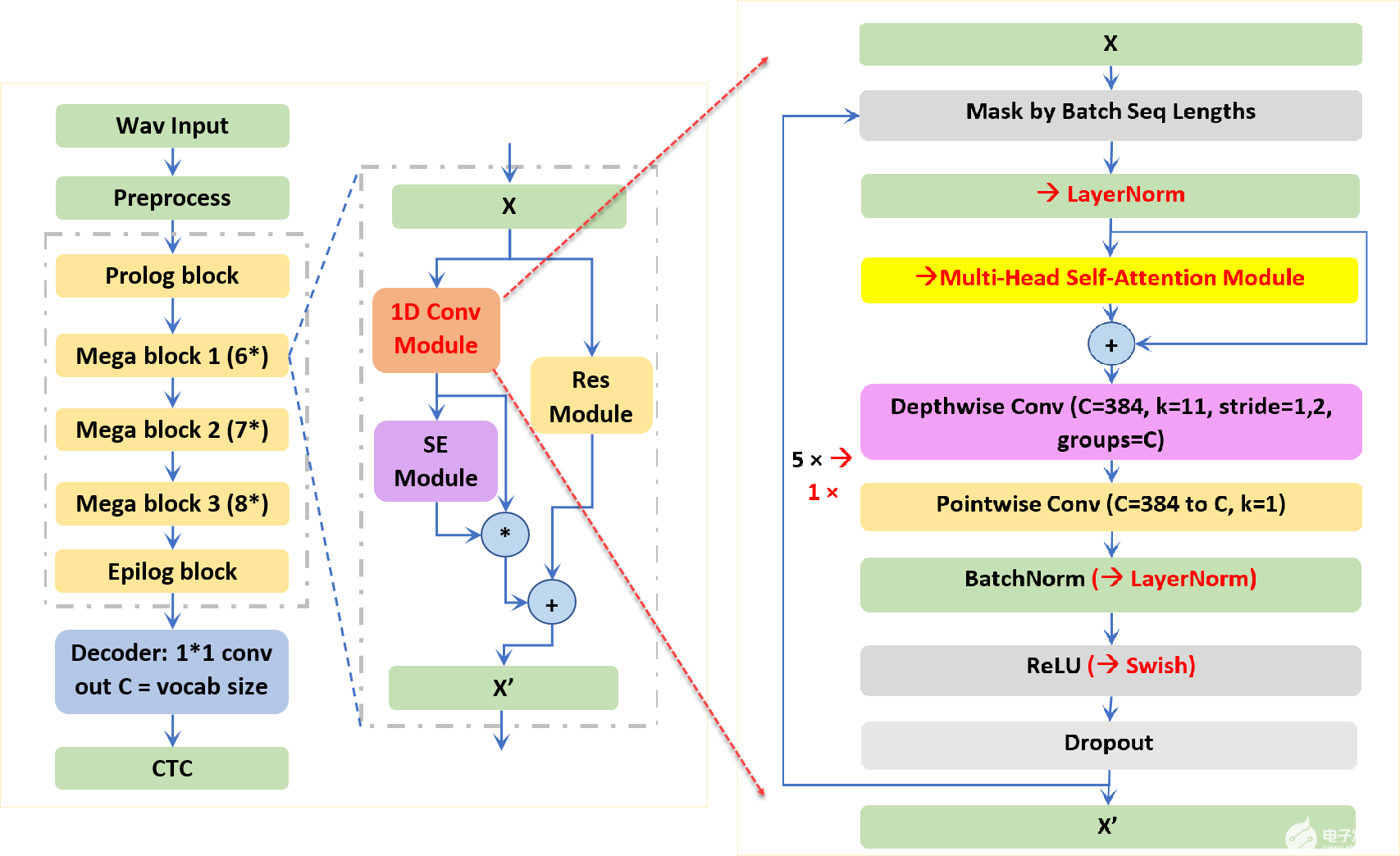

NVIDIA 研究人员提出的 Citrinet 是一种基于端到端卷积连接时态分类( CTC )的 ASR 模型。为了捕获本地和全局上下文信息, Citrinet 使用 1D 时间通道可分离卷积与子字编码、压缩和激励( SE )相结合,使整个体系结构与基于变压器的同类产品相比达到最先进的精度。

将 Citrinet 应用于日本 ASR 涉及几个挑战。具体来说,与类似的深度神经网络模型相比,它的收敛速度相对较慢,并且更难训练出具有类似精度的模型。考虑到影响 Citrinet 收敛速度的卷积层多达 235 个,我们旨在通过在 Citrinet 块的卷积模块中引入多头部注意来减少 CNN 层,同时保持 SE 和剩余模块不变。

图 2.Citrinet 端到端架构和主要构建块

如图 2 所示,加快训练时间需要在每个注意力增强的 Citrinet 块中减少八个卷积层。此外,考虑到自我注意对输入音频波的长度具有二次 的时间/记忆复杂性,我们将原来的 23 个 Jasper 块缩减为 8 个块,模型尺寸显著减小。这种设计确保了注意力增强的 Citrinet 对于从 20 秒到 100 秒的长语音序列达到了可比的推理时间。

初步实验表明,基于注意力的模型收敛于 100 到 200 个时间点,而 Citrinet 收敛到最佳错误率需要 500 到 1000 个时间点。在日本 CSJ-500-hour 数据集上的实验表明,与 Citrinet ( 80% 的训练时间)和 Conformer ( 40% 的训练时间和 18.5% 的模型大小)相比, Citrinet 的注意力需要更少的块层,收敛速度更快,字符错误率更低。

总结

通常,我们提出两种新的架构来构建端到端的日本 ASR 模型。在一个方向上,我们改进了基于变压器的 Conformer 训练和推断速度,并保持了其准确性。我们成功地构建了更稀疏和更深入的 Conformer 模型。我们还通过引入多头部自我注意机制和修剪 80% 的 CNN 层,提高了基于 CNN 的 Citrinet 收敛速度和准确性。这些建议是通用的,适用于其他亚洲语言。

关于作者

吴显超博士是 NVIDIA 的高级解决方案架构师。他专注于语音处理和自然语言处理的研究领域。他支持客户在 NVIDIA SDK (如威震天 LM 、 NeMo 和 Riva )下构建大规模预处理模型和对话人工智能平台。

Somshubra Majumdar 是 NVIDIA NeMo 工具包的资深研究科学家。他于 2016 年获得孟买大学计算机工程学士学位, 2018 年获得芝加哥伊利诺伊大学计算机科学硕士学位。他的研究兴趣包括自动语音识别、语音分类、时间序列分类和深度学习的实际应用。

审核编辑:郭婷

-

编码器

+关注

关注

45文章

3703浏览量

135749 -

语音识别

+关注

关注

38文章

1758浏览量

113272 -

ASR

+关注

关注

2文章

44浏览量

18881

发布评论请先 登录

相关推荐

卷积神经网络模型发展及应用

μC/OS-II 任务调度机制的改进

Snort匹配机制的改进

维纳滤波反卷积算法的改进

卷积神经网络的权值反向传播机制和MATLAB的实现方法

结合改进Fisher判别准则与GRV模块的卷积神经网络

基于通道注意力机制的SSD目标检测算法

结合注意力机制的改进深度学习光流网络

基于循环卷积注意力模型的文本情感分类方法

结合注意力机制的跨域服装检索方法

改进胶囊网络优化分成卷积的亚健康识别

一种基于因果路径的层次图卷积注意力网络

结合卷积和注意机制改进日语ASR

结合卷积和注意机制改进日语ASR

评论