超级计算机被用来建模和模拟科学计算中最复杂的过程,通常是为了洞察新发现,否则这些新发现将不实际或不可能在物理上演示。

NVIDIA BlueField data processing unit ( DPU )正在将 high-performance computing ( HPC )资源转化为更高效的系统,同时加速从数学建模和分子动力学到天气预报、气候研究,甚至可再生能源的广泛科学研究中的问题解决。

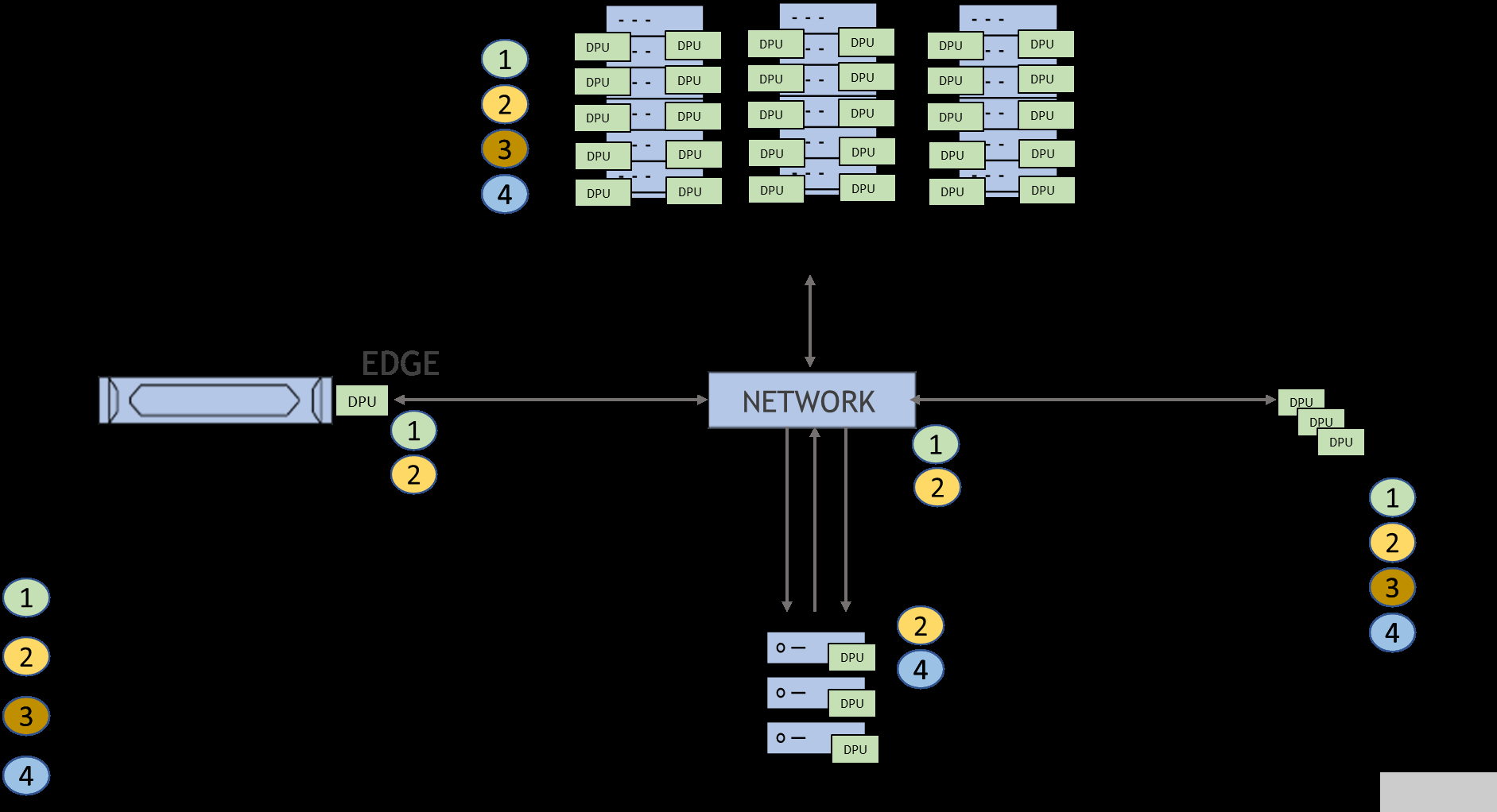

图 1. NVIDIA BlueField DPU 的创新领域

BlueField 已经在 云端网络 、 网络安全 、 通信 和 边缘计算 领域产生了显著影响。此外,在高性能计算的几个领域,它正在激发应用程序性能和系统效率方面的创新。

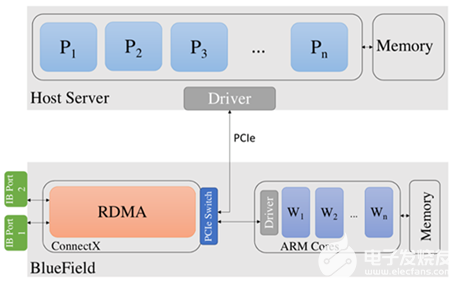

NVIDIA BlueField-3 提供基于多个 Arm AArch64 核的强大计算能力、多线程数据路径加速器、集成的 NVIDIA ConnectX-7 400Gb/s 网络 ,以及 I / O 路径中广泛的可编程加速引擎。它配备了双 DDR 6500MT / s DRAM 控制器,并配有高达 32 GB 的板载内存。 BlueField-3 是第三代芯片上数据中心基础设施,支持从云到核心数据中心再到边缘的高效、强大的软件定义、硬件加速基础设施。

那么,这一切对高性能计算意味着什么呢?

提高 HPC 应用程序性能和可扩展性

HPC 的核心是提高性能和可扩展性。近二十年来, InfiniBand 网络在性能和应用程序可扩展性方面一直处于领先地位,这有几个原因。

从高层次来看, InfiniBand 只是移动数据的最有效方式:直接数据放置。不需要涉及 CPU 或操作系统,也不需要在数据从网络接口通过系统到达需要它的实际应用程序时制作数据的多个副本。

如果 InfiniBand 已经如此高效, BlueField 会带来什么好处?

InfiniBand 多年来一直在解决的一个关键挑战是将网络通信开销从 CPU 移开,使其能够将时间集中在最擅长的方面:应用程序计算和分支代码。

当今主流服务器中的 CPU 过于通用,在数百或数千个与实际计算几乎无关的进程中共享其计算周期、时间和资源。

BlueField 通过卸载、加速和隔离广泛的高级网络、存储和安全服务,为超级计算带来了前所未有的创新和效率。

为什么人工智能时代带来了对 BlueField DPU 的需求

人工智能研究领域成立于 1956 年,是一门学术学科。甚至在那之前的十年,科学家们就开始讨论创造人工大脑的可能性。随着现代计算机硬件和软件的发展,这些概念很晚才成为现实。

2006 年, NVIDIA 推出了业界第一个针对 GPU 的 C 编译器开发环境 CUDA ,解决复杂计算问题的速度比传统方法快 100 倍。今天,人工智能丰富多彩,几乎推动了科学研究的每个领域,改变了我们的生活,塑造了工业景观。

同样, 2006 年中期引入了对非阻塞集合操作的第一个建议的引用。消息传递接口( MPI )的集合组通信功能的非阻塞接口在理论上肯定是丰富的。然而,它并没有在许多应用程序中实现。也许这是因为,在引入 DPU 之前,无法实现全部好处。

今天,随着 BlueField-3 的问世,这项技术已经提供了创新、性能和效率所需的基本要素。为了提高应用程序性能和可伸缩性,并消除操作系统抖动的影响,非阻塞集合操作重新引起了人们的兴趣。

科学计算还有几个领域,包括早期的例子, BlueField 正在演示如何将 HPC 转化为高效和可持续的计算。

使用网络计算节省 CPU 周期

NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP) 技术通过将许多阻塞的集体操作从 CPU 卸载到交换机网络,并消除了在端点之间多次发送数据的需要,从而提高了 MPI 操作的性能。这种创新的方法减少了到达聚合节点时穿越网络的数据量,并大大减少了 MPI 操作时间。

BlueField 通过利用其 Arm 内核实现非阻塞操作,扩展了额外的网络计算能力。这使系统主机 CPU 能够执行峰值重叠计算。

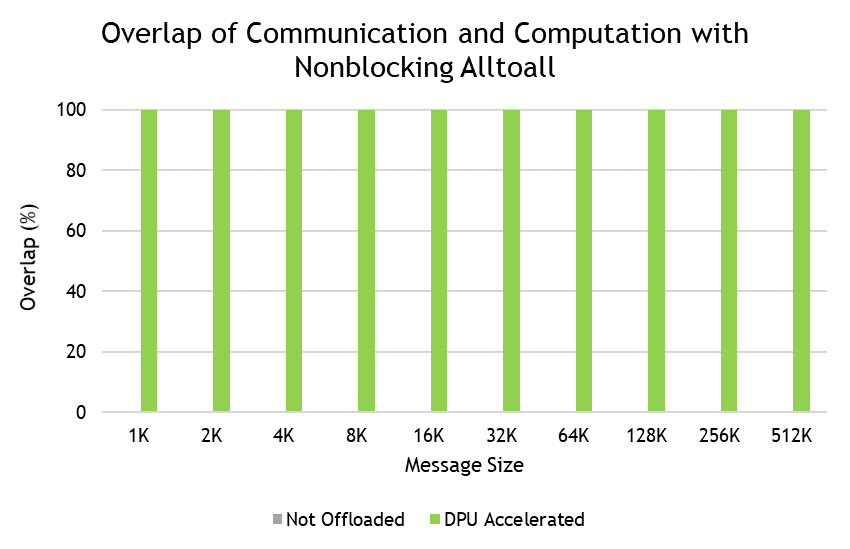

图 2 显示了一个使用 MVAPICH2- DPU 库的示例,该库正在进行优化,以充分利用 BlueField 的潜力。它显示了提取主机上发生的计算与 MPI_Ialltoall 通信之间的峰值重叠的能力。

图 2.使用 NVIDIA BlueField 技术与非阻塞通信和计算的重叠 全部全部

HPC 工作负载的计算存储

计算存储或 in-storage computing 为传统存储设备带来了 HPC 功能。在存储计算中,您可以在存储设备内或旁边执行选定的计算任务,从而减轻主机处理负担并减少数据移动。 BlueField 提供在单个卡上结合存储和网络计算的能力。

BlueField 使存储软件堆栈能够从计算节点卸载,同时作为连接结构的 NVMe 控制器存在,能够加速关键存储功能,如压缩、校验和计算和奇偶校验生成。此类服务在并行文件系统中提供。

整个存储系统堆栈在 Linux 内核中透明卸载,同时在 NVMe 目标端实现标准存储功能的简单 NVIDIA DOCA 实现。

新一代开放存储体系结构为加速、隔离和保护高性能存储系统提供了一种新的范例。该系统采用硬件和软件协同设计,使得 DPU 对用户来说非常高效和透明。

文件系统的加速意味着提高存储系统中关键功能的性能,而存储系统性能是基于深入学习的科学探究的关键促成因素。

将存储客户端和服务器完全卸载到 DPU 的能力导致以前无法实现的安全和性能隔离级别。关键数据平面和控制平面功能移动到 DPU 上的单独域。这样可以免除服务器 CPU 的工作,并在 CPU 或其软件受损的情况下保护功能。

NVIDIA DOCA 软件框架

NVIDIA DOCA SDK 是释放 BlueField 潜力的关键。 NVIDIA DOCA 和 BlueField 通过一个全面、开放的开发平台,共同实现了应用程序的开发,这些应用程序可以提供突破性的网络、安全、存储和应用程序性能。

NVIDIA DOCA 支持一系列操作系统和发行版,包括驱动程序、库、工具、文档和示例应用程序。即将发布的 NVIDIA DOCA 1.5 和 2.0 版本引入了广泛的网络、存储、安全功能和增强功能,为 HPC 开发人员提供突破性的性能和高级编程能力:

一个新的通信通道库

快速访问主机内存以实现 UCX 加速

存储仿真( SNAP ),包括存储加密

新的 NVIDIA DOCA 服务,包括 UCC 卸载服务和遥测服务

NVIDIA DOCA 安全 SDK

改造 HPC 的今天和明天

BlueField 、 NVIDIA DOCA 以及社区将继续改造 HPC 的许多创新领域已经初露端倪。

有些想法已经过时了,例如在数据中心范围内增强性能隔离,或增强作业调度程序以实现更智能的作业安排。

由于科学应用通常高度同步,系统噪声对大型 HPC 系统的负面影响可能对性能产生更大的影响。减少存储等其他过程引起的系统噪音至关重要。

遥测信息功能强大。它不仅仅是收集有关路由器、交换机和网络流量的信息。相反,可以通过工作负载和 I / O 特性收集和共享信息。

AI 框架精确地调整了 NVIDIA Quantum-2 InfiniBand 平台中的性能隔离算法。共享公共数据中心资源(如网络和存储)的多应用程序环境可以确保尽可能最佳的性能,就像应用程序作为单个实例在裸机上运行一样。

关于作者

Scot Schultz 是 HPC 技术专家,专注于人工智能和机器学习系统。 Scot 在分布式计算、操作系统、人工智能框架、高速互连和处理器技术方面拥有广泛的知识。在他的整个职业生涯中,拥有超过 25 年的高性能计算系统经验,他的职责包括各种工程和领导角色,包括战略 HPC 技术生态系统支持。 Scot 在众多行业标准组织的成长和发展中发挥了重要作用。

审核编辑:郭婷

-

cpu

+关注

关注

68文章

10803浏览量

210796 -

NVIDIA

+关注

关注

14文章

4848浏览量

102705 -

人工智能

+关注

关注

1789文章

46636浏览量

236995

发布评论请先 登录

相关推荐

HPC 研究人员借助 NVIDIA BlueField DPU 为网络计算的未来打下坚实基础

阿里云E-HPC联合安世亚太、联科集团共建云超算生态

VIDIA宣布在AI超级计算平台中加入融合了AI与高性能计算的新技术

剖析NVIDIA DPU如何在HPC 集群上加速科学计算应用

使用NVIDIA多个DPU加速HPC集群中的科学应用

从NVIDIA BlueField DPU 看加速计算的未来发展

NVIDIA Grace超级芯片为HPC及AI工作负载提速

使用DPU迎接HPC和超级计算性能的新时代

使用DPU迎接HPC和超级计算性能的新时代

评论