电子发烧友网报道(文/李弯弯)根据应用场景的不同,AI芯片被分为云端AI芯片和边缘AI芯片。云端AI芯片有些用于训练,有些用于推理。过去几年AI芯片的市场需求不断增加,2017年整体AI芯片市场规模为62.7亿美元,预计到2022年将会达到596.2亿美元。

而云端AI芯片的市场需求也是增长明显,根据市场调研机构数据,2017年云端训练AI芯片市场规模为20.2亿美元,云端推理芯片为3.4亿美元。预计到2022年,云端训练AI芯片将达到172.1亿美元,云端推理芯片为71.9亿美元

如今在全球云端AI芯片市场领域,可以说是英伟达一家独大,在云端训练市场占比达到90%,在云端推理市场占比也高达60%。另外,国外的英特尔、AMD等厂商也在积极布局。

在国内,也有大批企业寻求在云端AI芯片方面不断突破,包括寒武纪、昆仑芯、燧原科技、天数智芯,以及瀚博半导体、沐曦集成、壁仞科技、摩尔线程、登临科技等。这里对这些企业及产品进展做了梳理,如下:

寒武纪

寒武纪成立于2016年,专注于人工智能芯片产品的研发与技术创新,致力于打造人工智能领域的核心处理器芯片。产品广泛应用于服务器厂商和产业公司,面向互联网、金融、交通、能源、电力和制造等领域的复杂AI应用场景提供充裕算力,推动人工智能赋能产业升级。

寒武纪云端智能芯片产品,大致可以分为云端训练芯片和云端推理芯片,包括云端推理芯片思元270,主要面向云端训练的高端产品思元290,以及主要面向中高端训推场景的思元370。

思元290是寒武纪首颗AI训练芯片,采用创新性的MLUv02扩展架构,使用台积电7nm先进制程工艺制造,在一颗芯片上集成了高达460亿的晶体管。

思元370基于7nm制程工艺,是寒武纪首款采用chiplet(芯粒)技术的AI芯片,集成了390亿个晶体管,最大算力高达256TOPS(INT8),是寒武纪第二代产品思元270算力的2倍。凭借寒武纪最新智能芯片架构MLUarch03,思元370实测性能表现更为优秀。

思元370是国内第一款公开发布支持LPDDR5内存的云端AI芯片,内存带宽是上一代产品的3倍,访存能效达GDDR6的1.5倍。搭载MLU-Link™多芯互联技术,在分布式训练或推理任务中为多颗思元370芯片提供高效协同能力。全新升级的Cambricon NeuWare软件栈,新增推理加速引擎MagicMind,实现训推一体,大幅提升了开发部署的效率,降低用户的学习成本、开发成本和运营成本。

思元370通过不同MLU-Die组合出了三款不同规格、符合不同场景需求的加速卡产品MLU370-S4、MLU370-X4、MLU370-X8。

2021年,寒武纪与阿里巴巴等头部互联网企业的多个业务部门进行了深入合作,云端产品思元370芯片及加速卡在视觉、语音、图文识别等场景的适配性能表现超出客户预期,部分场景已经进入小批量销售环节。在金融领域,寒武纪与多家头部银行进行了导入和适配。其中,MLU370-X4在招商银行多个业务场景的实测性能超过竞品,能够大幅提升客户的效率。

昆仑芯

昆仑芯于2021年4月完成了独立融资,前身是百度智能芯片及架构部,在实际业务场景中深耕AI加速领域已十余年,是一家在体系结构、芯片实现、软件系统和场景应用均有深厚积累的AI芯片企业。

昆仑芯1代芯片于2020年量产,昆仑芯2代于2021年8月18日宣布正式量产。2022年09月百度集团执行副总裁沈抖透露,昆仑芯3代将于2024年初量产。

昆仑芯1代芯片采用14nm工艺,256 TOPS@INT8算力,可用于云数据中心和智能边缘,支持全AI算法,落地超过两万片;昆仑芯2代芯片,搭载自研的第二代XPU架构,采用7nm制程,GDDR6高性能显存,算力256 TOPS@INT8,128 TFLOPS@FP16,相比一代性能提升2-3倍,适用于云、端、边等多场景,支持硬件虚拟化,芯片间互联和视频编解码。

昆仑芯 AI 芯片除了拥有自研 XPU 架构及多项自主设计,也已与飞腾等多款国产通用处理器、麒麟等多款国产操作系统以及百度自研的飞桨深度学习框架完成了端到端的适配,拥有软硬一体的全栈国产AI能力。

目前,昆仑芯科技已与智能产业的上下游企业建立了良好的合作生态,通过向不同行业提供以人工智能芯片为基础的算力产品,辐射互联网、智慧城市、智算中心、智慧工业、智慧应急、智慧交通、智慧金融等“智慧+”产业,以计算驱动智能,以智能促进发展。

燧原科技

燧原科技成立于2018年3月,专注人工智能领域云端算力产品,致力为人工智能产业发展交付普惠的基础设施解决方案,提供原始创新、全栈自研、具备完全自主知识产权的通用人工智能训练和推理产品。凭借其高算力、 高能效比以及灵活编程能力,可广泛应用于互联网、金融、交通、能源及新基建等多个行业和场景。

截至目前,燧原科技已经开发了两个产品线,一个是云端的训练,包括邃思1.0和邃思2.0,一个是推理芯片,邃思2.5。

邃思1.0基于可编程芯片的设计理念,其计算核心包含32个通用可扩展神经元处理器(SIP),每8个SIP组合成1个可扩展智能计算群(SIC)。SIC之间通过HBM实现高速互联,通过片上调度算法,数据在搬迁中完成计算,实现SIP利用率最大化。邃思支持CNN、RNN、LSTM、BERT等网络模型和丰富的数据类型(FP32/FP16/BF16/Int8/Int16/Int32等)。

邃思2.0基于GCU-CARA 2.0架构,以TF32为核心提供多数据精度AI算力支持,针对张量、矢量、标量等多计算范式提供领先性能,支持指令驱动、可编程的融合式数据流架构,提供软件透明、基于任务的智能调度;基于12nm FinFET先进工艺,单芯片包含225亿个晶体管,有效提升算力密度;广泛支持视觉、语音语义、强化学习等各技术方向的模型训练。

燧原科技创始人赵立东前不久表示,公司去年与浪潮科技,联合发布了钱塘江智算中心的解决方案,打造了一个液冷的160台服务器的算力集群,集成了180张燧原科技第一代的训练卡,现在已部署在之江实验室上线运行。

天数智芯

天数智芯2018年正式启动通用并行云端计算芯片设计,公司致力于开发云端服务器级的通用高性能计算芯片,以客户、市场为导向,瞄准以云计算、人工智能、数字化转型为代表的数据驱动技术市场,解决核心算力瓶颈问题,为全产业打造高端算力解决方案。

2021年3月,天数智芯正式发布通用GPU“天垓100”芯片及天垓100加速卡。天垓100芯片基于7nm工艺,采用全自研的架构、计算核、指令集及基础软件栈,2.5D CoWoS晶圆封装技术,包括240亿个晶体管。

天数智芯坚持自研通用GPU体系思路,天垓100适配x86、ARM、MIPS等架构CPU指令集,业界标准的软件API(应用程序编程接口)支持垂直类行业应用开发,支持TensorFlow、PyTorch等各种主流深度学习开发框架,以及软硬件全栈支持等,广泛应用于互联网、运营商、生物医疗、教育科研、智算中心等不同行业众多应用场景。

2022年4月,天数智芯宣布,目前天垓100产品累计订单金额已经接近2亿元,覆盖新华三等多个头部企业。而且,天垓100已支撑近百个客户在人工智能领域进行超过两百个不同种类模型训练。另外天数智芯首款7nm通用GPU推理产品智铠100也在今年5月份成功点亮。

瀚博半导体

瀚博半导体成立于2018年,专注于研发高性能通用加速芯片,为计算机视觉、智能视频处理、自然语言处理等应用场景,提供低延时、高吞吐的异构计算性能和高效的性能/功耗比,芯片解决方案覆盖从云端到边缘的服务器及一体机市场。

2021年7月7日,瀚博半导体发布首款云端通用AI推理芯片SV100系列及VA1通用推理加速卡。SV100系列,深度学习推理性能指标数倍于现有主流数据中心GPU,超高吞吐量、超低延迟;针对各种深度学习推理负载而优化的通用架构,支持计算机视觉、视频处理、自然语言处理和搜索推荐等推理应用场景;集成高密度视频解码,广泛适用于云端与边缘解决方案,单芯片INT8峰值算力超过200TOPS,节省设备投资、降低运营成本。

在2022年世界人工智能大会期间,瀚博半导体又发布了四款新品:瀚博统一计算架构、全新数据中心AI推理卡载天VA10、边缘AI推理加速卡载天VE1、以及瀚博软件平台VastStream扩展版。此外,瀚博还预览展示国产7nm云端GPU芯片SG100,用于图像渲染、视频、元宇宙等领域,不过这款产品目前还未发布。

沐曦集成

沐曦集成成立于202年9月,公司致力于为异构计算提供安全可靠的高性能GPU芯片及解决方案,可广泛应用于人工智能、智慧城市、数据中心、云计算、自动驾驶、科学计算、数字孪生、元宇宙等前沿领域,为数字经济发展提供强大的算力支撑。

2022年1月,沐曦首款采用7nm工艺的异构GPU产品已正式流片,预计很快量产。该产品主要用于AI推理场景,可在人工智能、自动驾驶、工业和制造自动化、智慧城市、自然语言处理、边缘计算等领域应用。

沐曦第二款用于科学计算、数据中心弹性计算、AI训练等的旗舰GPU芯片也已进入研发收尾阶段,计划于2024年全面量产。此外,到2025年,沐曦将推出融合了图形渲染的完整GPU产品,也就是显示和游戏用途的GPU。

沐曦产品均采用完全自主研发的高性能GPU IP,拥有完全自主的指令集和架构,配以兼容主流GPU生态的完整软件栈(MACAMACA),具备高性能、高效能和高通用性的天然优势,能够为客户构建软硬件一体的全面生态解决方案。

壁仞科技

壁仞科技创立于2019年,致力于开发原创性的通用计算体系,建立高效的软硬件平台,同时在智能计算领域提供一体化的解决方案。从发展路径上,壁仞科技将首先聚焦云端通用智能计算,逐步在人工智能训练和推理、图形渲染等多个领域赶超现有解决方案。

壁仞科技BR100系列通用GPU芯片,针对人工智能训练、推理,及科学计算等更广泛的通用计算场景开发,主要部署在大型数据中心,依托“壁立仞”原创架构,可提供高能效、高通用性的加速计算算力。目前,BR100系列拥有BR100、BR104两款芯片。

BR100系列采用7nm制程,并创新性应用Chiplet与2.5D CoWoS封装技术,兼顾高良率与高性能;支持PCIe 5.0接口技术与CXL通信协议,双向带宽最高达128 GB/s;原创BLink™高速GPU互连技术,单卡互连带宽最高达448 GB/s,并支持单节点8卡全互连;除原生支持FP32、BF16、FP16、INT8等主流数据精度外,原创定义TF32+数据精度,相较TF32提供更高数据精度与吞吐性能。

摩尔线程

摩尔线程成立于2020年10月,专注于研发设计全功能GPU芯片及相关产品,支持3D高速图形渲染、AI训练推理加速、超高清视频编解码和高性能科学计算等多种组合工作负载,兼顾算力与算效,能够为中国科技生态合作伙伴提供强大的计算加速能力。

2022年3月30日,摩尔线程正式推出首款基于其先进架构MUSA统一系统架构(Moore Threads Unified System Architecture)打造的数据中心级多功能GPU产品MTT S2000,内置渲染、音视频编解码、人工智能加速和并行计算等硬件模块,能够提供图形图像渲染、视频云处理、AI和科学计算在内的全栈功能。

凭借其独特的渲染、虚拟化等能力和广泛的生态支持,MTT S2000可以在云桌面、安卓云游戏、视频云、云渲染和AI推理计算加速等应用场景全面助力绿色数字经济发展。

摩尔线程MTT S2000兼容X86、ARM等CPU架构以及主流Linux操作系统发行版,并已着手与多家服务器合作伙伴开展合作,包括浪潮、新华三、联想、清华同方、长城超云、思腾合力等OEM厂商多款通用服务器及GPU服务器型号,可以在众多硬件和应用环境中完成部署。

得益于丰富的模型库支持和先进硬件设计,MTT S2000能够满足计算机视觉、自然语言处理等多种智能应用场景的模型训练和推理应用,并对包括DBNet、CRNN、FastRCNN、Yolo V2/V3/V5、PSENet、Mask RCNN、Resnet 50/101、Inception、Vgg、Alexnet、Densenet、Unet等在内的众多主流深度学习算法提供支持。

同时,MTT S2000也支持用户使用PyTorch、TensorFlow、PaddlePaddle等深度学习框架进行算法开发及应用搭建。此外,用户也可通过应用更广泛的OpenCL及CUDA环境进行开发,大幅降低了新硬件的学习及应用门槛,提升开发速度。

登临科技

登临科技成立于2017年,专注于高性能通用计算平台的芯片研发与技术创新,致力于打造云边端一体、软硬件协同、训练推理融合的前沿芯片产品和平台化基础系统软件。

公司自主创新的GPU+,在兼容CUDA/OpenCL在内的编程模型和软件生态的基础上,通过架构创新,完美解决了通用性和高效率的双重难题。大量客户产品实测证明,针对AI计算,GPU+相比传统GPU在性能尤其是能效上有显著提升。

2022年9月,登临科技创始人李建文在某会议上表示,登临科技首款系列产品基于GPU+的创新AI加速器Goldwasser已在智慧城市、交通、金融、能源、电力、教育、无人驾驶、互联网等众多行业实现商业化落地,目标年内客户订单达数万片,并且已实现批量量产交付。登临第二代产品将于明年上半年进入市场,其能效比将是第一代产品的2倍。

另外,登临科技还发布了完整的翰铭(Hamming)软件工具链,该工具链支持国内外主流AI框架、操作系统、CPU、容器与虚拟机、以及推理服务器,可帮助客户尽快把算法部署到实际业务上,并帮助云端与数据中心的客户更好地利用硬件资源。

小结

总结来看,寒武纪、昆仑芯的云端AI芯片已经有一定量出货,燧原科技的产品也已经智算中心中部署运行,天数智芯表示其天垓100产品累计已拿下接近2亿元的订单金额,登临科技的产品也已经实现批量交付。其他各家的产品在研发和推进应用方面,都有不同程度的进展。整体而言,各家厂商都在积极寻求创新,寻求突破。

-

芯片

+关注

关注

453文章

50360浏览量

421621 -

AI

+关注

关注

87文章

30072浏览量

268331 -

人工智能

+关注

关注

1791文章

46819浏览量

237454

发布评论请先 登录

相关推荐

AI驱动存储需求激增,企业级SSD市场迎来国内厂商崛起

国内首款!赛思语音芯片(SLIC芯片)重磅发布,引爆1300亿+FTTR改造市场需求!

上半年国内手机市场呈现增长态势

RISC-V在中国的发展机遇有哪些场景?

国产FPGA的发展前景是什么?

需求带动射频电源市场增长,国产厂商逐步发力

英伟达AI芯片需求激增,封测厂订单量或翻倍

百亿光模块市场!光芯片加速国产化,国内厂商深挖高速光芯片潜力

戴森新款吹风机HD16发布对国内厂商的启示

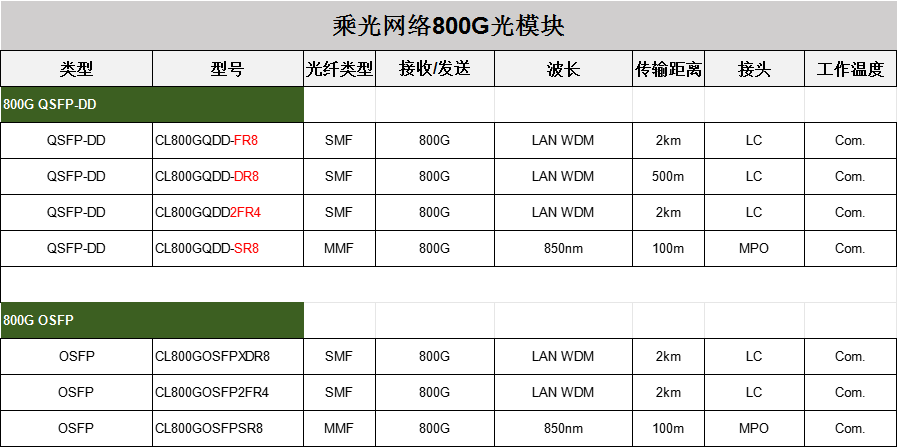

随着AI算力需求不断增强,800G光模块的需求不断增大

半导体市场需求日益旺盛 连续三个月正增长

英伟达如何应对AI芯片市场需求的转变

AI PC 强势进军市场,存储芯片厂商迎接复苏大商机

云端AI芯片市场需求不断增长,国内厂商进展如何?

云端AI芯片市场需求不断增长,国内厂商进展如何?

评论