前段时间,和几个业界同仁在探讨如何降低PUE,引发了对冷热通道温升、风机功率、自然冷源利用的相关探讨,发现讨论PUE居多,但降低PUE对IT设备的功耗的影响关注较少。本文结合环境温度对服务器芯片功耗的影响来探讨数据中心整体节能的一些措施。

一、机房温度和相对湿度标准

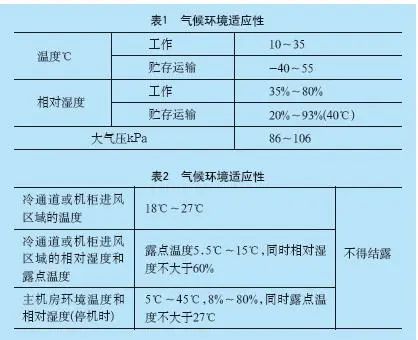

IDC机房服务的对象是服务器,我们首先探讨服务器对温度和相对湿度的要求。表1是《GB/T9813.3-2017计算机通用规范第3部分服务器》对服务器工作温度和相对湿度的要求,无论是工作温度还是相对湿度,这两个指标都是较容易满足的。而《GB50174-2017数据中心设计规范》则提出了更为严格的要求,如表2所示。

业内大客户对机房环境要求一般按照GB50174-2017的最低要求,以下是阿里巴巴数据中心和腾讯TB的相关标准。

机房内服务器和网络机架进风温度或UPS正面进风处任意点温度正常情况下不应高于26℃,湿度范围30-80%(不结露);紧急情况时,机房冷通道内任一点温度不应超过30℃(对应运营标准SLA,当有项目调整SLA温度上限时,需要具体商议),区域气流组织应考虑通风地板面积、通风孔率,局部风扇地板,局部精密空调,机柜面板密封等方式解决局部过热,确保热通道与冷通道温差不应超过13℃;

处理后的水质达到数据中心加湿用水要求。处理后的相对湿度满足最新国标要求,同时机房冷通道或机柜送风温度21℃-26℃,相对湿度30%rh-70%rh,含湿量5.5g/kg-10.6g/kg,除湿能力满足最大的范围要求。

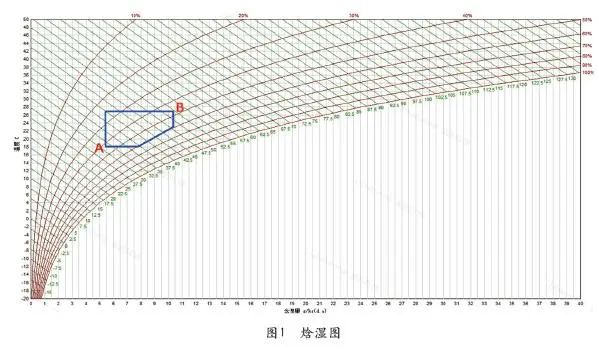

基于以上标准,我们发现,无论是计算机通用规范还是数据中心设计规范要求,冷通道的温度和相对湿度都是一个范围,如图1所示焓湿图中蓝色合围区域(各企业的标准略有不同,图中合围区域也会有所不同)。

二、机房温湿度的设置

既然机房的温湿度可以在一定范围内调整,那么,该如何调整机房的温湿度才能降低整个项目的能耗呢?如焓湿图所示,冷通道温湿度度从右上角B点位置降低到左下角A点位置,数据中心空调系统的能耗会明显的增加,PUE会提高,但IT设备特别的功耗是降低的,如何降低的呢?我们以IT设备的主要热源芯片的功耗来分析。

芯片(或半导体)的热阻与温度、功耗之间的关系为:

Ta=Tj-P×(Rjc+Rcs+Rsa)=Tj-P×Rja

公式中,Ta表示环境温度,Tj表示芯片的结温,P表示功耗,Rjc表示结壳间的热阻,Rcs表示芯片外壳与散热器间的热阻,Rsa表示散热器与环境间的热阻,Rja表示结与环境间的热阻。

当芯片的散热片足够大且接触足够良好时,壳温Tc=Ta,芯片外壳与环境间的热阻

Rja=Rcs+Rsa=O。此时Ta=Tj-P×(Rjc+Rcs+Rsa)演化成公式:

P=(Tj-Ta)/Rjc

厂家规格书一般会给出最大允许功耗Pcm、Rjc或Rja等参数,一般Pcm是指在Tc=25℃或

Ta=25℃时的最大允许功耗。

从公式可以看出,要想降低芯片的功率,就要降低Tj-Ta这个值,这个值与机房的冷热通道温度相对应,但实际上会有些差值,受到其他器件发热量的影响,Ta高于冷通道温度;受到散热器的散热效率影响,Tj也高于热通道温度,故降低冷热通道的温差、提高芯片散热器的散热效率,有利于降低芯片功率。

芯片的消耗功率用漏极源极间导通电阻RDS(on)计算,芯片所消耗的功率PD用芯片自身具有的导通电阻RDS(on)乘以漏极电流(ID)的平方表示:

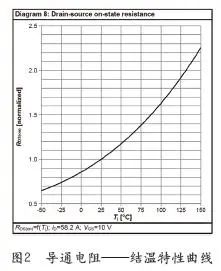

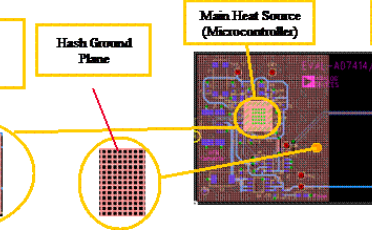

RDS(on)随着Tj的变化,厂家的规格书也会给出相应的曲线,图2所示为Infineon某款芯片的导通电阻-结温特性曲线。

从以上曲线看出,随着Tj的上升,RDS(on)也会明显的增加,根据上面的公式,PD也同系数的上升,故降低Tj,可以明显的降低PD。如果冷热通道温差不变,Tj-Ta这个差值就也不变,要降低Tj,除了提高芯片散热器的效率,就只能降低Ta,也就是通过降低冷通道的温度,以降低芯片的功耗。

但无论是降低冷热通道的温差,还是降低冷通道的温度,IT设备的功耗虽然降低了,数据中心空调系统的功耗却增加了。根据空气热力学公式Q=(P×60)/[1200×4.2×0.24×(Tj-Ta)]计算,Tj-Ta这个差值降低,服务器风机和精密空调风机的风量都会增加,风机的功耗也会增加。由于服务器风机和精密空调风机都是机房设备功耗的重要组成部分,冷热通道温差的调整还涉及到机房相对湿度的变化,故数据中心的冷热通道温差通常设置在10~12℃不变。

不改变冷热通道的温差,降低冷通道的温度,可以降低IT设备芯片的功耗,半导体设备发热量也跟着降低,在温差不变的情况下,必然会降低服务器风机和精密空调风机的风量需求和功耗。但降低冷通道的温度,虽然IT设备整体功耗和精密空调风机功耗会降低,但压缩机(含冷凝器风机)或者冷冻水中央空调系统的能效会降低,空调系统的功耗会增加。

那么,有没有一个IT设备和中央空调系统整体能耗最低的值呢?肯定有,这需要结合项目地去做综合测试。下面这个场景就值得我们去尝试:在冬冷夏暖地区自然冷的季节,可以通过降低冷冻水的温度来降低冷通道的温度,继而降低IT设备和冷冻水精密空调的功耗。由于使用了板式换热器,冷水机组完全停止工作,冷冻水供回水10/16℃相对于15/21℃,增加的主要是冷却塔风机和冷却水泵的功耗,但增加的这个功率是远低于IT设备和冷冻水精密空调降低的功耗,这个时候,整个项目的能耗降低了。但要注意的是,这个时候PUE并没有降低,反而升高了,因为IT设备功耗降低了,空调系统的功耗增加了。

对于IDC运营企业来讲,通常有包电与不包电之分,如果是包电的项目,肯定是整个项目的能耗降低优先考虑了,如果是不包电的项目,则要结合客户的需求综合考虑。综合各种需求,数据中心在运行时,冷通道的温度一般会结合当地气候特点设置三种工况:春秋22~23℃,夏季25~26℃,冬季20℃左右。这几种工况的调整,并不是雷同的,要结合当地的气候特点,实际上就是考虑整个项目的节能,而不纯粹是PUE考核。

三、结束语

IDC在建设时,追求PUE的降低没有错,但在运维时要考虑IT设备和基础设施的总能耗。结合当地的气候特点和客户对冷热通道温湿度的要求,灵活调整冷热通道的温湿度是整个项目节能的重要手段。

-

数据中心

+关注

关注

16文章

4774浏览量

72111 -

服务器芯片

+关注

关注

2文章

122浏览量

19254 -

风机

+关注

关注

1文章

387浏览量

24554

原文标题:关于数据中心PUE与计算机节能的探讨

文章出处:【微信号:通信电源技术,微信公众号:通信电源技术】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于STM32+SHT30设计的环境温度与湿度检测系统(IIC模拟时序)

[灌水]突破行业瓶颈?进入高稳定服务器时代

AD9910芯片手册说工作温度高温至85度,这个温度是指环境温度吗?

环境温度传感器检测

环境温度对电池性能有何影响?

外壳温度与环境温度

汽车电子环境温度和影响分析

如何对C8051F系列单片机的温度传感器测量环境温度的误差进行分析

为您解决温度问题(四)环境温度监测

关于电容超过额定环境温度时的额定功率

环境温度对服务器芯片功耗的影响

环境温度对服务器芯片功耗的影响

评论