0. 引言

多机器人协作在搜索救援、工业自动化、智慧农业等领域发展迅猛,而协同SLAM(C-SLAM)是实现多机器人协作的核心技术。现有的EuRoc、KITTI等数据集虽然在单机SLAM领域发挥了重要作用,但却很难去评价多机协同的轨迹和建图精度。近日,中山大学团队开发了一种用于协作SLAM的大规模多模态数据集,由3个无人车沿四种轨迹采集,包含7个室外场景和5个室内场景。这是第一个使用各种室内和室外环境的激光雷达、视觉和惯性数据的C-SLAM数据集,研究机器人协作的小伙伴一定不要错过!

2. 摘要

随着使用一组机器人协作完成任务的要求越来越高,研究界对协作同步定位和地图绘制越来越感兴趣。不幸的是,现有的数据集在它们捕获的协作轨迹的规模和变化方面是有限的,尽管不同主体之间的交互轨迹的一般化对于协作任务的整体可行性是至关重要的。为了帮助将研究社区的贡献与现实世界的多主体协调SLAM问题结合起来,我们引入了S3E,这是一个由无人驾驶地面车辆车队沿着四个设计的协作轨迹范例捕获的新的大规模多模态数据集。S3E由7个室外和5个室内场景组成,每个场景都超过200秒,由同步和校准良好的高质量双目相机、激光雷达和高频IMU数据组成。至关重要的是,我们的努力在数据集大小、场景可变性和复杂性方面超过了以前的尝试。它的平均记录时间是开创性的EuRoC数据集的4倍。我们还提供仔细的数据集分析以及协作SLAM和单个对应方的基线。

3. 数据集介绍

3.1 数据采集车

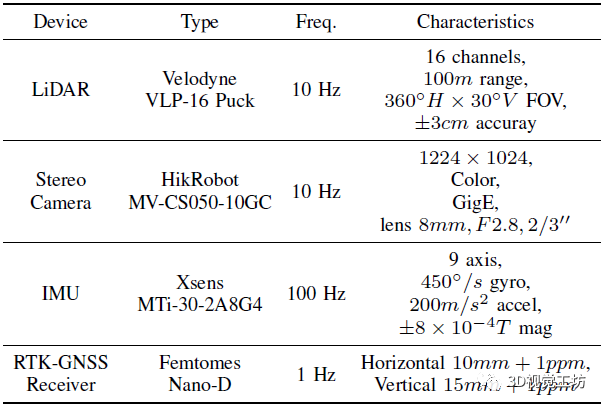

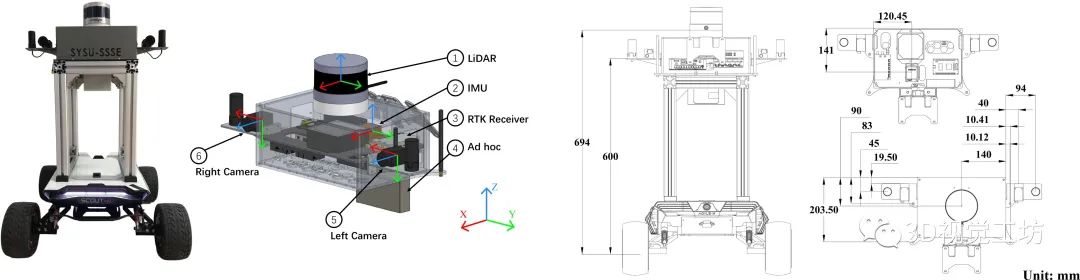

如图1所示是用于采集S3E数据集的无人车,每个无人车上都有2个高分辨率彩色相机、1个16线激光雷达、1个9轴IMU以及1个双天线RTK。表1所示是无人车所使用传感器的具体参数。 表1 传感器设备参数

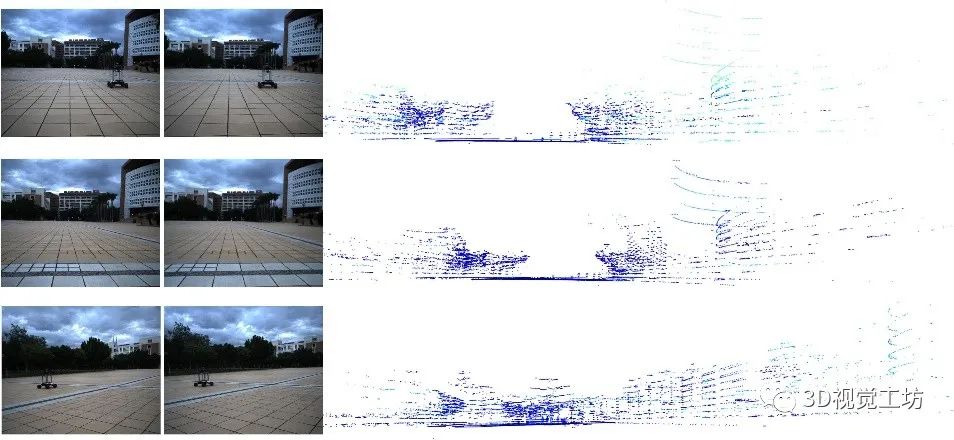

无人车所使用的平台是Agilex Scout Mini,它是一款四轮驱动、最高车速10km/h的全地形高速遥控移动平台。在具体的数据采集过程中,作者使用Velodyne VLP-16 Puck来记录360°点云数据。使用两台HikRobot MV-CS050-10GC GigE相机采集双目视觉数据,其中双目相机的基线为360mm,图像通过全局快门扫描捕获,并从原始图像降采样到1224x1024。此外,还使用9轴Xsens MTi-30-2A8G4 IMU记录三个加速度计和三个陀螺仪。为了进行验证和测试,作者还使用Femtomes Nano-D RTK配备双天线在GNSS可用区域捕获轨迹真值,真值采集频率为1 Hz。无人车平台上所有传感器的安装位置如图2所示,采集到的S3E数据集样例如图3所示。

图2 传感器布局和坐标系

图3 S3E数据集的数据示例,每行都显示了不同平台同时捕捉到的双目图像和点云。

3.2 传感器同步

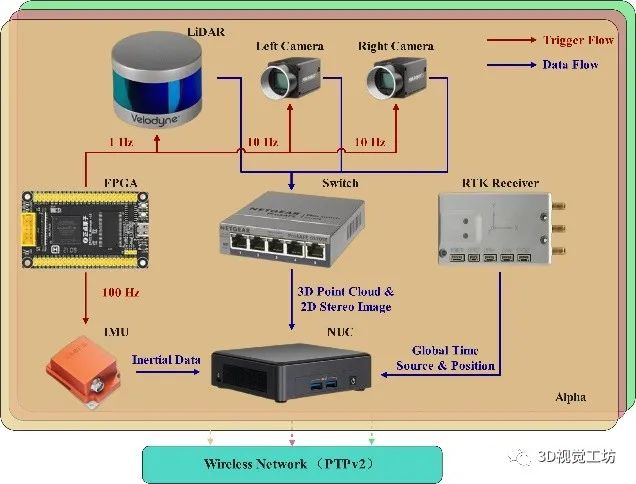

在多传感器融合中,时间同步和传感器校准至关重要。因此,作者在此方面也做了很多的工作。 (1) 时间同步:如图4所示,S3E的同步系统使用Altera EP4CE10板作为触发器,Intel NUC11TNKv7作为主机。对于不同机器人间的同步,作者把这个问题分成两种情况来讨论。首先,应用GNSS时间作为室外场景中的全局时间源来校准机器人的计时器。之后,在无GNSS系统中(室内场景),所有机器人运行时间校准程序,通过无线网络从PTP服务器获取外部全局时间数据。 对于内部同步,触发单元周期性地产生脉冲来触发激光雷达、双目摄像机和IMU。值得注意的是,FPGA产生1 Hz脉冲来触发激光雷达,然后激光雷达返回10 Hz数据,并在接收到触发信号后刷新内部计数器寄存器。摄像机和IMU在收到触发脉冲后立即返回数据。 (2) 传感器校准:在图2所示的传感器布局中,所有的坐标系都遵循右手定则。作者使用标准棋盘校准来运行相机的内部校准。对于激光雷达和IMU,由厂家进行内部传感器校准。之后进行双目相机联合标定和激光雷达-相机联合标定。此外,在利用Allan标准差对IMU噪声建模后,作者还进行了相机和IMU的联合标定。

图4 基于FPGA的同步系统架构

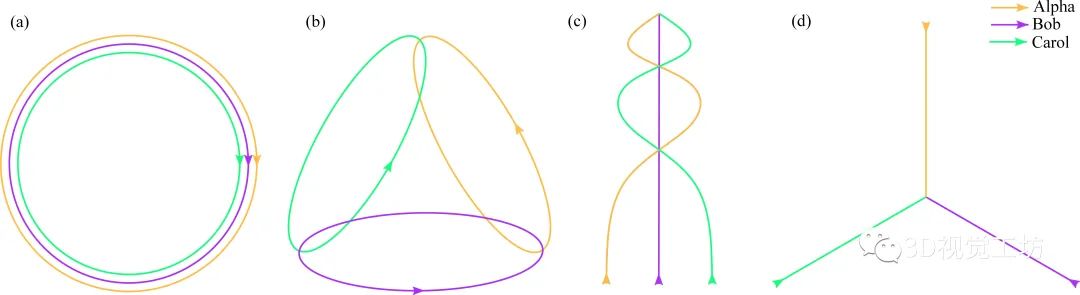

3.3 轨迹范例

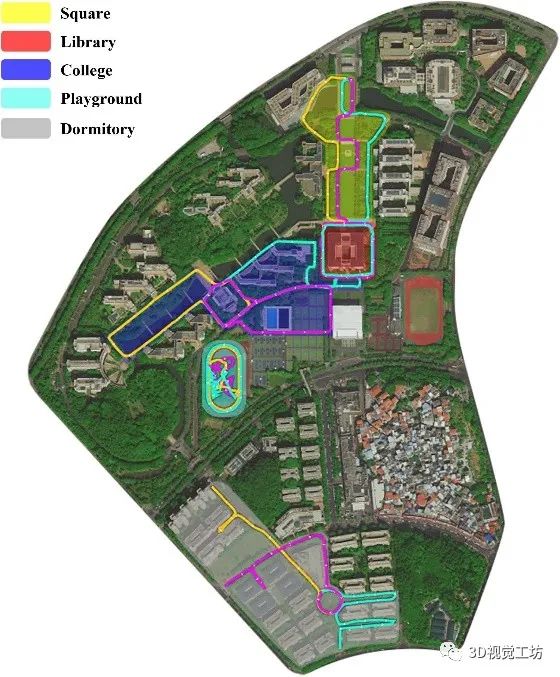

如图5所示,在S3E数据集中,作者设计了遵循四种不同的机器人内/机器人间规范的闭环轨迹。 第一种轨迹是C-SLAM应用中的典型情况,即机器人编队同时绕目标运行,主要用于对目标进行稠密三维重建。第二个轨迹模拟区域搜索和救援任务,每个机器人在不同的区域搜索,并在交互过程中与其他机器人共享信息。这种情况要求C-SLAM算法在小的公共区域内具有可靠的机器人内部闭环能力和高效的机器人之间闭环能力。第三条轨迹集中于仅具有机器人间环路闭合的场景,所有的机器人都从不同的地方开始,并在路径中的一些会合点前进,最后在同一个地方相遇。第四条轨迹中,机器人从不同的地方开始,终点是同一个地点。这种情况在C-SLAM中非常困难,因为所有的机器人只在终点相遇,几乎没有为回环提供任何信息。 图6显示了室外环境中S3E数据集的轨迹,它包含校园内五个有代表性的功能区域,即广场、图书馆、学院、操场和宿舍。

图5 四种轨迹范例

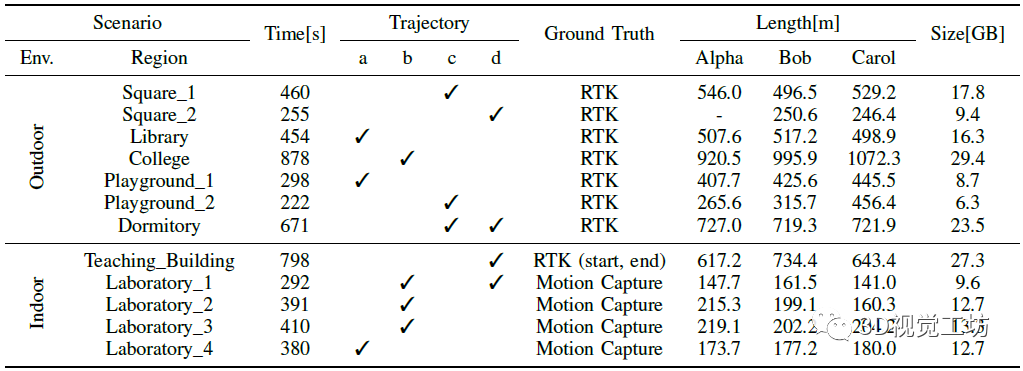

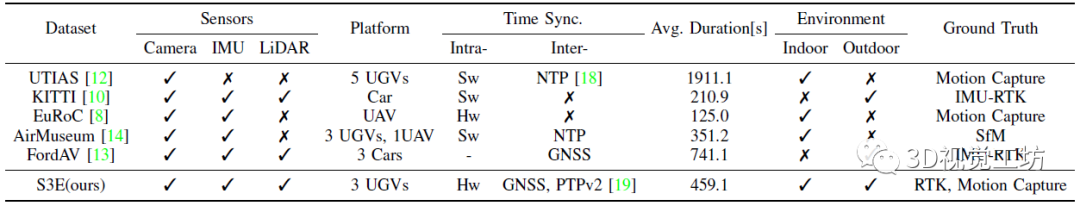

图6 S3E数据集的室外轨迹,Alpha、Bob和Carol在室外环境中的轨迹用橙色、紫色和青色标注。 S3E数据集的室外和室内分布情况如表2所示,与其他主流SLAM数据集的对比如表3所示。S3E数据集的平均时间为459.1s,这对解决C-SLAM的长期评估问题具有较大帮助。值得注意的是,对于每个设计的轨迹,该数据集至少包含一个序列。此外,Dormitory为第三类和第四类的混合轨迹,Laboratory_1为第二类和第四类的混合轨迹。 表2 S3E数据集分析

表3 与一些流行的SLAM数据集的对比

4. 实验

4.1 基线

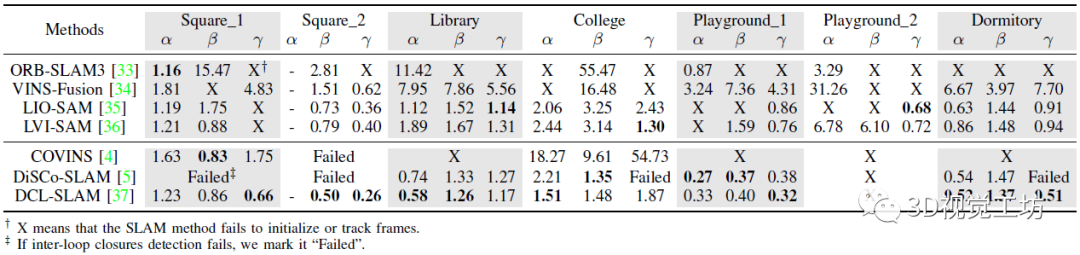

如表4所示,作者在S3E数据集上提供了四个单机器人SLAM和三个C-SLAM基线,评价指标为ATE,均是目前的主流SLAM算法。其中前者包括ORB-SLAM3、VINS-Fusion、LIO-SAM以及LVI-SAM。后者包括COVINS、DiSCo-SLAM以及DCL-SLAM。 作者采用了三种方法来生成轨迹真值:在GNSS可用区域,由双天线RTK设备记录的厘米级定位真值。对于无GNSS的场景,用RTK设备记录建筑物外轨道的起点和终点。并利用运动捕捉设备来记录室内情况下的起点和终点。 表4 室外环境下单SLAM和C-SLAM的基准ATE。α、β和γ分别代表ALPHA、BOB和CAROL

4.2 结果对比

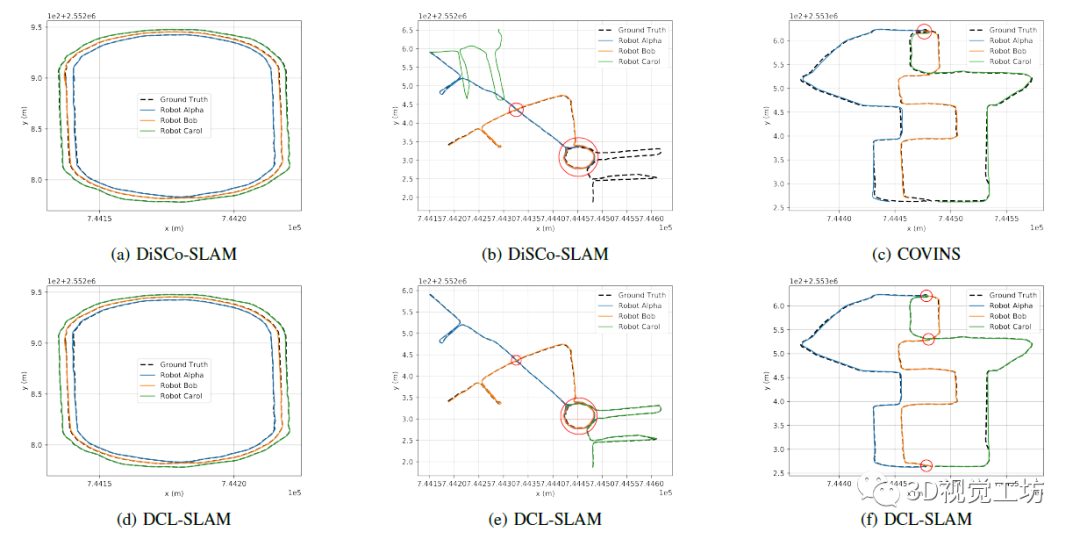

对于单机器人SLAM,基于激光雷达的方法通常优于基于视觉的方法。在S3E中,大多数基于视觉的方法在转弯时无法跟踪帧,因此,基于LiDAR的C-SLAM超过了基于视觉的C-SLAM。同时,C-SLAM在成功检测到回环时,可以状态估计的鲁棒性和准确性。例如DCL-SLAM相比其前端LIO-SAM,平均ATE降低了0.42。在Playground_1序列中,部署单LIO-SAM时,同心圆Alpha和Bob均无法跟踪帧,单通过DCL-SLAM可以成功跟踪,并且精度实现了大幅提升。在Square_1中,COVINS以7.09的ATE超过了单SLAM,Carol在ORB-SLAM3失败时通过协作实现了1.75 ATE。 如图7所示,红色圆圈表示C-SLAM成功检测到回环。在左侧,DiSCo-SLAM和DCL-SLAM在简单的情况下取得成功,因为不同观测之间的大量重叠保证了后端优化的冗余特性。与DCL-SLAM相比,COVINS在两个机器人同向移动的端点处成功检测到不同机器人之间的回环,但在两个机器人相对移动的中点处未能匹配到Bob和Carol之间的特征。这也是DCL-SLAM优于COVINS的原因之一。结果表明,先进的C-SLAM系统可以在具有相当大重叠度的轨迹间表现良好。

图7 C-SLAM的定性结果

5. 结论

近期,中山大学开发了一种由三个无人车记录的大规模C-SLAM数据集,它包含激光雷达-视觉-IMU数据。S3E数据集包含7个室外场景和5个室内场景,并进行了时间同步和传感器校准。此外,S3E数据集中包含了多个回环检测,并评估了当前最先进的C-SLAM及其单机器人前端比较器的性能。多机协同是机器人领域的一个重要发展趋势,而目前多机数据集还较少,S3E很大程度上填补了这方面的空白。

审核编辑 :李倩

-

机器人

+关注

关注

212文章

29319浏览量

211072 -

计时器

+关注

关注

1文章

427浏览量

33362 -

数据集

+关注

关注

4文章

1222浏览量

25231

原文标题:S3E:用于协作SLAM的大规模多模态数据集

文章出处:【微信号:3D视觉工坊,微信公众号:3D视觉工坊】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

爱芯通元NPU适配Qwen2.5-VL-3B视觉多模态大模型

FK10-18S18E2C3 FK10-18S18E2C3

DD10-36S24E3C2 DD10-36S24E3C2

DD6-05S24E3C2 DD6-05S24E3C2

FK6-36S24E2C3 FK6-36S24E2C3

多模态交互技术解析

商汤日日新多模态大模型权威评测第一

用于SLAM中点云地图综合评估的开源框架

利用VLM和MLLMs实现SLAM语义增强

激光雷达在SLAM算法中的应用综述

超声界“内卷终结者”!ZRT智锐通提供全新引擎打造多模态影像融合系统

利用OpenVINO部署Qwen2多模态模型

云知声山海多模态大模型UniGPT-mMed登顶MMMU测评榜首

S3E:用于协作SLAM的大规模多模态数据集

S3E:用于协作SLAM的大规模多模态数据集

评论