军事电子行业的人工智能(AI)正在以超现实的速度增长。各个领域的最新创新恰逢将计算、传感器技术和软件方面最强大的进步带到关键任务场景中。正如GPU在原始计算能力方面继续超过摩尔定律一样,新的传感器和网络接口带来了越来越大的数据集需要计算。这些新技术为将商业和科学人工智能进步的力量带入军事可运输设施提供了关键机会。民用数据中心型人工智能应用和军用可运输部署之间的主要区别(和障碍)是任务的环境、电力和安全要求。

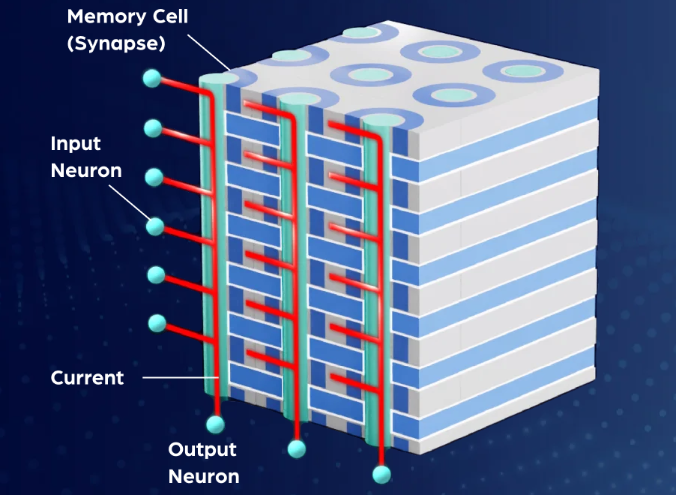

需要在边缘部署人工智能系统的一个明显例子是军用陆地、空中或海上车辆的威胁检测。与民用自动驾驶汽车物体识别一样,军事威胁检测系统正在捕获传入的传感器数据,将数据提供给预先训练的AI模型,并在传感器数据中推断威胁的迹象。此工作流虽然只有几个步骤,但需要几个不同的复杂硬件层。传感器向计算节点提供数据流,计算节点又将可操作的智能分发到适当的子系统,所有这些子系统都在高速存储和互连的框架上运行。

构建硬件架构图成为根据车辆的尺寸、重量和功率 (SWaP) 限制优化连续数据吞吐量的一项练习。虽然可以通过添加另一个计算机系统机架来优化民用数据中心的工作流程,但大多数军用车辆的独特功率、外形和环境条件使得对优化的人工智能可移动系统的挑战和需求显而易见。

应对此工作流程挑战的可能解决方案是将传感器数据流广播到远程或移动数据中心,这可以支持边缘优化程度较低的计算机系统;从而消除了对 AI 计算节点进行加固的需要。然而,随着数据量的增长,传感器数据存储与“云”或远程数据中心之间的通信路径很快成为吞吐量瓶颈。为了在军事可移动人工智能应用中充分利用最新的人工智能技术,应使用边缘优化的融合系统来集成整个工作流程。

这些坚固耐用的军用系统可最大限度地提高传感器数据摄取速率,并将其与整个计算、存储和网络速度相匹配。在这种无瓶颈体系结构中,平衡的数据流可以以可缩放的方式满足数据的计算需求,该方式可以随着数据的增长而增长。无需远程计算意味着可以捕获、处理传感器数据并将其用于实时推理和决策。

打破对远程数据中心和云计算的依赖可以优化AI工作流程的吞吐量,但确实带来了新的挑战。与军用车辆中的所有电子系统一样,融合AI系统的设计必须满足严格的MIL-STD环境条件以及各自车辆的独特动力传输系统。为数据中心构建的商用现货 (COTS) 服务器可在配备 220VAC 单相电源的空调房中运行。为了真正优化通常在不太理想条件下运行的军用车辆的AI工作流程,托管AI构建块的系统必须经过设计,测试和认证,以满足它们将继续支持的任务的严格要求。

审核编辑:郭婷

-

传感器

+关注

关注

2550文章

51056浏览量

753263 -

人工智能

+关注

关注

1791文章

47229浏览量

238340

发布评论请先 登录

相关推荐

《算力芯片 高性能 CPUGPUNPU 微架构分析》第3篇阅读心得:GPU革命:从图形引擎到AI加速器的蜕变

NPU技术如何提升AI性能

华迅光通AI计算加速800G光模块部署

如何优化SOC芯片性能

3D DRAM内嵌AI芯片,AI计算性能暴增

AI云服务器:开启智能计算新时代

ai服务器是什么架构类型

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

risc-v多核芯片在AI方面的应用

NanoEdge AI的技术原理、应用场景及优势

国科微:将持续优化边缘AI战略布局

荷兰AI芯片设计公司Axelera计划推出新型汽车芯粒AI架构

加速计算卡与AI显卡有什么区别?

6G网络架构的核心方案报告

优化AI可传输计算架构

优化AI可传输计算架构

评论