随着消费电子、生物医学和物联网/工业物联网市场中始终监听设备的爆炸式增长,似乎每个人都在尝试使用模拟来节省设计中的功耗。随着使用“模拟内存计算”来降低处理器功耗的新型机器学习(ML)数字芯片,半导体供应商正在发明新的方法来利用模拟计算的固有功耗和计算效率。那么,有什么障碍呢?事实是,尽管这些芯片利用模拟电路的固有优势来节省芯片内的功耗以进行神经网络处理,但它们最终是在数字域中对数字数据运行的数字处理芯片,这意味着它们只能为系统提供有限的节能效果。幸运的是,一种更全面地使用模拟计算的新系统级方法(模拟机器学习 (analogML) 内核)现在可以在系统级别实现更高的电源效率。

虽然模拟内存计算和模拟ML有时都被标记为“模拟计算”,但它们绝不是一回事。设计人员需要了解模拟内存计算和 analogML 内核之间的区别,以便创建更节能的终端设备?

内存模拟计算的芯片级效率

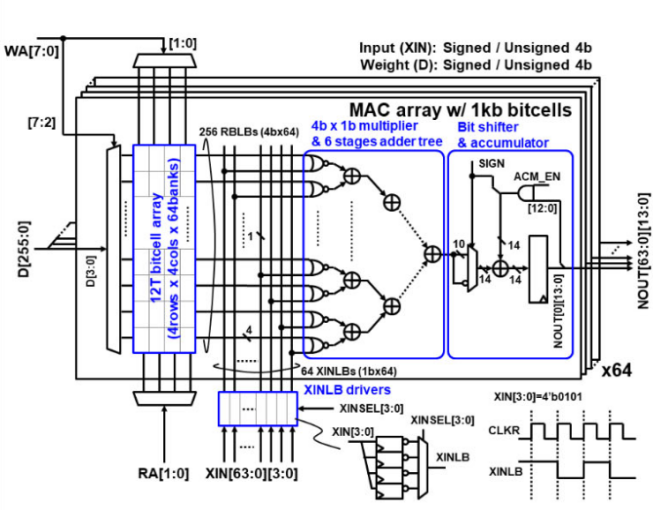

模拟内存计算通常是指在数字机器学习处理器的神经网络中使用模拟电路,以便以较低的功耗执行乘法累加 (MAC) 功能。但是,利用这种方法的芯片仍然是在标准数字处理范式中运行的时钟处理器,需要立即将所有模拟传感器数据数字化,无论是否相关。事实上,使用模拟内存计算的芯片实际上需要在确定数据的重要性之前进行三次单独的数据转换。传感器数据立即转换为数字以进行初始处理(数字化优先架构),然后在芯片内转换为模拟以用于MAC功能,最后,它们在芯片内转换为数字,用于推理,分类和其他功能所需的额外数字处理。因此,大量的数据转换,但实际的模拟处理并不多。

虽然模拟内存计算可能会降低单个推理芯片的功耗,但它仅以非常有限的方式使用模拟,因此它只能为整个系统提供同样有限的功耗降低。

通过模拟机器学习实现系统级效率

相比之下,analogML 内核完全在模拟域内运行,无需时钟,并在数字化任何数据之前使用原始模拟传感器数据进行推理和分类。analogML 内核集成到始终侦听的设备中,在花费任何功率进行单次数据转换之前确定数据的重要性。我们称之为“先分析”,因为模拟ML内核使数字系统保持关闭,除非检测到相关数据。

与集成模拟内存计算的 ML 芯片相比,analogML 内核处理模拟传感器数据的更简化方法对系统级效率具有重大影响。

例如,在典型的语音优先系统中,analogML 内核在 100% 的时间内处于开启状态,在始终监听模式下仅消耗 10μA 的电流,以确定哪些数据是重要的(分析优先架构),然后再在数字化上花费任何功率。这使系统的其余部分保持睡眠状态,直到检测到相关数据。与在数字域中 100% 运行(数字化优先架构)并消耗高达 3000-4000μA 的更传统的 ML 芯片相比,使用 analogML 的分析优先方法可将电池寿命延长多达 10 倍。这就是可持续使用数天而不是数小时的智能耳塞与一次电池充电可持续数年而不是数月的声控电视遥控器之间的区别。

AnalogML 核心中有什么?

深入了解 analogML 内核的幕后,可以揭示模拟内存计算与 analogML 内核之间的区别,模拟内存计算仅用于神经网络,后者由多个软件控制的模拟处理块组成,我们可以为各种分析优先应用程序启用、重新配置和调整。这些模块可以在需要时独立供电,可实现一系列功能。

传感器接口—可以为特定传感器类型(麦克风、加速度计等)合成接口电路

模拟特征提取 — 从原始模拟传感器数据中挑选出显著特征,大大减少进入神经网络的数据量

模拟神经网络 — 高效、占用空间小、可编程的模拟推理模块

模拟数据压缩—连续收集和压缩模拟传感器数据支持低功耗数据缓冲

模拟范式转变

AnalogML 远远超出了使用一点模拟计算来节省整个 ML 芯片计算的一小部分,以节省功耗。它是一个完整的模拟前端解决方案,在数据仍然是模拟数据的情况下,使用接近零的功耗来确定信号链中最早点的数据的重要性,以最大限度地减少流经系统的数据量和数字系统(ADC/MCU/DSP)的开启时间。在某些应用中,例如玻璃破碎检测,事件可能每十年发生一次(或永远不会发生),使用 analogML 内核使数字系统在 99+% 的时间内保持关闭,可以将电池寿命延长数年。这开辟了一类新的持久远程应用程序,如果所有数据(无论是否相关)在处理之前都已数字化,则无法实现这些应用程序。

底线是所有模拟计算都不相等。无论芯片中包含多少模拟处理以降低其功耗,除非该芯片在模拟域中运行,在模拟数据上,它不会做我们知道在系统中节省最多功耗的一件事 - 数字处理更少的数据。

审核编辑:郭婷

-

处理器

+关注

关注

68文章

19656浏览量

232455 -

物联网

+关注

关注

2920文章

45573浏览量

383784 -

机器学习

+关注

关注

66文章

8473浏览量

133739

发布评论请先 登录

相关推荐

云 GPU 加速计算:突破传统算力瓶颈的利刃

Fluidyn-PANACHE交通污染仿真案例演示:导入GIS数据快速建模

并非所有模拟计算都是平等的

并非所有模拟计算都是平等的

评论