PCI Express(PCIe)规范在3.0代保持了近七年(从2010年到2017年),通道以每秒8千兆传输(GT / s)的速度运行。

在此期间,计算和网络带宽需求继续快速增长。在这段时间即将结束时,PCIe 越来越成为提高系统性能的瓶颈。

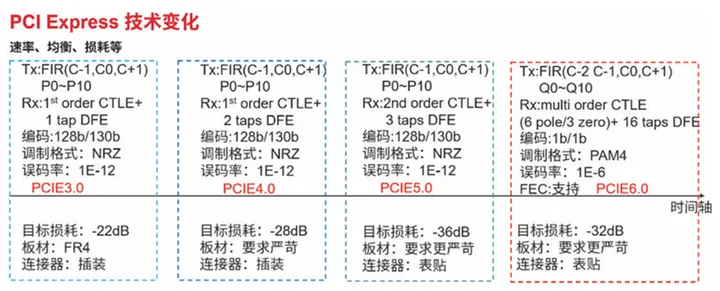

随着数据处理需求和带宽需求的不断加速,业界采取了更加积极的方法来提升 PCIe 的性能,以确保它与其他技术保持同步。PCI-SIG已承诺在两年内升级标准。PCIe 4.0 于 2017 年推出,并于 2019 年底随着 AMD EPYCTM 7002(罗马)处理器的推出在主流服务器中首次亮相。PCIe 4.0 将车道速度提高一倍,达到 16 GT/s。

然而,由 AI/ML、高性能计算 (HPC) 和其他数据中心工作负载驱动的对更大带宽的需求是永不满足的。云中的网络正在从 100 Ggb 以太网 (GbE) 转变为 400 GbE。因此,虽然 PCIe 4.0 最近才上市,但它已经不足以支持这些更快的网络速度。因此,在 2022 年初,我们将看到新服务器架构向下一代 PCIe 标准的过渡。

进入 PCIe 5.0。PCIe 5.0 标准在性能上又提高了一步,以增加带宽并最大限度地减少数据中心和边缘的通信延迟。它将数据速率扩展到 32 GT/s,车道速度比上一代又翻了一番。这允许具有高性能工作负载的应用程序(如基因组学、AI/ML 训练、视频转码和流媒体游戏)的进一步发展,所有这些应用程序的复杂性都在增加,并且要求越来越并行处理。

由于需要高带宽,企业和云数据中心有望成为PCIe 5.0的早期采用者。然而,鉴于越来越多的低延迟和时间敏感型应用程序,PCIe 5.0 在边缘的采用将很快随之而来。典型的超大规模数据中心可以帮助说明接口的部署位置。

超大规模数据中心有三个主要元素:网络、计算和存储。这是一种非常典型的云架构,也称为数据中心的叶脊架构。在此体系结构的基本节点上是服务器机架,这些机架组合在一起形成群集。基本计算,处理,基本上发生在这些服务器中。随着工作负载变得越来越复杂,并行性也在增加,从而推动了东/西流量(数据中心内流量)的增加。

此外,应用程序现在跨越机架内的多个服务器或多个机架。架顶式 (ToR) 交换机负责机架内服务器之间的数据流量交换。连接这些是叶交换机,可在群集内的机架之间实现数据流量。

再往上一层,有一个骨干交换机,使流量能够在数据中心内的集群之间流动。ToR 交换机的前面板是以太网 QSFP 节点,将其连接到机架内的服务器。服务器在 ToR 交换机的以太网连接的另一端有一个网络接口卡 (NIC)。

400 GbE 是一种双向链路,可在两个方向上提供每秒 400 千兆位 (Gb/s) 的带宽。这意味着 800 Gb/s 或每秒 100 GB (GB/s) 的总带宽。PCIe 5.0 也是双向的,通常实例化为 x16 接口。这意味着 32 GT/s,双工乘以 2,乘以 16 通道,除以每字节 8 位,(32 x 2 x 16)/8 或 124 GB/s。这足以支持全速运行的 400 GbE NIC,而 PCIe 4.0 实施的 16 GT/s 数据速率则无法支持。

PCIe 5.0 也提高了在 CPU 和 SSD 控制器之间对 NVMe 驱动器进行非常快速的视频存储访问所需的性能。从存储的角度来看,视频正在扩展到越来越高的分辨率,这意味着控制器和CPU之间的接口必须变得越来越快,而U.2外形尺寸需要x4接口。以 PCIe 5.0 的速度运行,这意味着 32 GB/s 的总带宽。

这种对带宽的贪婪需求永无止境。更多的带宽可以提高工作负载,使新的应用程序成为可能,这些应用程序在永无止境的良性循环中再次需要更多的带宽。PCIe 5.0 代表了最新一代的系统接口标准,它正变得无处不在,用于连接计算设备内部的芯片,就像以太网用于设备之间的连接一样。随着PCI Express标准现在处于两年的升级节奏,PCIe 5.0将成为迈向更高水平的计算性能的重要组成部分。

审核编辑:郭婷

-

处理器

+关注

关注

68文章

19293浏览量

229940 -

服务器

+关注

关注

12文章

9184浏览量

85482 -

PCIe

+关注

关注

15文章

1239浏览量

82687

发布评论请先 登录

相关推荐

银翼新境 致态TiPro9000引领个人存储PCIe 5.0新时代

pcie 4.0与pcie 5.0的区别

PCIe加速卡在数据中心的应用

Kioxia发布PCIe 5.0 EDSFF E1.S SSD

Solidigm发布高性能PCIe 5.0 SSD,引领数据中心存储新纪元

PCIe 5.0 SerDes 测试

美光推出9550系列数据中心PCIe 5.0 SSD

DS320PR1601 32Gbps 16通道PCIe 5.0、CXL 2.0线性转接驱动器数据表

DS320PR410支持PCIe5.0、CXL 2.0的四通道线性转接驱动器数据表

BittWare提供基于英特尔Agilex™ 7 FPGA最新加速板

英韧科技:无AI不存储,国产PCIe 5.0主控率先发力

PCIe 5.0:加速云中的数据移动

PCIe 5.0:加速云中的数据移动

评论