作者:Mehul Gupta

来源:DeepHub IMBA

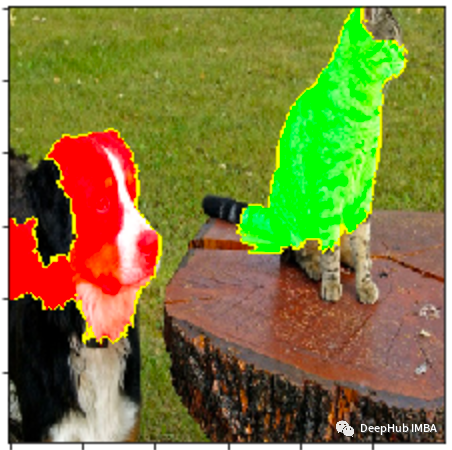

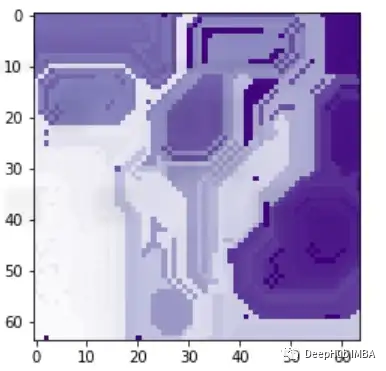

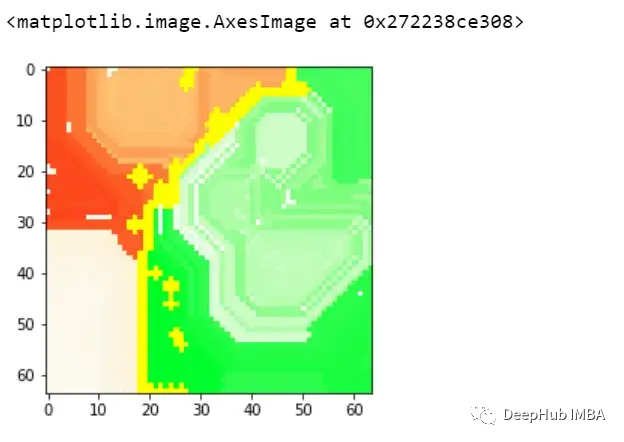

图像与表格数据集有很大不同(显然)。如果你还记得,在之前我们讨论过的任何解释方法中,我们都是根据特征重要性,度量或可视化来解释模型的。比如特征“A”在预测中比特征“B”有更大的影响力。但在图像中没有任何可以命名的特定特征,那么怎么进行解释呢?

一般情况下我们都是用突出显示图像中模型预测的重要区域的方法观察可解释性,这就要求了解如何调整LIME方法来合并图像,我们先简单了解一下LIME是怎么工作的。

LIME在处理表格数据时为训练数据集生成摘要统计:

使用汇总统计生成一个新的人造数据集

从原始数据集中随机提取样本

根据与随机样本的接近程度为生成人造数据集中的样本分配权重

用这些加权样本训练一个白盒模型

解释白盒模型

%matplotlib inline

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

from keras.layers import Input, Dense, Embedding, Flatten

from keras.layers import SpatialDropout1D

from keras.layers.convolutional import Conv2D, MaxPooling2D

from keras.models import Sequential

from randimage import get_random_image, show_array

import random

import pandas as pd

import numpy as np

import lime

from lime import lime_image

from skimage.segmentation import mark_boundaries

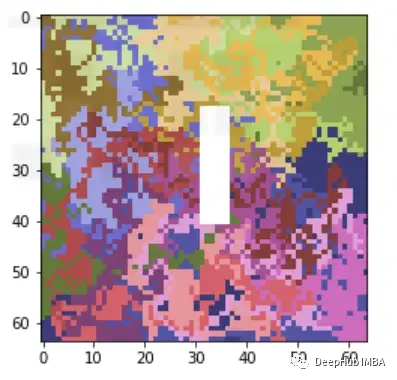

#preparing above dataset artificially

training_dataset = []

training_label = []

for x in range(200):

img_size = (64,64)

img = get_random_image(img_size)

a,b = random.randrange(0,img_size[0]/2),random.randrange(0,img_size[0]/2)

c,d = random.randrange(img_size[0]/2,img_size[0]),random.randrange(img_size[0]/2,img_size[0])

value = random.sample([True,False],1)[0]

if value==False:

img[a:c,b:d,0] = 100

img[a:c,b:d,1] = 100

img[a:c,b:d,2] = 100

training_dataset.append(img)

training_label.append(value)

#training baseline CNN model

training_label = [1-x for x in training_label]

X_train, X_val, Y_train, Y_val = train_test_split(np.array(training_dataset).reshape(-1,64,64,3),np.array(training_label).reshape(-1,1), test_size=0.1, random_state=42)

epochs = 10

batch_size = 32

model = Sequential()

model.add(Conv2D(32, kernel_size=3, padding='same', activation='relu'))

model.add(MaxPooling2D(pool_size=2))

model.add(Flatten())

# Output layer

model.add(Dense(32,activation='relu'))

model.add(Dense(1, activation='sigmoid'))

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

model.fit(X_train, Y_train, validation_data=(X_val, Y_val), epochs=epochs, batch_size=batch_size, verbose=1)

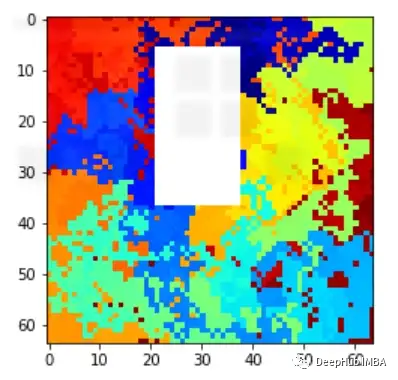

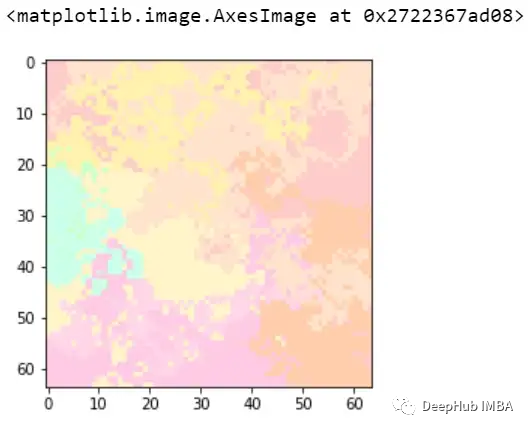

x=10

explainer = lime_image.LimeImageExplainer(random_state=42)

explanation = explainer.explain_instance(

X_val[x],

model.predict,top_labels=2)

)

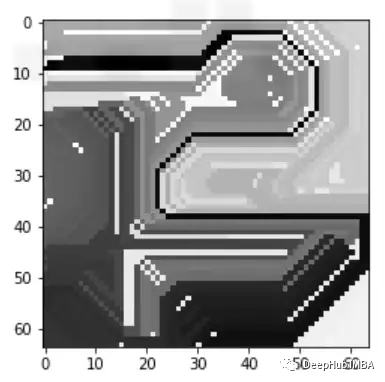

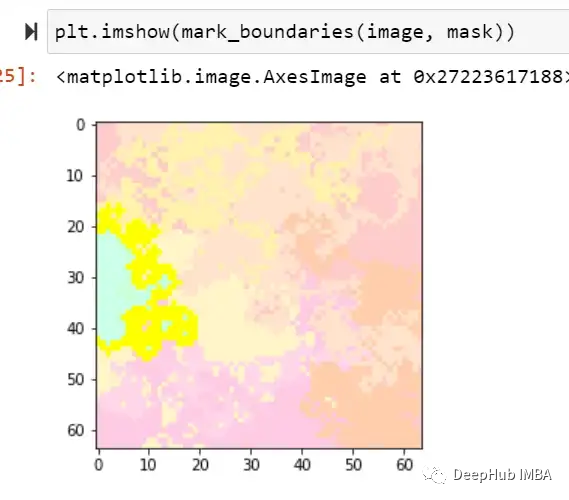

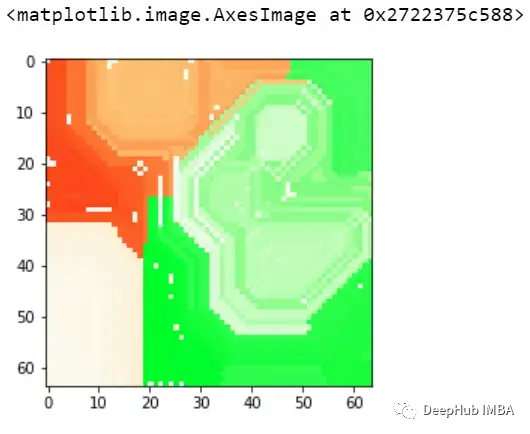

image, mask = explanation.get_image_and_mask(0, positives_only=True,

hide_rest=True)

这样我们就可以理解模型导致错误分类的实际问题是什么,这就是为什么可解释和可解释的人工智能如此重要。

END

(添加请备注公司名和职称)

Imagination 基于 O3DE 引擎的光线追踪 Demo 详解

Imagination Technologies是一家总部位于英国的公司,致力于研发芯片和软件知识产权(IP),基于Imagination IP的产品已在全球数十亿人的电话、汽车、家庭和工作场所中使用。获取更多物联网、智能穿戴、通信、汽车电子、图形图像开发等前沿技术信息,欢迎关注 Imagination Tech!

原文标题:使用LIME解释CNN

文章出处:【微信公众号:Imagination Tech】欢迎添加关注!文章转载请注明出处。

-

imagination

+关注

关注

1文章

570浏览量

61272

原文标题:使用LIME解释CNN

文章出处:【微信号:Imgtec,微信公众号:Imagination Tech】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

使用LIME解释CNN

使用LIME解释CNN

评论