1. 业务背景

是这样的,业务背景是公司的内部系统有一个广告保存接口,需要ADX那边将投放的广告数据进行保存供后续使用。 广告数据大概长这样:

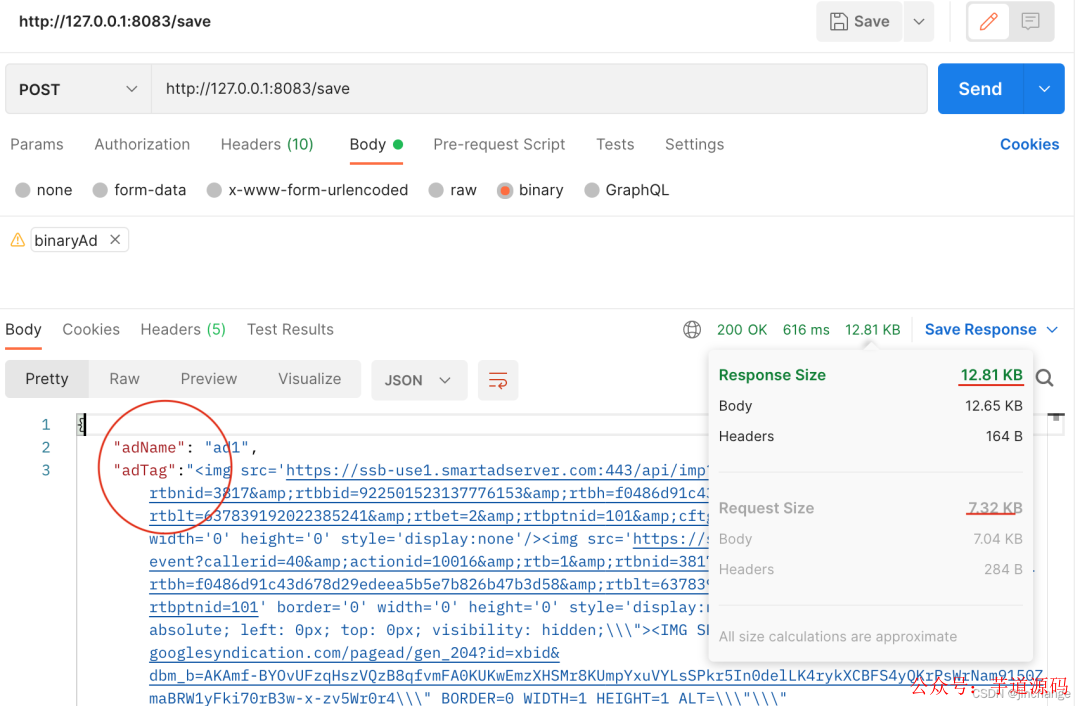

- adName是广告名字

- adTag是广告渲染的HTML代码,超级大数据库中都是用text类型来存放的,我看到最大的adTag足足有60kb大小…

{

"adName":"",

"adTag":""

}

因此,对与请求数据那么大的接口我们肯定是需要作一个优化的否则太大的数据传输有以下几个弊端:

为了克服这几个问题团队中的老鸟产生一个想法:

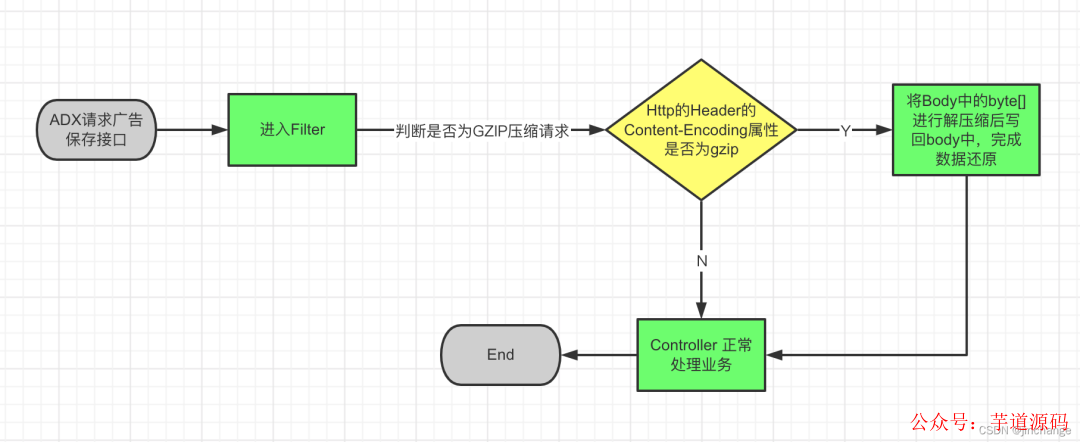

请求广告保存接口时先将Json对象字符串进行GZIP压缩,那请求时传入的就是压缩后的数据,而GZIP的压缩效率是很高的,因此可以大大减小传输数据,而当数据到达广告保存接口前再将传来的数据进行解压缩,还原成JSON对象就完成了整个GZIP压缩数据的请求以及处理流程。

其实这样做也存在着弊端:

-

请求变复杂了

- 接口调用方那边需要对数据进行压缩

- 接口执行方那边需要对拿到的数据进行解压

-

需要额外占用更多的CPU计算资源

-

可能会影响到原有的其他接口

对于以上几点基于我们公司当前的业务可以这样解决:

- 对与需要占用而外的CPU计算资源来说,公司的内部系统属于IO密集型应用,因此用一些CPU资源来换取更快的网络传输其实是很划算的

- 使用过滤器在请求数据到达Controller之前对数据进行解压缩处理后重新写回到Body中,避免影响Controller的逻辑,代码零侵入

- 而对于改造接口的同时是否会影响到原来的接口这一点可以通过 HttpHeader 的Content-Encoding=gzip属性来区分是否需要对请求数据进行解压缩

那废话少说,下面给出实现方案

基于 Spring Boot + MyBatis Plus + Vue & Element 实现的后台管理系统 + 用户小程序,支持 RBAC 动态权限、多租户、数据权限、工作流、三方登录、支付、短信、商城等功能

- 项目地址:https://github.com/YunaiV/ruoyi-vue-pro

- 视频教程:https://doc.iocoder.cn/video/

2. 实现思路

前置知识:

- Http 请求结构以及Content-Encoding 属性

- gzip压缩方式

- Servlet Filter

- HttpServletRequestWrapper

- Spring Boot

- Java 输入输出流

实现流程图:

核心代码:

创建一个SpringBoot项目,先编写一个接口,功能很简单就是传入一个Json对象并返回,以模拟将广告数据保存到数据库

/**

*@ClassName:ProjectController

*@Authorzhangjin

*@Date2022/3/2420:41

*@Description:

*/

@Slf4j

@RestController

publicclassAdvertisingController{

@PostMapping("/save")

publicAdvertisingsaveProject(@RequestBodyAdvertisingadvertising){

log.info("获取内容"+advertising);

returnadvertising;

}

}

/**

*@ClassName:Project

*@Authorzhangjin

*@Date2022/3/2420:42

*@Description:

*/

@Data

publicclassAdvertising{

privateStringadName;

privateStringadTag;

}

编写并注册一个拦截器

/**

*@ClassName:GZIPFilter

*@Authorzhangjin

*@Date2022/3/260:36

*@Description:

*/

@Slf4j

@Component

publicclassGZIPFilterimplementsFilter{

privatestaticfinalStringCONTENT_ENCODING="Content-Encoding";

privatestaticfinalStringCONTENT_ENCODING_TYPE="gzip";

@Override

publicvoidinit(FilterConfigfilterConfig)throwsServletException{

log.info("initGZIPFilter");

}

@Override

publicvoiddoFilter(ServletRequestservletRequest,ServletResponseservletResponse,FilterChainfilterChain)throwsIOException,ServletException{

longstart=System.currentTimeMillis();

HttpServletRequesthttpServletRequest=(HttpServletRequest)servletRequest;

StringencodeType=httpServletRequest.getHeader(CONTENT_ENCODING);

if(CONTENT_ENCODING_TYPE.equals(encodeType)){

log.info("请求:{}需要解压",httpServletRequest.getRequestURI());

UnZIPRequestWrapperunZIPRequestWrapper=newUnZIPRequestWrapper(httpServletRequest);

filterChain.doFilter(unZIPRequestWrapper,servletResponse);

}

else{

log.info("请求:{}无需解压",httpServletRequest.getRequestURI());

filterChain.doFilter(servletRequest,servletResponse);

}

log.info("耗时:{}ms",System.currentTimeMillis()-start);

}

@Override

publicvoiddestroy(){

log.info("destroyGZIPFilter");

}

}

/**

*@ClassName:FilterRegistration

*@Authorzhangjin

*@Date2022/3/260:36

*@Description:

*/

@Configuration

publicclassFilterRegistration{

@Resource

privateGZIPFiltergzipFilter;

@Bean

publicFilterRegistrationBeangzipFilterRegistrationBean() {

FilterRegistrationBeanregistration=newFilterRegistrationBean<>();

//Filter可以new,也可以使用依赖注入Bean

registration.setFilter(gzipFilter);

//过滤器名称

registration.setName("gzipFilter");

//拦截路径

registration.addUrlPatterns("/*");

//设置顺序

registration.setOrder(1);

returnregistration;

}

}

实现RequestWrapper实现解压和写回Body的逻辑

/**

*@ClassName:UnZIPRequestWrapper

*@Authorzhangjin

*@Date2022/3/2611:02

*@Description:JsonString经过压缩后保存为二进制文件->解压缩后还原成JsonString转换成byte[]写回body中

*/

@Slf4j

publicclassUnZIPRequestWrapperextendsHttpServletRequestWrapper{

privatefinalbyte[]bytes;

publicUnZIPRequestWrapper(HttpServletRequestrequest)throwsIOException{

super(request);

try(BufferedInputStreambis=newBufferedInputStream(request.getInputStream());

ByteArrayOutputStreambaos=newByteArrayOutputStream()){

finalbyte[]body;

byte[]buffer=newbyte[1024];

intlen;

while((len=bis.read(buffer))>0){

baos.write(buffer,0,len);

}

body=baos.toByteArray();

if(body.length==0){

log.info("Body无内容,无需解压");

bytes=body;

return;

}

this.bytes=GZIPUtils.uncompressToByteArray(body);

}catch(IOExceptionex){

log.info("解压缩步骤发生异常!");

ex.printStackTrace();

throwex;

}

}

@Override

publicServletInputStreamgetInputStream()throwsIOException{

finalByteArrayInputStreambyteArrayInputStream=newByteArrayInputStream(bytes);

returnnewServletInputStream(){

@Override

publicbooleanisFinished(){

returnfalse;

}

@Override

publicbooleanisReady(){

returnfalse;

}

@Override

publicvoidsetReadListener(ReadListenerreadListener){

}

publicintread()throwsIOException{

returnbyteArrayInputStream.read();

}

};

}

@Override

publicBufferedReadergetReader()throwsIOException{

returnnewBufferedReader(newInputStreamReader(this.getInputStream()));

}

}

附上压缩工具类

publicclassGZIPUtils{

publicstaticfinalStringGZIP_ENCODE_UTF_8="UTF-8";

/**

*字符串压缩为GZIP字节数组

*@paramstr

*@return

*/

publicstaticbyte[]compress(Stringstr){

returncompress(str,GZIP_ENCODE_UTF_8);

}

/**

*字符串压缩为GZIP字节数组

*@paramstr

*@paramencoding

*@return

*/

publicstaticbyte[]compress(Stringstr,Stringencoding){

if(str==null||str.length()==0){

returnnull;

}

ByteArrayOutputStreamout=newByteArrayOutputStream();

GZIPOutputStreamgzip;

try{

gzip=newGZIPOutputStream(out);

gzip.write(str.getBytes(encoding));

gzip.close();

}catch(IOExceptione){

e.printStackTrace();

}

returnout.toByteArray();

}

/**

*GZIP解压缩

*@parambytes

*@return

*/

publicstaticbyte[]uncompress(byte[]bytes){

if(bytes==null||bytes.length==0){

returnnull;

}

ByteArrayOutputStreamout=newByteArrayOutputStream();

ByteArrayInputStreamin=newByteArrayInputStream(bytes);

try{

GZIPInputStreamungzip=newGZIPInputStream(in);

byte[]buffer=newbyte[256];

intn;

while((n=ungzip.read(buffer))>=0){

out.write(buffer,0,n);

}

}catch(IOExceptione){

e.printStackTrace();

}

returnout.toByteArray();

}

/**

*解压并返回String

*@parambytes

*@return

*/

publicstaticStringuncompressToString(byte[]bytes)throwsIOException{

returnuncompressToString(bytes,GZIP_ENCODE_UTF_8);

}

/**

*

*@parambytes

*@return

*/

publicstaticbyte[]uncompressToByteArray(byte[]bytes)throwsIOException{

returnuncompressToByteArray(bytes,GZIP_ENCODE_UTF_8);

}

/**

*解压成字符串

*@parambytes压缩后的字节数组

*@paramencoding编码方式

*@return解压后的字符串

*/

publicstaticStringuncompressToString(byte[]bytes,Stringencoding)throwsIOException{

byte[]result=uncompressToByteArray(bytes,encoding);

returnnewString(result);

}

/**

*解压成字节数组

*@parambytes

*@paramencoding

*@return

*/

publicstaticbyte[]uncompressToByteArray(byte[]bytes,Stringencoding)throwsIOException{

if(bytes==null||bytes.length==0){

returnnull;

}

ByteArrayOutputStreamout=newByteArrayOutputStream();

ByteArrayInputStreamin=newByteArrayInputStream(bytes);

try{

GZIPInputStreamungzip=newGZIPInputStream(in);

byte[]buffer=newbyte[256];

intn;

while((n=ungzip.read(buffer))>=0){

out.write(buffer,0,n);

}

returnout.toByteArray();

}catch(IOExceptione){

e.printStackTrace();

thrownewIOException("解压缩失败!");

}

}

/**

*将字节流转换成文件

*@paramfilename

*@paramdata

*@throwsException

*/

publicstaticvoidsaveFile(Stringfilename,byte[]data)throwsException{

if(data!=null){

Stringfilepath="/"+filename;

Filefile=newFile(filepath);

if(file.exists()){

file.delete();

}

FileOutputStreamfos=newFileOutputStream(file);

fos.write(data,0,data.length);

fos.flush();

fos.close();

System.out.println(file);

}

}

基于 Spring Cloud Alibaba + Gateway + Nacos + RocketMQ + Vue & Element 实现的后台管理系统 + 用户小程序,支持 RBAC 动态权限、多租户、数据权限、工作流、三方登录、支付、短信、商城等功能

3. 测试效果

注意一个大坑:千万不要直接将压缩后的byte[]当作字符串进行传输,否则你会发现压缩后的请求数据竟然比没压缩后的要大得多!一般有两种传输压缩后的byte[]的方式:

- 将压缩后的byet[]进行base64编码再传输字符串,这种方式会损失掉一部分GZIP的压缩效果,适用于压缩结果要存储在Redis中的情况

- 将压缩后的byte[]以二进制的形式写入到文件中,请求时直接在body中带上文件即可,用这种方式可以不损失压缩效果

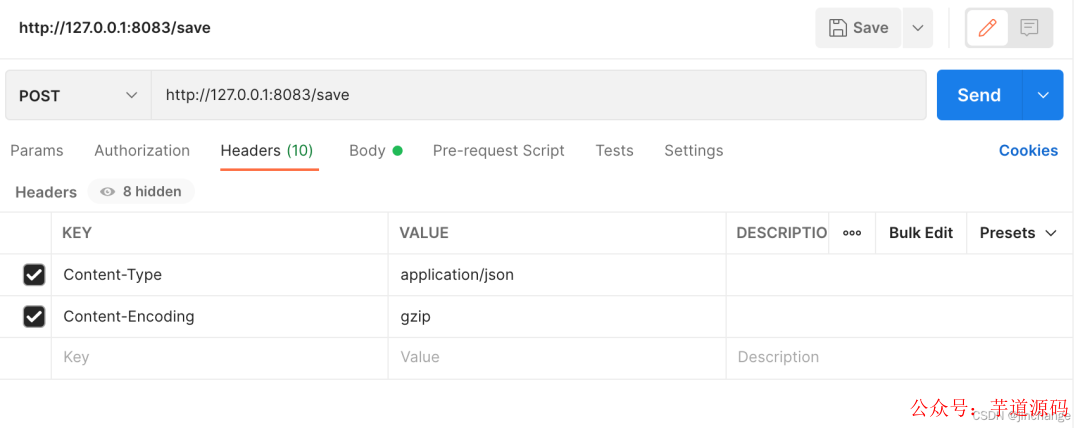

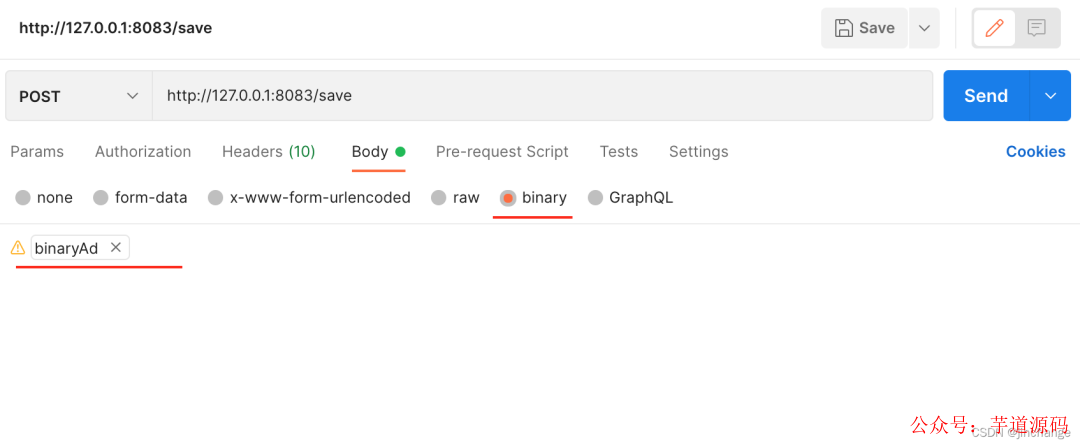

Postman测试Gzip压缩数据请求:

- 请求头指定数据压缩方式:

- Body带上压缩后的byte[]写入的二进制文件

- 执行请求,服务端正确处理了请求并且请求size缩小了将近一半,效果还是很不错的,这样GZIP压缩数据的请求的处理就完成了,完整的项目代码在下方

4. Demo地址

- https://gitee.com/wx_1bceb446a4/gziptest

审核编辑 :李倩

-

spring

+关注

关注

0文章

340浏览量

14343 -

传输数据

+关注

关注

1文章

122浏览量

16103 -

大数据

+关注

关注

64文章

8889浏览量

137439

原文标题:Spring Boot + Filter 实现 Gzip 压缩超大 json 对象,传输耗时大大减少

文章出处:【微信号:芋道源码,微信公众号:芋道源码】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

校园点餐订餐外卖跑腿Java源码

SSM开发环境的搭建教程 SSM与Spring Boot的区别

Spring 应用合并之路(二):峰回路转,柳暗花明

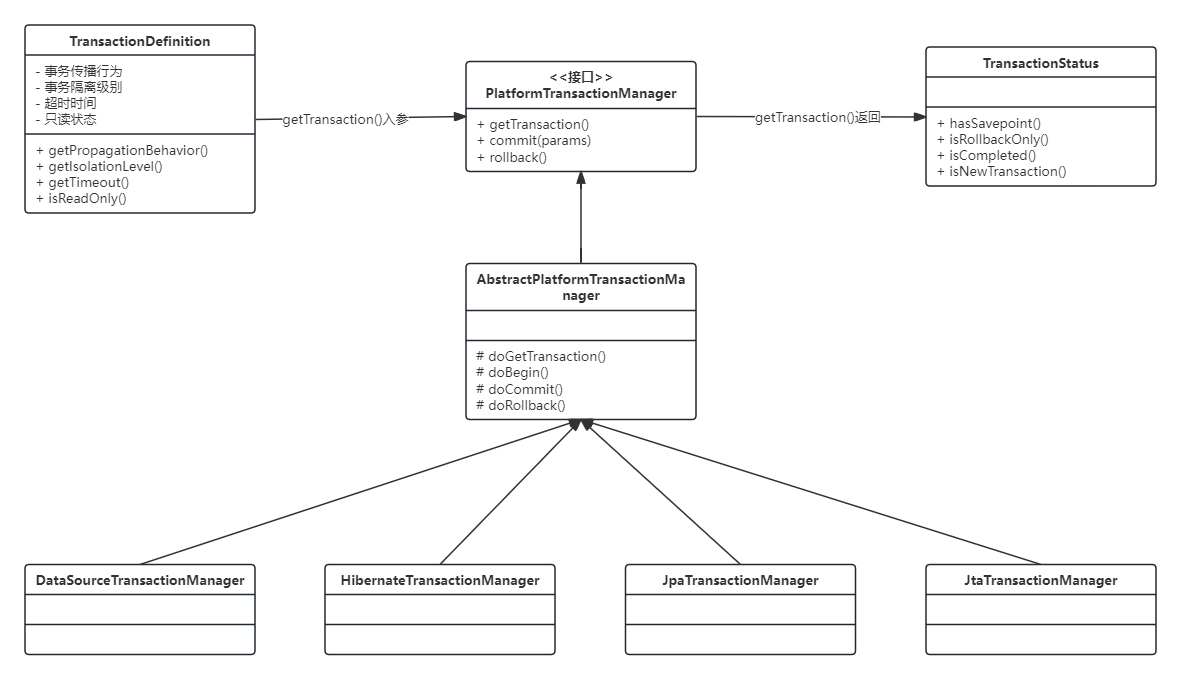

Spring事务实现原理

如何使用gzip压缩和解压缩技术

JSON协议是什么,物联网中的RTU中如何使用JSON协议和服务器交互

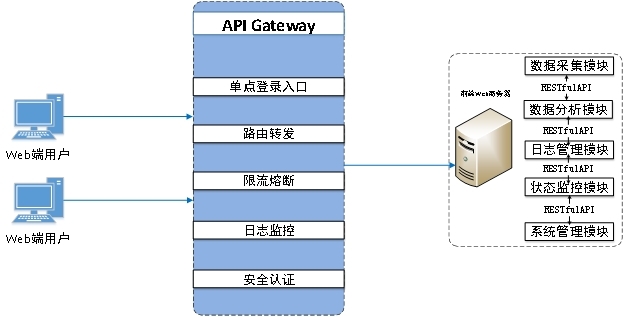

Spring Cloud Gateway网关框架

单片机boot0和boot1怎么设置

vue+spring boot人员定位系统源码,实现实时定位、智慧调度、轨迹追踪

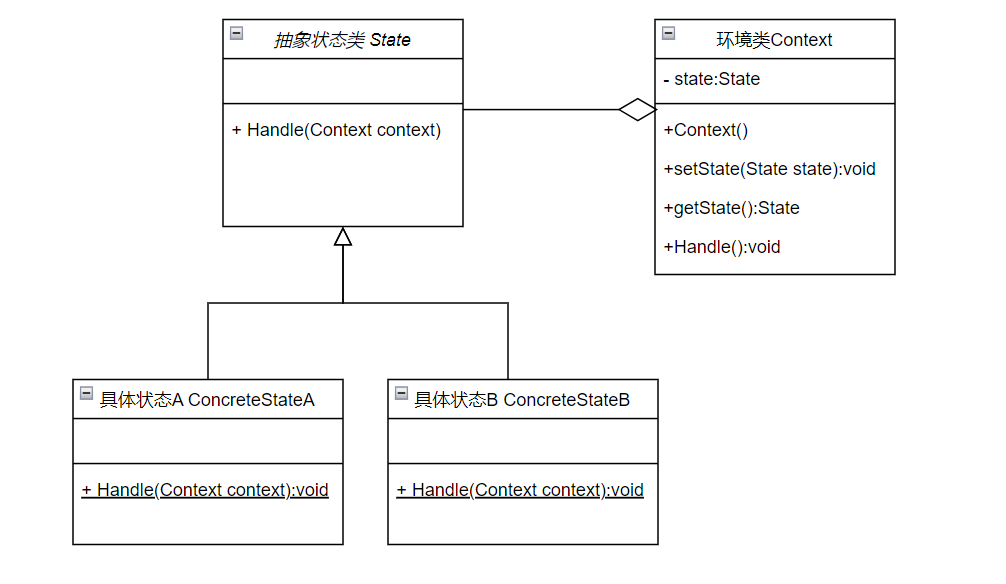

玩转Spring状态机

UWB室内外高精度一体化融合定位系统源码 UWB技术定位系统应用场景 Java+Spring boot+MYSQL 技术开发

PLC设备通过智能网关采用HTTP协议JSON文件对接MES、ERP等系统平台

Python压缩和解压缩实现代码分享

使用Spring Boot 3.2虚拟线程搭建静态文件服务器

Spring Boot+Filter实现Gzip压缩超大json对象

Spring Boot+Filter实现Gzip压缩超大json对象

评论