01、背景

作为计算机视觉中的一项基础任务,目标检测受到了广泛的关注。在恶劣的天气下,尤其是在雾天环境下,大气中存在很多浑浊介质(如颗粒、水滴等),传统相机可见光难以穿透颗粒介质,因此恶劣天气下的数据非常罕见,现有的检测架构依赖于未失真的传感器流,而恶劣天气下传感器会产生非对称的失真,使得户外场景图像出现退化和降质,清晰度低和对比度低,细节特征模糊不清等特点,对于在高质量图像下训练的目标检测模型,往往无法准确的定位目标,是当前目标检测任务中的一大挑战,同时也是当前如何在复杂天气环境下进行视觉自主导航的一大挑战。为解决这个问题,Bijelic提出了一个新的多模式数据集,该数据集是在北欧10,000 多公里的行驶中获得的。此数据集是恶劣天气下的第一个大型的多模式数据集,且具有10 万个激光雷达、相机、雷达和门控NIR传感器的标签。同时Bijelic提出了一种深层融合网络,可进行稳健的融合,而无需涵盖所有非对称失真的大量标记训练数据。从提议级融合出发,提出了一种由测量熵驱动的自适应融合特征的单镜头模型。

02、数据集介绍

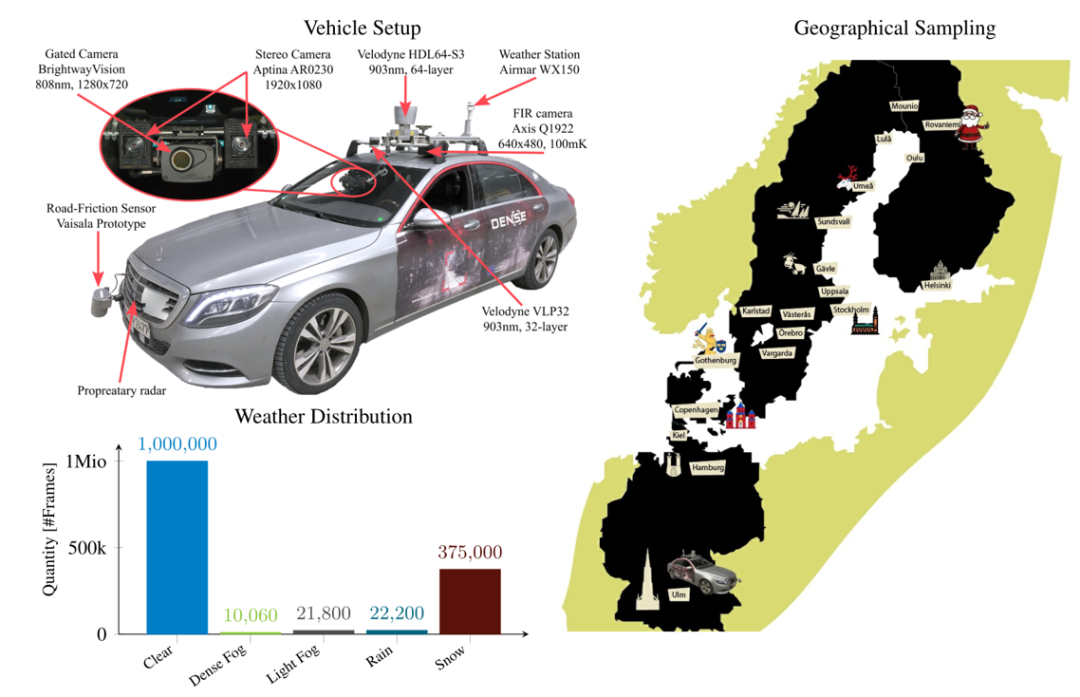

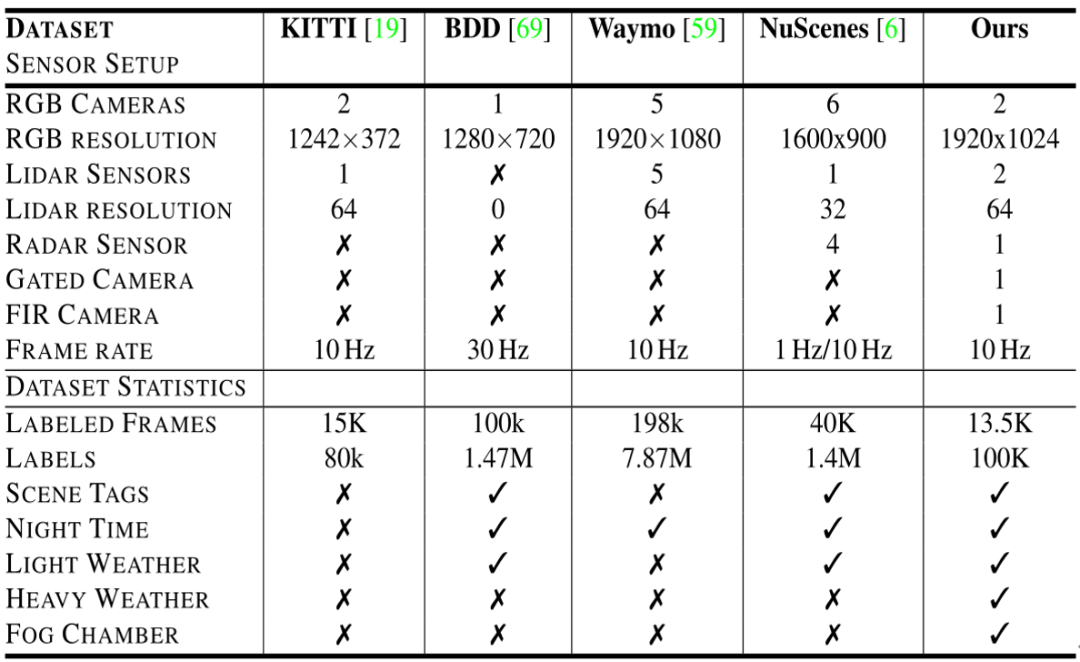

为了评估恶劣天气中的目标检测,Bijelic进行了实地测试,构建了一个大型的汽车数据集,该数据集提供了用于多模式数据的2D 和3D 检测边界框,并对罕见恶劣天气情况下的天气,光照和场景类型进行了精细分类。表中比较了提出的数据集和最近的大规模汽车数据集,例如Waymo,NuScenes,KITTI和BDD数据集。与NuScenes和BDD相比,该数据集不仅包含在晴朗天气条件下的实验数据,还包含在大雪,雨天和雾中的实验数据。

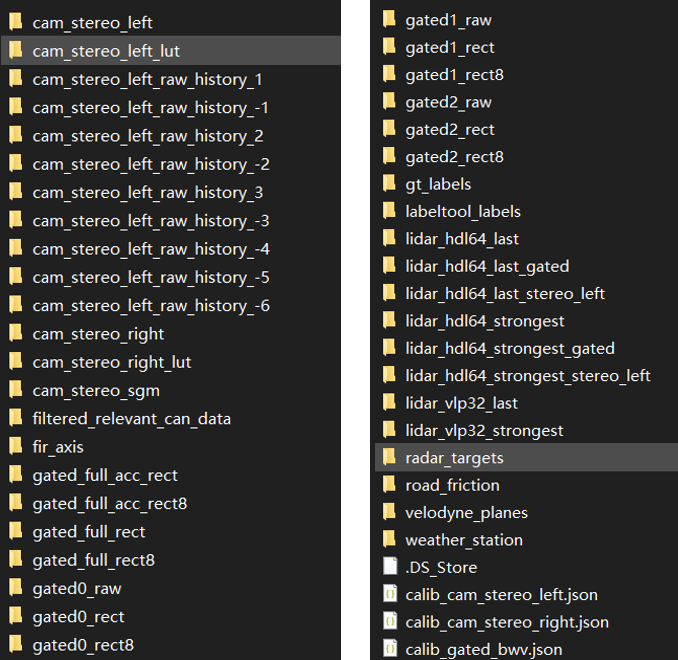

所有实验数据分别在德国,瑞典,丹麦和芬兰获得,在不同的天气和光照条件下覆盖了10,000km 的距离。以10Hz 的帧速率共收集了140 万帧。每第100 帧都经过手动标记,以平衡场景类型的覆盖范围。生成的注释包含5500个晴天,1000个浓雾,1 000个薄雾,4000个雪/雨。本数据集具体包含文件如下图所示。

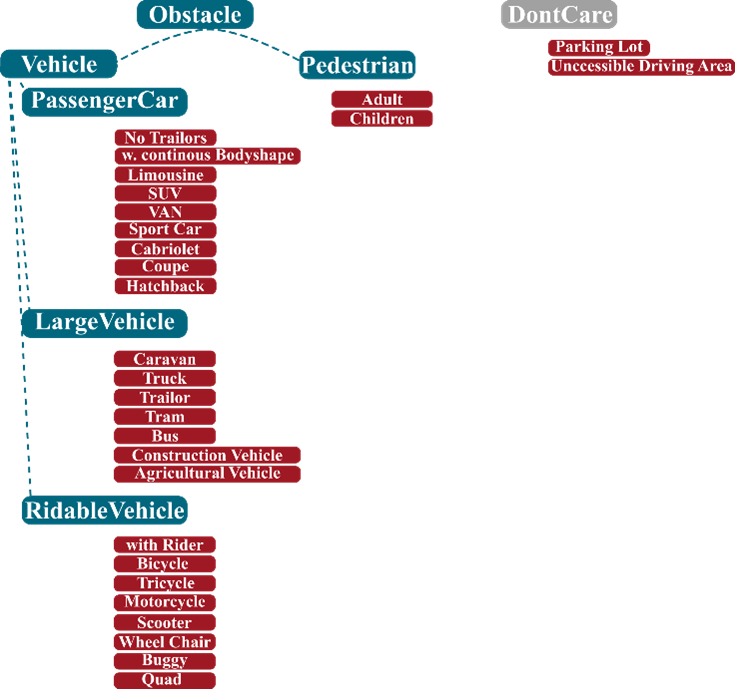

对于该数据集的使用,目前由于作者还未开源融合网络,暂时只能使用源数据,但是也算为后续恶劣天气下的多传感器融合3D目标检测提供了真实环境下的数据集。若仅针对于纯图像2D目标检测或3D检测来说,该数据集中可用于验证作用,或者以混合数据形式作为训练集,但是仅使用该数据集做为验证和训练可能不足以支撑网络学习。正如下图数据集具体标签所示,其标签主要包括五类,蓝色为注释标签,红色为该标签所包括的类别。注意若使用该数据集为训练集,其他数据集为验证集要重新归一标签,与其他数据集标签重合度较低,重新清洗数据也是使用该数据集的一个难点。

03、自适应多模式单次融合

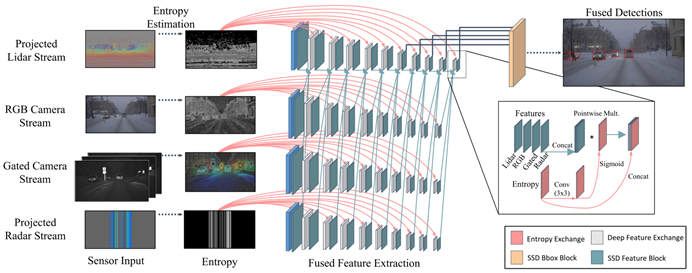

1、网络架构

数据表示。相机分支使用常规的三平面RGB 输入,而对于激光雷达和雷达分支,本文的方法与最近的鸟瞰(BeV)投影方案或原始点云表示不同。BeV 投影或点云输入不允许进行深度的早期融合,因为早期图层中的特征表示与相机特征天生不同。因此,现有的BeV 融合方法只能在建议匹配区域之后进行提升空间中的特征融合,而不能提前。图中可视化了本文提出的输入数据编码,该编码有助于进行深度多模态融合。深度,高度和脉冲强度作为激光雷达网络的输入,而不是仅使用朴素的深度输入编码。对于雷达网络,假设雷达在与图像平面正交和与水平图像尺寸平行的2D 平面中进行扫描。因此,考虑沿垂直图像轴雷达的不变性,并沿垂直轴复制扫描。使用单应性映射将门控图像转换为RGB 相机的图像平面。本文所提出的输入编码使用不同流之间的逐像素对应,可以实现与位置和强度相关的融合,用零值来编码缺失的测量样本。

特征提取。作为每个流中的特征提取堆栈,本文使用了改进的VGG主干。将通道数量减少一半,并在conv4 层上切断网络,使用conv4-10中的六个要素层作为SSD 检测层的输入。特征图随尺寸减小,实现了一个用于不同比例检测的特征金字塔。如结构图所示,不同特征提取堆栈的激活进行了交换。为了使融合更加可靠,为每个特征交换块提供了传感器熵。首先对熵进行卷积,应用Sigmoid与来自所有传感器的级联输入特征相乘,最后级联输入熵。熵的折叠和Sigmoid的应用在区间[0,1] 中生成一个乘法矩阵,这可以根据可用信息分别缩放每个传感器的级联特征。具有低熵的区域可以被衰减,而富熵的区域可以在特征提取中被放大。这样能够在特征提取堆栈中实现自适应融合特征

2、实验

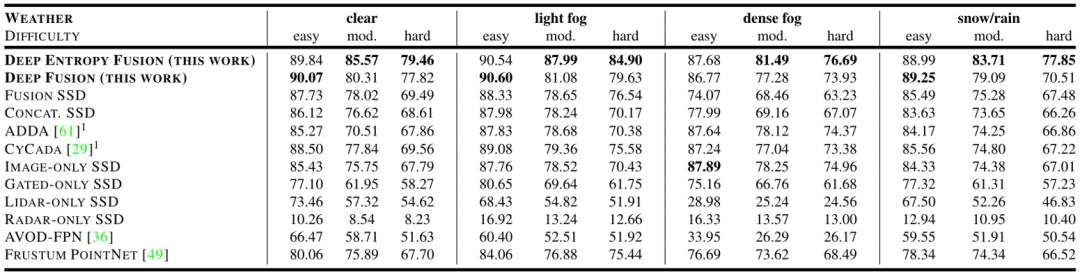

在恶劣天气的实验测试数据上验证所提出的融合模型。将这种方法与现有的单传感器输入和融合的检测器,以及域自适应方法进行比较。由于训练数据获取存在天气偏向,仅使用提出的数据集的晴朗天气部分进行训练,使用Bijelic提出新的多模式天气数据集作为测试集来评估检测性能。结果如图所示。

总体而言,由图中可看到随着雾密度的增加,特别是在严重失真的情况下,该文所提出的自适应融合模型的性能优于所有其他方法,与次佳的特征融合变体相比,它提高了9.69%的幅度。但是在有雾条件下,激光雷达的性能也同样具有很大的局限性,在仅激光雷达情况下的检测率,AP下降了45.38%。此外,它还对相机-激光雷达融合模型AVOD,Concat SSD 和Fusion SSD产生了重大影响。它使得学习到的冗余不再成立,这些方法甚至低于仅使用图像的方法。

04、结论

所提出的数据集解决了自动驾驶中的一个关键问题:场景中的多传感器融合和其中注释数据稀少且由于自然的天气偏向而难以获取的图像数据。为后续的研究者引入了一个新颖的恶劣天气数据集,涵盖了不同天气情况下的相机、激光雷达、雷达、门控NIR 和FIR 传感器数据。同时提出的一个实时的深度多模态融合网络不同于提案层的融合,而是由测量熵驱动自适应融合。

该方法一定程度上改进恶劣天气条件下智能自主驾驶车辆在户外环境下进行精确的视觉感知能力,同时也能为后续视觉导航在复杂天气环境下进行精确建图提供高精度的目标定位。

虽然该数据集提出一定程度上填补了多模态数据集的缺失,但是由于自然偏向的问题,恶劣天气采集到的图像还是较少,仍然不适用于网络的训练,如何解决恶劣天气条件下数据集稀少或者降低深度学习网络对于数据样本的依赖性仍亟待改进。

审核编辑:郭婷

-

传感器

+关注

关注

2552文章

51228浏览量

754653 -

计算机

+关注

关注

19文章

7519浏览量

88202 -

数据集

+关注

关注

4文章

1208浏览量

24737

原文标题:基于多模态自适应熵驱动融合的恶劣天气自动驾驶视觉感知技术研究

文章出处:【微信号:vision263com,微信公众号:新机器视觉】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NaVILA:加州大学与英伟达联合发布新型视觉语言模型

Xsens Sirius-在严苛环境中进行3D惯性导航

导航分析仪的技术原理和应用场景

复杂环境下多无人智能车辆协同调控

Bumblebee X 立体相机提升工业自动化中的立体深度感知

agv叉车激光导航和二维码导航有什么区别?适用什么场景?选哪种比较好?

SLAM:机器人如何在未知地形环境中进行导航

如何在不同应用场景下构建音频测试环境

如何在复杂天气环境下进行视觉自主导航

如何在复杂天气环境下进行视觉自主导航

评论