电子发烧友网报道(文/周凯扬)在近期举办的Re:Invent大会上,亚马逊为其AWS云服务公布了上线全新的EC2实例,分别是C7gn、HPC7g和R7iz。R7iz用到了英特尔最新的第四代Xeon Scalable处理器Sapphire Rapids,而HPC7g则是由新处理器Graviton3E来驱动的。与此同时,AWS还在本次会议上公布了第五代Nitro芯片Nitro v5和第二代推理芯片AWS Inferentia 2,其中Graviton3E和Nitro v5都是基于Arm架构打造的。

性能更上一层楼的Graviton3E

在HPC领域,Arm的出镜率还是比较低的,除了像富岳超算这样的顶级存在外,我们很少看到云服务厂商基于Arm芯片来打造HPC计算集群,Graviton的出现可谓改变了这一点。AWS在2020年推出的C6gn实例,就是基于其Graviton2处理器打造的,相较基于第二代AMD EPYC处理器的C5实例,C6gn做到了成本低上20%,性能却高上40%的表现。

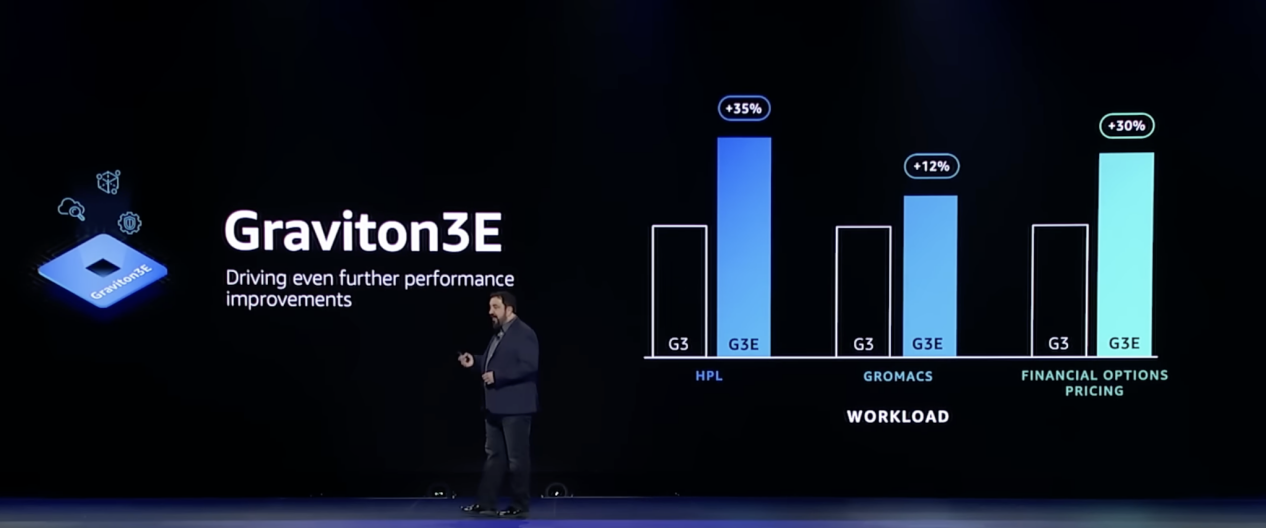

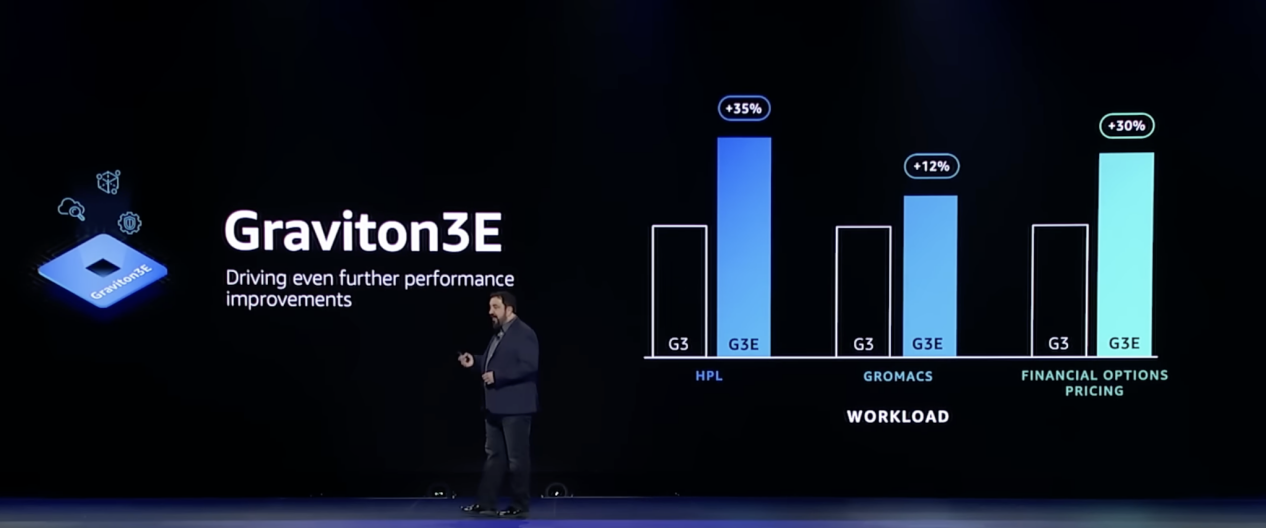

Graviton3E在不同负载下的性能提升 / 亚马逊

根据亚马逊给出的数据,Graviton3E在Graviton3的基础上再加改良,以测试浮点性能的基准HPL为例,Graviton3E将矢量指令处理性能再度提高了35%。而HPC7g实例相比基于Graviton2的C6gn实例,更是将浮点性能拔高至两倍,比基于第3代AMD EPYC 7003系列48核处理器的HPC6a实例,性能上也能高出20%,可以说是AWS上性价比最高的HPC实例了。

如今的亚马逊已经有了100多个不同的Graviton实例,供使用者灵活选择。而且让Graviton充分发挥作用的不仅是AWS EC2这样的弹性计算云服务,还有Fargate这样无需管理实例的服务,也获得了不小的性能提升。

然而对于大部分云服务厂商来说,他们首推的实例很多依然是基于x86的,这不禁让人深思,真的会有大型公司选择了Arm服务器芯片吗?亚马逊给出了肯定的答案,也介绍了Graviton极快的普及速度。

从亚马逊给出的合作伙伴中,我们可以看到大宇无限、Epic、Lyft、Zoom等公司,都选了围绕Graviton芯片来构造他们的产品服务。比如美国电视串流服务DirectTV在使用Graviton 3的实例后,成本减少了20%的同时,延迟也有了最高50%的降低,使得他们能在访问流量变化巨大的同时灵活扩展容量,还能保证性能不受影响。

加剧DPU和AI芯片内卷的Nitro和Inferentia

对于多数超大规模数据中心和云服务厂商来说,他们的DPU往往来自第三方,比如英伟达的BlueField、AMD的Pensando等,而亚马逊旗下的Annapurna Labs,则成了AWS DPU产品的Nitro的幕后功臣。

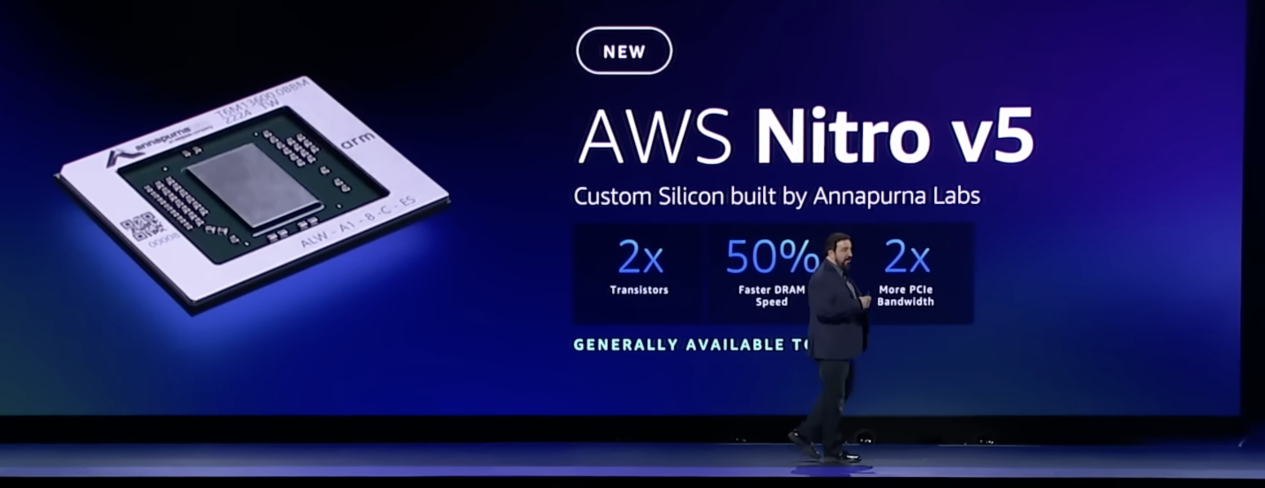

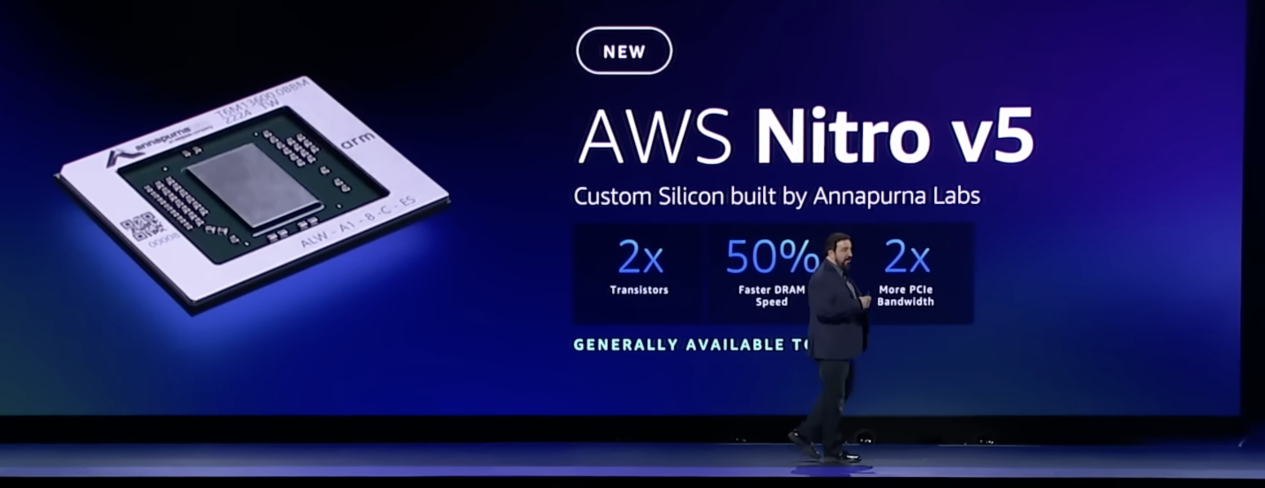

Nitro v5芯片 / 亚马逊

而这次Annapurna Labs设计的Nitro v5在性能上再度实现了飞跃,亚马逊展示的数据上提到,Nitro v5相较上一代集成了两倍的晶体管数目,在算力上提升近两倍,拥有快上50%的DRAM速度,PCIe带宽也提升至两倍。由此可以看出,Nitro v5应该选择了更先进的工艺,DRAM和PCIe也换成了最新一代。

在实际测试中,Nitro v5可以提高最多60%的吞吐量,降低30%的延迟,在能效比上也有了40%的提升。正是因为有着这样强大的性能,AWS选择了将其集成到C7gn、HPC7g实例中去,与Graviton3和Graviton3E一起实现200Gbps的超高网络性能。

大型语言模型的出现推动深度学习进入了下一个阶段,但庞大的参数量加大了推理所需的算力和成本。2019年,AWS的Inferentia芯片第一代出现在Inf1实例上,为用户提供了性价比优于GPU实例的选项,但彼时的深度学习模型还大多数停留在数百万个,如今某些深度学习模型的参数已经超过了数百亿,比如百度的PLATO-XL对话生成模型、亚马逊的AlexaTM等。

为此,Annapurna Labs拿出了全新的Inferentia2芯片,最高可支持到1750亿参数的大型深度学习模型。基于Inferentia2芯片的Inf2实例也首次支持到分布式推理,将大型模型分布到多个芯片上进行推理。与上一代Inf1实例相比,Inf2可以提供高达4倍的吞吐量和10分之一的延迟,与GPU实例相比更是将能效提高了50%之多。

小结

这样频繁的芯片发布节奏,足以看出亚马逊在自研服务器芯片上已经到了一个新的高度。不得不承认,亚马逊早在2016年就收购Annapurna Labs是一个多么具有前瞻性的战略决策,在云服务厂商竞争愈演愈烈的当下,拥有自研可控的服务器芯片无疑是杀手锏。虽然谷歌、阿里巴巴等厂商也都加入到了自研服务器芯片的行列中来,但与亚马逊的AWS相比,在产品阵容和布局时间上还是有所差距。

性能更上一层楼的Graviton3E

在HPC领域,Arm的出镜率还是比较低的,除了像富岳超算这样的顶级存在外,我们很少看到云服务厂商基于Arm芯片来打造HPC计算集群,Graviton的出现可谓改变了这一点。AWS在2020年推出的C6gn实例,就是基于其Graviton2处理器打造的,相较基于第二代AMD EPYC处理器的C5实例,C6gn做到了成本低上20%,性能却高上40%的表现。

Graviton3E在不同负载下的性能提升 / 亚马逊

根据亚马逊给出的数据,Graviton3E在Graviton3的基础上再加改良,以测试浮点性能的基准HPL为例,Graviton3E将矢量指令处理性能再度提高了35%。而HPC7g实例相比基于Graviton2的C6gn实例,更是将浮点性能拔高至两倍,比基于第3代AMD EPYC 7003系列48核处理器的HPC6a实例,性能上也能高出20%,可以说是AWS上性价比最高的HPC实例了。

如今的亚马逊已经有了100多个不同的Graviton实例,供使用者灵活选择。而且让Graviton充分发挥作用的不仅是AWS EC2这样的弹性计算云服务,还有Fargate这样无需管理实例的服务,也获得了不小的性能提升。

然而对于大部分云服务厂商来说,他们首推的实例很多依然是基于x86的,这不禁让人深思,真的会有大型公司选择了Arm服务器芯片吗?亚马逊给出了肯定的答案,也介绍了Graviton极快的普及速度。

从亚马逊给出的合作伙伴中,我们可以看到大宇无限、Epic、Lyft、Zoom等公司,都选了围绕Graviton芯片来构造他们的产品服务。比如美国电视串流服务DirectTV在使用Graviton 3的实例后,成本减少了20%的同时,延迟也有了最高50%的降低,使得他们能在访问流量变化巨大的同时灵活扩展容量,还能保证性能不受影响。

加剧DPU和AI芯片内卷的Nitro和Inferentia

对于多数超大规模数据中心和云服务厂商来说,他们的DPU往往来自第三方,比如英伟达的BlueField、AMD的Pensando等,而亚马逊旗下的Annapurna Labs,则成了AWS DPU产品的Nitro的幕后功臣。

Nitro v5芯片 / 亚马逊

而这次Annapurna Labs设计的Nitro v5在性能上再度实现了飞跃,亚马逊展示的数据上提到,Nitro v5相较上一代集成了两倍的晶体管数目,在算力上提升近两倍,拥有快上50%的DRAM速度,PCIe带宽也提升至两倍。由此可以看出,Nitro v5应该选择了更先进的工艺,DRAM和PCIe也换成了最新一代。

在实际测试中,Nitro v5可以提高最多60%的吞吐量,降低30%的延迟,在能效比上也有了40%的提升。正是因为有着这样强大的性能,AWS选择了将其集成到C7gn、HPC7g实例中去,与Graviton3和Graviton3E一起实现200Gbps的超高网络性能。

大型语言模型的出现推动深度学习进入了下一个阶段,但庞大的参数量加大了推理所需的算力和成本。2019年,AWS的Inferentia芯片第一代出现在Inf1实例上,为用户提供了性价比优于GPU实例的选项,但彼时的深度学习模型还大多数停留在数百万个,如今某些深度学习模型的参数已经超过了数百亿,比如百度的PLATO-XL对话生成模型、亚马逊的AlexaTM等。

为此,Annapurna Labs拿出了全新的Inferentia2芯片,最高可支持到1750亿参数的大型深度学习模型。基于Inferentia2芯片的Inf2实例也首次支持到分布式推理,将大型模型分布到多个芯片上进行推理。与上一代Inf1实例相比,Inf2可以提供高达4倍的吞吐量和10分之一的延迟,与GPU实例相比更是将能效提高了50%之多。

小结

这样频繁的芯片发布节奏,足以看出亚马逊在自研服务器芯片上已经到了一个新的高度。不得不承认,亚马逊早在2016年就收购Annapurna Labs是一个多么具有前瞻性的战略决策,在云服务厂商竞争愈演愈烈的当下,拥有自研可控的服务器芯片无疑是杀手锏。虽然谷歌、阿里巴巴等厂商也都加入到了自研服务器芯片的行列中来,但与亚马逊的AWS相比,在产品阵容和布局时间上还是有所差距。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

亚马逊

+关注

关注

8文章

2651浏览量

83327

发布评论请先 登录

相关推荐

亚马逊启动“登月”计划,目标部署10万颗自研AI芯片

:Trainium2,目标是在亚马逊自己的数据中心里部署10万颗Trainium2,以提高数据处理效率并降低AI芯片采购成本。 近几年,亚马逊一直都在致力于自

比亚迪最快于11月实现自研算法量产,推进智驾芯片自研进程

10月21日市场传出消息,比亚迪正计划整合其新技术院下的自研智能驾驶团队,目标是在今年11月实现自研智能驾驶算法的量产,并持续推进智能驾驶芯片

独立服务器与云服务器的区别

随着互联网技术的飞速发展,企业对于服务器的需求日益增加,而服务器市场也随之出现了多种类型的产品,其中最常见的是独立服务器和云服务器。这两种服务器

亚马逊AWS自研AI芯片崛起,挑战英伟达

近期,据路透社独家报道披露,在德克萨斯州奥斯汀市一处紧密防守的芯片实验室中,六位来自亚马逊AWS的工程师正在对一种尚未公开透露名称及详细参数的新型服务器展开深入测试。这一关键事件引人注

亚马逊正测试一款融入AI芯片的新型服务器设计

在得克萨斯州奥斯汀的秘密芯片实验室中,亚马逊正紧锣密鼓地测试一款高度保密的新型服务器设计,该设计融入了亚马逊自主研发的AI芯片,旨在与业界巨

云服务器和虚拟服务器的区别是什么

云服务器和虚拟服务器是两种常见的服务器类型,它们在很多方面有相似之处,但也有一些关键的区别。本文将详细介绍云服务器和虚拟服务器的区别,包括它

苹果计划搭建自研芯片驱动的AI数据中心

据内部人士透露,苹果已将自研芯片应用于云计算服务器,用以支持其设备未来的高级AI服务。目前我们尚未收到苹果方面对此事的回应。

高通自研服务器芯片"SD1"揭晓,核心搭载Oryon

据国外科技媒体Android Authority透露,高通公司在公布骁龙X Elite / Plus芯片之后,内部正在研发代号为“SD1”、内置Oryon处理器的服务器芯片。

苹果自研AI服务器芯片,预计2025年台积电3nm工艺

4 月 24 日,知名数码博主@手机晶片达人发布动态,爆料苹果正研发自家 AI 服务器芯片,预计 2025 年下半年量产,采用台积电 3nm 制程。

服务器远程不上服务器怎么办?服务器无法远程的原因是什么?

产生问题的原因,检查硬盘和服务器系统。通过日志和检查数据来确认问题出

现的原因以及如何解决。

三、端口问题

1.端口错误

找回正确的端口或更换远程端口

2.端口被扫爆

更改端口,并在防火墙禁止扫爆的IP

发表于 02-27 16:21

linux服务器和windows服务器

Linux服务器和Windows服务器是目前应用最广泛的两种服务器操作系统。两者各有优劣,也适用于不同的应用场景。本文将

对Linux服务器和Windows

发表于 02-22 15:46

微软正在研发新型网卡,旨在提升自研AI芯片性能

微软近日被曝正在秘密研发一款高性能的新型网卡,这一创新旨在增强其自研的Maia AI服务器芯片的功能,并可能大幅度降低对外部芯片设计厂商如英

再发三大服务器芯片,自研实力愈发强悍的亚马逊

再发三大服务器芯片,自研实力愈发强悍的亚马逊

评论