导航是一个内容丰富、基础扎实的问题领域,它推动了许多不同领域的研究进展:尤其是感知、计划、记忆、探索和优化。从历史上看,这些挑战都是单独考虑的,并且建立的解决方案依赖于固定的数据集——例如,通过环境的记录轨迹。然而,这些数据集不能用于决策和强化学习,总的来说,导航作为一项交互式的学习任务,其中学习agent的行动和行为是与感知和规划同时学习的,这一观点相对来说没有得到支持。因此,现有的导航基准测试通常依赖于静态数据集(Geiger等人,2013;Kendall等人,2015)或模拟器(Beattie等人,2016;Shah等人,2018年)。为了支持和验证端到端导航的研究,我们提出了StreetLearn:一个交互式的、第一人称的、部分观察的视觉环境,使用谷歌街景的照片内容和广泛的覆盖范围,并给出了一个具有挑战性的目标驱动的导航任务的性能基线。

I.简介

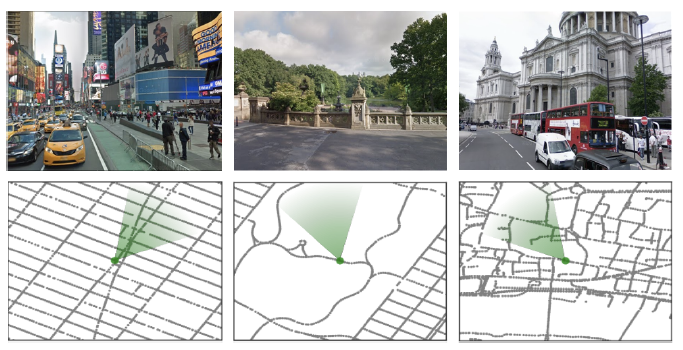

图1 l 我们的环境是由来自StreetView的真实世界的地方建立的。图中显示了纽约市(时代广场、中央公园)和伦敦(圣保罗大教堂)的不同景观和相应的本地地图。绿色的圆锥体代表agent的位置和方向。

导航这一课题对各种研究学科和技术领域都具有吸引力,是希望破解网格和位置细胞密码的神经科学家的研究课题(Banino等人,2018;Cueva和Wei, 2018), 同时也是机器人研究的一个基本方面,希望建造可以到达给定目的地的移动机器人。大多数导航算法涉及在探索阶段建立一个明确的地图,然后通过该表征进行规划和行动。 最近,研究人员试图通过探索和与环境的互动来直接学习导航策略,例如使用端到端的深度强化学习(Lample和Chaplot,2017;Mirowski等人,2017;Wu等人,2018;Zhu等人,2017)。 为了支持这项研究,我们设计了一个名为StreetLearn的互动环境,使用谷歌街景的图像和基础连接信息(见图1),包括匹兹堡和纽约市的两个大区域。该环境以高分辨率的摄影图片为特色,展示了多样化的城市环境,并以真实的街道连接图跨越了城市规模的区域。 在这个环境中,我们开发了几个穿越任务,要求agent从一个目标到另一个目标进行长距离的导航。

其中一项任务在现实世界中类似于一个在特定城市工作的速递员,他从一个被称为 "A "的任意地点开始,然后被指示去一个用绝对坐标定义的特定地点"B",但他从来没有被告知这些地点的地图或从A到B的路径,或被告知自己的位置。 另一项任务是模仿谷歌地图,遵循由自然语言导航指示和图像缩略图组成的一步一步的指示。额外的导航任务可以在StreetLearn环境中开发。 我们在第2节中描述了数据集、环境和任务,在第3节中解释了环境代码,在第4节中描述了已实施的方法和基线方法,在第5节中描述了结果,在第6节中详细介绍了相关工作。 II.环境

本节介绍了StreetLearn,一个利用谷歌街景构建的互动环境。由于街景数据是在全球范围内收集的,并且包括高分辨率图像和图表连接,因此它是研究导航的宝贵资源。

街景提供了一组地理定位的360°全景图像,这些图像构成了一个无向图的节点(我们交替使用节点和全景这一术语)。我们选择了纽约市和匹兹堡的一些地区。纽约市可供下载的地区是曼哈顿第81街以南的地区。

这包括在一个由(40.695,-74.028)和(40.788,-73.940)定义的长/宽边界框内的近似56K全景图像。请注意,布鲁克林、皇后区、罗斯福岛以及曼哈顿的桥梁和隧道都不包括在内,我们只包括曼哈顿海滨和第79/81街的多边形内的全景图,覆盖面积为31.6平方公里。匹兹堡数据集包括58K张图像,由(40.425, -80.035)和(40.460, -79.930)之间的经度/纬度边界框来定义,覆盖8.9公里乘3.9公里的区域。

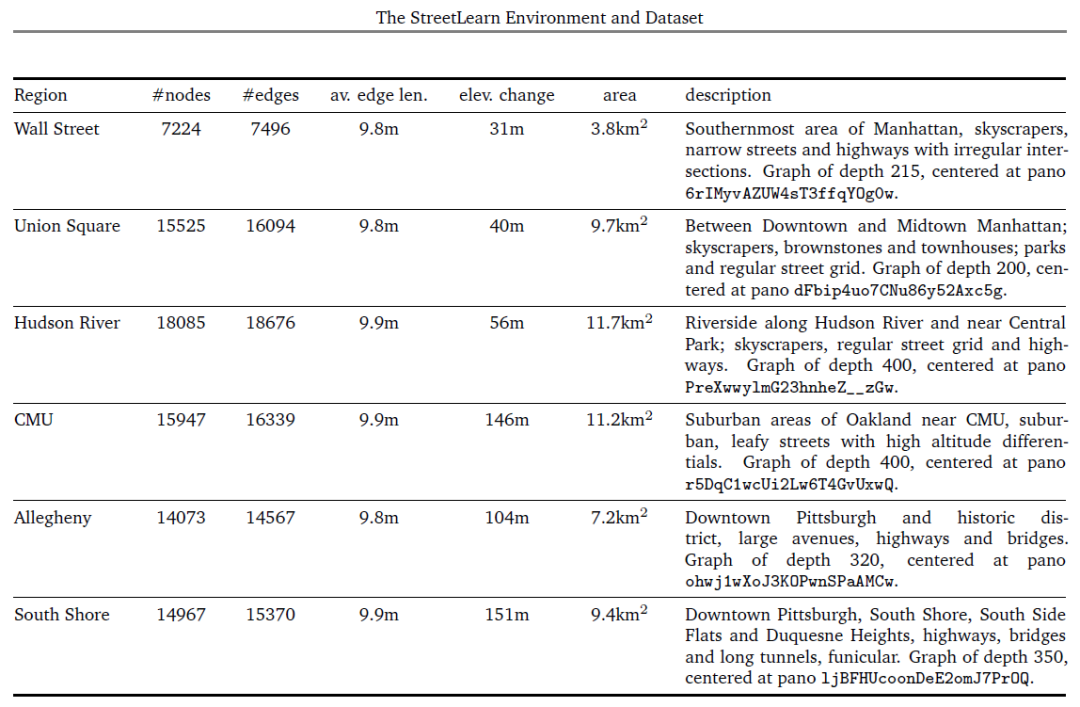

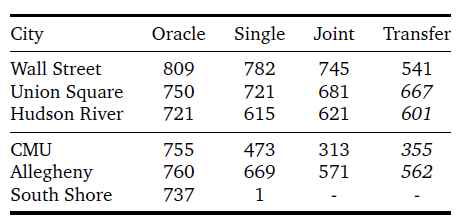

此外,我们在每个城市确定了三个区域,可以单独用于训练或转移学习实验。表1给出了每个地区的统计数据。

无向图的边描述了节点与其他节点的接近性和可及性。我们不减少或简化基础的连接性,而是使用完整的图;因此,有许多节点的拥挤地区,复杂的闭塞交叉口,隧道和人行道,以及其他偶发事件。

平均节点间距为10米,在交叉口的密度更高。虽然图形被用来构建环境,但agent从未观察到底层图形--只观察到RGB图像(公共街景产品中可见的叠加信息,如箭头,也不被agent看到)。

图1中显示了RGB图像和图表的例子。 在我们的数据集中,每个全景图都被存储为一个协议缓冲区(Google,2008)对象,包含一个高质量的压缩JPEG格式的字符串,对等角图像进行编码,并以下列属性加以装饰:一个独特的字符串标识符,全景相机的位置(经度/纬度坐标和高度,以米为单位)和方向(俯仰、滚动和偏航角度),图像的采集日期,以及直接连接的相邻对象列表。 2.1.界定数据集内的区域 在StreetLearn数据集中,整个曼哈顿和匹兹堡的环境包含了大的城市区域,每个区域代表了超过56000张街景全景图,从一个极端到另一个极端,穿越这些区域可能需要经过街景图中接近1千的节点。 为了使学习具有可操作性,也为了确定训练和转移的不同区域,我们可以将环境切割成更小的区域。例如,图3显示了将曼哈顿和匹兹堡切割成6个区域("华尔街"、"联合广场"、"哈德逊"、"CMU"、"阿勒格尼 "和"南岸")的情况,这在我们第5节的实验中使用。 在街道图上划分区域有许多可能性:最明显的是用经纬度边界框来切割图形,其缺点是会产生不相连的部分。第二种是用多边形来切割图形,但必须指定该多边形的所有顶点,依靠凸面体来选择包含在多边形内的节点,这很不方便。 我们选择了第三种方法来确定我们的区域,通过广度优先搜索(BFS)(Moore, 1959; Zuse, 1972)从一个给定的节点开始增长图形区域,这只需要选择一个中心全景图和一个图形深度,并确保产生的图形是连接的。我们在表1中列出了这些区域的大小(以节点、边和区域覆盖率计)、高度变化和描述,包括中央全景图的ID和BFS图的深度。 2.2.agent界面和速递任务

RL环境需要指定agent的观察和行动空间,并定义任务。StreetLearn环境在每个时间点提供可视化观察xt。视觉输入是为了模拟第一人称,部分观察到的环境,因此xt是一个裁剪过的、60°正方形的RGB图像,被缩放为84×84像素(即不是整个全景图)。

动作空间由五种离散的动作组成。"缓慢 "向左或向右旋转(±22.5°),"快速"向左或向右旋转(±67.5°),或向前移动(如果从当前agent的姿势来看,没有一个边缘,这个动作就会成为一个noop)。

如果在agent的视锥中有多个边,那么就选择最中心的一个。

StreetLearn提供了一个额外的观察,即目标描述符gt,它向agent传达了任务目标--去哪里领取下一个收获。

如何指定目标有很多选择:例如,图像是一个自然的选择(如(Zhu等人,2017)),但在城市范围内很快就变得模糊不清;可以使用基于语言的指示或街道地址(如(Chen等人,2018)),尽管这将把重点放在语言基础而不是导航上;和地标可用于以可扩展的、无坐标的方式对目标位置进行编码(Mirowski等人,2018)。

对于这项快递任务,我们采取最简单的路线,并将目标地点直接定为连续值坐标 (Lattg, Longtg)。注意目标描述是绝对的;它与agent的位置无关,只在绘制新目标时发生变化(无论是在成功获得目标时还是在任务事件开始时)。

在快递任务中,可以概括为导航到城市中一系列随机地点的问题,agent从StreetLearn图中随机抽样的位置和方向开始每一个任务。从图中随机抽出一个目标位置,计算出目标描述符g0并输入给agent。如果agent到达一个接近目标的节点(100米,或大约一个城市街区),agent就会得到奖励,并随机选择下一个目标并输入给agent。

每一个任务在1000个agent步骤后结束。agent在到达目标时获得的奖励与目标和agent首次分配目标时的位置之间的最短路径成正比;很像速递服务,agent在较长的旅程中获得较高的奖励。

直观地说,为了解决速递任务,agent需要学会将目标编码与在目标位置观察到的图像相关联,以及将在当前位置观察到的图像与到达不同目标位置的策略相关联。

2.3.课程

课程学习通过选择更多更难的例子来呈现给学习算法,逐渐增加学习任务的复杂性(Bengio等人,2009;Graves等人,2017;Zaremba和Sutskever,2014)。我们发现,对于目的地较远的速递任务,课程可能很重要。与其他RL问题(如Montezuma’s Revenge)类似,速递员任务的奖励非常稀少;与该游戏不同,我们能够制定一个自然的课程计划。我们首先对agent位置500米范围内的新目标进行采样(第1阶段)。在第二阶段,我们逐步扩大允许目标的最大范围,以覆盖整个图形。

注意,虽然本文主要关注速递任务,但正如下面第3节所述,该环境已经丰富了,通过一步步的(图像、自然语言指令)和目标图像指定方向的可能性。

III.编码

3.1.编码结构

我们在https://github.com/deepmind/streetlearn提供了环境和agent的编码。该编码库包含以下组件:

• 我们的C++ StreetLearn引擎用于加载、缓存和提供谷歌街景全景图,并根据城市街道图和agent的当前位置和方向处理导航(从一个全景图移动到另一个)。每个全景图都从其等矩形(Wikipedia, 2005)表示投影到第一人称视图,可以指定偏航、俯仰和视场角度。

• 用于存储全景图和街道图的消息协议缓冲区(Google, 2008)。

表1 l 纽约的三个地区(华尔街、联合广场和哈德逊河)和匹兹堡的三个地区(CMU、阿勒格尼和南岸)的相关信息。

• 一个基于Python的接口,用于调用具有自定义动作空间的StreetLearn环境。

• 在Python StreetLearn界面中,几个游戏被定义在单独的文件中,文件名以game.py结尾。

• 一个简单的人类agent,使用Pygame在Python中实现,在所要求的地图上实例化StreetLearn环境,并使用户能够玩速递或跟随指令的游戏

• Oracleagent,类似于人类agent,自动导航到指定的目标,并报告Oracle在速递或指令遵循游戏中的表现。

•agent的TensorFlow实施。

3.2.编码界面

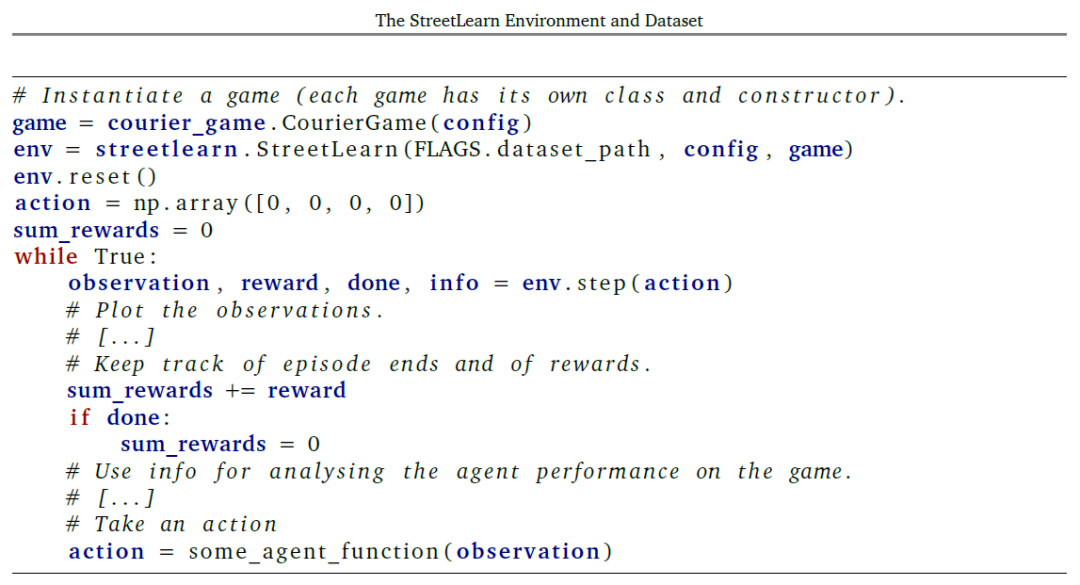

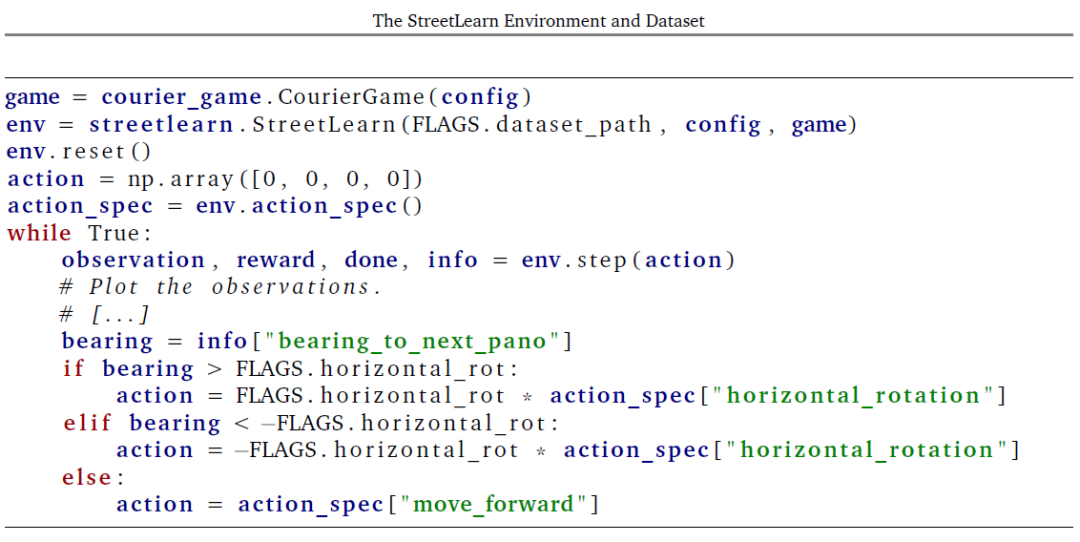

我们的Python StreetLearn环境遵循OpenAI Gym2(Brockman等人,2016)的规范。

在实例化了一个特定的游戏和环境后,可以通过调用函数reset()来初始化环境。注意,如果在构建时将auto_reset的flag设置为True,那么每当一个情节结束时,reset()将被自动调用。

如清单4所示,agent在环境中通过迭代生成一个动作,将其发送到(逐步通过)环境,并处理环境返回的观察结果和奖励。对函数step(动作)的调用返回:

• 观察(构造时要求的观察数组和标量的元组),

•奖励(一个带有agent当前奖励的浮动标度数),

•done(布尔值,表示一个游戏情节是否已经结束并被重置),

•以及info(环境状态变量字典,用于调试agent行为或访问特权环境信息以进行可视化和分析)。

3.3.行动和观察

我们向agent提供了四个行动:

• 在全景图中向左或向右旋转一个指定的角度(改变agent的偏航)。 • 在全景图中按指定的角度向上或向下旋转(改变agent的间距)。 • 如果agent从A到B的当前方位在30度的公差角度内,则从当前全景图A向前移动到另一个全景图B。 • 在全景图中放大和缩小。 因此,agent行动通过step(action)作为4个标量数字的图组被发送到环境中。 然而,对于通过强化学习训练离散策略agent,行动空间被离散为整数。例如,我们在(Mirowski等人,2018)中使用了5个动作:(向前移动,左转22.5度,左转67.5度,右转22.5度,右转67.5度)。目前可以要求从环境中获得以下观察结果:•view_image:从环境中返回并由agent看到的第一人称视角图像的RGB图像; •graph_image:自上而下的街道图图像的RGB图像,通常不被agent看到; •pitch:agent的俯仰角的标量值,单位是度(零对应于水平); •yaw:agent的偏航角度的标量值,单位是度(零对应于北); •yaw_label:agent偏航的整数离散值,使用16个bin; •metadata:具有当前全景图元数据的Pano类型的消息协议缓冲区; •target_metadata:具有目的/目标全景图元数据的Pano类型的消息协议缓冲区; •latlng:agent当前位置的纬度/经度标量值的元组; •latlng:当前agent位置的整数离散值,使用1024个bins(32个bins为纬度,32个bins为经度); •target_latlng:目的/目标位置的纬度/经度度标量值的元组; •target_latlng:目标位置的整数离散值,使用1024个bins (32个bins 为纬度,32个bins 为经度); •thumbnails:从环境中返回的第一人称视角图像的n+1个RGB图像集,当用n个指令进行指令追踪游戏时,agent应该在特定的航点和目标位置看到这些图像; •instructions:当用n个指令进行指令追踪游戏时,在特定的航点和目标地点为agent提供n个指令集; •neighbors:agent周围的近邻以自我为中心的可穿越性网格的矢量,agent周围的方向有16个bin,bin 0对应于agent正前方的可穿越性; •ground_truth_direction:为了遵循最短路径到达下一个目标或航点,agent要采取的相对地面真实方向的标量值。这种观察应该只对使用模仿学习训练的agent提出要求。

3.4.游戏

以下游戏可在StreetLearn环境中使用:

3.4.1.硬币_游戏在硬币游戏中,奖励包括散落在地图上的无形硬币,每个硬币的奖励为1。一旦被捡到,这些奖励在剧情结束前不会再出现。3.4.2.速递_游戏在速递游戏中,agent被赋予了一个目标目的地,以经/纬度对的形式加以说明。一旦达到目标(有100米的容许偏差),就会对新的目标进行采样,直到情节结束。 在一个目标上的奖励与agent得到新的目标分配时从其位置到该目标位置的最短路径上的全景图数量成正比。额外的奖励形成包括当agent到达距离目标200米范围内时的早期奖励。 额外的硬币也可以分散在整个环境中。硬币的比例、目标半径和早期奖励半径是可参数化的。课程_速递游戏与速递游戏类似,但在任务的难度上有一个课程(分配任务时,从agent的位置到目标的最大直线距离)。3.4.3.指令游戏目标指令游戏及其变体--递增指令游戏和逐步指令游戏使用导航指令来引导agent到达目标。agent被提供了一个指令清单以及缩略图,引导agent从其起始位置到目标位置。 在逐步游戏中,agent每次提供一个指令和两个缩略图,在其他游戏变体中,整个列表在整个游戏中都可以使用。到达目标地点(所有变体),以及击中单个航点(仅增量和逐步)时,均可获得奖励。 在训练过程中,有各种课程策略可供agent使用,并且可以采用奖励塑造法,当agent进入到距离一个航点或目标50米的范围内时,提供零星的奖励。

IV.方法

本节简要介绍了在速递任务中被评估的一系列方法。

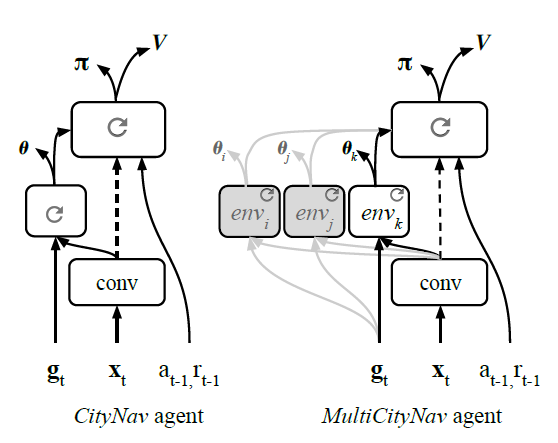

4.1.Goal-dependent Actor-Critic 强化学习 我们将学习问题形式化为马尔科夫决策过程,有状态空间s,行动空间A,环境s,以及一组可能的目标g。 奖励函数取决于当前的目标和状态:R : s ×g ×A → R. 通常的强化学习目标是找到使预期收益最大化的政策,该策略被定义为从状态s0开始的折现奖励之和,折现率为γ。 I在这个导航任务中,一个状态st的预期回报也取决于一系列的采样目标{gk}k。策略是:给定当前状态st和目标gt下,在动作上的分布:π(als, g) = Pr(at = alst= s, gt = g)。我们将值函数定义为代理的期望返回值,该代理从状态st的策略π中采样动作,目标gt: 我们假设agent应该从两种类型的学习中获益:第一,学习一般的、与位置无关的表征和探索行为;第二,学习本地特定的结构和特征。一个导航代理不仅需要一个通用的内部表征,以支持认知过程,如场景理解,而且还需要组织和记忆一个地方特有的特征和结构。因此,为了支持这两种类型的学习,我们专注于具有多种途径的神经架构。 我们在表1中描述的六个区域评估了两个agent。我们在此对该方法进行总结,因为这些agent的全部架构细节之前已经描述过(Mirowski等人,2018)。 策略和价值函数都由一个神经网络设定参数,该网络共享除最终线性输出以外的所有层。 该agent对原始像素图像xt进行操作,这些图像通过卷积网络,如(Mnih等人,2016)。长短期记忆(LSTM)(Hochreiter和Schmidhuber,1997)接收对话编码器的输出,以及过去的奖励rt+1和以前的行动at+1。这两种不同的结构描述如下。

图4 l 与环境互动的主要循环。

图5l 架构的比较。左图:City-Nav是一个具有策略LSTM、独立目标LSTM和操作辅助航向(θ)的单一城市导航架构。右图:多城市导航是一个多城市架构,每个城市都有独立的目标LSTM路径。

CityNav架构(图5b)有一个卷积编码器和两个LSTM层,它们被指定为策略LSTM和目标LSTM。目标描述gt与之前的动作和奖励以及卷积编码器的视觉特征一起被输入到目标LSTM。CityNav agent还在目标LSTM的输出上增加了一个辅助的航向(θ)预测任务。

多城市导航架构(图5c)扩展了CityNav agent,以便在不同城市学习。 目标LSTM的职责是编码和封装当地特定的特征和拓扑结构,这样就可以添加多个路径,每个城市或地区一个。此外,在对一些城市进行训练后,我们证明卷积编码器和政策LSTM变得足够通用,只需要为新的城市训练一个新的目标LSTM。

为了训练agent,我们使用IMPALA(Espeholt等人,2018),这是一个actor-critic的实现,将行动和学习分离开来。在我们的实验中,IMPALA的性能与A3C(Mnih等人,2016)相似。我们对CityNav使用256个行为体,对MultiCityNav使用512个行为体,批次大小分别为256或512,序列长度为50。

我们注意到,这些计算资源并不是所有人都能得到的,所以我们验证了只用16个行动者和1个学习者,在一台带有图形处理单元(GPU)的台式电脑上运行,就能获得类似的结果。

我们使用的台式机有很大的内存(192GB),用于实例化16个StreetLearn环境(每个环境都需要一个大的缓存内存来缓存全景图),但更小的内存也可以使用,但要权衡一下更频繁的磁盘访问。

CityNav和基线架构的TensorFlow实现(Mirowski等人,2018)可在https://github.com/deepmind/streetlearn的代码回收库中获得。

训练器代码是对(Espeholt等人,2018)的直接修改,来自https://github.com/deepmind/scalable_ agent,可单独提供。

4.2.Oracle

我们还通过使用广度优先搜索计算从所有全景位置到指定目标位置的最短路径来计算所有任务的上限(Moore, 1959;Zuse, 1972)的全景连通性图。这使我们能够计算agent应该去的下一个全景图是哪一个,以及agent为了向前移动到那个全景图应该对齐的方向,重复这个过程直到到达目的地。

这个ground_truth_position可以作为一个观察值被请求(对于模仿学习代理),或者从环境返回的信息字典中提取。清单6显示了如何实现 oracle agent,以提供一个有价值的衡量标准来衡量任务。

V.速递任务的结构

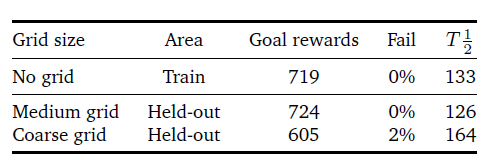

为了评估所描述的方法,我们给出了每个区域的单独性能,以及多个区域的联合训练结果。我们还展示了该方法的概括能力,即通过评估保留区域的目标,以及只对一个全新的区域进行agent训练。 表2给出了在图3和表1中定义的纽约市和匹兹堡市的六个不同地区,不同的代理在每1000步事件中取得的平均总奖励。尽管代理人接受了奖励塑造的训练(即,当他们在目标的小半径范围内时,他们会得到部分奖励),这里给出的每集回报只包括达到目标时给予的全部奖励。实验都是用5个不同的种子重复进行的。 在表2中,Oracle的结果是直接在图上进行广度搜索的结果,因此它们反映了完美的性能。单一结果显示了使用CityNav架构为每个区域单独训练的agent的性能。训练有素的agent在纽约市表现良好,实现了85%至97%的oracle收益,而在匹兹堡表现较差,尤其是在南岸地区,agent完全失败。 这可能是由于该地区具有挑战性的海拔变化,即使在附近的节点之间也会产生错综复杂的路线,这也是我们指定课程任务的一个伪命题(基于从agent位置到目标的最大欧氏距离,不考虑实际旅行时间)。 特别是,当 agent在南岸的杜肯山顶时,在河对岸的目标地点,如果乘坐飞机500米远,公路距离可能会有数公里。 联合结果显示了在五个地区联合训练的多城市导航agent在每个地区的表现(不包括南岸)。尽管现在在更大的范围内进行了训练:两个城市和五个地区,但所产生的agent 在性能上只下降了一点。 最后,转移给出了一个agent的表现,该agent在四个地区接受训练(用斜体字给出),然后转移到第五个地区(华尔街)。在这种转移中,只有目标LSTM被修改;架构的其他两个部分(卷积编码器或策略LSTM)没有梯度更新。

表2 l Oracle的每个城市目标奖励,单一训练的CityNav和多个CityNav agent在5个城市(华尔街、曼哈顿的联合广场和哈德逊河、匹兹堡的CMU和阿勒格尼)联合训练或在4个城市(联合广场、哈德逊河、CMU和阿勒格尼)联合训练。

图6 l Oracle的实施,使用地面真实方向/方位到下一个全景图。

表3 l CityNav agent在一组目标地点(中等和粗略的网格)上的概括表现(奖励和失败指标)。我们还计算了半程时间(T1/2),即到达目标的一半。

为了研究受过训练的agent的概括能力,我们掩盖了25%的可能目标,并对剩余的目标进行训练(见图5(Mirowski等人,2018)的说明)。在测试时,我们只对agent在封闭区域达到目标的能力进行评估。注意,agent仍然能够穿越这些区域,只是它从未在那里采样过目标。更确切地说,封闭的区域是经纬度为0.01°(粗网格)或0.005°(中网格)的方块(分别大约为1平方公里和0.5平方公里)。

在实验中,我们对CityNavagent进行了1B步的训练,接下来冻结了agent的权重,并对其在100M步的封闭区域的表现进行了评估。表3显示,随着封闭区面积的增加,agent的性能有所下降。为了进一步理解,除了测试奖励指标,我们还使用了未完成目标(Fail)和半行程时间(T1/2)指标。

错过目标的指标衡量的是没有达到目标的百分比。半程时间衡量的是完成agent与目标之间的一半距离所需的agent步骤数量。

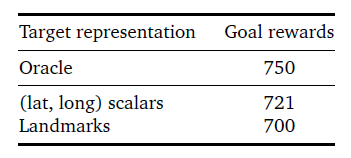

我们还在表4中比较了使用(经纬度)目标描述符与之前提出的地标描述符(Mirowski等人,2018)时取得的性能。虽然地标方案有一些优势,比如避免了固定的坐标框架,但(纬度,纬度)描述符的表现要优于纽约联合广场地区的地标。

表4 lCityNav代理在联合广场上使用不同类型的目标表示时的表现:(纬度,长度)标量与地标。

VI.相关工作

StreetLearn环境与近年来出现的许多其他模拟器和数据集相关,这些模拟器和数据集是为了响应增强学习和更普遍地通过交互学习导航的更大兴趣而出现的。

我们重点列举了这些相关的数据集和环境,请读者参考Mirowski等人(2018)对相关方法的更完整讨论。

许多基于RL的导航方法依赖于模拟器,这些模拟器具有程序化生成的变化等特点,但在视觉上往往是简单和不真实的,包括合成的3D环境,如VizDoom(Kempka等人,2016)、HoME(Brodeur等人,2017)、House 3D(Wu等人,2018)、Chalet(Yan等人)等。2016)、DeepMind Lab(Beattie等人,2016)、HoME(Brodeur等人,2017)、House 3D(Wu等人,2018)、Chalet(Yan等人,2018),或AI2-THOR(Kolve等人,2017)。

为了弥补模拟和真实之间的差距,研究人员开发了更真实、更高保真度的模拟环境(Dosovit- skiy等人,2017;Kolve等,2017;沙阿等人,2018;吴等人,2018)。然而,尽管模拟环境越来越具有照片真实感,但其固有的问题在于环境的有限多样性和观察结果的清洁性。

我们的真实世界数据集是多样化和视觉逼真的,包括行人、汽车、公共汽车或卡车、不同的天气条件和植被的场景,覆盖了很大的地理区域。然而,我们注意到我们的环境有明显的局限性:它不包含动态元素,行动空间必然是离散的,因为它必须在全景图之间跳跃,而且街道拓扑结构不能被任意改变或再生。

最近引入了更多视觉逼真的环境,如MatterportRoom-to-Room (Chang等人,2017)、AdobeIndoorNav(Mo等人,2018)、Stanford 2D- 3D-S(Armeni等人,2016)、ScanNet (Dai等人,2017)、Gibson环境(Xia等人,2018)和MI- NOS (Savva等人,2017)来表示室内场景,其中一些还添加了导航指令。

deVries等人(2018)使用纽约的图像,但依靠对附近地标的分类注释,而不是视觉观察,并且只使用了500张全景图的数据集(我们的数据集要大两个数量级)。最近,Cirik等人(2018),特别是Chen等人(2018)也提出了以街景图像为基础的较大的驾驶指令数据集。

VII.总结

导航是一项重要的认知任务,它使人类和动物能够在没有地图的情况下穿越一个复杂的世界。为了帮助理解这种认知技能,它的出现和稳健性,以及它在现实世界中的应用,我们公开了一个数据集和一个基于谷歌街景的互动环境。

我们精心策划的数据集是由经过人工审查和隐私审查的摄影图片构成的--我们采取了这些额外的预防措施,以确保所有的人脸和车牌都被适当地模糊了。

该数据集可获得,并根据要求进行分发;在个人要求删除或模糊谷歌街景网站上的特定全景图的情况下,我们将其要求传播给StreetLearn数据集的用户,并向用户提供符合删除要求的最新版本。

我们的环境使agent的训练能够纯粹基于视觉观察和绝对目标位置表征来导航到不同的目标位置。我们还用文字说明扩展了该数据集,以实现基于奖励的任务,重点是遵循相对方向来达到目标。我们将依靠这个数据集和环境来解决接地的、长距离的、目标驱动的导航的基本问题。

审核编辑:郭婷

-

谷歌

+关注

关注

27文章

6153浏览量

105244 -

数据集

+关注

关注

4文章

1206浏览量

24667

原文标题:自动驾驶“环境和数据集”

文章出处:【微信号:阿宝1990,微信公众号:阿宝1990】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

如何利用遥感监测环境变化 遥感卫星的工作原理与种类

HarmonyOS Next元服务蒹葭动卡体验互动

纯净IP:构建可信网络环境的基石

谷歌推出Project Oscar:利用代理技术高效管理软件程序

如何使用Cygwin在Win64中构建环境?

如何在不同应用场景下构建音频测试环境

谷歌计划推出明星网红AI聊天机器人,与Meta展开技术竞争

求助,通过VScode构建的集成开发环境如何更新环境下的ESP-IDF版本?

谷歌模型框架是什么软件?谷歌模型框架怎么用?

谷歌发布全新AI模型Genie

鸿蒙开发【编译构建】讲解

自动化构建环境在FPGA设计中的应用

StreetLearn利用谷歌街景构建的互动环境介绍

StreetLearn利用谷歌街景构建的互动环境介绍

评论