2022年第三季度,英伟达营收达到59.31亿美元,其中数据中心业务贡献了38.3亿美元,同比增长31%,再度成为英伟达最强大的收入来源。

作为数据中心的「扛把子」芯片,DPU已经成为英伟达战略布局的重中之重。但除了高性能之外,DPU其实还抓住了现代数据中心的一个最大痛点:节能。

在各大科技公司纷纷「降本增效」的2022年,绿色与节能,比往年受到了更多人的关注。

数据中心的最大「杀手」

数字化经济时代,数据成为重要资源。就拿每天都在使用的手机为例,无论是浏览各种APP产生的交互,还是浏览图片、播放视频,抑或是微信端的聊天记录,本质上都是大量的数据。而这些数据的传输、处理、计算、存储,很大程度上都需要数据中心来完成。

现在,数据中心成为汇聚所有数据的核心。随着全球数据量的爆发性增长,数据中心的规模也在不断扩大。

之前的文章里我们就介绍过,性能早就不是衡量数据中心的唯一标准、甚至不是最重要的标准。建设一个现代化数据中心,它能提供的算力大小固然重要,但还有很多因素同样重要,首当其冲的就是:耗电。

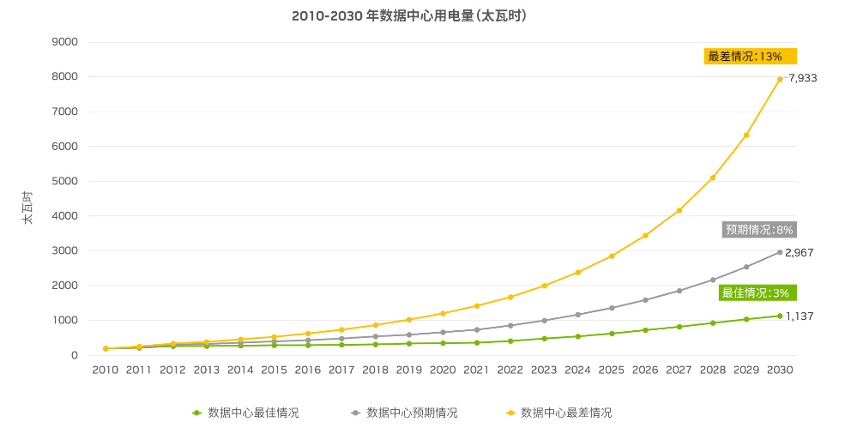

全球能源的大部分电能消耗均来自大型数据中心。有调查显示,目前数据中心的耗电量占全球发电量的比例高于1%,而这一占比在美国为 1.8%、在欧洲为 2.7%。在 2015 年有报告数据就预计,到 2030 年,数据中心消耗的电量占全球发电量的比例将上升到 8%~13%。

2020年,中国数据中心年度用电总量已达至1380亿度,占我国全社会用电量的2%。高昂的电费已经成为数据中心运行成本的大头,约占60%~70%。

有点讽刺的是,全球经济与科技的发展,已经越来越追求绿色和低碳。但驱动这些技术发展的数据中心,却成为当今消耗电力和能源最多的场景之一。

问题就来了:如何解决数据中心的耗电难题?目前业界主要有两种方法。

首先,就是把数据中心搬到电费更便宜的地方。比如我国的贵州、内蒙等地,就建了不少数据中心,很重要的考虑就是利用当地更便宜的电费,拉低数据中心的运营成本。我国现在已经开始推进的「东数西算」工程,一个很重要的考虑也是把更多算力放在更便宜的地方,从而促进国家算力网更加平衡的发展。

但是不难看出,数据中心「搬家」,其实并没有从根本上解决数据中心的高能耗,只是降低了使用能源的成本。所以并不能作为唯一的解决方案。

第二,就是在数据中心的架构设计上做文章。常见的方法包括提高冷却效率、采用智能电源管理系统提高电源使用率、提高每台机器的负载利用率等等。这些方法在某种程度上触及到问题的本质,并且可以将数据中心的能耗降低不少。

不过随着数据中心的不断发展,新的问题又出现了。2012年,业界首次提出「数据中心税」的概念。它指的是数据中心里存在大量「基础设施」,也就是前面说的对数据进行传输、存储、计算的软硬件。对于用户来说,这些基础设施是不可见的,但用户仍然需要为它们付费。

就像在超市买个面包,它的标价其实包含了面包的成本、运输、储藏这一系列费用,甚至也包括超市的电费、房租等这些和面包没什么关系的费用分摊。

有研究显示,目前「数据中心税」已经达到30%。也就是说,用户花100元买数据中心服务,有30元其实都是花在了数据中心的基础设施成本上。

究其原因,就是传统的数据中心硬件不能满足日益增长的计算存储和传输需求了,造成了费力不讨好的尴尬局面。一方面花了大量资源去支撑基础设施、造成数据中心税;另一方面,这些投入的资源和算力却并不是为了基础设施的功能而设计的,导致运行效率非常低。这也从另一个角度解释了,为什么数据中心耗电量如此巨大的原因,就是没把好钢用在刀刃上。

因此,升级数据中心硬件、特别是芯片,让数据中心更加绿色高效,就成了国际学术界和工业界关心的重要课题。

DPU如何实现数据中心能效提升

顾名思义,DPU是一种面向数据的处理器。2020年,英伟达在GTC 秋季大会上宣布推出BlueField-2 DPU,它集成了大量特定领域专用加速器,专门用来执行执行网络、存储和安全等基础设施任务的处理。同时,在DPU芯片上拥有比x86 CPU更节能的Arm CPU核心,主要负责控制类的应用,比如卸载基础设施应用的控制平面、服务器虚拟化平台或容器管理软件的部分功能。

DPU出现的意义,就是为了进一步提升数据中心的效率、解决「数据中心税」的难题。具体来说,英伟达将DPU的主要任务总结成了三点:卸载、加速、隔离。

一、卸载,就是将原本在通用CPU上运行的应用,转移到DPU上来完成,从而实现对CPU的「卸载」,相当于给CPU减了负。比如在数据中心里常见的网络协议栈的处理,通常都是由CPU上运行的软件来实现的。相比之下,从智能网卡发展而来的DPU可以非常直接地连接网络,也有更强的网络处理能力。

比如英伟达的BlueField-2 DPU,就能支持200Gbps网络的线速处理,并且能实现OvS等数据中心常见应用。这样就释放了宝贵的CPU内核资源给用户,而不是用来交「数据中心税」,从而极大提升了数据中心的资源使用率。

二、加速,就是利用专门的硬件,把卸载下来的应用做的更快、性能更高。说白了,就是不仅把活接下来,还干的比原来还好。

比如,将OvS卸载到BlueField DPU后,服务器的网络吞吐量从19.8Gbps增至49.3Gbps。不仅在加速网络吞吐量两倍多,还释放了原本用于运行OvS的18个虚拟CPU核心。

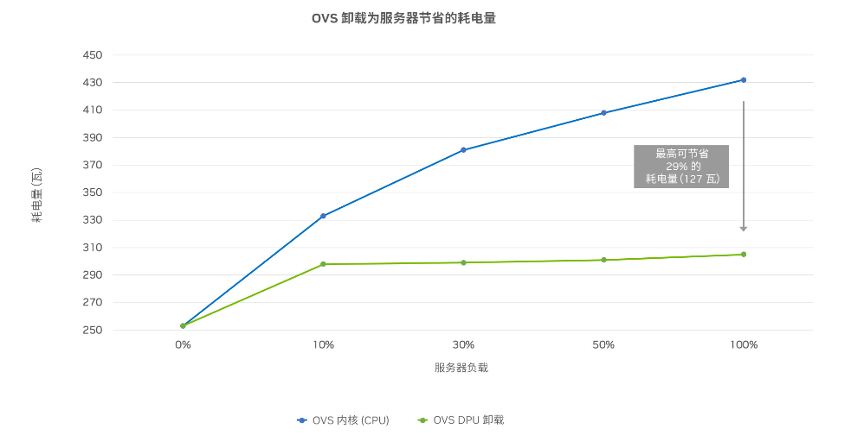

从能耗角度来看,一方面可以用耗电更低的DPU芯片实现更高的性能、用更少的服务器完成同样的工作;另一方面还提高了CPU的利用率,二者结合,自然将服务器的能耗大幅降下来了。根据英伟达测试的数据,采用DPU之后,每台服务器至少可节省300-400瓦的耗电量。

除了OvS,在运行数据中心基础设施的其他任务时,DPU也有专门的硬件引擎来用于加速网络、数据加密/解密、密钥管理、存储虚拟化和其他任务。DPU 上的CPU核心通常比一般服务器CPU更节能,并且可以直接访问网络管线。

因此,即使一些网络任务无法通过DPU的专用引擎来加速,DPU核心也能比服务器CPU更高效地执行SDN、遥测、深度数据包检查或其他网络任务。

有了DPU,承载网络侧专用性的网络堆栈算法和传输协议运算转移,数据中心可以更高效地应对多元化的算力需求,释放CPU和GPU的算力资源,让数据中心的性能得到进一步优化。

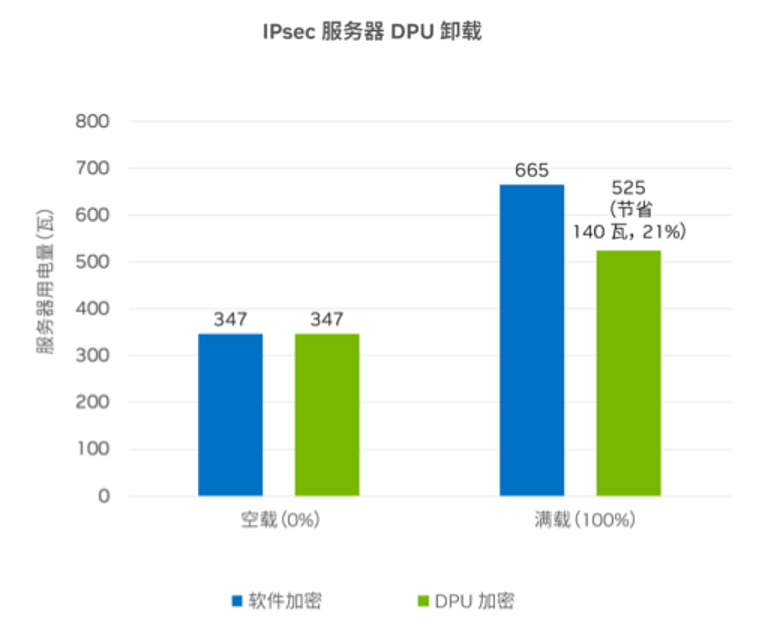

三、隔离,就是利用DPU的专用硬件,实现数据中心关键的安全功能。比如,数据中心常见的加密协议IPsec通常需要CPU或者专用的加密加速器卡来完成。而BlueField DPU就集成了对IPsec的硬件支持,让关键的加解密过程不经过CPU,避免多用户共享CPU和内存时发生数据窃取和攻击;也不需要额外的专用加密卡,进一步节省成本。

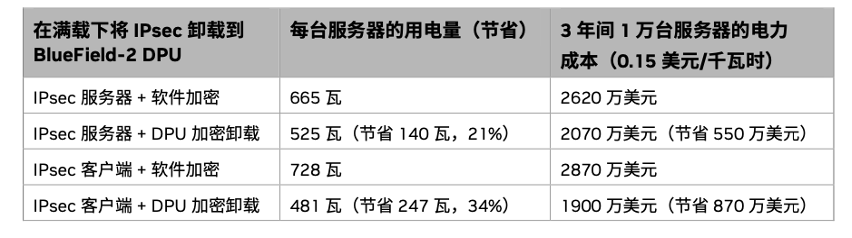

和CPU相比,采用DPU卸载IPsec之后,每台服务器耗电量降低21%,可节电高达140瓦;客户端也可节省能耗,最高耗电降低34%,节电高达247瓦。对于大型数据中心而言,这相当于在三年间节省了近 900 万美元的电费。

除了上面介绍的三个硬件特点之外,BlueField DPU还提供了DOCA软件编程框架,它主要分成三个主要模块,分别是DOCA服务、库和驱动。此外,DOCA还将实例代码、文档、以及预打包容器都集成在一起,可以让用户直接对DPU进行编程。

有了这些框架和方法实例,软件开发者就不需要管底层的硬件细节,更不需要再花时间去学习硬件相关的知识和编程方法,而可以专注于自己业务本身的开发。

通过采用并部署DPU,可以减少服务器的部署数量、并降低每台服务器的耗电量。根据《NVIDIA BlueField DPU能效白皮书》中的数据,拥有1 万台服务器的大型数据中心三年期间可大幅节省 2600 万美元。通过使用 DPU,服务器可节省 6.3%的资本性支出,由于较低的电力成本,运营性支出又节省了 46%。

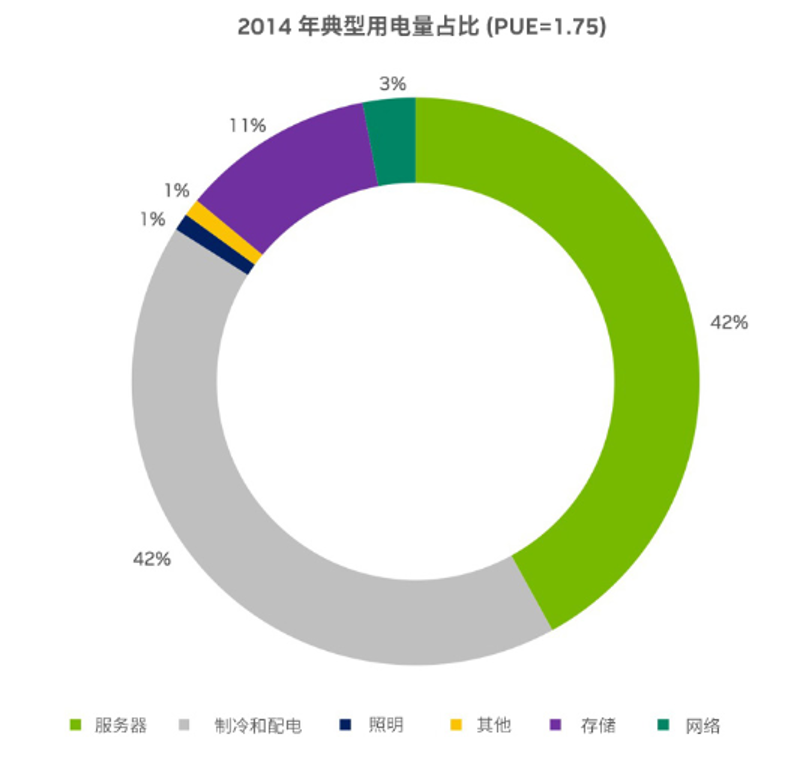

此外,降低服务器耗电量还可以节省数据中心的附加成本,如配电和冷却等。每瓦进入数据中心的电力都需要电源管理硬件。比如,不间断电源、发电机(加上燃料输送和存储)和配电装置,消耗的每一瓦电力都会转变成必须从数据中心排放出来的热量。从下图中可以看到,高达 40% 的数据中心耗电量还专门用于冷却。因此,服务器端节省的每一瓦电力都会减少数据中心冷却装置所需的电量,以及供电和散热所需的资产设备数量。

结语

当下,全球DPU市场已经迎来爆发式增长。据赛迪顾问预计,中国DPU产业市场规模将在2025年超过565.9亿元,复合增速达到 51.73%,而全球DPU产业市场规模更加庞大,将超过245.3亿美元,复合增速高达至170.60%。

除了高性能和安全性的考虑,低功耗也逐渐成为DPU新的核心需求。通过DPU实现数据中心的绿色发展,已经逐渐成为提高数据中心效率、降低能耗的大势所趋。

想了解更多DPU在数据中心里的能耗优势,扫描二维码获取 NVIDIA BlueField DPU 能效白皮书。

审核编辑 :李倩

-

数据中心

+关注

关注

16文章

4696浏览量

71965 -

DPU

+关注

关注

0文章

354浏览量

24133 -

英伟达

+关注

关注

22文章

3749浏览量

90847

原文标题:英伟达DPU的最大优势,竟然是省钱?

文章出处:【微信号:Leadtek,微信公众号:丽台科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

英伟达与软银携手共建日本AI基础设施

英伟达投资日本AI公司Sakana AI

英伟达DPU的最大优势,竟然是省钱?

英伟达DPU的最大优势,竟然是省钱?

评论