【导读】2022年对AI来说注定是不平凡的一年,这不吴恩达、Bengio等一众圈内大佬在接受DeepLearning.ai的采访中都展望了2023年AI的发展趋势,还分享了自己的科研小故事。

还有1天,2022年就要过去了。

此前我们报道了吴恩达的2022年终盘点,辞旧迎新之际,Bengio等一众AI大佬们在DeepLearning.ai聚在一起,展望了自己眼中的2023年。

Yoshua Bengio:寻找具备理性的AI模型

过去,深度学习的进展主要是「大力出奇迹」:采用最新的架构,提升硬件,扩大算力、数据和规模。我们是否已经拥有了我们所需要的架构,剩下的就是开发更好的硬件和数据集,以便我们能够继续扩大规模?现在还缺什么吗?

我认为是缺的,我希望在未来的一年里能找到这些缺失的东西。

我一直在与神经科学家和认知神经科学家合作,研究最先进的系统和人类之间的差距。简单地扩大模型规模并不能填补这种差距。相反,在目前的模型中建立一种类似于人类的能力,来发现和推理高层次的概念和它们之间的关系,可能会让差距变得更大。

考虑一下学习一项新任务所需的例子数量,即所谓的「样本复杂度」。训练一个深度学习模型玩一个新的视频游戏需要大量的游戏玩法,这些玩法对而人类而言,可以很快学会。但计算机需要考虑无数的可能性,来规划一条从A到B的高效路线。而人类则不需要。

人类可以选择正确的知识片段,并将这些片段贴合在一起,形成一套相关的解释、答案或计划。此外,给定一组变量,人类非常擅长确定哪些是原因,哪些是结果。而目前的人工智能技术在这个能力上还无法接近人类水平。

通常情况下,AI系统对生成的答案和方案的正确性高度自信,即使实际上是错误的。这个问题在文本生成器或聊天机器人这样的应用中可能是一些很有意思的笑话,但换到自动驾驶汽车或医疗诊断系统中,却可能威胁到生命。

目前的AI系统的行事特征,部分原因是它们就是被设计成这样的。比如,文本生成器的训练只是为了预测下一个单词,而不是建立一个内部数据结构,也不必说明所操作的概念以及它们之间的关系。

但我认为,我们可以设计出能够追踪事情背后的意义,并对其进行推理的AI系统,同时仍能发挥当前深度学习方法的众多优势。这样就可以解决从过度的样本复杂性到过度自信的不正确性等各种挑战。

论文链接:https://arxiv.org/pdf/2111.09266.pdf 我对「生成流网络」GFlowNets很感兴趣,这是我们团队一年前开始的一种训练深度网络的新方法。这个想法的灵感来自于人类通过一连串步骤进行推理的方式,在每一步加入新的相关信息。 这就像强化学习,因为模型是按顺序学习政策来解决问题的。它也像生成式建模,因为它可以对解决方案进行抽样,以对应于进行概率推理。 如果你想到一个图像的解释,你的想法可以转换成一个句子,但它不是句子本身。相反,它包含关于该句子中的概念的语义和关系信息。一般来说,我们把这种语义内容表示为一个图,其中每个节点是一个概念或变量。 我不认为这是唯一的解决方案,我期待着看到多种多样的方法。通过多样化的探索,我们将有更大的机会找到目前AI领域缺失的东西,,弥补当前人类和人类水平的AI之间的差距。 Yoshua Bengio是蒙特利尔大学计算机科学教授和Mila-魁北克人工智能研究所的科学主任。他与Geoffrey Hinton和Yann LeCun一起获得了2018年图灵奖,以表彰他对深度学习的突破性贡献。 Alon Halevy:个人数据时间轴 Alon Halevy是一位以色列裔美国计算机科学家,也是数据集成领域的专家。他从2005年到2015年担任谷歌的研究科学家,负责谷歌数据融合表。 他是ACM会员,并于2000年获得美国总统奖 (PECASE)。他还是科技公司Nimble Technology(现为Actuate Corporation)和Transformic Inc.的创始人。 在对2023年的展望中,Halevy聚焦于个人数据时间轴(personal data timeline)的构建。 公司和组织如何使用用户数据?这一重要问题在技术圈和政策界都受到了广泛关注。 2023年,还有一个同样重要、值得更多关注的问题:作为个人,我们如何利用生成的数据来改善我们的健康,增加活力和生产力? 我们每天都在生成各种数据。照片捕捉我们的生活经历,手机记录我们的锻炼情况和位置,互联网服务记录我们的消费和购买内容。 我们还会记录各种愿望:想要前往的旅行和尝试的餐厅、计划欣赏的书籍和电影,以及想要进行的社交活动。 不久后,智能眼镜将更细致地记录我们的种种体验。然而,这些数据分散在许多应用程序中。为了更好地总结过去的经历,我们需要每天从不同应用中整理过去的记忆。 能不能把所有的信息都融合在一张个人时间表上,帮助我们朝着目标、希望和梦想前进呢?事实上,很久之前就有人有这样的想法。 早在1945年,美国科学家范内瓦·布什(Vannevar Bush)就设计了一款产品,称其为麦克斯储存器(memex)。90年代,戈登·贝尔 (Gordon Bell) 和微软研究院的同事构建了MyLifeBits,可以储存一个人一生中所有的信息。 但是,当我们把所有数据都保存在一个地方,保护隐私,防止信息被滥用显然是一个关键问题。 目前,没有一家公司可以拥有我们所有的数据,也没有存储我们的所有数据的授权。因此,需要通力合作,构建支持个人时间线的技术,包括用于数据交换、加密存储和安全处理的协议。 建立个人时间轴,有两个技术挑战亟待解决。 第一个挑战关于系统的智能问答。尽管我们在基于文本和多模态数据的问答方面取得了重大进展,然而在许多情况下,智能问答要求我们明确推理答案集合。 这是数据库系统的基础。例如,要回答「我在东京参观了哪些咖啡馆?」或者「我在两小时内跑了多少次半程马拉松?」,要求检索集合作为中间答案。而在目前,自然语言处理中还无法完成这项任务。 从数据库中汲取更多灵感,还需要让系统能够解释答案的出处,并判断答案是否正确完整。 构建个人时间轴的第二个挑战,是如何开发个人数据轴分析技术,以改善用户的生活质量。 根据积极心理学,人们可以为自己创造积极的体验并养成更好的习惯,以实现更好的发展。一个可以访问我们生活点滴和目标的AI智能体,可以及时提醒我们需要完成和避免的事情。 当然,我们选择做什么取决于我们自己,但我相信,一个能够全面了解我们的日常活动,拥有更好的记忆力和计划能力的人工智能会使每个人受益良多。 Douwe Kiela:少点炒作,多点谨慎 Douwe Kiela是斯坦福大学符号系统的兼职教授。在剑桥大学完成硕士和博士学位后,Kiela分别在IBM、微软、Facebook AI担任研究员,并担任Hugging Face的研究主管。

在新年展望中,Kiela表达了他对人工智能系统发展的愿望。 今年,我们真正看到人工智能开始成为主流。像Stable Diffusion和ChatGPT这样的系统完全激发了公众的想象力。 这是激动人心的时刻,我们正处于伟大事物的风口浪尖:毫不夸张地说,这种能力的转变会和工业革命一样,产生颠覆性的影响。 但是在兴奋之余,我们应该警惕炒作,格外谨慎,以负责任的态度进行研发。 对大型语言模型而言,不论这些系统是否真的「有意义」,外行人都会将它们拟人化,因为它们有能力执行人类最具代表性的事情:产生语言。 但是,我们必须让公众了解这些人工智能系统的能力和局限性,因为公众大多认为计算机还是那种老式的符号处理器,例如,它们擅长数学但不擅长艺术,而目前情况却恰恰相反。 现代AI有项严重的缺陷,其系统很容易被无意误用或有意滥用。它们不仅会产生错误的信息,而且看起来非常自信,让人信以为真。 这些AI系统对复杂的多模态人类世界缺乏足够的理解,也不具备哲学家所说的「大众心理学」,即解释和预测他人行为和心理状态的能力。 目前,AI系统还是不可持续的资源密集型产品,我们对输入的训练数据和输出的模型之间的关系知之甚少。 同时,虽然模型扩展可以极大提高有效性——例如,某些功能只有在模型达到一定规模时才会出现——但也有迹象表明,随着这模型扩展,更容易出现偏见,甚至是更不公平的系统。 因此,我对2023年的希望是,我们能改善这些问题。对多模态、定位和交互的研究可以使系统更好地理解现实世界和人类行为,从而更好地理解人类。 研究对齐、归因和不确定性可以使AI系统更安全,更不容易产生幻觉,并构建更加准确的奖励模型。以数据为中心的人工智能有望展示更高效的缩放法则,更有效地将数据转化为稳健和公平的模型。

论文链接:https://arxiv.org/pdf/2007.14435.pdf 最后,我们应该更加关注人工智能持续的评估危机。我们需要对数据和模型进行更精细、更全面的测量,以确保我们能够描述我们的进步和局限性,并从生态有效性(例如,AI系统在真实世界的应用案例)的角度出发,理解我们从人工智能发展中真正想要获得的东西。 Been Kim:用科学研究解释模型 Been Kim是来自Google Brain的一名科学家,毕业于麻省理工大学,他的研究领域是交互式机器学习。 对于过去这一年里AI所展现的创造力以及取得的诸多成就,她在激动兴奋之余,也提出了自己对未来AI研究的一些看法。

对于AI来说,这是一个激动人心的时刻,在生成艺术和许多其他应用程序方面取得了令人着迷的进步, 虽然这些方向令人兴奋,但我认为我们需要从事不那么浮躁的工作,不光是AI能创造出更多东西,或是能设计出多大的模型:

回归基础并将研究人工智能模型作为科学探究的目标。

为什么要这么做? 可解释性领域旨在创建工具来为复杂模型的输出生成解释,帮助我们探寻AI与人类的关系。 例如一种工具采用图像和分类模型,并以加权像素的形式生成解释。像素的权重越高,它就越重要。例如,它的值对输出的影响越大,它可能就越重要,但如何定义重要性因工具而异。 虽然生成AI取得了一些成功,但事实证明许多工具的运行方式出乎我们的意料。 例如未经训练的模型的解释在数量和质量上与训练模型的解释无法区分,尽管产生相同的输出,但解释通常会随着输入的微小变化而改变。 此外,模型的输出与工具的解释之间没有太多因果关系。其他工作表明,对模型输出的良好解释不一定会对人们使用模型的方式产生积极影响。 期望和结果之间的这种不匹配意味着什么,我们应该怎么做?它表明我们需要检查我们如何构建这些工具。 目前我们采用以工程为中心的方法:反复试验。我们基于直觉构建工具(例如我们为每个像素块而不是单个像素生成权重,解释会更直观)。

论文链接:https://arxiv.org/pdf/1811.12231.pdf 图宾根大学的一个团队发现,神经网络看到的纹理(如大象的皮肤)比形状(大象的轮廓)更多,即使我们在解释图像时看到了大象的轮廓可能是以集体高亮像素的形式。 这项研究告诉我们,模型可能看到的不是形状,而是纹理,这称为归纳偏差—由于其架构或我们优化它的方式而导致的特定类别模型的趋势。 揭示这种倾向可以帮助我们了解模型,就像揭示人类的倾向可以用来理解人类的行为(例如不公平的决定)一样。 这种常用于理解人类的方法也可以帮助我们理解模型。对于模型,由于其内部结构的构建方式,我们还有一种工具:理论分析。 这个方向的工作已经在模型、优化器和损失函数的行为方面产生了令人兴奋的理论结果。有些利用统计学、物理学、动力系统或信号处理中的经典工具,许多来自不同领域的工具在人工智能的研究中还有待探索。 追求科学并不意味着我们应该停止实践:科学使我们能够根据原理和知识构建工具,而实践则将理念变为现实。

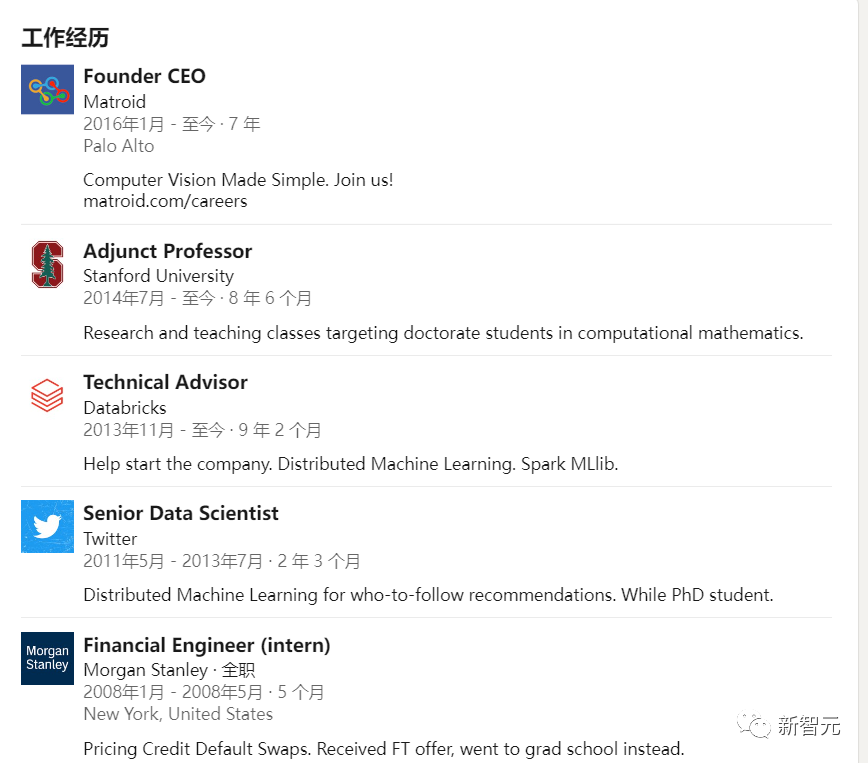

论文链接:https://hal.inria.fr/inria-00112631/document 实践也可以启发科学:在实践中行之有效的东西可以为科学结构化的模型结构提供参考,就如同2012年的高性能卷积网络激发了许多分析为什么卷积有助于泛化的理论论文一样。 Reza Zadeh:让ML模型主动学习 Reza Zadeh是计算机视觉公司Matroid 的创始人兼CEO,毕业于斯坦福大学,他的研究领域是机器学习、分布式计算和离散应用数学,同时也是 Databricks 的早期成员。 他认为,在即将到来的2023将会是主动学习腾飞的一年。

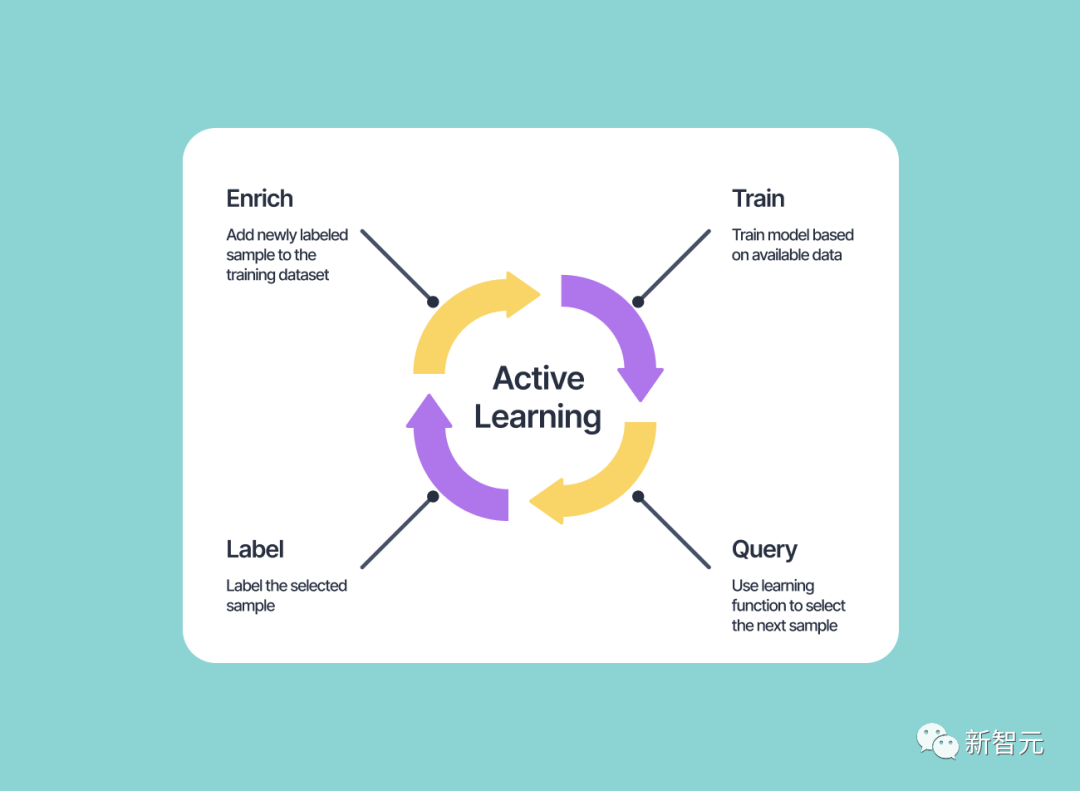

随着我们进入新一年,人们希望生成AI的爆炸式增长将在主动学习(Active Learning)方面带来重大进展。 这种技术使ML系统能够生成自己的训练示例并对它们进行标记,而在大多数其他形式的机器学习中,算法被赋予一组固定的示例,并且通常只能从这些示例中学习。

那么主动学习可以给机器学习系统带来什么呢?

适应不断变化的条件

从更少的标签中学习

让人们了解最有价值/最困难的实例

实现更高的性能

主动学习的理念已经存在了几十年,但从未真正流行起来。以前,算法很难生成供人类评估并可推进学习算法的图像或句子。 但随着图像和文本生成AI的大火,主动学习有望取得重大突破。现在当学习算法不确定其编码空间的某些部分的正确标签时,它可以主动从该部分生成数据以获取输入。 主动学习有可能彻底改变机器学习的方式,因为它允许系统随着时间的推移不断改进和适应。 主动学习系统不依赖于一组固定的标记数据,而是可以寻找新的信息和示例,以帮助它更好地理解它试图解决的问题。 这可以带来更准确和有效的机器学习模型,并且减少对大量标记数据的需求。 我对主动学习在生成AI的最新进展之上充满期待。进入新的一年,我们很可能会看到更多实施主动学习技术的机器学习系统,2023 年可能是主动学习真正腾飞的一年。

审核编辑 :李倩

-

AI

+关注

关注

87文章

31133浏览量

269453 -

机器学习

+关注

关注

66文章

8425浏览量

132770 -

深度学习

+关注

关注

73文章

5507浏览量

121274

原文标题:Bengio等大佬年度展望!懂理性的AI模型要来了?

文章出处:【微信号:vision263com,微信公众号:新机器视觉】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

AI大模型与深度学习的关系

AI模型在面对数据壁垒时的困境

ai大模型和传统ai的区别在哪?

AI大模型与AI框架的关系

AI大模型与传统AI的区别

AI大模型与小模型的优缺点

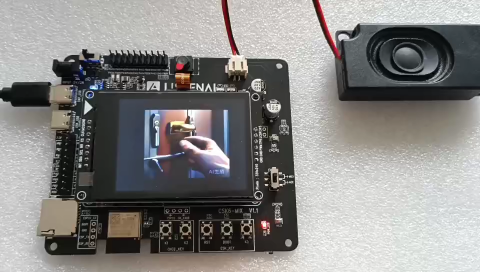

聆思CSK6视觉语音大模型AI开发板入门资源合集(硬件资料、大模型语音/多模态交互/英语评测SDK合集)

STM CUBE AI错误导入onnx模型报错的原因?

为什么Cubeai导入模型的时候报错[AI:persondetection] ModuleNotFoundError: No module named \'_socket\'?

防止AI大模型被黑客病毒入侵控制(原创)聆思大模型AI开发套件评测4

Yoshua Bengio:寻找具备理性的AI模型

Yoshua Bengio:寻找具备理性的AI模型

评论