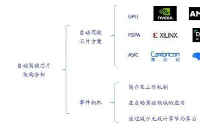

尽管模仿人类思想和想法的软件算法是人工智能的基础,但硬件也是一个重要组成部分,这就是现场可编程门阵列 (FPGA) 和图形处理单元(GPU)发挥重要作用的地方。

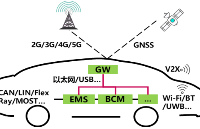

人工智能 (AI) 是指能够以与人类相同的方式做出决策的非人类机器智能。这包括沉思、适应能力、意图能力和判断力。机器视觉、机器人自动化、认知计算、机器学习和计算机视觉都是人工智能市场的应用。人工智能正在汽车、消费电子、媒体和娱乐以及半导体等多个行业领域迅速获得关注,预示着下一次伟大的技术变革。

半导体预计将在未来几年持续增长。随着全球对机器学习设备的需求不断增长,许多属于 EDA(电子设计自动化)、显卡、游戏、多媒体行业的主要市场参与者正在投资提供创新的高速计算处理器。虽然人工智能主要基于模仿人类思想和想法的软件算法,但硬件也是一个重要组成部分。现场可编程门阵列 (FPGA) 和图形处理单元 (GPU) 是大多数 AI 操作的两种主要硬件解决方案。据先行研究组预测,2021年全球人工智能硬件市场规模为104.1亿美元,预计到2030年将达到892.2亿美元,2022-2030年复合年增长率为26.96%

FPGA 和 GPU 概述

FPGA 概述

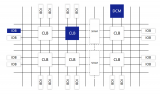

具有可重新编程逻辑门的硬件电路称为现场可编程门阵列 (FPGA)。当芯片在现场使用时,用户可以通过覆盖配置来设计独特的电路。这与不能重新编程的标准芯片形成对比。使用 FPGA 芯片,您可以构建从简单的逻辑门到多核芯片组的任何东西。FPGA 的使用非常流行,其中内部电路是必不可少的,并且预计会发生变化。FPGA 应用涵盖 ASIC 原型设计、汽车、多媒体、消费电子产品以及更多领域。根据应用要求,可选择低端、中端或高端 FPGA 配置。Lattice 半导体的 ECP3 和 ECP5 系列、Xilinx 的 Artix-7/Kintex-7 系列和 Intel 的 Stratix 系列是一些流行的低功耗和低设计密度的 FPGA 设计。

逻辑块是使用具有有限输入的查找表 (LUT) 构建的,并使用基本存储器(例如 SRAM 或闪存)来构建以存储布尔函数。每个 LUT 都链接到一个多路复用器和一个触发器寄存器以支持时序电路。同样,许多 LUT 可用于创建复杂的功能。

FPGA 更适合嵌入式应用,并且比 CPU 和 GPU 使用的功率更低。这些电路不受 GPU 等设计的限制,可用于定制数据类型。此外,FPGA 的可编程性使得修改它们变得更加简单。

使用 FPGA 的优势

高效节能

借助 FPGA,设计人员可以精确调整硬件以满足应用程序的要求。凭借其低功耗能力,可以最大限度地降低 AI 和 ML 应用程序的整体功耗。这可以延长设备的使用寿命并降低培训的总体成本。

易于灵活

FPGA 为处理 AI/ML 应用程序提供了可编程性的灵活性。可以根据需要对一个单独的块或整个块进行编程。

减少延迟

FPGA 擅长处理短语并减少延迟。减少延迟是指计算系统以最小延迟响应的能力。这在视频监控、视频预处理和后处理以及文本识别等实时数据处理应用中至关重要,在这些应用中,每一微秒都至关重要。因为它们在没有操作系统的裸机环境中运行,所以 FPGA 和 ASIC 比 GPU 更快。

并行处理

FPGA 的操作和能源效率由于它们能够同时执行多项任务甚至指定设备的特定部分用于特定功能而得到显著提高。少量分布式内存包含在 FPGA 特殊架构的结构中,使它们更接近处理器。

GPU 概述

图形处理单元 (GPU) 的最初目的是创建计算机图形和虚拟现实环境,这些环境依赖于复杂的计算和浮点功能来渲染几何对象。没有它们,现代人工智能基础设施将不完整,并且非常适合深度学习过程。

人工智能需求大量数据可供研究和学习以取得成功。要运行人工智能算法并移动大量数据,需要大量的计算能力。GPU 可以执行这些任务,因为它们的创建是为了快速处理生成图形和视频所需的大量数据。它们在机器学习和人工智能应用中的广泛使用部分归功于它们的高计算能力。

GPU 可以同时处理多项计算。因此,可以分布式训练程序,从而大大加快机器学习活动。使用 GPU,您可以添加多个资源需求较低的内核,而不会影响性能或功率。市场上有各种类型的 GPU,通常分为以下几类,例如数据中心 GPU、消费级 GPU 和企业级 GPU。

使用 GPU 的优势

内存带宽

GPU 具有良好的内存带宽,因此在深度学习应用程序中它们往往可以快速执行计算。在大型数据集上训练模型时,GPU 消耗的内存更少。凭借高达 750GB 的内存带宽,它们可以真正加速 AI 算法的快速处理。

多核

通常,GPU 由许多可以组合在一起的处理器集群组成。这使得可以极大地提高系统的处理能力,特别是对于具有并行数据输入、卷积神经网络 (CNN) 和 ML 算法训练的 AI 应用程序。

灵活性

由于 GPU 的并行能力,您可以将 GPU 分组到集群中并在这些集群之间分配作业。另一种选择是使用具有专用集群的单个 GPU 来训练特定算法。具有高数据吞吐量的 GPU 可以并行地对许多数据点执行相同的操作,从而使它们能够以无与伦比的速度处理大量数据。

数据集大小

对于模型训练,AI 算法需要大量数据集,这会导致内存密集型计算。GPU 是高效处理具有许多大于 100GB 的数据点的数据集的最佳选择之一。自并行处理开始以来,它们提供了有效处理基本相同或非结构化数据所需的原始计算能力。

运行 AI 应用程序的两个主要硬件选择是 FPGA 和 GPU。尽管 GPU 可以处理 AI 和深度学习所需的海量数据,但它们在能效、热问题、耐用性以及使用新 AI 算法更新应用程序的能力方面存在局限性。FPGA 为神经网络和 ML 应用程序提供了显着优势。这些包括易于 AI 算法更新、可用性、耐用性和能源效率。

此外,在为 FPGA 创建软件方面取得了重大进展,这使得编译和编程变得更加简单。为了让您的 AI 应用程序取得成功,您必须调查您的硬件可能性。正如所说,在确定行动方案之前,请仔细权衡您的选择。

扫描二维码获取

更多精彩

FPGA设计论坛

欢迎关注至芯科技

至芯官网:www.zxopen.com

至芯科技技术论坛:www.fpgaw.com

至芯科技淘宝网址:

https://zxopen.taobao.com

至芯科技FPGA初级课程(B站):

https://space.bilibili.com/521850676

至芯科技FPGA在线课程(腾讯课堂):

https://zxopenbj.ke.qq.com/

至芯科技-FPGA 交流群(QQ):282124839

更多资料下载欢迎注册http://www.fpgaw.com

扫码加微信回复加群

邀请您加入FPGA学习交流群

欢迎加入至芯科技FPGA微信学习交流群,这里有一群优秀的FPGA工程师、学生、老师、这里FPGA技术交流学习氛围浓厚、相互分享、相互帮助、叫上小伙伴一起加入吧!

原文标题:FPGA还是GPU?AI主芯片将如何选择

文章出处:【微信公众号:FPGA设计论坛】欢迎添加关注!文章转载请注明出处。

-

FPGA

+关注

关注

1629文章

21729浏览量

603054

原文标题:FPGA还是GPU?AI主芯片将如何选择

文章出处:【微信号:gh_9d70b445f494,微信公众号:FPGA设计论坛】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

GPU是如何训练AI大模型的

训练AI大模型需要什么样的gpu

《算力芯片 高性能 CPUGPUNPU 微架构分析》第3篇阅读心得:GPU革命:从图形引擎到AI加速器的蜕变

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】--全书概览

AI时代的芯片革命:GPU、FPGA与TPU竞相涌现

FPGA芯片你了解多少?

FPGA在深度学习应用中或将取代GPU

到底什么是ASIC和FPGA?

FPGA、ASIC、GPU谁是最合适的AI芯片?

FPGA还是GPU?AI主芯片将如何选择

FPGA还是GPU?AI主芯片将如何选择

评论