AIGC 已经火了很长时间了,出现了文本生成图像、文本生成视频、图像生成视频等广泛的应用场景,如今谷歌研究院的一项新研究可以让我们根据输入视频生成其他视频了!

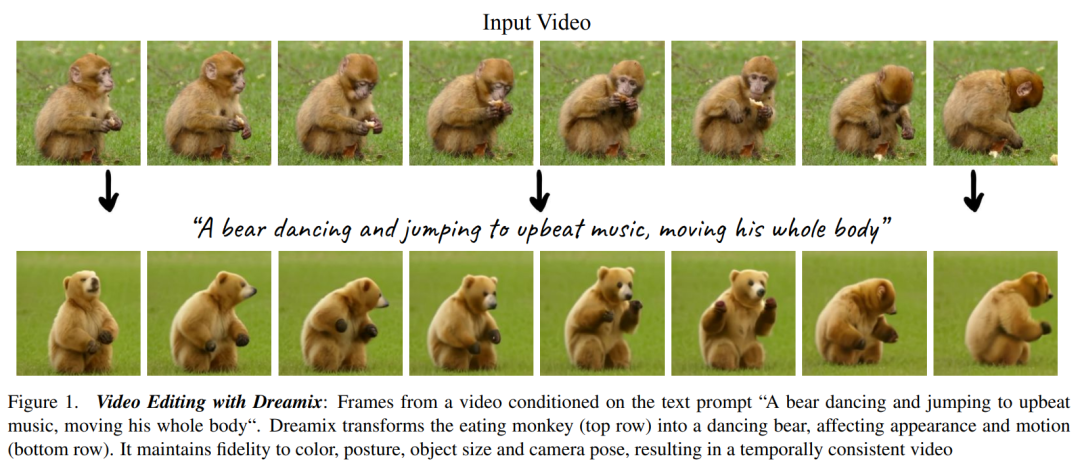

我们知道,生成模型和多模态视觉语言模型的进展已经为具备前所未有生成真实性和多样性的大型文本到图像模型铺平了道路。这些模型提供了新的创作过程,但仅限于合成新图像而非编辑现有图像。为了弥合这一差距,基于文本的直观编辑方法可以对生成和真实图像进行基于文本的编辑,并保留这些图像的一些原始属性。与图像类似,近来文本到视频模型也提出了很多,但使用这些模型进行视频编辑的方法却很少。 在文本指导的视频编辑中,用户提供输入视频以及描述生成视频预期属性的文本 prompt,如下图 1 所示。目标有以下三个方面,1)对齐,编辑后的视频应符合输入文本 prompt;2)保真度,编辑后的视频应保留原始视频的内容,3)质量,编辑后的视频应具备高质量。 可以看到,视频编辑比图像编辑更加具有挑战性,它需要合成新的动作,而不仅仅是修改视觉外观。此外还需要保持时间上的一致性。因此,将 SDEdit、Prompt-to-Prompt 等图像级别的编辑方法应用于视频帧上不足以实现很好的效果。

在近日谷歌研究院等发表在 arXiv 的一篇论文中,研究者提出了一种新方法 Dreamix,它受到了 UniTune 的启发,将文本条件视频扩散模型(video diffusion model, VDM)应用于视频编辑。

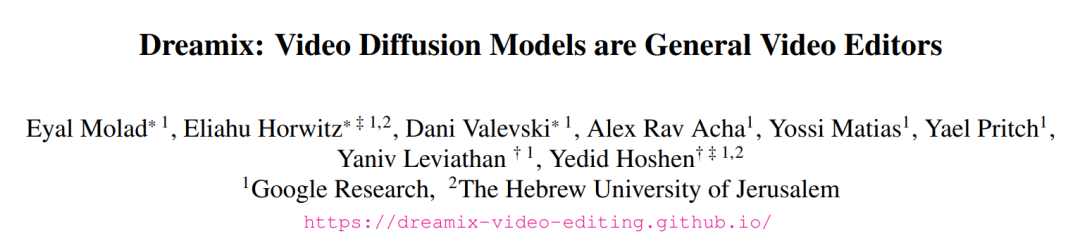

Dreamix: Video Diffusion Models are General Video Editors

论文地址:https://arxiv.org/abs/2302.01329

项目主页:https://dreamix-video-editing.github.io/

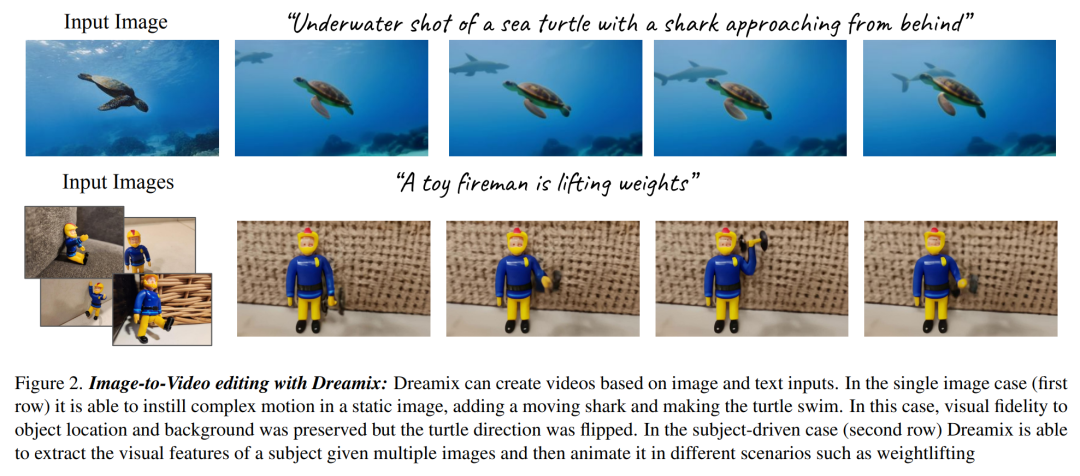

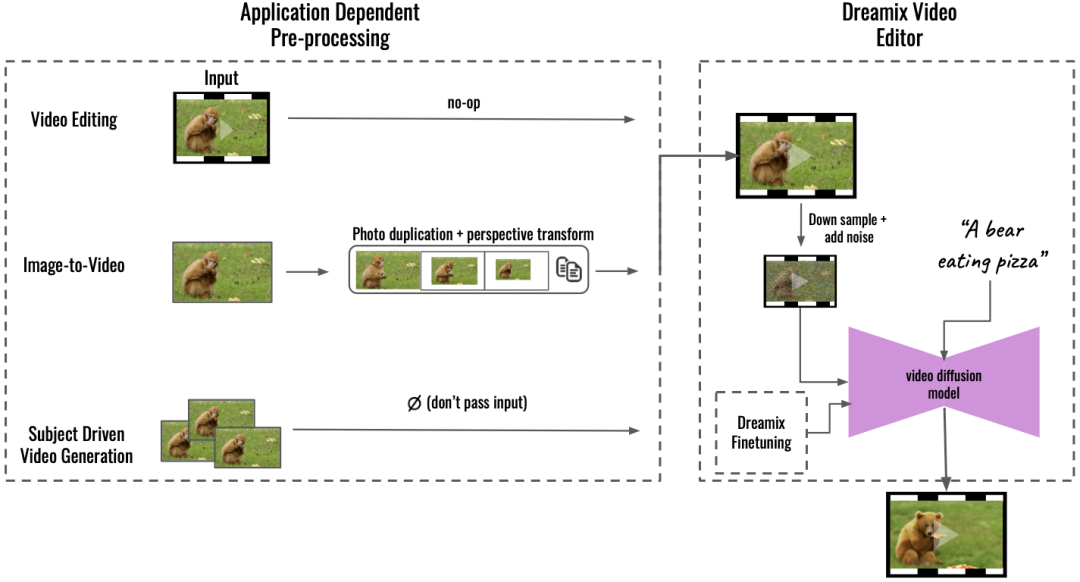

文中方法的核心是通过以下两种主要思路使文本条件 VDM 保持对输入视频的高保真度。其一不使用纯噪声作为模型初始化,而是使用原始视频的降级版本,通过缩小尺寸和添加噪声仅保留低时空信息;其二通过微调原始视频上的生成模型来进一步提升对原始视频的保真度。 微调确保模型了解原始视频的高分辨率属性。对输入视频的简单微调会促成相对较低的运动可编辑性,这是因为模型学会了更倾向于原始运动而不是遵循文本 prompt。研究者提出了一种新颖的混合微调方法,其中 VDM 也在输入视频各个帧的集合上进行微调,并丢弃了它们的时序。混合微调显著提升了运动编辑的质量。 研究者进一步利用其视频编辑模型提出了一个新的图像动画框架,如下图 2 所示。该框架包含了几个步骤,比如为图像中的对象和背景设置动画、创建动态相机运动等。他们通过帧复制或几何图像变换等简单的图像处理操作来实现,从而创建粗糙的视频。接着使用 Dreamix 视频编辑器对视频进行编辑。此外研究者还使用其微调方法进行目标驱动的视频生成,也即 Dreambooth 的视频版本。

在实验展示部分,研究者进行了广泛的定性研究和人工评估,展示了他们方法的强大能力,具体可参考如下动图。

对于谷歌这项研究,有人表示,3D + 运动和编辑工具可能是下一波论文的热门主题。

还有人表示:大家可以很快在预算内制作自己的的电影了,你所需要的只是一个绿幕以及这项技术:

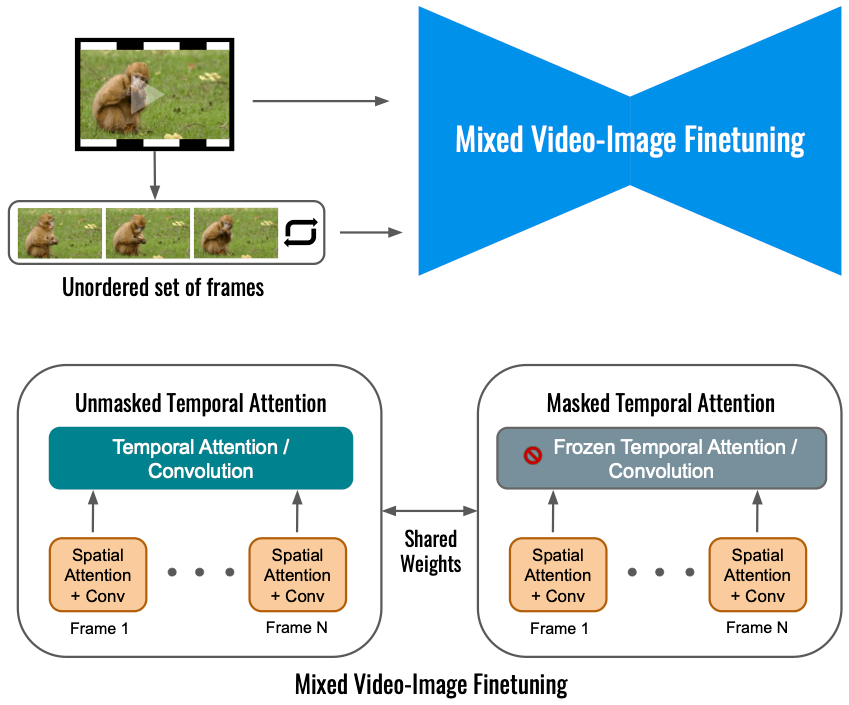

方法概览 本文提出了一种新的方法用于视频编辑,具体而言: 通过逆向被破坏视频进行文本引导视频编辑 他们采用级联 VDM( Video Diffusion Models ),首先通过下采样对输入视频就行一定的破坏,后加入噪声。接下来是级联扩散模型用于采样过程,并以时间 t 为条件,将视频升级到最终的时间 - 空间分辨率。 在对输入视频进行破坏处理的这一过程中,首先需要进行下采样操作,以得到基础模型(16 帧 24 × 40),然后加入方差为 高斯噪声,从而进一步破坏输入视频。 对于上述处理好的视频,接下来的操作是使用级联 VDM 将损坏掉的低分辨率视频映射到与文本对齐的高分辨率视频。这里的核心思想是,给定一个嘈杂的、时间空间分辨率非常低的视频,有许多完全可行的、高分辨率的视频与之对应。本文中基础模型从损坏的视频开始,它与时间 s 的扩散过程具有相同的噪声。然后该研究用 VDM 来逆向扩散过程直到时间 0。最后通过超分辨率模型对视频进行升级。 混合视频图像微调 仅利用输入视频进行视频扩散模型的微调会限制物体运动变化,相反,该研究使用了一种混合目标,即除了原始目标(左下角)之外,本文还对无序的帧集进行了微调,这是通过「masked temporal attention」来完成的,以防止时间注意力和卷积被微调(右下)。这种操作允许向静态视频中添加运动。

高斯噪声,从而进一步破坏输入视频。 对于上述处理好的视频,接下来的操作是使用级联 VDM 将损坏掉的低分辨率视频映射到与文本对齐的高分辨率视频。这里的核心思想是,给定一个嘈杂的、时间空间分辨率非常低的视频,有许多完全可行的、高分辨率的视频与之对应。本文中基础模型从损坏的视频开始,它与时间 s 的扩散过程具有相同的噪声。然后该研究用 VDM 来逆向扩散过程直到时间 0。最后通过超分辨率模型对视频进行升级。 混合视频图像微调 仅利用输入视频进行视频扩散模型的微调会限制物体运动变化,相反,该研究使用了一种混合目标,即除了原始目标(左下角)之外,本文还对无序的帧集进行了微调,这是通过「masked temporal attention」来完成的,以防止时间注意力和卷积被微调(右下)。这种操作允许向静态视频中添加运动。

推理 在应用程序预处理的基础上(Aapplication Dependent Pre-processing,下图左),该研究支持多种应用,能将输入内容转换为统一的视频格式。对于图像到视频,输入图像被复制并被变换,合成带有一些相机运动的粗略视频;对于目标驱动视频生成,其输入被省略,单独进行微调以维持保真度。然后使用 Dreamix Video Editor(右)编辑这个粗糙的视频:即前面讲到的,首先通过下采样破坏视频,添加噪声。然后应用微调的文本引导视频扩散模型,将视频升级到最终的时间空间分辨率。

实验结果 视频编辑:下图中 Dreamix 将动作改为舞蹈,并且外观由猴子变为熊,但视频中主体的基本属性没有变:

Dreamix 还可以生成与输入视频时间信息一致的平滑视觉修改,如下图会滑滑板的小鹿:

图像到视频:当输入是一张图像时,Dreamix 可以使用其视频先验添加新的移动对象,如下图中添加了在有雾的森林中出现一头独角兽,并放大。

小屋旁边出现企鹅:

目标驱动视频生成:Dreamix 还可以获取显示相同主题的图像集合,并以该主题为运动对象生成新的视频。如下图是一条在叶子上蠕动的毛毛虫:

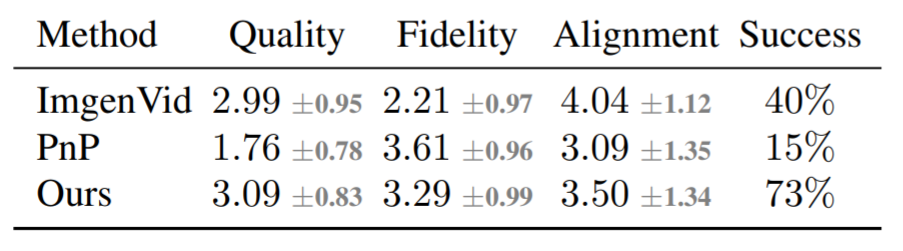

除了定性分析外,该研究还进行了基线比较,主要是将 Dreamix 与 Imagen-Video、 Plug-and-Play (PnP) 两种基线方法进行对比。下表为评分结果:

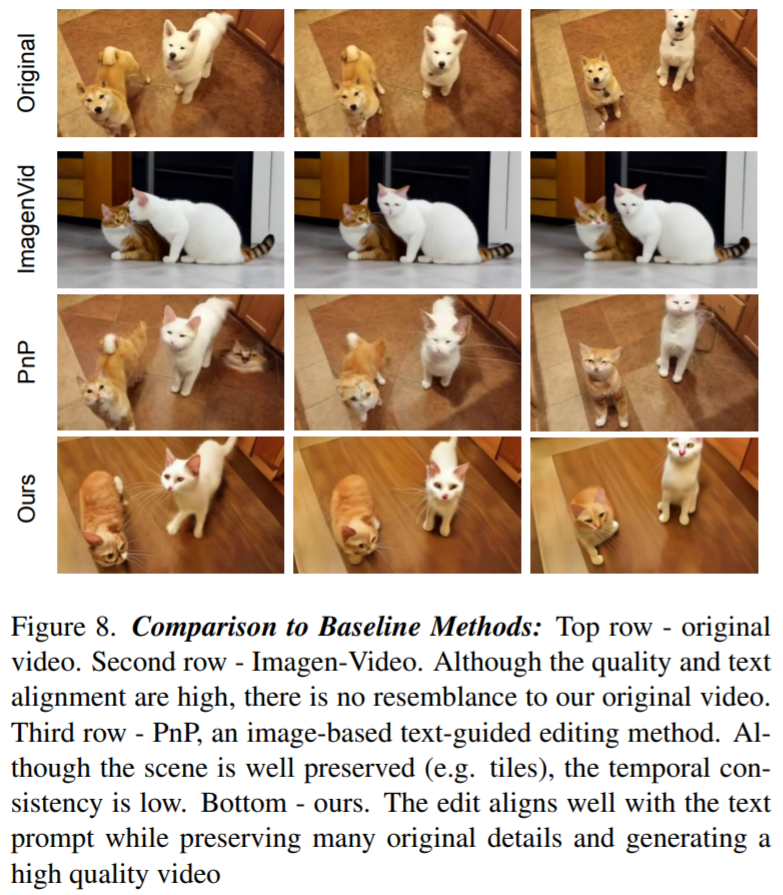

图 8 展示了由 Dreamix 编辑的视频和两个基线示例:文本到视频模型实现了低保真度的编辑,因为它不以原始视频为条件。PnP 保留了场景,但不同帧之间缺乏一致性;Dreamix 在这三个目标上都表现良好。

审核编辑 :李倩

-

视频

+关注

关注

6文章

1959浏览量

73202 -

编辑器

+关注

关注

1文章

807浏览量

31333 -

语言模型

+关注

关注

0文章

545浏览量

10358

原文标题:谷歌新作Dreamix:视频扩散模型是通用视频编辑器,效果惊艳!

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

OpenAI暂不推出Sora视频生成模型API

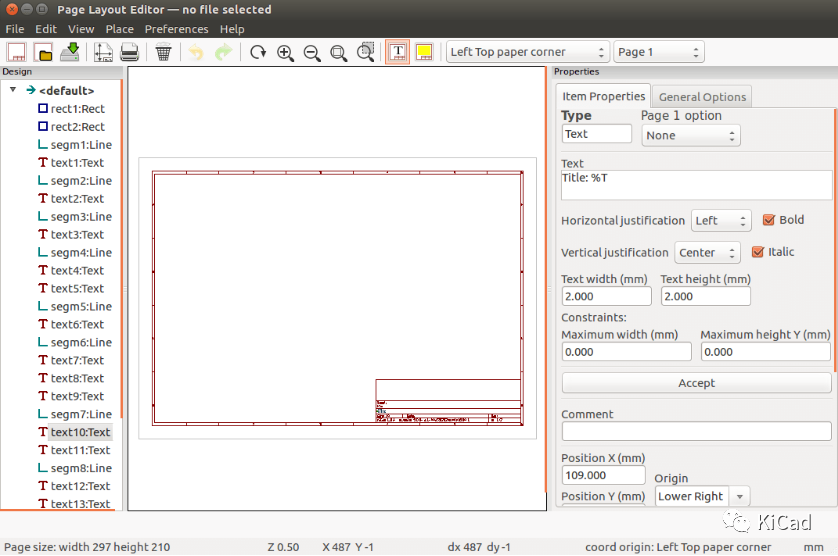

图纸编辑器的基本操作

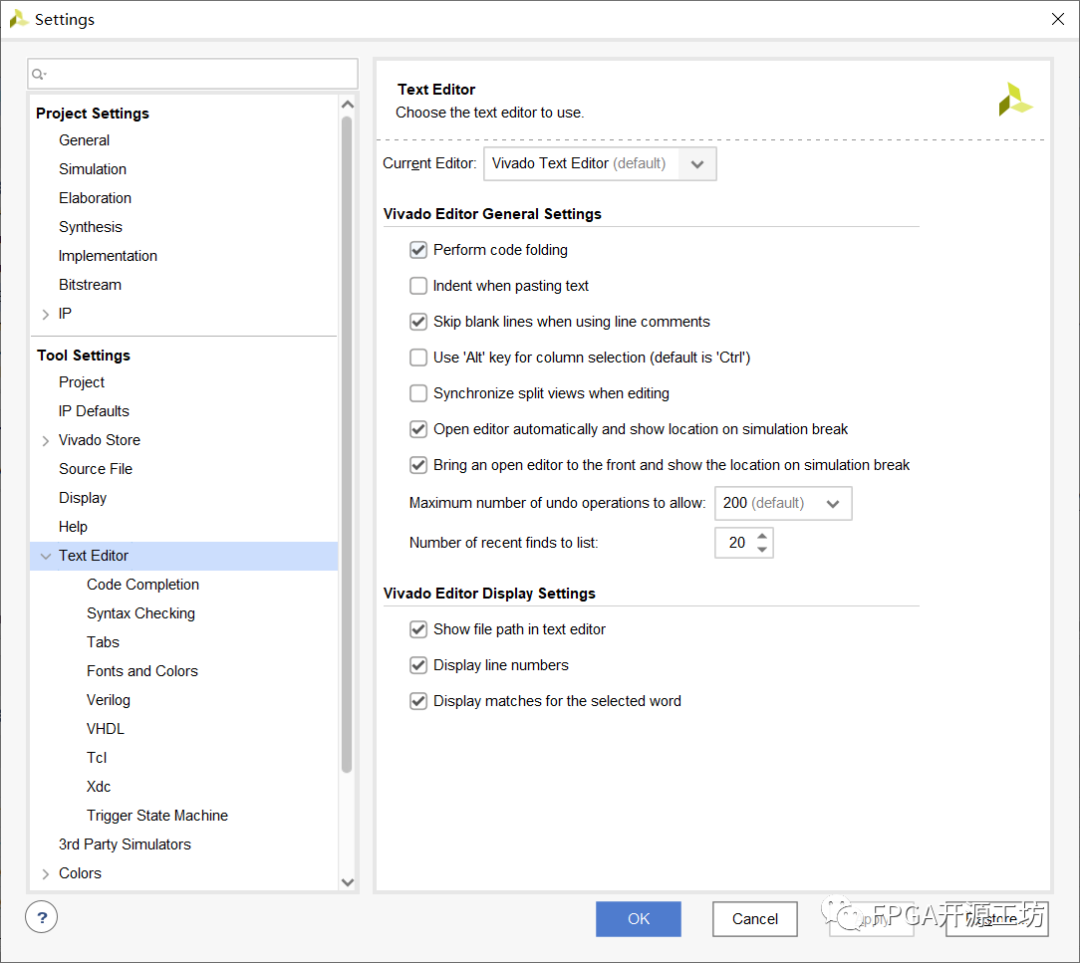

Vivado编辑器乱码问题

vim编辑器命令模式使用方法

vim编辑器如何使用

嵌入式学习-常用编辑器之Vim编辑器

常用编辑器之Vim编辑器

Sora还在PPT阶段,“中国版Sora”已经开放使用了!

TSMaster 中 Hex 文件编辑器使用详细教程

谷歌新作Dreamix:视频扩散模型是通用视频编辑器,效果惊艳!

谷歌新作Dreamix:视频扩散模型是通用视频编辑器,效果惊艳!

评论