趁着ChatGPT这一热门话题还未消退,我们来聊一聊这类大规模语言模型(LLM)或通用人工智能(AGI)背后的细节。毕竟目前相关的概念股跟风大涨,但还是有不少人在持观望态度。无论是国外还是国内,有没有可能做出下一个ChatGPT?以及打造这样一个模型所需的研发成本和运营成本究竟是多少。

ChatGPT背后的成本,以及GPU厂商等候多时的增长点

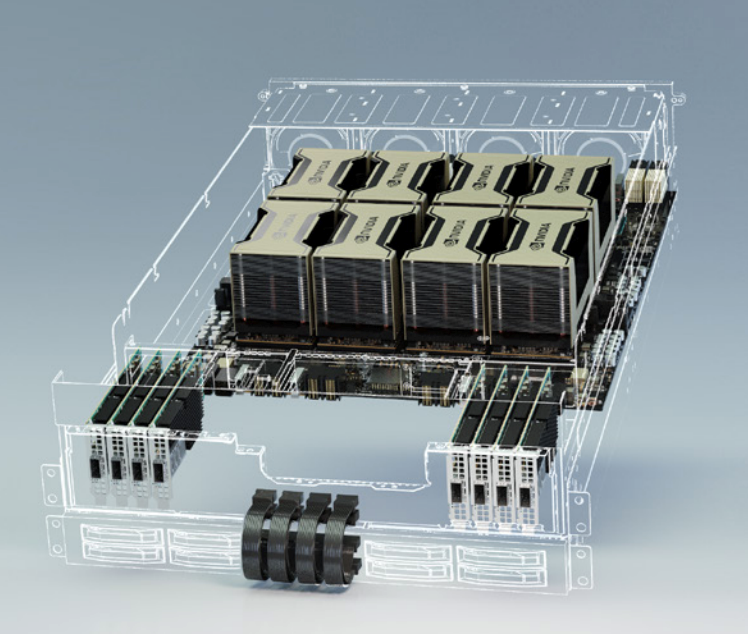

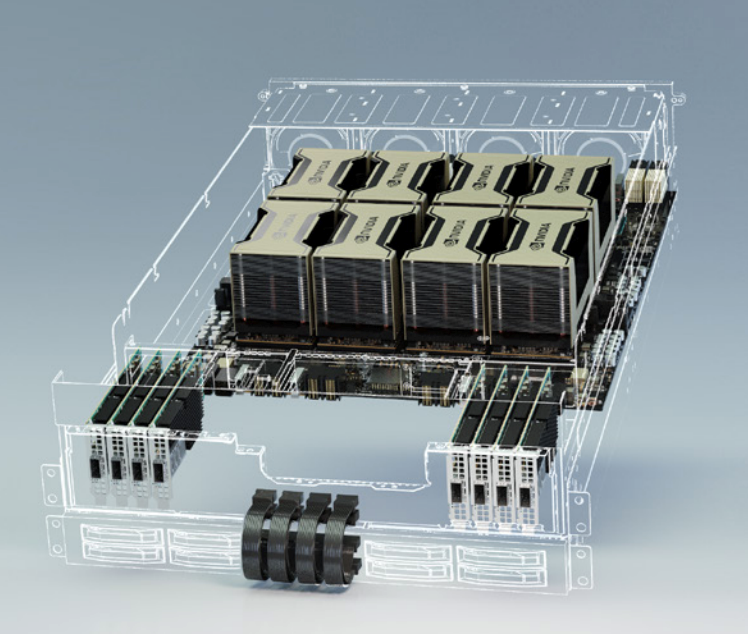

首先,ChatGPT是OpenAI预训练的对话模型,除去训练本身所需的硬件与时间成本外,运营时的推理成本也要算在其中。根据UBS分析师Timothy Arcuri的观点,ChatGPT使用到了至少1万块英伟达的GPU来运营这一模型。不过这还是相对较为保守的数据,根据Semianalysis分析师Dylan Patel对模型参数、日活跃用户数以及硬件利用率等种种因素的分析,他粗略估计OpenAI需要用到3617个HGX A100服务器来维持ChatGPT的运转。

HGX A100 / 英伟达

需要注意的是,该分析中的HGX A100服务器是8块A100 SXM的定制化模块,并非DGX A100这样集成了AMD CPU的标准服务器模块,也就是说共需28936块英伟达A100 GPU。且不说A100本身就高昂的售价,更何况现在还有一定的溢价。一张40GB的A100 PCIe卡,目前在亚马逊上的单价为8000多美元,而80GB的A100 PCIe卡价格在15000美元左右浮动。

由此估算,运行ChatGPT的前期设备投入成本少说也有2.3亿美元,这其中还没算进CPU、内存、硬盘和网关等设备的硬件成本。所有GPU同时运转时的TDP功耗达到7234kW。按照美国商用电价来计算的话,哪怕是每日运转单由GPU带来的电费也至少要两万美元以上。这样的设备成本除非是微软、谷歌、亚马逊这样本就手握大把服务器硬件资源的厂商,否则很难支撑这一模型的日常运转。

接着我们再从每次查询的推理成本这个角度来看,如果只负责在服务器上部署ChatGPT的OpenAI无需考虑设备购入成本,而是只考虑GPU云服务器的定价。根据Dylan Patel的估算,ChatGPT每次查询的成本为0.36美分,约合2.4分人民币,每天在硬件推理上的成本也高达70万美元。由此来看,无论是OpenAI现在免费提供的ChatGPT,还是微软在Bing上启用的ChatGPT,其实都是在大把烧钱。

要知道,现在还只是用到了ChatGPT这一文本语言模型,根据OpenAI的CEO Sam Altman的说法,他们的AI视频模型也在准备当中。而要想打造更复杂的视频模型,势必会对GPU算力提出更高的要求。

未来的硬件成本会更低吗?

对于任何一个想要运行ChatGPT这类服务的厂商,打造这样一款应用都要付出不小的成本,所以现阶段还是微软、谷歌之类的巨头相互博弈。但Sam Altman也表示,随着越来越多的竞争出现,毋庸置疑会把硬件成本压低,也会把每个Token的定价压低。

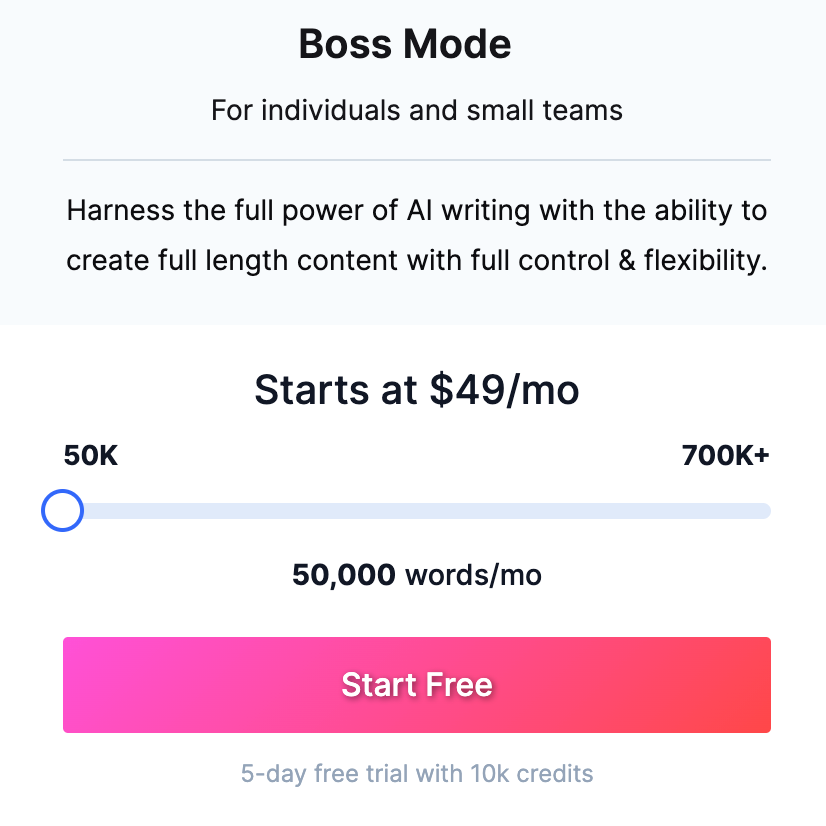

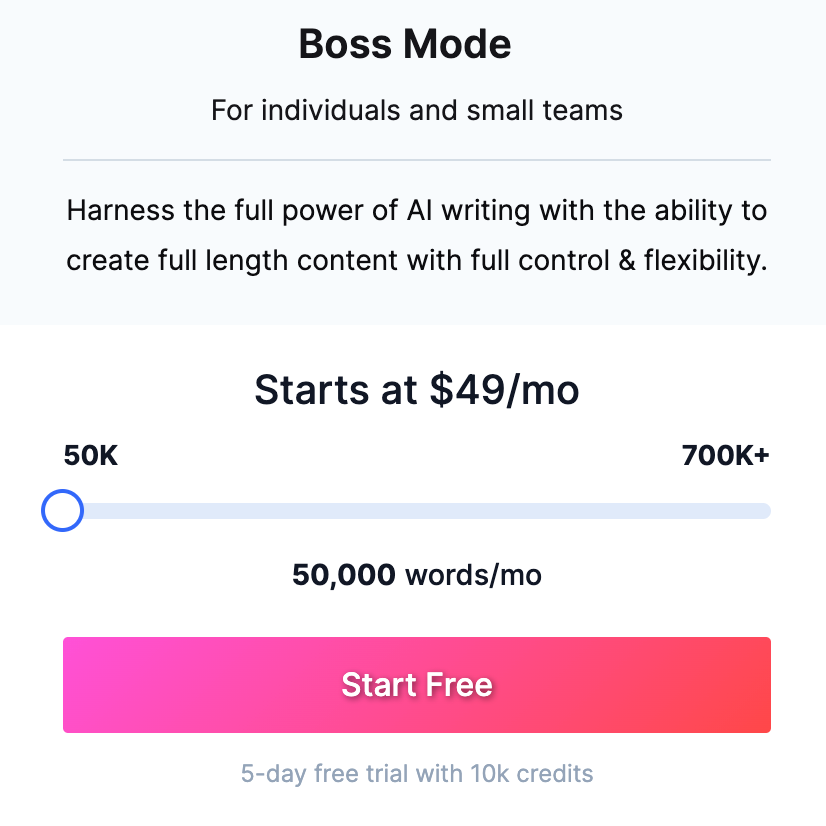

Jasper AI写作工具的定价 / Jasper.ai

大家可以参照一下其他利用OpenAI的GPT-3的AI工具,比如Jasper。Jasper作为一个人工智能写作软件,每月需要缴纳50美元,才能享受5万字的写作字数上限。而反观ChatGPT,哪怕是目前的免费版也能帮你写就长篇故事了。而这些工具鼓吹的多种模板,在ChatGPT中也只是换一种问法而已。

Sam Altman认为会有更多的玩家入局AGI,如此一来ChatGPT这种类型的服务会出现在更多的产品和应用中,而不再只是作为大厂的附庸,比如只在微软的Bing、Office中大规模使用等,这也是OpenAI还考虑授权给其他公司的原因。

不过如果依照谷歌的访问和搜索量来部署ChatGPT或Bard这样类似模型的话,所需的成本必定要远远高于Bing,毕竟谷歌依然是目前国际领先的搜索引擎。

如果谷歌用其TPU之类的专用硬件来完成LLM的训练与推理,其成本必然显著低于GPU这类通用硬件的,毕竟TPU这类ASIC芯片在量产成本和运行功耗上都有着得天独厚的优势。

但谷歌如果使用专用硬件的话,可能会存在强制绑定的问题,哪怕谷歌选择公开TPU商业运营,如果想用集成Bard的合作客户也基本与谷歌云绑定了,就像现在的ChatGPT与微软Azure强制绑定一样。而且如果Bard出现算法路线上的大变动,TPU这种ASIC方案很难再对其进行针对性优化。

由此可以看出,虽然大小入局者众多,但真正落地、可大规模使用且还算好用的产品还是只有ChatGPT一个,要想等到行业内卷压低成本,可能还得等上很长一段时间。

ChatGPT如何实现盈利?

微软高调宣布与OpenAI合作,并将ChatGPT融入Bing等一系列微软产品中,这已经不是什么新闻了。但其实这样的合作关系昭示了ChatGPT的一种盈利方式,那就是授权。除了微软这种深度合作的厂商以外,其他应用开发商也可以采用授权的方式,将ChatGPT集成到自己的产品中去。

不过Sam Altman在接受外媒采访时表示,他们目前在授权上的合作还并不多。由此猜测,要么是此类授权费用昂贵,要么就是缺少成熟的产品形态来应用这一技术,毕竟当下还算强相关的应用也只有搜索引擎、写作工具以及AI助手等。再说,对于感兴趣想尝鲜的厂商来说,直接接入OpenAI的API或许价格反倒更低。

另一种盈利方式,也是现在最流行且已被普遍接受的收费模式,订阅制。2月1日,OpenAI正式推出了20美元一个月的ChatGPT Plus,提供高峰时期的访问、更快的响应速度以及新功能和改进的抢先体验。

结语

总的来说,ChatGPT这类AGI作为元宇宙之后的又一大风口,激发了一股初创公司入局LLM的热潮。但从客观来看,对于这些初创公司来说,他们打从一开始根本不需要考虑市场风险,比如这会不会是个伪需求。他们更应该担心的应该是技术风险,也就是究竟有没有这个实力和资本去打造一个可用的LLM。

ChatGPT背后的成本,以及GPU厂商等候多时的增长点

首先,ChatGPT是OpenAI预训练的对话模型,除去训练本身所需的硬件与时间成本外,运营时的推理成本也要算在其中。根据UBS分析师Timothy Arcuri的观点,ChatGPT使用到了至少1万块英伟达的GPU来运营这一模型。不过这还是相对较为保守的数据,根据Semianalysis分析师Dylan Patel对模型参数、日活跃用户数以及硬件利用率等种种因素的分析,他粗略估计OpenAI需要用到3617个HGX A100服务器来维持ChatGPT的运转。

HGX A100 / 英伟达

需要注意的是,该分析中的HGX A100服务器是8块A100 SXM的定制化模块,并非DGX A100这样集成了AMD CPU的标准服务器模块,也就是说共需28936块英伟达A100 GPU。且不说A100本身就高昂的售价,更何况现在还有一定的溢价。一张40GB的A100 PCIe卡,目前在亚马逊上的单价为8000多美元,而80GB的A100 PCIe卡价格在15000美元左右浮动。

由此估算,运行ChatGPT的前期设备投入成本少说也有2.3亿美元,这其中还没算进CPU、内存、硬盘和网关等设备的硬件成本。所有GPU同时运转时的TDP功耗达到7234kW。按照美国商用电价来计算的话,哪怕是每日运转单由GPU带来的电费也至少要两万美元以上。这样的设备成本除非是微软、谷歌、亚马逊这样本就手握大把服务器硬件资源的厂商,否则很难支撑这一模型的日常运转。

接着我们再从每次查询的推理成本这个角度来看,如果只负责在服务器上部署ChatGPT的OpenAI无需考虑设备购入成本,而是只考虑GPU云服务器的定价。根据Dylan Patel的估算,ChatGPT每次查询的成本为0.36美分,约合2.4分人民币,每天在硬件推理上的成本也高达70万美元。由此来看,无论是OpenAI现在免费提供的ChatGPT,还是微软在Bing上启用的ChatGPT,其实都是在大把烧钱。

要知道,现在还只是用到了ChatGPT这一文本语言模型,根据OpenAI的CEO Sam Altman的说法,他们的AI视频模型也在准备当中。而要想打造更复杂的视频模型,势必会对GPU算力提出更高的要求。

未来的硬件成本会更低吗?

对于任何一个想要运行ChatGPT这类服务的厂商,打造这样一款应用都要付出不小的成本,所以现阶段还是微软、谷歌之类的巨头相互博弈。但Sam Altman也表示,随着越来越多的竞争出现,毋庸置疑会把硬件成本压低,也会把每个Token的定价压低。

Jasper AI写作工具的定价 / Jasper.ai

大家可以参照一下其他利用OpenAI的GPT-3的AI工具,比如Jasper。Jasper作为一个人工智能写作软件,每月需要缴纳50美元,才能享受5万字的写作字数上限。而反观ChatGPT,哪怕是目前的免费版也能帮你写就长篇故事了。而这些工具鼓吹的多种模板,在ChatGPT中也只是换一种问法而已。

Sam Altman认为会有更多的玩家入局AGI,如此一来ChatGPT这种类型的服务会出现在更多的产品和应用中,而不再只是作为大厂的附庸,比如只在微软的Bing、Office中大规模使用等,这也是OpenAI还考虑授权给其他公司的原因。

不过如果依照谷歌的访问和搜索量来部署ChatGPT或Bard这样类似模型的话,所需的成本必定要远远高于Bing,毕竟谷歌依然是目前国际领先的搜索引擎。

如果谷歌用其TPU之类的专用硬件来完成LLM的训练与推理,其成本必然显著低于GPU这类通用硬件的,毕竟TPU这类ASIC芯片在量产成本和运行功耗上都有着得天独厚的优势。

但谷歌如果使用专用硬件的话,可能会存在强制绑定的问题,哪怕谷歌选择公开TPU商业运营,如果想用集成Bard的合作客户也基本与谷歌云绑定了,就像现在的ChatGPT与微软Azure强制绑定一样。而且如果Bard出现算法路线上的大变动,TPU这种ASIC方案很难再对其进行针对性优化。

由此可以看出,虽然大小入局者众多,但真正落地、可大规模使用且还算好用的产品还是只有ChatGPT一个,要想等到行业内卷压低成本,可能还得等上很长一段时间。

ChatGPT如何实现盈利?

微软高调宣布与OpenAI合作,并将ChatGPT融入Bing等一系列微软产品中,这已经不是什么新闻了。但其实这样的合作关系昭示了ChatGPT的一种盈利方式,那就是授权。除了微软这种深度合作的厂商以外,其他应用开发商也可以采用授权的方式,将ChatGPT集成到自己的产品中去。

不过Sam Altman在接受外媒采访时表示,他们目前在授权上的合作还并不多。由此猜测,要么是此类授权费用昂贵,要么就是缺少成熟的产品形态来应用这一技术,毕竟当下还算强相关的应用也只有搜索引擎、写作工具以及AI助手等。再说,对于感兴趣想尝鲜的厂商来说,直接接入OpenAI的API或许价格反倒更低。

另一种盈利方式,也是现在最流行且已被普遍接受的收费模式,订阅制。2月1日,OpenAI正式推出了20美元一个月的ChatGPT Plus,提供高峰时期的访问、更快的响应速度以及新功能和改进的抢先体验。

结语

总的来说,ChatGPT这类AGI作为元宇宙之后的又一大风口,激发了一股初创公司入局LLM的热潮。但从客观来看,对于这些初创公司来说,他们打从一开始根本不需要考虑市场风险,比如这会不会是个伪需求。他们更应该担心的应该是技术风险,也就是究竟有没有这个实力和资本去打造一个可用的LLM。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

ChatGPT

+关注

关注

29文章

1577浏览量

8185 -

LLM

+关注

关注

0文章

306浏览量

458

发布评论请先 登录

相关推荐

小白学大模型:构建LLM的关键步骤

随着大规模语言模型(LLM)在性能、成本和应用前景上的快速发展,越来越多的团队开始探索如何自主训练LLM模型。然而,是否从零开始训练一个LLM,并非每个组织都适合。本文将根据不同的需求

什么是LLM?LLM在自然语言处理中的应用

随着人工智能技术的飞速发展,自然语言处理(NLP)领域迎来了革命性的进步。其中,大型语言模型(LLM)的出现,标志着我们对语言理解能力的一次飞跃。LLM通过深度学习和海量数据训练,使得机器能够以前

LLM技术对人工智能发展的影响

随着人工智能技术的飞速发展,大型语言模型(LLM)技术已经成为推动AI领域进步的关键力量。LLM技术通过深度学习和自然语言处理技术,使得机器能够理解和生成自然语言,极大地扩展了人工智能的应用范围

LLM和传统机器学习的区别

在人工智能领域,LLM(Large Language Models,大型语言模型)和传统机器学习是两种不同的技术路径,它们在处理数据、模型结构、应用场景等方面有着显著的差异。 1. 模型结构

端到端InfiniBand网络解决LLM训练瓶颈

ChatGPT对技术的影响引发了对人工智能未来的预测,尤其是多模态技术的关注。OpenAI推出了具有突破性的多模态模型GPT-4,使各个领域取得了显著的发展。 这些AI进步是通过大规模模型训练实现

ChatGPT背后的AI背景、技术门道和商业应用

作者:京东科技 李俊兵 各位看官好,我是球神(江湖代号)。 自去年11月30日ChatGPT问世以来,迅速爆火出圈。 起初我依然以为这是和当年Transformer, Bert一样的“热点”模型

大模型LLM与ChatGPT的技术原理

在人工智能领域,大模型(Large Language Model, LLM)和ChatGPT等自然语言处理技术(Natural Language Processing, NLP)正逐步改变着人类

llm模型有哪些格式

LLM(Large Language Model,大型语言模型)是一种深度学习模型,主要用于处理自然语言处理(NLP)任务。LLM模型的格式多种多样,以下是一些常见的LLM模型格式

llm模型和chatGPT的区别

,有许多不同的LLM模型,如BERT、GPT、T5等。 ChatGPT是一种基于GPT(Generative Pre-trained Transformer)模型的聊天机器人。GPT模型是一种

LLM模型的应用领域

在本文中,我们将深入探讨LLM(Large Language Model,大型语言模型)的应用领域。LLM是一种基于深度学习的人工智能技术,它能够理解和生成自然语言文本。近年来,随着计算能力的提高

什么是LLM?LLM的工作原理和结构

随着人工智能技术的飞速发展,大型语言模型(Large Language Model,简称LLM)逐渐成为自然语言处理(NLP)领域的研究热点。LLM以其强大的文本生成、理解和推理能力,在文本

大语言模型(LLM)快速理解

自2022年,ChatGPT发布之后,大语言模型(LargeLanguageModel),简称LLM掀起了一波狂潮。作为学习理解LLM的开始,先来整体理解一下大语言模型。一、发展历史大语言模型的发展

OpenAI 深夜抛出王炸 “ChatGPT- 4o”, “她” 来了

当地时间5月13日OpenAI推出ChatGPT-4o,代表了人工智能向前迈出的一大步。在GPT-4turbo的强大基础上,这种迭代拥有显著的改进。在发布会的演示中,OpenAI展示该模型的高级

发表于 05-27 15:43

在FPGA设计中是否可以应用ChatGPT生成想要的程序呢

当下AI人工智能崛起,很多开发领域都可看到ChatGPT的身影,FPGA设计中,是否也可以用ChatGPT辅助设计呢?

发表于 03-28 23:41

LLM风口背后,ChatGPT的成本问题

LLM风口背后,ChatGPT的成本问题

评论