电子发烧友网报道(文/李弯弯)近日消息,随着ChatGPT的热潮,华为昇腾AI服务器、拓维信息兆瀚RA5900-A系列AI训练服务器等询单量及预定量爆发式增长。

AI服务器通常搭载GPU、FPGA、ASIC等加速芯片,利用CPU与加速芯片的组合可以满足高吞吐量互联的需求,为自然语言处理、计算机视觉、机器学习等AI应用场景提供强大的算力支持,支撑AI算法训练和推理。

AI服务器与普通服务器的区别

服务器是一种高性能计算机,作为网络的节点,存储、处理网络上80%的数据、信息,因此也被称为网络的灵魂。普通服务器是以CPU为计算能力的提供者,采用串行架构,擅长逻辑计算和浮点计算。由于逻辑判断需要大量的分支跳转,使得CPU的结构复杂,计算能力的提高主要靠堆积更多的核心数来实现。

在大数据、云计算、人工智能、元宇宙、数据孪生和物联网等网络技术的应用中,互联网上的数据呈现出几何倍数的增长,这对以CPU为主要计算能力来源的传统服务是巨大的考验。目前,CPU的制程工艺和单个CPU的核心数接近极限,但数据的增加仍在继续,因此有必要提高服务器的数据处理能力。在这种环境下,AI服务器应运而生。

AI服务器与普通服务器的区别:在服务器的硬件架构方面,AI服务器是异构服务器,可以根据应用范围采用不同的组合方式,如CPU + GPU、CPU + TPU、CPU + 其他加速卡等。与普通服务器相比,内存、存储、网络没有区别,主要是大数据、云计算、人工智能等方面需要更多的内存,满足各种数据的收集整理。

普通GPU服务器一般是单卡或者双卡,AI服务器需要承担大量计算,一般配置四块以上的GPU卡,甚至搭建一个AI服务器集群;AI服务器需要独特的设计,由于AI服务器有多个GPU卡,需要对系统结构、散热和拓扑进行专门设计,以满足AI服务器长期稳定运行的要求。

目前市场上的AI服务器普遍采用CPU + GPU,由于GPU和CPU形式不同所以AI服务器采用并行计算模式,善于梳理图形渲染、机器学习等密集数据操作。在GPU上,NVIDIA优势明显,GPU单卡核心数可达近千个,如配置16张NVIDIATesla V100 Tensor Core 32GB GPUs核心数可超过10240个,计算性能高达每秒2千万亿次。而且经过近几年市场的发展,也证实了CPU +GPU异构服务器在当前环境下确实有很大的发展空间。

AI服务器市场现状及主要玩家

近几年,中国市场的AI服务器出货量和渗透率都在提升。未来预计随着AI模型训练和应用的兴起,需要支持AI功能的服务器将持续增加。IDC预计,中国AI服务器2021年的市场规模为57亿美元,同比增长61.6%,到2025年市场规模将增长到109亿美元,CAGR为17.5%。

根据其此前发布的《中国加速计算市场(2021年下半年)跟踪报告》,2021年全年中国AI服务器市场规模达350.3亿元,同比增长68.6%。浪潮信息、宁畅、新华三、华为、安擎位居前五,占据了82.6%的市场份额。其中,浪潮AI服务器市场占有率达52.4%。

近日,浪潮信息在某平台上表示,公司在人工智能服务器领域的市占率位居全球AI服务器市场第一,在ChatGPT和AIGC相关方向上已有布局相关业务。日前消息,淮海智算中心携手浪潮信息进行了超大规模参数AI大模型训练性能测试,实测数据表明,千亿参数规模的自然语言AI单体大模型在淮海智算中心计算平台上的训练算力效率达53.5%,刷新了业内AI大模型训练算力效率新高。

宁畅在AI服务器方面已经发布多款产品,比如X620 G50,这是一款基于第四代英特尔至强可扩展处理器的高端2U机架式服务器。可根据业务需求对资源进行灵活配置,满足各种各行业应用需求。完美适用于机器学习、AI推理、云计算、高性能计算、云存储、大数据、虚拟化、办公系统等应用场景。

还有上文提到的拓维信息,早在ChatGPT爆发之前,就已布局了一系列人工智能产品。该公司表示,旗下兆瀚智能计算产品包括AI推理、AI训练、AI集群等,具有超强AI算力、更优AI能效、最佳AI拓展等产品特点,在行业内有领先优势。

未来,拓维信息将持续重点关注先进计算、人工智能等前沿技术领域,加大在人工智能产业的规划布局及基础软硬件产业投入,充分发挥自身在人工智能领域的影响力。通过与华为的全方位深入合作,推出基于昇腾处理器的兆瀚AI产品,努力构筑业界超强AI算力平台。

中科曙光在AI服务器上也有布局。据介绍,中科曙光已推出“全浸没式液冷AI训练专用服务器”,与百度、复旦大学等企业及科研院所深度合作,形成了诸多基于AI模型的联合解决方案,支持了国内多个千亿级以上参数规模的AI大模型训练,攻克类脑智能、基因技术、自动驾驶等多个前沿领域AI难题。

此外还有中国长城、神州数码、广电运通等。中国长城在芯片、整机、服务器、网络交换机、路由器、工业控制系统、容灾备份产品等自主安全产品谱系逐步成为相关市场的主导产品,AI服务器已实现量产。神州数码之前推出了神州鲲泰人工智能推理服务器,以“鲲鹏+昇腾”为核心,可提供128个处理核心的算力,同时最大可支持8张华为Atlas 300推理卡,提供256GB推理缓存,以及最大704 TOPS INT8的AI算力。

小结

过去几年人工智能发展迅速,作为算力支撑的AI服务器市场在不断增加。如今在ChatGPT爆火下,人工智能训练和推理寻求将持续扩大,预计未来AI服务器市场规模将继续保持高速增长趋势。而在其中布局已久的浪潮、中科曙光、宁畅、拓维信息等无疑将更具优势。

AI服务器通常搭载GPU、FPGA、ASIC等加速芯片,利用CPU与加速芯片的组合可以满足高吞吐量互联的需求,为自然语言处理、计算机视觉、机器学习等AI应用场景提供强大的算力支持,支撑AI算法训练和推理。

AI服务器与普通服务器的区别

服务器是一种高性能计算机,作为网络的节点,存储、处理网络上80%的数据、信息,因此也被称为网络的灵魂。普通服务器是以CPU为计算能力的提供者,采用串行架构,擅长逻辑计算和浮点计算。由于逻辑判断需要大量的分支跳转,使得CPU的结构复杂,计算能力的提高主要靠堆积更多的核心数来实现。

在大数据、云计算、人工智能、元宇宙、数据孪生和物联网等网络技术的应用中,互联网上的数据呈现出几何倍数的增长,这对以CPU为主要计算能力来源的传统服务是巨大的考验。目前,CPU的制程工艺和单个CPU的核心数接近极限,但数据的增加仍在继续,因此有必要提高服务器的数据处理能力。在这种环境下,AI服务器应运而生。

AI服务器与普通服务器的区别:在服务器的硬件架构方面,AI服务器是异构服务器,可以根据应用范围采用不同的组合方式,如CPU + GPU、CPU + TPU、CPU + 其他加速卡等。与普通服务器相比,内存、存储、网络没有区别,主要是大数据、云计算、人工智能等方面需要更多的内存,满足各种数据的收集整理。

普通GPU服务器一般是单卡或者双卡,AI服务器需要承担大量计算,一般配置四块以上的GPU卡,甚至搭建一个AI服务器集群;AI服务器需要独特的设计,由于AI服务器有多个GPU卡,需要对系统结构、散热和拓扑进行专门设计,以满足AI服务器长期稳定运行的要求。

目前市场上的AI服务器普遍采用CPU + GPU,由于GPU和CPU形式不同所以AI服务器采用并行计算模式,善于梳理图形渲染、机器学习等密集数据操作。在GPU上,NVIDIA优势明显,GPU单卡核心数可达近千个,如配置16张NVIDIATesla V100 Tensor Core 32GB GPUs核心数可超过10240个,计算性能高达每秒2千万亿次。而且经过近几年市场的发展,也证实了CPU +GPU异构服务器在当前环境下确实有很大的发展空间。

AI服务器市场现状及主要玩家

近几年,中国市场的AI服务器出货量和渗透率都在提升。未来预计随着AI模型训练和应用的兴起,需要支持AI功能的服务器将持续增加。IDC预计,中国AI服务器2021年的市场规模为57亿美元,同比增长61.6%,到2025年市场规模将增长到109亿美元,CAGR为17.5%。

根据其此前发布的《中国加速计算市场(2021年下半年)跟踪报告》,2021年全年中国AI服务器市场规模达350.3亿元,同比增长68.6%。浪潮信息、宁畅、新华三、华为、安擎位居前五,占据了82.6%的市场份额。其中,浪潮AI服务器市场占有率达52.4%。

近日,浪潮信息在某平台上表示,公司在人工智能服务器领域的市占率位居全球AI服务器市场第一,在ChatGPT和AIGC相关方向上已有布局相关业务。日前消息,淮海智算中心携手浪潮信息进行了超大规模参数AI大模型训练性能测试,实测数据表明,千亿参数规模的自然语言AI单体大模型在淮海智算中心计算平台上的训练算力效率达53.5%,刷新了业内AI大模型训练算力效率新高。

宁畅在AI服务器方面已经发布多款产品,比如X620 G50,这是一款基于第四代英特尔至强可扩展处理器的高端2U机架式服务器。可根据业务需求对资源进行灵活配置,满足各种各行业应用需求。完美适用于机器学习、AI推理、云计算、高性能计算、云存储、大数据、虚拟化、办公系统等应用场景。

还有上文提到的拓维信息,早在ChatGPT爆发之前,就已布局了一系列人工智能产品。该公司表示,旗下兆瀚智能计算产品包括AI推理、AI训练、AI集群等,具有超强AI算力、更优AI能效、最佳AI拓展等产品特点,在行业内有领先优势。

未来,拓维信息将持续重点关注先进计算、人工智能等前沿技术领域,加大在人工智能产业的规划布局及基础软硬件产业投入,充分发挥自身在人工智能领域的影响力。通过与华为的全方位深入合作,推出基于昇腾处理器的兆瀚AI产品,努力构筑业界超强AI算力平台。

中科曙光在AI服务器上也有布局。据介绍,中科曙光已推出“全浸没式液冷AI训练专用服务器”,与百度、复旦大学等企业及科研院所深度合作,形成了诸多基于AI模型的联合解决方案,支持了国内多个千亿级以上参数规模的AI大模型训练,攻克类脑智能、基因技术、自动驾驶等多个前沿领域AI难题。

此外还有中国长城、神州数码、广电运通等。中国长城在芯片、整机、服务器、网络交换机、路由器、工业控制系统、容灾备份产品等自主安全产品谱系逐步成为相关市场的主导产品,AI服务器已实现量产。神州数码之前推出了神州鲲泰人工智能推理服务器,以“鲲鹏+昇腾”为核心,可提供128个处理核心的算力,同时最大可支持8张华为Atlas 300推理卡,提供256GB推理缓存,以及最大704 TOPS INT8的AI算力。

小结

过去几年人工智能发展迅速,作为算力支撑的AI服务器市场在不断增加。如今在ChatGPT爆火下,人工智能训练和推理寻求将持续扩大,预计未来AI服务器市场规模将继续保持高速增长趋势。而在其中布局已久的浪潮、中科曙光、宁畅、拓维信息等无疑将更具优势。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

AI

+关注

关注

87文章

30643浏览量

268824 -

ChatGPT

+关注

关注

29文章

1558浏览量

7585

发布评论请先 登录

相关推荐

ChatGPT短暂“罢工”,云服务器还能用吗?

日,备受欢迎的AI聊天机器人ChatGPT突然遭遇了一次短暂的服务中断,这让不少用户心生疑虑:云服务器,这个支撑起无数互联网应用的强大后盾,究竟还靠谱吗?

什么是AI服务器?AI服务器的优势是什么?

AI服务器是一种专门为人工智能应用设计的服务器,它采用异构形式的硬件架构,通常搭载GPU、FPGA、ASIC等加速芯片,利用CPU与加速芯片的组合来满足高吞吐量互联的需求,为自然语言处理、计算机视觉、机器学习等人工智能应用场景提

AI服务器的特点和关键技术

AI服务器,即人工智能服务器,是一种专门设计用于运行和加速人工智能(AI)算法与模型的硬件设备。随着人工智能技术的快速发展和普及,AI

性能与安全同样重要,苹果的AI服务器

Intelligence通过生成式模型来改善用户的使用体验。事实上,苹果一共有两个自主开发的AI模型,一个用于设备端AI的30亿参数模型,以及一个更大的LLM,其服务器资源满足更多的查询。 苹果

英伟达新业务动向:AI服务器市场的新变局

在全球AI技术迅猛发展的浪潮中,英伟达正积极布局,寻求新的业务增长点。据最新报道,英伟达计划为其即将推出的GB200旗舰人工智能芯片设计服务器机架,此举无疑将对该领域的传统厂商如戴尔、HPE和AMD等构成一定压力,甚至可能引发

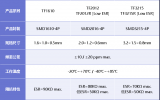

差分晶振在AI服务器中的应用案例

随着ChatGPT技术不断发展和应用,我国AI服务器市场保持较快增速(预计 2023年我国服务器市场规模将增至308亿美元),而AI

发表于 06-17 15:15

•1次下载

英伟达首次向OpenAI供应AI服务器,鸿海出货预期将增长

自2017年起,鸿海便开始与英伟达合作开发服务器,其中包括世界上首台AI服务器HGX1。值得注意的是,OpenAI成立之初,有一张照片展示了黄仁勋赠予马斯克一台AI

服务器远程不上服务器怎么办?服务器无法远程的原因是什么?

产生问题的原因,检查硬盘和服务器系统。通过日志和检查数据来确认问题出

现的原因以及如何解决。

三、端口问题

1.端口错误

找回正确的端口或更换远程端口

2.端口被扫爆

更改端口,并在防火墙禁止扫爆的IP

发表于 02-27 16:21

【国产FPGA+OMAPL138开发板体验】(原创)6.FPGA连接ChatGPT 4

访问ChatGPT 4这样的AI模型是非常复杂的,因为这涉及到大量的数据传输、协议实现、并行处理、优化等等。更重要的是,ChatGPT 4这样的模型通常是运行在强大的服务器集群上。不过

发表于 02-14 21:58

如何配置单台服务器

万里征途总是从第一步开始的,构建一个复杂系统也是如此。我们从简单的部分着手,先让所有的功能都在一个服务器上运行。图1-1展示了如何配置单台服务器,让一切都在其上运行,包括Web应用、数据库、缓存等。

AI服务器简介及晶振应用

AI服务器,是一种专门用于处理人工智能相关任务的高性能计算机。它具备强大的计算能力和存储能力,能够快速处理大量的数据和复杂的算法。与传统的计算设备相比,AI服务器具有更高的计算效率和更

物理服务器对ai发展的应用

物理服务器在AI发展中扮演着重要的角色。传统的以CPU为计算部件的服务器架构已难以满足人工智能的新需求,因此,"CPU+ GPU/FPGA/ASIC"的异构计算架构成为人工智能服务器的

ChatGPT热潮引发AI服务器爆单

ChatGPT热潮引发AI服务器爆单

评论