这篇文章来源于DevicePlus.com英语网站的翻译稿。

尽管语音交互正像触摸屏那样为数字接口带来重大变革,但语言处理有其局限性。特别是,数字语言处理仅限于有限且特定的指令,尚未具备人类对话中的情境理解能力。

在相关领域的前沿研究中,麻省理工学院(MIT)计算机科学与人工智能实验室(CSAIL)的研究人员致力于构建一个更好的处理单元,使机器人不需要循序渐进的指令,而是可以从指令和语境中的上下文来对事物进行推断。

因此,“ComText”诞生了,这是一个处理系统,代表“上下文中的指令”,使机器人可以理解聊天背景信息,如语言线索和周围环境。

为什么上下文很重要?

在自然语言的使用中,经常说类似于“把它捡起来”这样的话。虽然人类能够根据情境来理解这里的“它”指的是什么,但如今的数字化助手或机器人需要更多的信息才能够理解,因为指令缺乏特定性。

MIT 解释说:“捡起它意味着能够看到并识别物体,理解指令,识别出问题中的“它”指的是你放下的工具,回到你放下手中工具的记忆中,并将你放下的工具与其他类似形状和尺寸的工具区分开来。

目前,像Alexa和Siri这样的数字化助手正在彻底改变我们与科技互动的方式,但要让机器人个人助理不断发展,这种对于情境的理解能力是必不可少的。

ComText 的实际应用:语言处理

ComText 的实际应用:空间理解

挑战

RAGE Frameworks的首席执行官Venkat Srinivasan认为这种交互的挑战主要有三点。

首先,许多支持语音的人工智能工具,比如IBM Watson和Google AlphaGo,在处理人类语言方面存在困难,因为“当前大多数应用是将文本视为数据,而不是语言”。

第二点是情境理解:“只有当技术专注于语言结构,而不是像目前大多数技术所做的那样仅仅注意文本中的单词时,才能进行正确的情境理解。”

最后一个挑战是逻辑:使用这个解决方法得出的结论,其推理之间的可追溯性。

“情境学习”的研究与发展

根据这篇研究论文,为了开发ComText,一个研究团队使用了“强化自然语言的概率模型”。

“主要贡献在于告诉了我们机器人应该像人类那样有多种类型的记忆,” 首席研究员Andrei Barbu表示,“我们有了解决这个问题的第一个数学公式,现在正在探索这两种类型的记忆是如何相互配合并发挥作用的。”

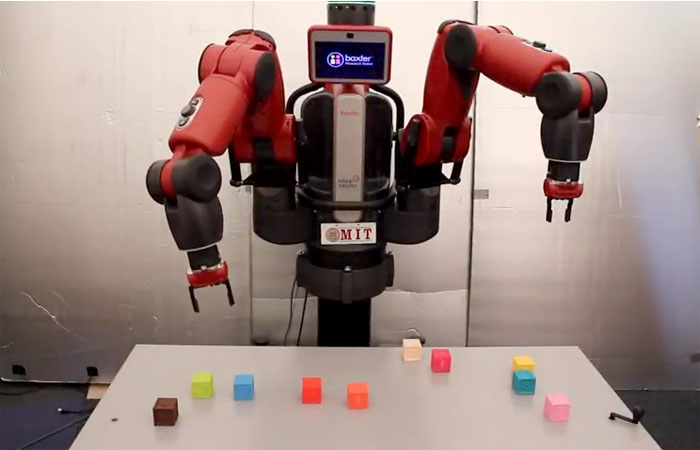

为了测试这个工具,研究者使用了一个名叫Baxter Research Robot(百特研究机器人)的双臂人形机器人,在频率∼20Hz、分辨率1080×760的条件下,使用交叉校准的Kinect 2版 RGB-D观察工作区。配置有一个Amazon Echo Dot(亚马逊回声点),可以将语音指令转换为文本。

为了研究该机器如何有效地对上下文线索进行评估,要求独立操作的人员直接指示机器人完成五项任务,最后制作了96个用户与机器人交互的短视频。通过对视频进行分析,研究者发现在90.2%到94.7%的时间,推断出的命令以“在目标位置,对正确的物品执行正确的操作”的方式被执行。

发生失败主要是由于感知错误,或由于障碍物遮挡了视线,或因为物体直接朝向或远离相机的移动。

这个实验成功的证明了ComText从以往的语言陈述中搜集线索,并将它们与视觉观察相结合,然后对移动物体进行追踪的能力。随着时间的推移,通过更多的交互和观察,这些积累起来的经验也会被逐渐细化。

个人助理机器人的潜在应用

虽然关于AI伦理问题的偏见仍然存在,但ComText在发展成为具有更接近“人类交互能力”的机器人方面依然取得了重大进展。不过,现实情况是,要实现一个能理解人类互动细微差别全功能助手机器人,我们还有很长的路要走。

首席研究员Rohan Paul 表示:“目前,我们还没有生产产品。” 与之相对的是,他们仍然坚持如何在机器搜集更大范围的上下文信息并得出结论的能力方面得到提高,Paul说:“我们真正想做的是让人类和机器人的能力相结合,一起来创造出更复杂的东西。”

DevicePlus 编辑团队

设备升级版适用于所有热爱电子和机电一体化的人。

审核编辑黄宇

-

机器人

+关注

关注

210文章

28266浏览量

206722

发布评论请先 登录

相关推荐

这批中国企业,在做人形机器人触觉传感器

NLP技术在聊天机器人中的作用

【书籍评测活动NO.51】具身智能机器人系统 | 了解AI的下一个浪潮!

机器人技术的发展趋势

AI大模型的最新研究进展

星尘智能Astribot S1亮相世界机器人大会

清华大学:软体机器人柔性传感技术最新研究进展

视觉传感器助力机器人“看到”并理解周围世界

Al大模型机器人

视觉机器人焊接的研究现状

具备情境理解能力的个人助理机器人研究进展

具备情境理解能力的个人助理机器人研究进展

评论