一:数据中心空调负荷分析

一般而言,建筑面积小于 200㎡ 称为小型数据中心;建筑面积在 200~500㎡之间为中型数据中心。建筑面积在 500~2000㎡之间为中、大型数据中心。建筑面积在 2000~10000㎡为大型数据中心。建筑面积大于 10000㎡则称为超大数据中心。

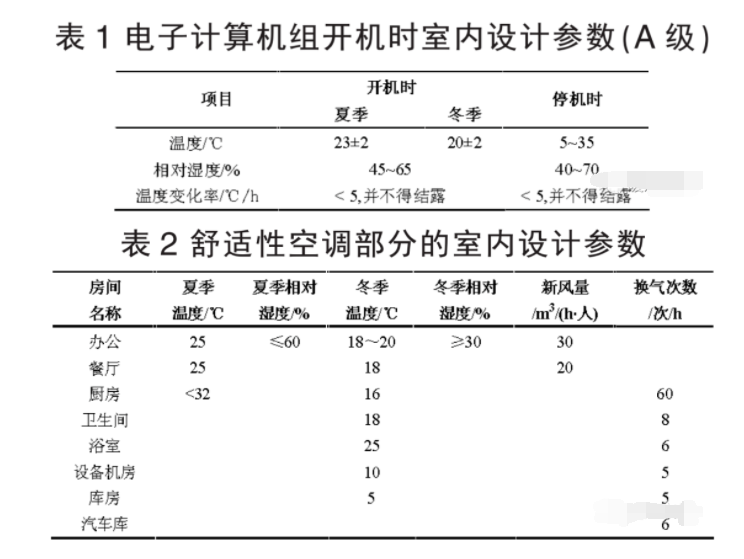

1、室内设计参数

对于超大型数据中心建筑而言,建筑的主要功能房间是数据机房。但除了主要功能的数据机房以外,还需要有大量其他功能的房间,如:办公、餐饮、车库等,以满足数据中心正常运行维护所需。

将主要空调房间分为两类:数据机房属工艺性空调房间,其室内设计参数按照数据机房的工艺性要求选取。其他办公、餐饮等房间属舒适性空调房间,室内参数按照普通舒适性房间的要求选取。

工艺性空调部分(数据机房)的室内设计参数,其温度、湿度指标均执行 A 级标准,如表 1 所示。舒适性空调部分的室内设计参数,如表 2 所示。

2、冷热负荷

在数据机房建筑中,通常室外环境对室内的影响较小,空调的热湿负荷主要来自于室内。机柜设备散热量大且热源集中,需全年向外排热,即使在冬季也有相当大的冷负荷。机柜设备无散湿量,主机房内的散湿量主要来自于工作人员,而大中型电子计算机主机房内工作人员较少,因此主机房内的散湿量很小,同时新风负荷也较小。

此外,主机房对照明的要求通常不高,因而机房内照明负荷与设备用电负荷相比很低,照明发热量不大。大中型电子计算机一般都全年内长时间连续运行,在计算主机房内的负荷时可按开机时的要求进行设计。在本工程中,电子计算机房的新风量取机房空调总循环风量的 5%。

归纳起来,机房空调的热湿负荷主要包括以下内容:机房内电子计算机和其它设备的散热;人体散热、湿;照明装置散热;新风负荷;建筑围护结构的传热以及太阳辐射得热。

二、系统形式选择

1、冷源

处于对数据机房安全性保障的考虑,空调系统进行了冗余设计。所谓冗余,是指空调系统中重复配置一定的设备,当系统发生故障时,冗余配置的设备投入使用,承担故障设备的工作,由此减少系统的故障时间。

由于数据机房的重要性为 A 类,因此空调系统的设计采用了 N+N 的冗余设计,以达到设备互为备份的作用。各数据机房均采用双冷源(冷冻水和直接蒸发式冷媒)的恒温空调系统,室内的末端机组同时接空调冷冻水管和冷媒管道。在一般情况下,系统由离心式冷水机组通过冷冻水系统供冷;当遇有冷冻机组或水泵、管道等故障发生的情况下,切换至直接蒸发式空调系统供冷;在停电等情况发生时,由柴油发电机组供给计算机房用直接蒸发式空调系统工作。

2、末端

对于数据机房建筑,机房内部的空调末端形式以及气流组织设计,一直是影响空调效率和效果的重要部分。近年来,随着数据机房的大量出现,国内外也逐渐形成了比较成熟的室内空调气流组织的解决方案和相应的专业设计团队。这些解决方案针对不同规模、不同等级的数据机房,综合考虑室内环境控制与节能的需求。

此外,每层电子计算机房设置新风机组,以保证专用计算机房的正压。按电子计算机房新风量的 80%为平时的排风量。同时,设置一套电子计算机房内气体灭火系统作用完毕后的专用排风系统,按 5 次 /h气次数计算。

三、数据中心空调节能问题

数据中心空调的能效为何如此之低?通过对当前数据中心的研究发现,大多数数据中心的空调系统都存在着如下一系列的设计问题。

1、系统整合难、切换难、维护难。

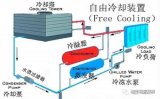

为了服务器工作人为营造低温环境,完全采用人工制冷,没有利用自然冷源自然冷却。改进冷源形式往往是最为经济有效的节能方法,制冷机在空调系统中耗电最大,以冷却塔免费供冷代替制冷机,依靠自然冷源提供冷量,会使空调系统的整体运行能耗大幅下降,是效果显著的节能途径。而在实际应用中,采用自然冷源存在系统整合难、切换难、维护难的特点,所以目前国内只有少部分的大型数据中心成功有效的使用了该技术。

2、没有充分利用空调系统的诸多节能技术。

空调系统中节能效果突出的余热回收、蓄冷、变风量、变频等技术,在数据中心中很少采用。因为数据中心所其提供服务的特殊性,数据安全是首要因素,宕机是不允许出现的情况。空调系统作为服务器正常工作的保障,管理者更关注其制冷能力是否有足够的冗余量,某台空调发生故障时能否及时开启备用设备,对设计的要求必然保守。而节能技术需要积少成多、其效果需日积月累才能体现,如果担心某技术对空调的稳定性可能产生影响,往往倾向于不采用。

3、空调设备制冷量与实际负荷的匹配存在问题。

机房内的机架通常是逐步投入、不断扩容的,而空调负荷与气流组织则是建设阶段对机房整体考虑设计的。运行初期投入使用的机架数少,空调系统部分负荷下运行,效率不高。而后期投入使用的新型的机架,往往功率更大,发热密度更高,却受制于机房现有格局,不能被摆放在气流组织有利的位置。这样,随着机架不断进场,机房内始终冷热不均,管理者只能调低空调机的温度设定值,造成过度制冷,导致空调能耗居高不下。

4、设计选用的空调机型参数与机房运行时的真实热工况存在偏差。

据调查发现,目前约 85%的数据中心空调机组耗能比设计工况高 50% 以上。现行数据中心设计均参照的是国标《电子信息系统机房设计规范》及美国 TIA-942 标准,精密空调机组的设计运行温 / 湿度为 23℃±1℃/50%,加之现有精密空调生产厂家所提供的室内机回风工况参数多为 24℃/50%。 故空调设计时多按照此工况点进行选型。而服务器机架的发展趋势是高度集成化,单个机架的功率越来越大,机柜出风口温度很高,实际运行中很容易出现局部温控点温度超标的现象,应对办法就是将空调机组设定的回风温度 24℃ 调低。 假如调低空调机组设定温度 2℃, 那么按回风参数24℃ 选型出来的空调机组对应 22℃ 的工况点,直接膨胀式空调压缩机 COP 值会下降约 7%,显冷量会下降 8%~19%,冷冻水式空调机组的显冷量会下降 13%~16%。因机房负荷全部是显热负荷,则能耗增加了大约 15%~25%。若继续调低空调机运行工况参数设定点,对应的能耗会呈现非线性的增长。

( 5)精密空调机组温湿度一起控制的模式,造成了先除湿再加湿的能耗浪费。

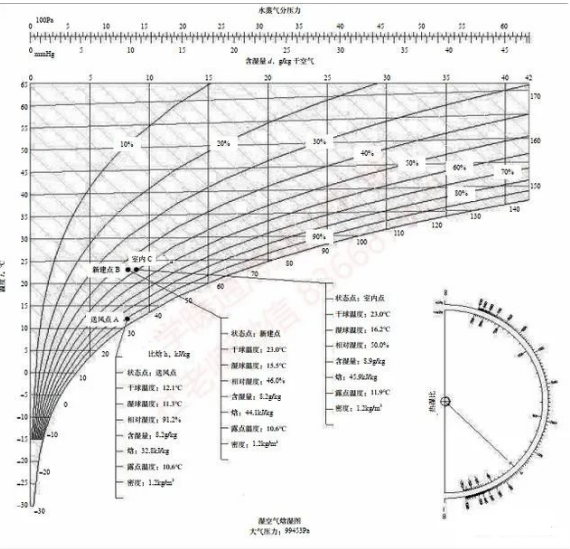

在干球温度 23℃,相对湿度 50% 的室内状态点,露点温度为 11.9℃,空气经过表冷器时降温除湿。而机房运行过程中基本无散湿量,所以空气湿度降低,超过设定下限后空调自动开启加湿功能,此时加湿器给空气等温加湿,增加了空调潜热冷负荷,空调能耗显著上升。

四、某数据中心节能改造案例 大连地区一个 2500 个机架的数据中心。其改造设计如下: 选用 800RT 离心式冷水机组三台(输入功率466kW), 400RT 螺杆式冷水机组两台(输入功率265kW),总制冷量 3200RT,另根据机房级别设置备用。运营初期负荷极小的情况下,利用螺杆机调节范围的优势,避免部分负荷的低能效和系统喘振。根据气象参数、工程设计条件确定系统供回水温度,计算免费供冷的切换温度并结合实际情况适当降低确定实际切换温度,以避免频繁切换,获得合理的免费供冷期。 期内对应制冷机设计匹配的冷却塔、板式换热器,用于自然冷却免费间接供冷。当季节过渡,室外湿球温度超过切换温度时开启制冷机,制冷机配变频器可实现冷却水的低温运行,最低运行温度可低至 13℃。更低的冷凝侧温度使机组在小压缩比工况下工作,性能系数 COP 值大幅提高,相当于间接利用了自然冷源免费供冷。 配合以上技术措施,冷冻水侧采用 12℃/18℃的高水温,一方面进一步降低压缩比,另一方面高于室内空气 11.9℃ 的露点温度,实现了空调末端干工况运行。干工况不仅简化了系统,更适用于机房的工作环境,更是杜绝了不必要的除湿再加湿过程抵消的制冷量。与提高的冷冻水温相对应,空调器回风温度提高至 30℃,既加大了送风温差降低能耗,又使末端设定工况更接近实际情况,有利于运行的控制。 本工程采用的各项技术措施之间关系密切,不可相互孤立使用,需结合实际情况整体性灵活运用。

改造经济指标如下: 按照该数据中心节能设计,冷却水夏季 30/36,冬季 10/16 经板换至 12/18 冷冻水 12/18。夏季冷却塔冷幅 5℃,湿球温度 25℃。冬季冷却塔冷幅 8℃,切换湿球温度 2℃。根据设计温度可确定空调系统免费供冷期约为 100 天,过渡期约为 120 天,夏季标准运行工况约为 145 天。

(1)免费供冷期 单台制冷机压缩机运行功率 413kW,全部自然冷却,相当于可节约电量 413kW,考虑管道电伴热、积水盘电加热等因素,节能效果按 75% 计算,则 4 台机组共节能 413×75%×4=1239kW,年节约电量 297 万 kW·h。

(2)过渡季 制冷机配变频器可实现冷却水低温运行,最低温度可达 13℃。整个过渡季按冷却水平均水温22/28℃ 考虑,冷冻水按 7/12℃ 考虑,同一制冷机组较标准工况下输入功率降低, 800RT 的制冷机在过渡季实际运行功率为 413kW,则 4 台机组共节能99×4=396kW,年节约电量 114 万 kW·h。

(3)夏季 提高冷冻水温,制冷机 COP 提升带来的能耗节约:

合计年节约电量 81 万 kW·h。

(4)常规冷冻水供回水温度

7/12℃ 工况下,整个数据中心机房部分选用空调器 54 台,空调器单 台 制 冷 量 170kW, 风 量 41400m3/h, 输 入 功 率8.0kW。其送风状态点 A(见下页焓湿图):干球温度 12.1℃,湿球温度 11.3℃, d=8.2g/kg。机房内基本无湿负荷,空气吸收机架散热后升温到新建状态点 B:干 球 温 度 23℃, d=8.2g/kg,i=44.1kj/kg;再通过而电极式蒸汽加湿器等温加湿,到达室内状态点 C:干球温度 23℃, d=8.9g/kg , i=45.9kj/kg。从B 到 C 过程的⊿ i=1.8 kj/kg,即为除湿又加湿过程增加的潜热冷负荷:1.8kj/kg×41400m3/h×1.2kg/m3×54=1341kW。 按冷水机组 COP 值 6.0 计算,此部分耗电功率223.5kw,即为可节约能耗。全年可以节约电量为196 万 kW·h。

(5)提高冷冻水温带来了空调器末端制冷能力的降低

整个数据中心机房部分选用空调器 54 台,空调器单台制冷量 170kW,风量 41400m3/h,输入功率 11.2kW。常规冷冻水供回水温度 7/12℃ 工况下,单台空调器输入功率只需要 8.0kW。故单台能耗增加 3.2kW, 54 台机组共增加 172.8kW。全年增加耗电量 151 万 kW·h。 各项措施综合累计节能效果:297+114+81+196-151=537kW。 本数据中心设计年耗电量为 7737 万 kW·h,其中空调系统耗电约为 3100 万 kW·h。采用本技术措施节能约 17.32%。

编辑:黄飞

-

数据中心

+关注

关注

16文章

5044浏览量

72967 -

空调系统

+关注

关注

0文章

104浏览量

18007

原文标题:案例设计 | 如何设计数据中心空调系统和节能?

文章出处:【微信号:通信电源技术,微信公众号:通信电源技术】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

数据中心子系统的组成

国际数据中心及云计算产业展览会

数据中心光互联解决方案

数据中心太耗电怎么办

数据中心是什么

如何去提高数据中心的运营效率呢

基于预测的数据中心应用服务节能调度系统

数据中心行业电能质量监测与治理方案

数据中心空调系统节能技术白皮书

详细的数据中心空调系统设计方案解析

精密空调—模块化精密空调方案,让数据中心更可靠!

数据中心空调系统和节能设计方案

数据中心空调系统和节能设计方案

评论