电子发烧友网报道(文/李弯弯)近段时间,由OpenAI推出的ChatGPT火遍全球,它几乎可以生成任何形式的文本,从写文章、编写代码,到回答复杂的数学问题。上线近两个月,ChatGPT的注册用户就达到1亿,成为史上用户破亿速度最快的软件之一。

ChatGPT的爆火给生成式AI的应用带来更多可能性,AI语言处理大模型也随之进入全球角逐的新阶段。在国内,百度、阿里等头部互联网企业都已经宣布有相关的研究。那么,国内在发展AI语言处理大模型方面是否具备相应的条件,国产厂商可以如何把握这个机会?

在AIGC大模型发展上,国内具备哪些条件

从目前的情况来看,国内在发展这类大模型上可以说已经具备一定的条件。比如在算法层面,国内的互联网公司以及一些研究院,已经具备研究语言大模型的基础;在算力层面,国内的AI大算力芯片,以及在算力集群方面,也已经取得长足进步;在部署和服务方面,国内的云服务厂商可以提供各种服务渠道,让基础设施能够便捷实用,使算法在大算力平台上很好的部署。

不足之处在于,第一,ChatGPT能够达到现在的水平,是因为它六七年长时间的产品迭代,从GPT-1到GPT-2再到ChatGPT期间有大量的用户使用,在数据集的标注、分拣、精炼上,也有很多创新的工程化步骤。对于中文大模型来说,差距在于如何获得更多、更有意义,更有价值的语义语料,如何在算法迭代、大量的用户使用之后,使能更大规模模型的推进。

第二,大模型的训练离不开大算力,燧原科技创始人兼COO张亚林在接受电子发烧友采访的时候表示,目前国际厂商的高算力芯片在中国仍然具有标杆效应。

第三,在生态建设上,无论是现在很火的ChatGPT,还是之前备受关注的生成式AI公司Stability、Runway,他们在基础模型、大模型的模型开发库,用户大量的应用上,都已经形成了可以触达终端用户的商业模式。而在国内,目前还没树立起这样全栈的生态和商业模式。

不过,虽然国内在发展这类大模型方面存在不足,整体而言这对于国内厂商来是个很好的机会。从算力方面来看,人工智能技术的发展和应用本身对算力的需求极大,目前全球大模型训练的算力基本以英伟达为主。

随着ChatGPT的爆火,国内各类生成式AI大模型的训练和部署将会加速,这对国内人工智能算力厂商来说无疑是个机会,国内厂商需要思考如何通过自身的算力发展,来持续推动中国本土大模型的进步。

ChatGPT爆火,算力厂商如何把握机会

那么AIGC大模型的训练和推理,对算力供应商有怎样的要求呢?对此,张亚林谈到了几点:首先是芯片,包括芯片的有效算力、架构的创新性、以及芯片的性价比等,这些将会决定算力集群是否具备足够的市场竞争力。

其次是集群系统,一个超大规模的集群系统,由几千张加速卡、几千颗芯片组成,还包括互联和存储。除了加速卡的性能之外,还要看整个系统的稳定性、集群的互联效率、存储的效率、以及分布式系统运行的稳定性。

第三是软件生态,它是否能够支持整个大模型的调试和开发。这要求企业不仅要能提供基础的软件栈,还要能够提供大模型能跑的分布式框架,让调试者和开发者能够更好的调试和开发这些大模型,就是说还需要具备一个整套的软件栈。

张亚林认为,从芯片设计,集群的稳定性,到整个软件栈的完备性,这对于初创公司来说还有一段很长的路要走,需要持续的产品迭代。

那么国内在AI大算力芯片或者GPGPU赛道的厂商,如何能够抓住ChatGPT这波浪潮带来的机会呢?首先,它需要做出高性价比的算力,现在来说这样的算力还太贵,以致于并不是所有人都能够玩得起这场游戏,企业需要能够推出高性价比的集群,让整个ChatGPT类大模型的开发更经济。

第二,最终呈现在用户侧的是整个的集群系统,就如上文所言,其中包括几千张加速卡,几千颗芯片,大量的互联和存储,很多服务器。因此,国内的AI大芯片厂商需要能够站到系统的角度去看问题,包括整个系统的设计、调动能力、让用户易用,这些跟芯片本身的设计和开发能力会不太一样。

第三,如何让用户在开发过程中做到高效和易用。训练本身是一个很复杂、很广阔的生态。今天的大模型,其实是把很广阔的需求浓缩到了一些比较确定的大模型上,这让整个训练从很广阔的发散状态,变成了有可能聚焦在某一些维度上就能够很好的支撑和优化的状态。

这给国内很多AI厂商提供了很好的思路,企业可以聚焦在比如大模型集群化的领域。国内厂商可以由此切入,谁能够在这样一个大规模AI生成领域,把训练和推理整套集群系统,做得更优化、更完整、更易用,谁就能够在这场游戏中拔得先机。

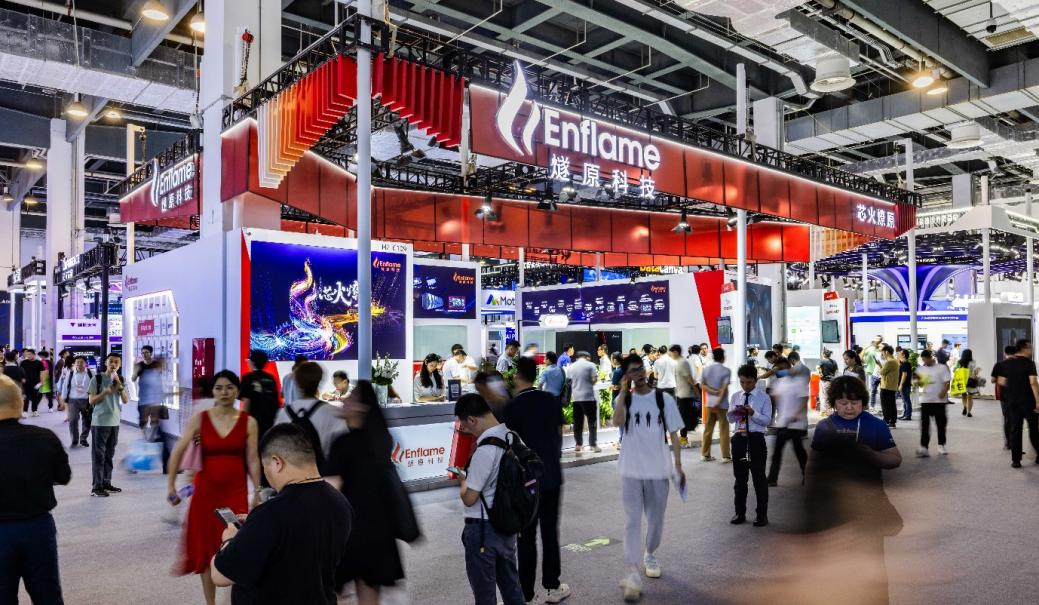

在人工智能算力领域,燧原科技已经有了很深的积累。目前燧原科技已经迭代了两代训练和推理产品,第三代也已经在研发中。此外,燧原科技已经在科研领域和智慧城市的应用中落地了训练和推理的超千卡算力集群。张亚林表示,类似ChatGPT这样的AIGC生成式模型,对于燧原科技而言是个机遇,公司可以把已经积累的系统集群的经验推广到更多的客户赛道上,帮助客户使能更多大模型的生成。

同时,面对生成式AI大模型带来的发展机会,燧原科技将从多个方面去做深度布局。第一是持续推进和迭代集群化产品和软件生态栈,与更多战略用户一起优化集群系统,提高性价比和能效比;第二是与国内云服务商进行深度合作,通过他们的云服务平台,触达更多To B和To C用户;第三是与国家相关机构合作制定更多关于AIGC标准和白皮书,探讨未来发展方向,与国家政策和标准融合;第四是与更多大模型厂商、云平台厂商等一起共创生态。

小结

整体而言,虽然目前ChatGPT仍然还存在一些问题,不过它的强大功能却是有目共睹。对于人们的生产生活来说,ChatGPT等大模型的发展将会带来劳动力的释放。

未来随着模型的进一步扩大,数据集进一步加强,AIGC这类巨大模型将会愈发智能,它也将会更加逼近人们所说的通用人工智能(AGI),而这个过程必然给相关产业带来机会,包括算力,而对于用户来说,厂商如何提供更高能效比、性价比的算力是关键。

ChatGPT的爆火给生成式AI的应用带来更多可能性,AI语言处理大模型也随之进入全球角逐的新阶段。在国内,百度、阿里等头部互联网企业都已经宣布有相关的研究。那么,国内在发展AI语言处理大模型方面是否具备相应的条件,国产厂商可以如何把握这个机会?

在AIGC大模型发展上,国内具备哪些条件

从目前的情况来看,国内在发展这类大模型上可以说已经具备一定的条件。比如在算法层面,国内的互联网公司以及一些研究院,已经具备研究语言大模型的基础;在算力层面,国内的AI大算力芯片,以及在算力集群方面,也已经取得长足进步;在部署和服务方面,国内的云服务厂商可以提供各种服务渠道,让基础设施能够便捷实用,使算法在大算力平台上很好的部署。

不足之处在于,第一,ChatGPT能够达到现在的水平,是因为它六七年长时间的产品迭代,从GPT-1到GPT-2再到ChatGPT期间有大量的用户使用,在数据集的标注、分拣、精炼上,也有很多创新的工程化步骤。对于中文大模型来说,差距在于如何获得更多、更有意义,更有价值的语义语料,如何在算法迭代、大量的用户使用之后,使能更大规模模型的推进。

第二,大模型的训练离不开大算力,燧原科技创始人兼COO张亚林在接受电子发烧友采访的时候表示,目前国际厂商的高算力芯片在中国仍然具有标杆效应。

第三,在生态建设上,无论是现在很火的ChatGPT,还是之前备受关注的生成式AI公司Stability、Runway,他们在基础模型、大模型的模型开发库,用户大量的应用上,都已经形成了可以触达终端用户的商业模式。而在国内,目前还没树立起这样全栈的生态和商业模式。

不过,虽然国内在发展这类大模型方面存在不足,整体而言这对于国内厂商来是个很好的机会。从算力方面来看,人工智能技术的发展和应用本身对算力的需求极大,目前全球大模型训练的算力基本以英伟达为主。

随着ChatGPT的爆火,国内各类生成式AI大模型的训练和部署将会加速,这对国内人工智能算力厂商来说无疑是个机会,国内厂商需要思考如何通过自身的算力发展,来持续推动中国本土大模型的进步。

ChatGPT爆火,算力厂商如何把握机会

那么AIGC大模型的训练和推理,对算力供应商有怎样的要求呢?对此,张亚林谈到了几点:首先是芯片,包括芯片的有效算力、架构的创新性、以及芯片的性价比等,这些将会决定算力集群是否具备足够的市场竞争力。

其次是集群系统,一个超大规模的集群系统,由几千张加速卡、几千颗芯片组成,还包括互联和存储。除了加速卡的性能之外,还要看整个系统的稳定性、集群的互联效率、存储的效率、以及分布式系统运行的稳定性。

第三是软件生态,它是否能够支持整个大模型的调试和开发。这要求企业不仅要能提供基础的软件栈,还要能够提供大模型能跑的分布式框架,让调试者和开发者能够更好的调试和开发这些大模型,就是说还需要具备一个整套的软件栈。

张亚林认为,从芯片设计,集群的稳定性,到整个软件栈的完备性,这对于初创公司来说还有一段很长的路要走,需要持续的产品迭代。

那么国内在AI大算力芯片或者GPGPU赛道的厂商,如何能够抓住ChatGPT这波浪潮带来的机会呢?首先,它需要做出高性价比的算力,现在来说这样的算力还太贵,以致于并不是所有人都能够玩得起这场游戏,企业需要能够推出高性价比的集群,让整个ChatGPT类大模型的开发更经济。

第二,最终呈现在用户侧的是整个的集群系统,就如上文所言,其中包括几千张加速卡,几千颗芯片,大量的互联和存储,很多服务器。因此,国内的AI大芯片厂商需要能够站到系统的角度去看问题,包括整个系统的设计、调动能力、让用户易用,这些跟芯片本身的设计和开发能力会不太一样。

第三,如何让用户在开发过程中做到高效和易用。训练本身是一个很复杂、很广阔的生态。今天的大模型,其实是把很广阔的需求浓缩到了一些比较确定的大模型上,这让整个训练从很广阔的发散状态,变成了有可能聚焦在某一些维度上就能够很好的支撑和优化的状态。

这给国内很多AI厂商提供了很好的思路,企业可以聚焦在比如大模型集群化的领域。国内厂商可以由此切入,谁能够在这样一个大规模AI生成领域,把训练和推理整套集群系统,做得更优化、更完整、更易用,谁就能够在这场游戏中拔得先机。

在人工智能算力领域,燧原科技已经有了很深的积累。目前燧原科技已经迭代了两代训练和推理产品,第三代也已经在研发中。此外,燧原科技已经在科研领域和智慧城市的应用中落地了训练和推理的超千卡算力集群。张亚林表示,类似ChatGPT这样的AIGC生成式模型,对于燧原科技而言是个机遇,公司可以把已经积累的系统集群的经验推广到更多的客户赛道上,帮助客户使能更多大模型的生成。

同时,面对生成式AI大模型带来的发展机会,燧原科技将从多个方面去做深度布局。第一是持续推进和迭代集群化产品和软件生态栈,与更多战略用户一起优化集群系统,提高性价比和能效比;第二是与国内云服务商进行深度合作,通过他们的云服务平台,触达更多To B和To C用户;第三是与国家相关机构合作制定更多关于AIGC标准和白皮书,探讨未来发展方向,与国家政策和标准融合;第四是与更多大模型厂商、云平台厂商等一起共创生态。

小结

整体而言,虽然目前ChatGPT仍然还存在一些问题,不过它的强大功能却是有目共睹。对于人们的生产生活来说,ChatGPT等大模型的发展将会带来劳动力的释放。

未来随着模型的进一步扩大,数据集进一步加强,AIGC这类巨大模型将会愈发智能,它也将会更加逼近人们所说的通用人工智能(AGI),而这个过程必然给相关产业带来机会,包括算力,而对于用户来说,厂商如何提供更高能效比、性价比的算力是关键。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

算力

+关注

关注

1文章

1040浏览量

15081 -

ChatGPT

+关注

关注

29文章

1578浏览量

8261

发布评论请先 登录

相关推荐

燧原科技助力美图AI换装全球爆火

2025蛇年元宵后,美图公司旗下美颜相机凭借“AI换装”功能爆火,获得了国内外用户的极大青睐,App下载量和使用量迅速激增的同时,也面临了海量推理算力即时支持的挑战。

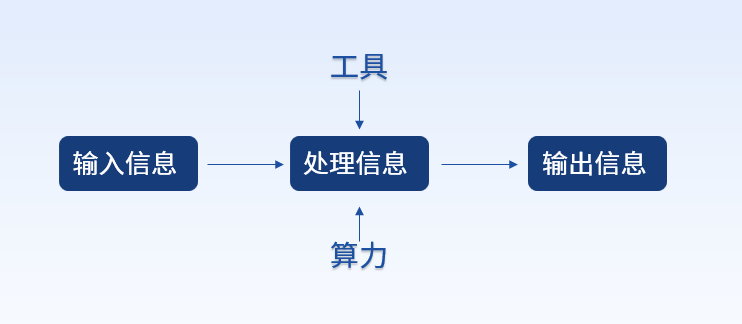

算力基础篇:从零开始了解算力

算力即计算能力(Computing Power),狭义上指对数字问题的运算能力,而广义上指对输入信息处理后实现结果输出的一种能力。虽然处理的内容不同,但处理过程的能力都可抽象为算力。比

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】--全书概览

本帖最后由 1653149838.791300 于 2024-10-16 22:19 编辑

感谢平台提供的书籍,厚厚的一本,很有分量,感谢作者的倾力付出成书。

本书主要讲算力芯片CPU

发表于 10-15 22:08

浅析三大算力之异同

随着一年多前ChatGPT的出现引爆人工智能(AI)浪潮,支撑大模型背后的“算力”概念突然闯进我们的视野,成为科技圈炙手可热的新词,引领着最新潮流。作为数字经济时代新生产力,也许不少人

大模型时代的算力需求

现在AI已进入大模型时代,各企业都争相部署大模型,但如何保证大模型的算力,以及相关的稳定性和性能,是一个极为重要的问题,带着这个极为重要的问题,我需要在此书中找到答案。

发表于 08-20 09:04

摩尔线程张建中:以国产算力助力数智世界,满足大模型算力需求

摩尔线程创始人兼CEO张建中在会上透露,为了满足国内对AI算力的迫切需求,他们正在积极寻求与国内顶尖科研机构的深度合作,共同推动更大规模的AI智算

算力十问:超算智算,通算及算存比

邬贺铨指出,现有测算方法难以精准衡量算力。国内企业服务器的出货量并不等于国内市场的使用量,而且进口国外的服务器未统计在内;服务器出货量也不等于上架量,更不等于已经加电使用量。通常服务器

ChatGPT爆火,国内算力厂商如何把握机会?

ChatGPT爆火,国内算力厂商如何把握机会?

评论