其拥有 30亿参数 ,是目前全球开源模型中 ImageNet准确度最高、规模最大 ,同时也是物体检测标杆数据集COCO中唯一超过65.0 mAP的模型。

凭借在多模态多任务处理能力方面多项突破,“书生2.5”的图文跨模态开放任务处理能力可为 自动驾驶 、机器人等通用场景任务提供高效精准的感知和理解能力支持,向通用人工智能迈出坚实的一步。 “书生”由商汤科技、上海人工智能实验室、清华大学、香港中文大学、上海交通大学于2021年11月首次共同发布,并持续联合研发。

即日起,“书生2.5”多模态通用大模型 已在商汤参与的通用视觉开源平台OpenGVLab开源 。

迈向AGI通用人工智能

当今快速增长的各式应用需求下,传统计算机视觉已无法处理真实世界中数不胜数的特定任务。 我们迫切需要一种具备通用场景感知和复杂问题处理能力的高级视觉系统。

“书生2.5”实现了通过文本来定义任务,从而可以灵活地定义不同场景的任务需求,并根据给定视觉图像和任务的提示性语句,给出相应的指令或作答,进而具备通用场景下的高级感知和复杂问题处理能力,比如图像描述、视觉问答、视觉推理和文字识别等。

在自动驾驶和居家机器人等通用场景下,“书生2.5”可辅助处理各种复杂任务。

例如, 在自动驾驶场景中,可以大幅提升场景感知理解能力 ,准确辅助车辆判断交通信号灯状态、道路标志牌等信息,为车辆决策规划提供有效信息输入。

利用多模态多任务通用大模型辅助完成自动驾驶场景中各类复杂任务

利用多模态多任务通用大模型辅助完成居家机器人场景中各类复杂任务

除解决自动驾驶和居家机器人这类复杂问题的能力,“书生2.5”通用大模型 也可解决纷繁复杂的日常生活中的常见任务,满足各种需求 。

除全图级别的以图生文,“书生2.5”通用大模型同样 可根据物体边框更精细化定位任务需求 。

“书生2.5”同时具备AIGC“以文生图”的能力。 可根据用户提出的文本创作需求,利用扩散模型生成算法,生成高质量、自然的写实图像。

例如,借助“书生2.5”的以文生图能力帮助自动驾驶技术研发,通过生成各类真实的道路交通场景,如繁忙的城市街道、雨天拥挤车道、马路上奔跑的狗等,生成写实的Corner Case训练数据,进而训练自动驾驶系统对Corner Case场景的感知能力上限。

“书生2.5”还 可根据文本快速检索出视觉内容 。

例如,可在相册中返回文本所指定的相关图像,或是在视频中检索出与文本描述最相关的帧,提高视频中时间定位任务的效率。 此外还支持引入物体检测框,根据文本返回最相关的物体,实现开放世界视频或图像中物体检测及视觉定位。

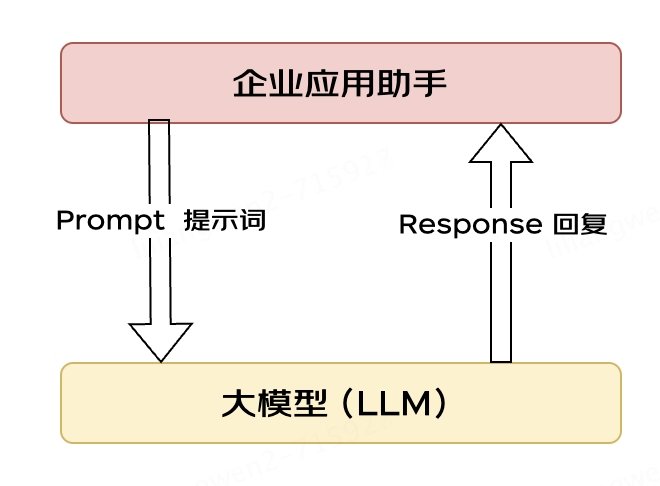

高效能打通自然语言、图像等多模态任务处理

“书生2.5”在图文跨模态领域卓越的性能表现来自于视觉、语音及多任务建模三大模型能力的有效融合,即 InternImage-G通用视觉大模型 、用于文本理解的 超大语言预训练模型(LLM) 和 用于多任务的 兼容解码建模大模型(Uni-Perceiver) 。

其中,InternImage-G通用视觉大模型能够基于动态稀疏卷积算子自适应地调整卷积的位置和组合方式,从而为多功能视觉感知提供强大的表示。

超大语言模型通过在超大规模丰富文本语料库上进行预训练提供强大可靠的文本特征。

Uni-Perceiver通才任务解码建模通过将不同模态的数据编码到统一的表示空间,将不同任务统一为相同的任务范式,从而能够以相同的架构和共享的模型参数同时处理各种模态和任务。

此外,“书生2.5”还创新性地引入了任务级别的稀疏激活机制,使其具备高效率的多任务协作能力。

在视觉主流图像分类数据集ImageNet上,该模型仅基于公开数据便达到 90.1%的Top-1准确率 。 这是除谷歌与微软之外,唯一准确率超过90.0%的模型。 值得一提的是,谷歌与微软均未公开模型及额外数据集。

除高精确度的语义理解能力外,“书生2.5”在目标定位性能上同样有着出色的表现。 在物体检测标杆数据集COCO上,取得了65.4的mAP。 “书生2.5”也在包括图像分类、物体检测、语义分割、图像描述、图文检索等 20+个不同场景、不同任务的单模态和跨模态公开数据集中都取得了最佳成绩 。

“书生2.5”在20余个不同场景不同任务的单模态和跨模态公开数据集中都取得了最佳成绩

当前,“书生”还在持续学习、不断进步,致力于推动多模态多任务通用模型技术的突破,驱动通用人工智能技术的创新应用生态,为推动人工智能学术、产业发展做出贡献。

关于OpenGVLab

OpenGVLab致力于通用视觉模型的开源社区建设,开源项目覆盖数据、模型、评测基准全链路,为学术界和产业界的多模态通用模型研发提供坚实支撑。 在数据方面,OpenGVLab构建了千万级超大规模精标注数据集,涵盖了图像分类、目标检测等视觉核心任务的标注,同时包括各类图像中的属性、状态等的精细标注,显著降低了数据采集成本。 在模型方面,OpenGVLab的开源项目全方位覆盖了通用模型架构、高效训练框架及超高性能的预训练模型,助力社区用极低的数据量快速满足多场景、多任务、高性能的AI模型训练,并供所有对人工智能技术感兴趣的人士自由体验。 OpenGVLab还提供了多任务、多模态的通用视觉评测基准,可提供权威的评测结果,推动基于统一标准的公平和准确评测,加快通用视觉模型的产业化应用步伐。

通过开源社区建设,OpenGVLab帮助开发者显著降低通用视觉模型的开发门槛,用更低成本快速开发用于成百上千种视觉任务、视觉场景的算法模型,高效实现对长尾场景的覆盖,推动通用AI技术的规模化应用。

审核编辑:汤梓红

-

人工智能

+关注

关注

1792文章

47409浏览量

238919 -

模型

+关注

关注

1文章

3261浏览量

48912 -

Agi

+关注

关注

0文章

82浏览量

10210 -

商汤

+关注

关注

0文章

55浏览量

3962 -

大模型

+关注

关注

2文章

2482浏览量

2848

原文标题:商汤发布多模态多任务通用大模型“书生2.5”,迈向AGI通用人工智能

文章出处:【微信号:SenseTime2017,微信公众号:商汤科技SenseTime】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

亥步多模态医疗大模型发布:人工智能引领医疗新纪元

Meta发布多模态LLAMA 3.2人工智能模型

报名开启!深圳(国际)通用人工智能大会将启幕,国内外大咖齐聚话AI

阿丘科技成功入选“北京市通用人工智能产业创新伙伴计划”,AI+工业视觉实力再获肯定

千方科技成功入选“北京市通用人工智能产业创新伙伴计划”

大模型应用之路:从提示词到通用人工智能(AGI)

商汤发布多模态多任务通用大模型“书生2.5”,迈向AGI通用人工智能

商汤发布多模态多任务通用大模型“书生2.5”,迈向AGI通用人工智能

评论