OpenAI 刚刚宣布正式推出GPT-4。GPT-4 是 Generative Pre-trained Transformer 4 的缩写,即生成型预训练变换模型 4。

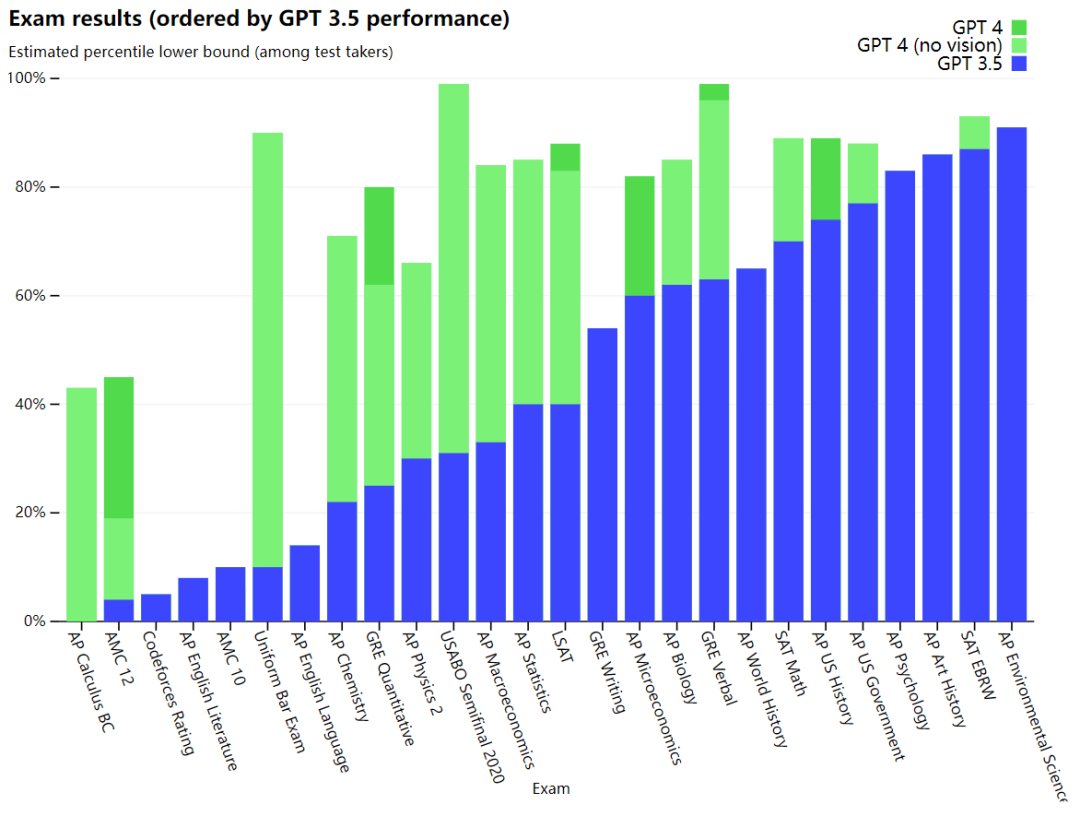

公告写道,GPT-4 是一个多模态大型语言模型(支持接受图像和文本输入,以文本形式输出),也是 OpenAI 努力扩展深度学习的最新里程碑。虽然 GPT-4 对于许多现实场景的处理比人类差,但它在各种体现专业和学术能力的 benchmark 上,已表现出和人类相当的水平。 例如,GPT-4 通过了模拟律师考试,其分数在应试者的前 10% 左右;相比之下,GPT-3.5 的得分却在倒数 10% 左右。OpenAI 表示,他们花了 6 个月的时间来使用对抗性测试程序,以及通过 ChatGPT 的经验教训迭代调整 GPT-4,从而在真实性和可控性等方面取得了有史以来最好的结果(尽管远非完美)。 使用示例 OpenAI 用一张梗图演示了 GPT-4 特有的「多模态」功能。 用户提问:解释下图的笑点是什么,并对图片中的每部分进行描述。

GPT-4:

The image shows a package for a "Lightning Cable" adapter with three panels. Panel 1: A smartphone with a VGA connector (a large, blue, 15-pin connector typically used for computer monitors) plugged into its charging port. Panel 2: The package for the "Lightning Cable" adapter with a picture of a VGA connector on it. Panel 3: A close-up of the VGA connector with a small Lightning connector (used for charging iPhones and other Apple devices) at the end. The humor in this image comes from the absurdity of plugging a large, outdated VGA connector into a small, modern smartphone charging port.

翻译如下:

图片显示了一个 "Lightning Cable" 适配器的包装,总共包含三个部分。 面板 1:一部智能手机,其充电端口插着一个 VGA 接口(大的蓝色 15 针接口,通常用于电脑显示器)。 面板 2:"Lightning Cable" 适配器的包装上有一张 VGA 接口的图片。 面板 3:VGA 连接器的特写,末端是一个小的 Lightning 连接器(用于为 iPhone 和其他苹果设备充电)。 这张图片的笑点来自于:展示了将一个大的、过时的 VGA 连接器插入一个小的、现代的智能手机充电端口的荒谬性。

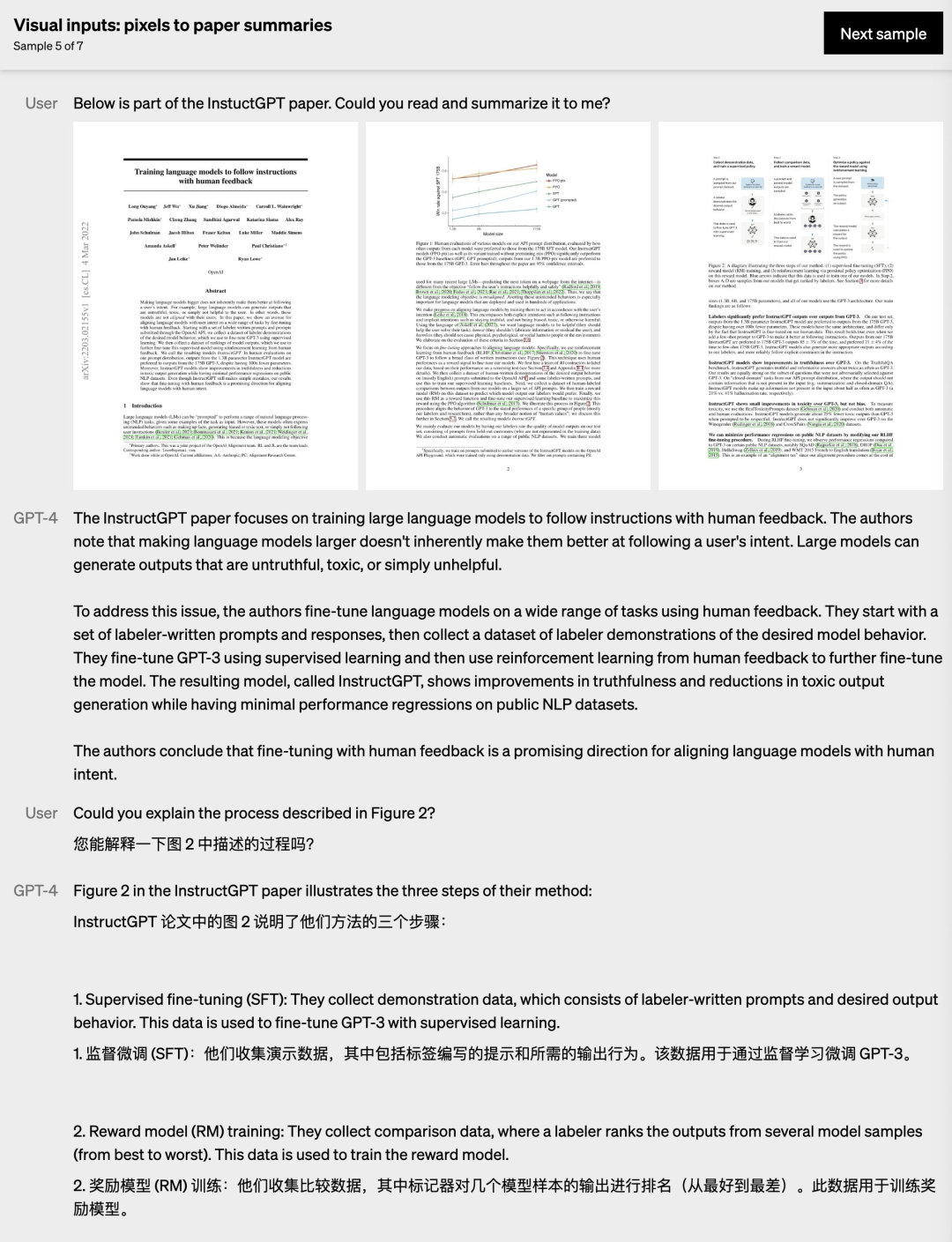

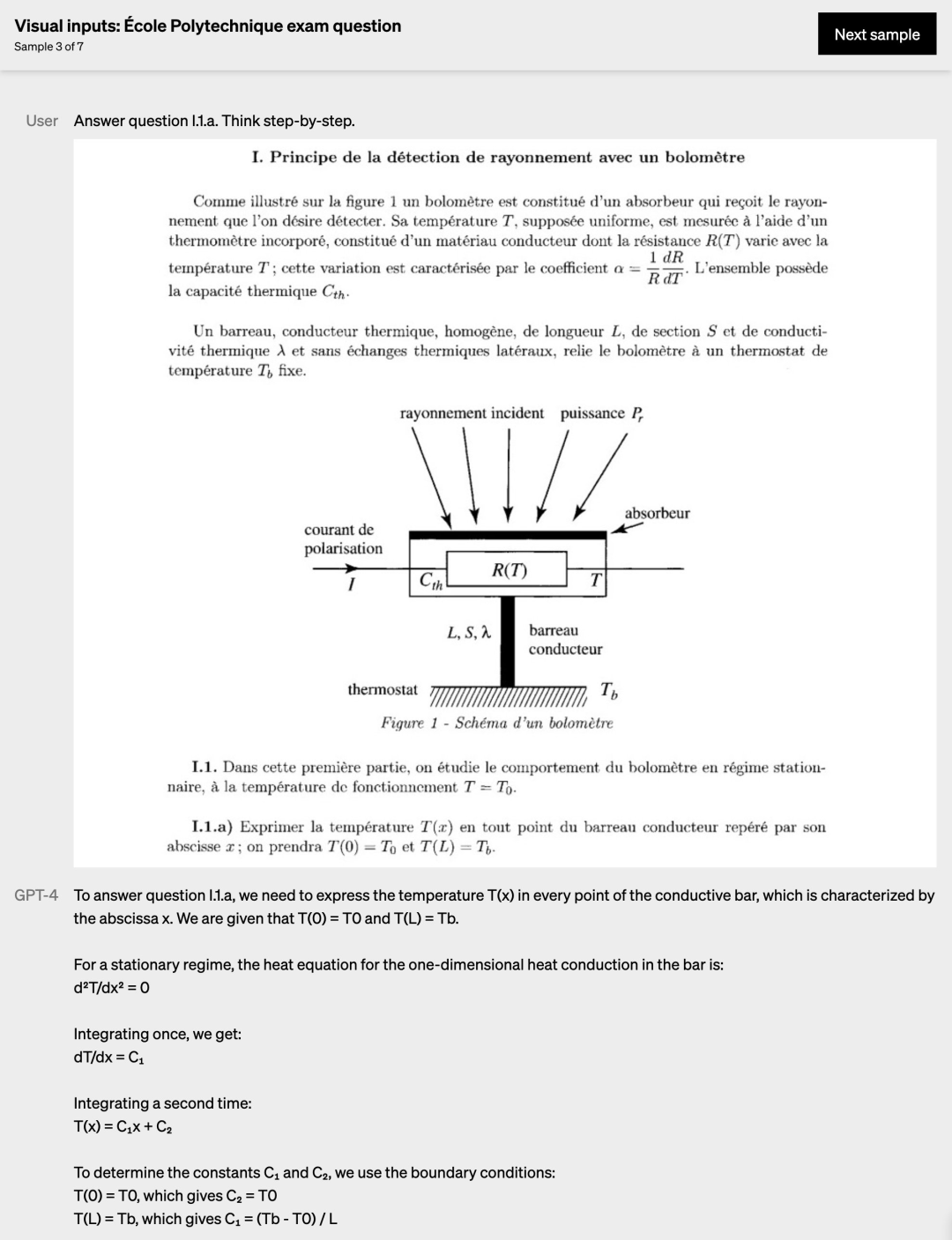

上面的例子看起来很简单,OpenAI 紧接着展示了高级用法 —— 像人类一样读论文。简单来说就是给 GPT-4 提供论文的图片格式文件,让它阅读并总结出要点。效果如下:

甚至直接让 GPT-4 回答图片中对应题号的问题:

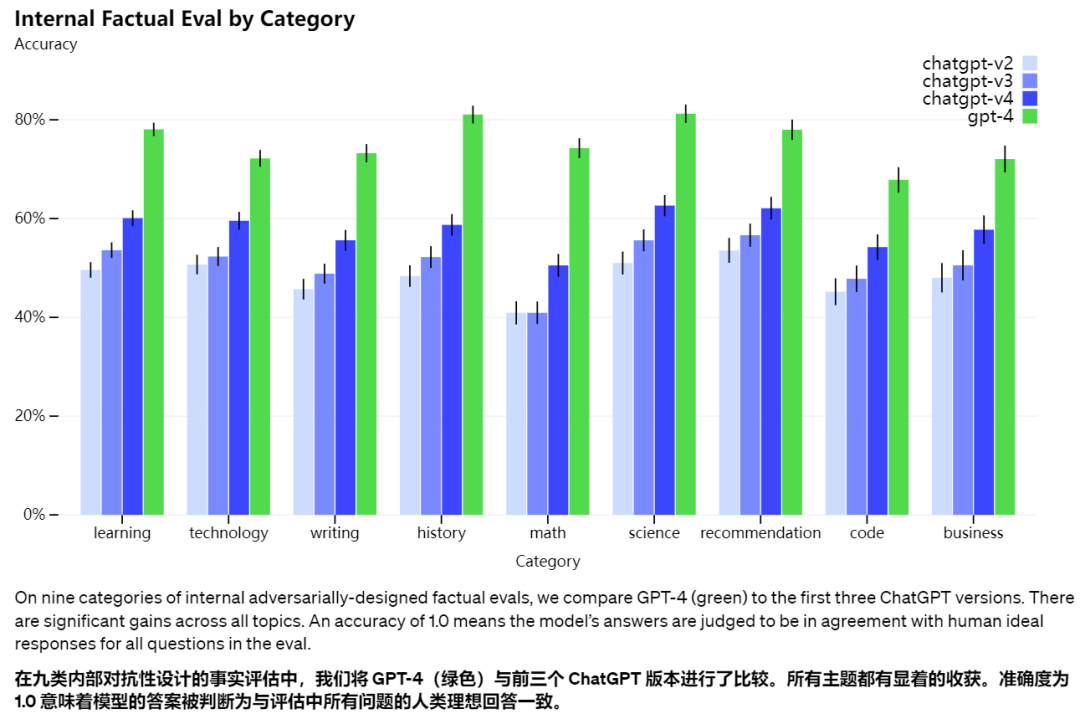

GPT-4 局限性 尽管功能强大,但 GPT-4 与早期的 GPT 模型具有相似的局限性,即生成的结果不符合事实。因此它仍然不完全可靠(它会产生 “幻觉” 事实并出现推理错误)。 虽然这仍然是一个问题,但 GPT-4 相对于以前的模型(它们本身在每次迭代中都在改进)显着减少了 “幻觉”。在内部的对抗性真实性评估中,GPT-4 的得分比最新的 GPT-3.5 高 40%:

与 GPT 3.5 的对比 据介绍,对于日常的谈话,GPT-3.5 和 GPT-4 之间的区别可能很微妙。但当任务的复杂性达到足够的阈值时,差异就会出现 ——GPT-4 比 GPT-3.5 更可靠、更有创意,并且能够处理更细微的指令。 为了了解这两种模型之间的区别,OpenAI 通过各种 benchmark 进行了测试,包括最初为人类设计的模拟考试。从下图可以看出,GPT-4 的成绩大部分都比 GPT-3 好。

GPT-4 也在多项测试项目中取得了接近满分的成绩:

USABO Semifinal Exam 2020(美国生物奥林匹克竞赛)

GRE 口语

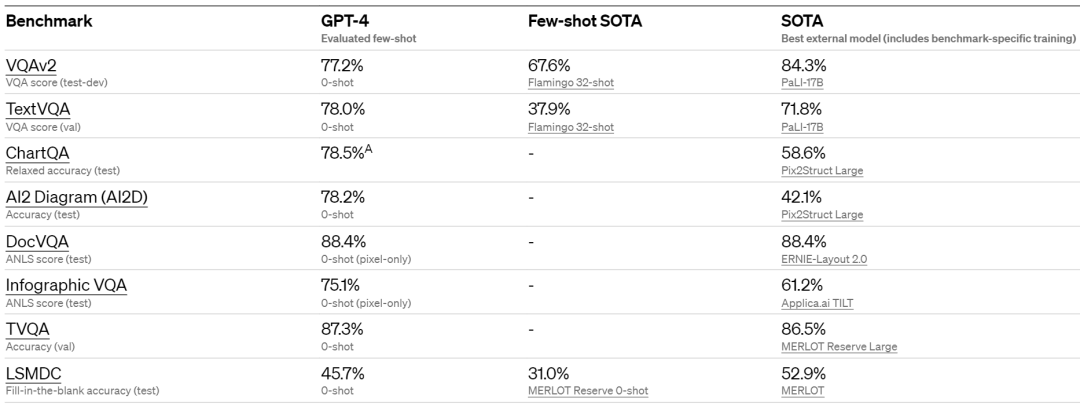

OpenAI 还将机器学习模型的传统 benchmark 用于评估 GPT-4。结果显示,GPT-4 已经远远超过现有的大型语言模型,以及大多数最先进的 (SOTA, state-of-the-art) 模型。benchmark 数据如下:

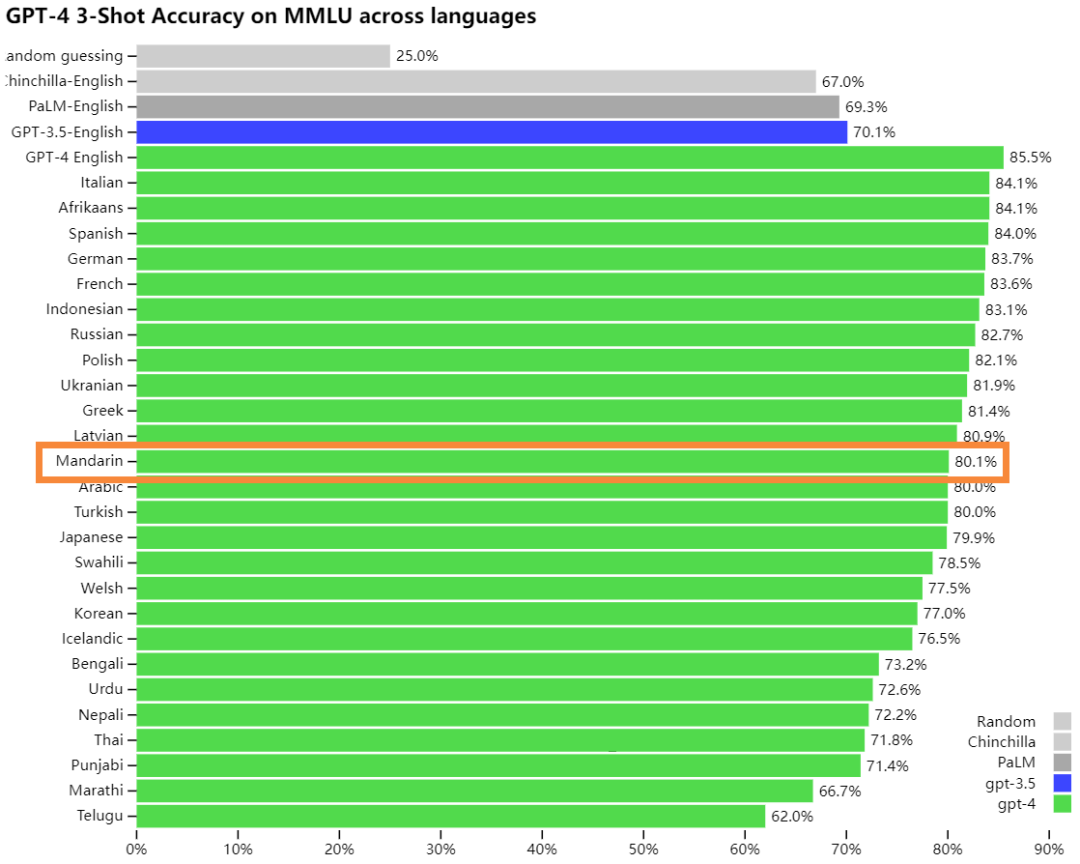

在 MMLU benchmark 中(一个基准数据集,包括来自于 STEM、人文、社科等 57 个学科的选择题,它用于测试 LLM 的世界知识和问题解答的能力),GPT-4 处理中文的准确度大约是 80%,已经优于其他 LLM 的英文表现,比如 GPT-3.5、Chinchilla、PALM。

试用方式

ChatGPT Plus 订阅用户可尝鲜体验,他们将在 chat.openai.com 上获得具有使用s上限的 GPT-4 访问权限。

调用 API,访问

https://openai.com/waitlist/gpt-4进入等待名单

另外,

现在只支持纯文本的请求(图像输入还在 alpha 阶段)

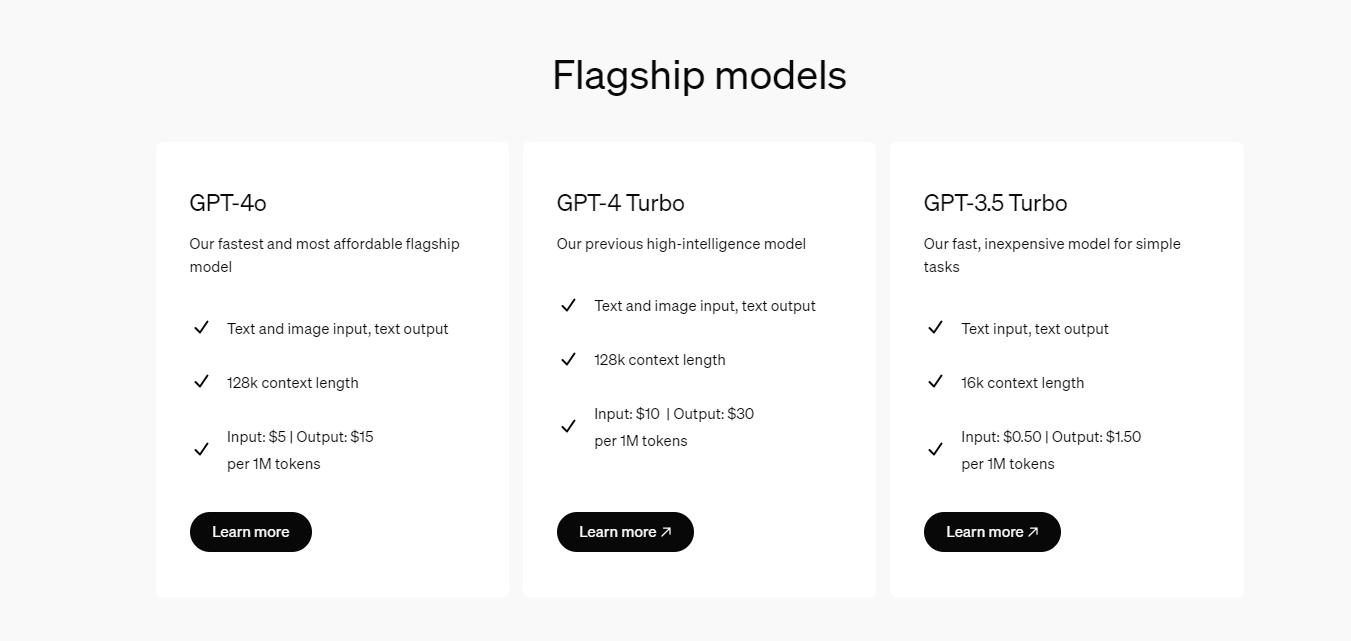

定价:prompt - $0.03 per 1k token, completion - $0.06 per 1k token

context 长度为 8192 tokens,并且提供 32768 token 的版本(价格也更贵,$0.06 & $0.12)

审核编辑 :李倩

-

图像

+关注

关注

2文章

1083浏览量

40449 -

模型

+关注

关注

1文章

3229浏览量

48810 -

OpenAI

+关注

关注

9文章

1082浏览量

6483

原文标题:OpenAI正式发布GPT-4:支持图像和文本的输入、 处理中文的准确度大幅提升

文章出处:【微信号:OSC开源社区,微信公众号:OSC开源社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

OpenAI 推出 GPT-4o mini 取代GPT 3.5 性能超越GPT 4 而且更快 API KEY更便宜

OpenAI推出新模型CriticGPT,用GPT-4自我纠错

OpenAI API Key获取:开发人员申请GPT-4 API Key教程

OpenAI正式发布GPT-4:支持图像和文本的输入、 处理中文的准确度大幅提升

OpenAI正式发布GPT-4:支持图像和文本的输入、 处理中文的准确度大幅提升

评论