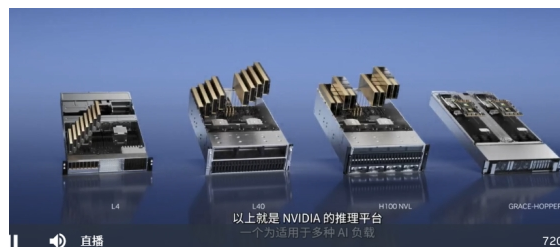

针对ChatGPT等大型语言模型的推理,我们宣布推出一款新的Hopper GPU配备双GPU NVLINK的PCIE H100

同时还可支持商用PCIE服务器轻松扩展

目前在云上唯一可以实际处理ChatGPT的GPU是HGX A100与适用于GPT-3处理的HGX A100相比,一台搭载四对H100及双GPU NVLINK的标准服务器的速度

H100可将大型语言模型的处理成本,降低一个数量级

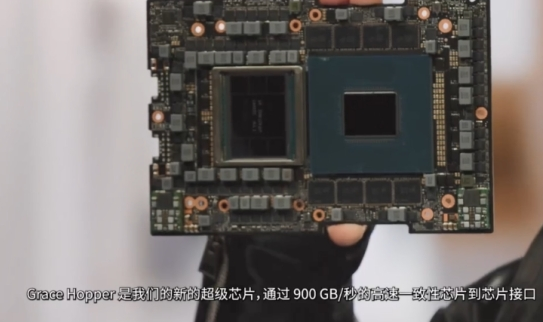

Grace Hopper非常适合处理大型数据集,例如适用于推荐系统和大型语言模型的AI数据库。

如今,利用大容量内存,CPU会存储和查询巨型嵌入表,然后将结果传输到GPU进行推理,借助Grace-Hopper, Grace可以查询嵌入表,并将结果直接传输到Hopper速度比PCIE快7倍

GTC 2023主题直播地址:https://t.elecfans.com/live/2302.html

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

cpu

+关注

关注

68文章

10922浏览量

213277 -

服务器

+关注

关注

12文章

9342浏览量

86206 -

gtc

+关注

关注

0文章

73浏览量

4456 -

ChatGPT

+关注

关注

29文章

1574浏览量

8140

发布评论请先 登录

相关推荐

软银升级人工智能计算平台,安装4000颗英伟达Hopper GPU

软银公司宣布,其正在扩展的日本顶级人工智能计算平台已安装了约4000颗英伟达Hopper GPU。这一举措显著提升了平台的计算能力。据悉,该平台自2

英伟达:Hopper芯片需求强劲 英伟达发言人谈生产增长

据外媒报道,英伟达发言人透露Hopper芯片需求强劲,而且Blackwell 芯片的广泛采样也已经开启。而对于产量问题;则表示有望在下半年实现增长。

英伟达GPU新品规划与HBM市场展望

在COMPUTEX 2024主题演讲中,英伟达(NVIDIA)公布了其GPU产品的未来规划。据英伟达透露,B100、B200和GB200系列

英伟达去年数据中心GPU出货量占比约98%

半导体分析公司TechInsights的最新报告揭示了英伟达在数据中心GPU领域的惊人增长。据悉,在2023年,英伟

亚马逊AWS暂缓订购英伟达Grace Hopper,等待新品Grace Blackwel

今年 3 月,英伟达宣布了新款人工智能处理器Blackwell,比上一代Hopper提前不到一年面世。CEO黄仁勋表示,新产品在训练大规模语言模型方面的性能将提升一倍。

英伟达静候新品来临,亚马逊暂缓购买Grace Hopper

今年3月,英伟达发布了全新的Blackwell处理器,距离前任产品Hopper的发布不过短短一年。英伟达首席执行官黄仁勋表示,新款产品在训练

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

2024年3月19日,[英伟达]CEO[黄仁勋]在GTC大会上公布了新一代AI芯片架构BLACKWELL,并推出基于该架构的超级芯片GB200,将助推数据处理、工程模拟、电子设计自动化

发表于 05-13 17:16

全面解读英伟达NVLink技术

NVLink是一种解决服务器内GPU之间通信限制的协议。与传统的PCIe交换机不同,NVLink带宽有限,可以在服务器内的GPU之间实现高速直接互连。第四代NVLink提供更高的带宽,每条通道达到112Gbps,

发表于 04-22 11:01

•1567次阅读

英伟达发布新一代AI芯片架构Blackwell GPU

近日,英伟达首席执行官黄仁勋在GTC 2024会议上发表主题演讲,重磅推出全新AI芯片架构Blackwell GPU。这一创新技术的首款芯片

英伟达GTC大会丨宇树通用人形机器人H1与全球共同拥抱AI

,与英伟达一起推动全球AI机器人的深度进化。 Unitree H1前段时间刚刚以每秒3.3米的运动速度创下了全尺寸人形机器人速度的世界纪录,潜在速度

英伟达GTC大会将开幕 黄仁勋将带你《见证AI的变革时刻》

英伟达GTC大会将开幕 黄仁勋将带你《见证AI的变革时刻》 全球都在关注的英伟达GTC大会将开幕

英伟达GTC大会即将召开,聚焦AI与机器人技术前沿

备受瞩目的英伟达GTC大会将于3月18日至21日盛大举行。作为英伟达每年最重要的技术发布平台,GTC

GTC 2023直播:英伟达推出Hopper GPU,速度比PCIE快7倍

GTC 2023直播:英伟达推出Hopper GPU,速度比PCIE快7倍

评论