电子发烧友网报道(文/李弯弯)3月21日晚间,英伟达CEO黄仁勋在2023年GTC开发者大会上发表了主题演讲,介绍了英伟达在AI领域的最新进展。

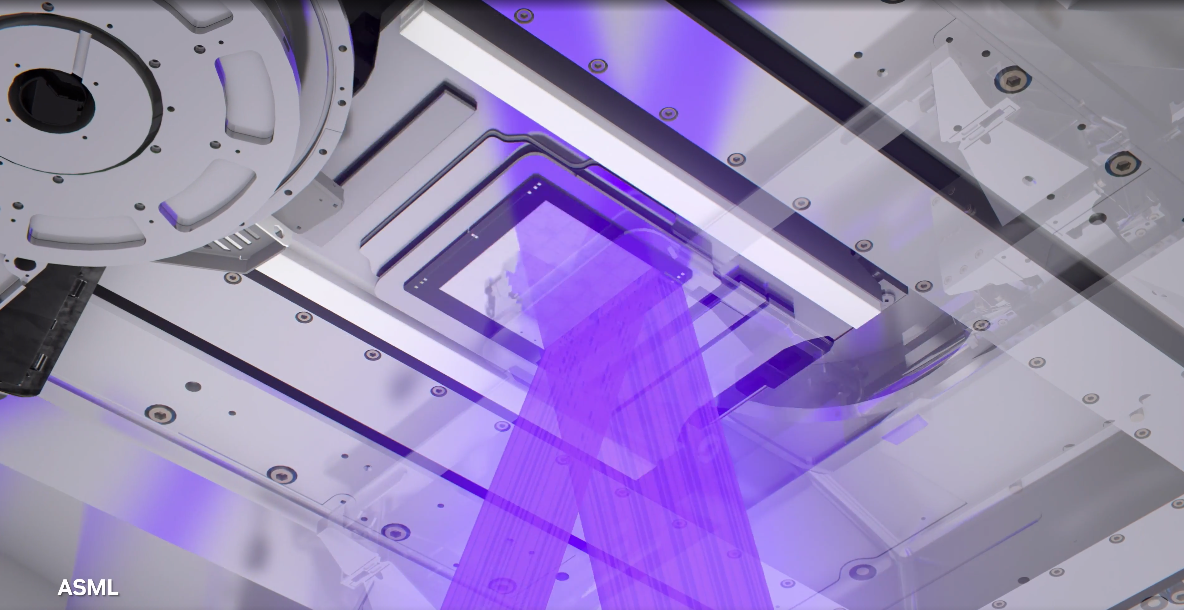

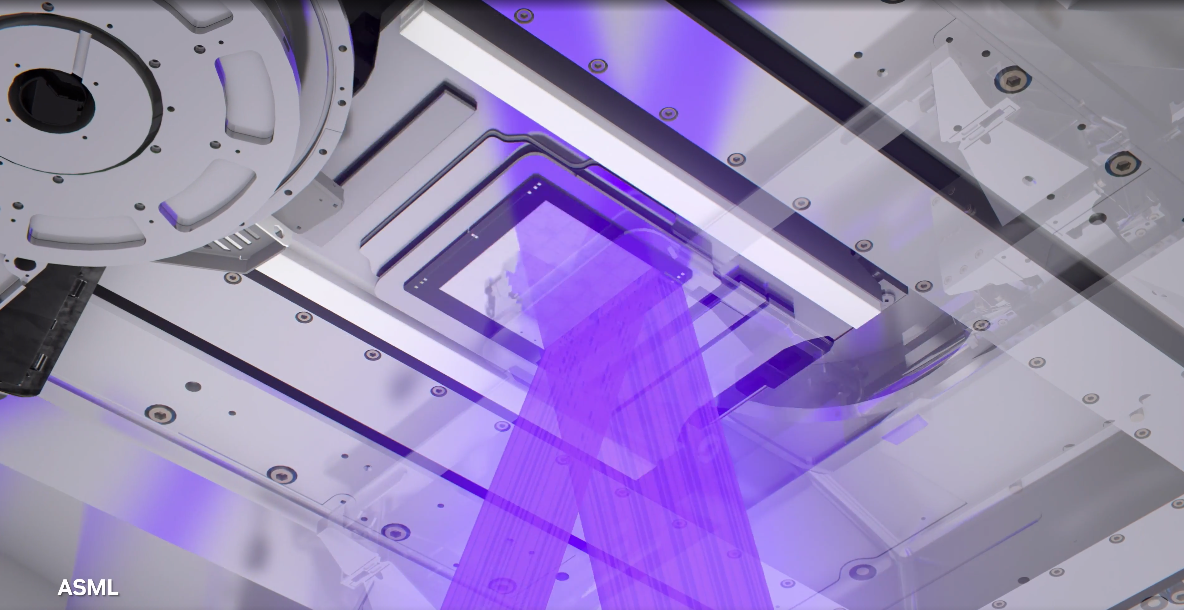

其中有两点最为引人瞩目,一是英伟达宣布了一项突破性技术——NVIDIA cuLitho计算光刻库,它将加速计算带入计算光刻领域,使ASML、TSMC和Synopsys等半导体领导者能够加速下一代芯片的设计和制造。

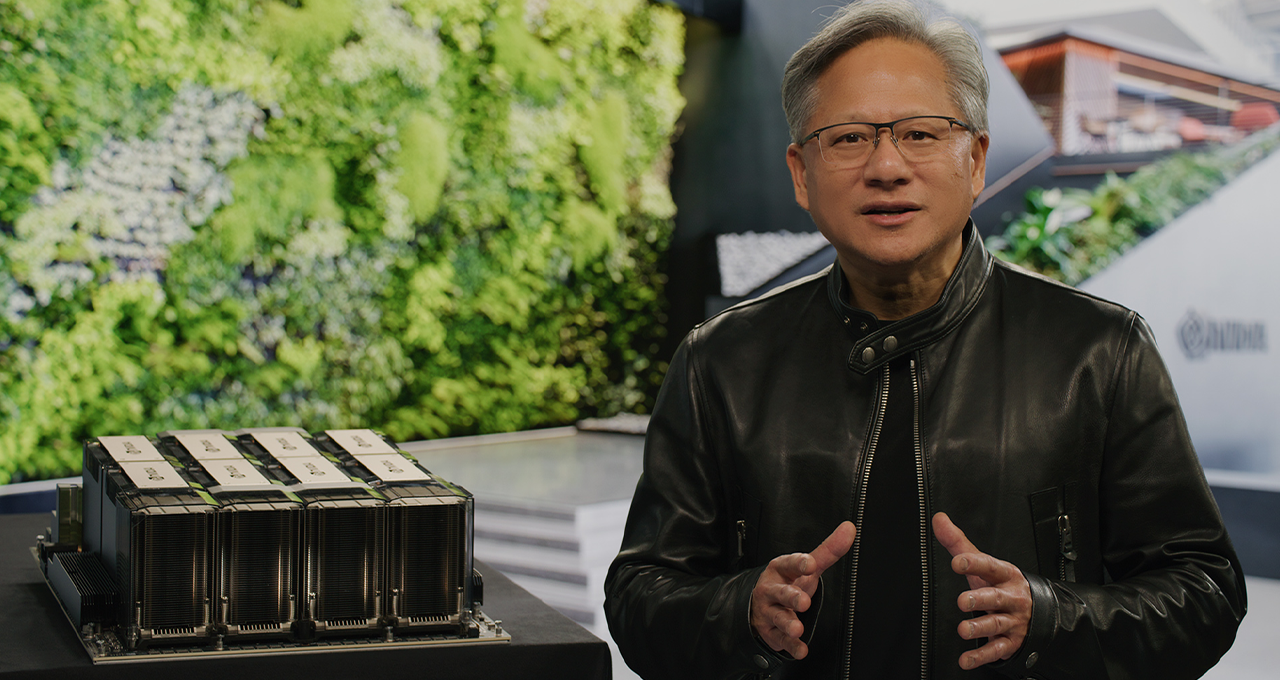

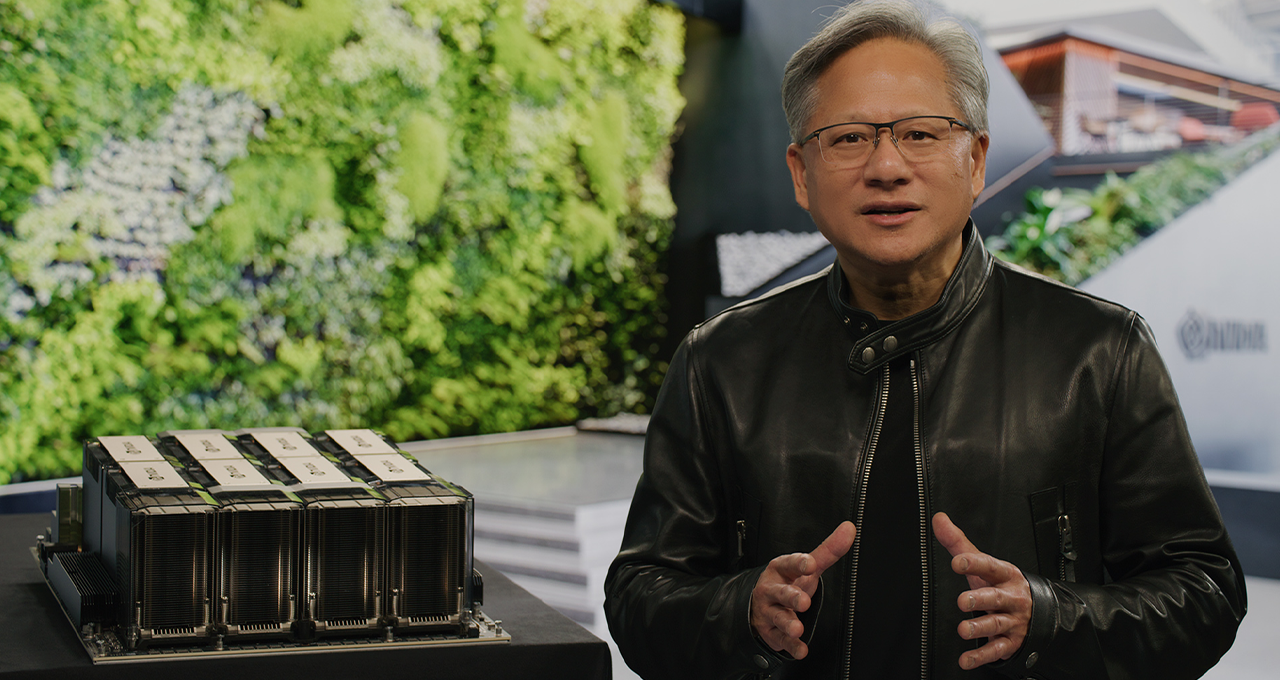

二是专为ChatGPT打造的H100 NVLINK,以及为赋能生成式AI发布的NVIDIA AI Foundations云服务系列。黄仁勋认为“我们正处于AI的iPhone时刻”。他说:“初创公司正在竞相打造颠覆性产品和商业模式,科技巨头也在寻求突破。”

计算光刻库cuLitho将光刻技术提高40倍

光刻工艺过程可以用光学和化学模型,借助数学公式来描述。光照射在掩模上发生衍射,衍射级被投影透镜收集并会聚在光刻胶表面,这一成像过程是一个光学过程;投影在光刻胶上的图像激发光化学反应,烘烤后导致光刻胶局部可溶于显影液,这是化学过程。

计算光刻就是使用计算机来模拟、仿真这些光学和化学过程,从理论上探索增大光刻分辨率和工艺窗口的途径,指导工艺参数的优化。

计算光刻是提高光刻分辨率、推动芯片制造达到2nm及更先进节点的关键手段。英伟达表示,这一进展将使芯片拥有比现在更小的晶体管和电线,同时加快上市时间,并提高全天候运行的大型数据中心的能源效率,以推动制造过程。

具体来看,NVIDIA cuLitho计算光刻库有哪些优势?在GPU上运行时,cuLitho的性能比目前的光刻技术提高了40倍。

据黄仁勋介绍,英伟达的H100需要89块掩膜板,如果用CPU进行处理的话,每个掩膜板都需要消耗两周的时间,而如果在GPU上运行cuLitho,则只需8个小时即可处理完一个掩膜板。

它使500个NVIDIA DGX H100系统能够实现40000个CPU系统的工作,运行所有部件并行计算光刻工艺,有助于减少电力需求和潜在环境影响。

在短期内,使用cuLitho的晶圆厂可以每天生产3-5倍以上的光掩模,芯片设计模板使用的功率比当前配置低9倍。之前一个光掩模所需的两周时间现在可以在一夜之间处理。从长远来看,cuLitho将提供更好的设计规则、更高的密度、更高的产量和人工智能光刻技术。

NVIDIA正在与主要合作伙伴合作,以推动这些新技术的快速采用。黄仁勋并预告台积电将把这套AI系统,在今年6月导入2纳米试产,用于提升2纳米制程良率,并缩短量产时程。

台积电CEO魏哲家表示,这一发展为TSMC在芯片制造中更广泛地部署光刻技术和深度学习等光刻解决方案提供了新的可能性,为半导体扩展的延续做出了重要贡献。

ASML首席执行官Peter Wennink表示,正计划将其集成到所有的计算光刻软件中,ASML与NVIDIA在GPU和cuLitho方面的合作,应该会给计算光刻带来巨大的好处,从而给半导体带来巨大的益处缩放比例,在高NA极紫外光刻的时代尤其如此。

Synopsys董事长兼首席执行官Aart de Geus表示,计算光刻,特别是光学邻近校正(OPC),正在突破界限,与NVIDIA合作,在cuLitho平台上运行Synopsys OPC软件,我们将性能从几周大幅提高到几天。

专为ChatGPT打造的H100 NVLINK

NVIDIA技术是AI的基础,黄仁勋讲述了NVIDIA如何在生成式AI变革初期就已参与进来。早在2016年,他就向OpenAl亲手交付了第一台NVIDIA DGX AI超级计算机一支持ChatGPT的大型语言模型突破背后的引擎。

去年年底推出的ChatGPT几乎在一夜之间爆火,吸引了超过1亿用户,成为有史以来增长最快的应用。黄仁勋认为“我们正处于Al的iPhone时刻”。在GTC大会上,他还宣布了专为ChatGPT设计的推理GPU(图形处理器)。

其中最主要的是H100 NVLINK,它将英伟达的两个H100 GPU拼接在一起,以部署像 ChatGPT这样的大型语言模型(LLM)。

黄仁勋表示,当前唯一可以实际处理ChatGPT的GPU是英伟达HGX A100。与前者相比,现在一台搭载四对H100和双NVLINK的标准服务器速度能快10倍,可以将大语言模型的处理成本降低一个数量级。

H100不是新的GPU,英伟达在一年前的GTC上展示了其Hopper架构,并在各种任务中加速AI推理(推理是机器学习程序部署的第二阶段,此时运行经过训练的程序以通过预测来回答问题)。英伟达表示,H100 NVL附带94GB内存,与上一代产品相比,H100的综合技术创新可以将大型语言模型的速度提高30倍。

据黄仁勋透露,H100 NVL预计将在今年下半年上市。

另外,为了加速企业使用生成式Al的工作,黄仁勋在此次大会上还发布了NVIDIA AI Foundations云服务系列,为需要构建、完善和运行自定义大型语言模型及生成式A的客户提供服务,他们通常使用专有数据进行训练并完成特定领域的任务。

Al Foundations服务包括NVIDIA NeMo,用于构建自定义语言文本-文本转换生成模型;Picasso视觉语言模型制作服务,适用于想要构建使用授权或专有内容训练而成的自定义模型的客户;以及BioNeMo,助力2万亿美元规模的药物研发行业的研究人员。

小结

在本次GTC开发者大会上,英伟达除了带来令人瞩目的计算光刻库cuLitho,专为ChatGPT打造的H100 NVLINK以及赋能生成式AI的NVIDIA AI Foundations云服务系列外,还带来了其他的技术进展,包括量子计算系统、视觉图像系统等。

新的AI技术和迅速蔓延的应用正在改变科学和各行各业,并为成千上万的新公司开辟新的疆域。在黄仁勋看来,这将是迄今为止最重要的一次GTC。

其中有两点最为引人瞩目,一是英伟达宣布了一项突破性技术——NVIDIA cuLitho计算光刻库,它将加速计算带入计算光刻领域,使ASML、TSMC和Synopsys等半导体领导者能够加速下一代芯片的设计和制造。

二是专为ChatGPT打造的H100 NVLINK,以及为赋能生成式AI发布的NVIDIA AI Foundations云服务系列。黄仁勋认为“我们正处于AI的iPhone时刻”。他说:“初创公司正在竞相打造颠覆性产品和商业模式,科技巨头也在寻求突破。”

计算光刻库cuLitho将光刻技术提高40倍

光刻工艺过程可以用光学和化学模型,借助数学公式来描述。光照射在掩模上发生衍射,衍射级被投影透镜收集并会聚在光刻胶表面,这一成像过程是一个光学过程;投影在光刻胶上的图像激发光化学反应,烘烤后导致光刻胶局部可溶于显影液,这是化学过程。

计算光刻就是使用计算机来模拟、仿真这些光学和化学过程,从理论上探索增大光刻分辨率和工艺窗口的途径,指导工艺参数的优化。

计算光刻是提高光刻分辨率、推动芯片制造达到2nm及更先进节点的关键手段。英伟达表示,这一进展将使芯片拥有比现在更小的晶体管和电线,同时加快上市时间,并提高全天候运行的大型数据中心的能源效率,以推动制造过程。

具体来看,NVIDIA cuLitho计算光刻库有哪些优势?在GPU上运行时,cuLitho的性能比目前的光刻技术提高了40倍。

据黄仁勋介绍,英伟达的H100需要89块掩膜板,如果用CPU进行处理的话,每个掩膜板都需要消耗两周的时间,而如果在GPU上运行cuLitho,则只需8个小时即可处理完一个掩膜板。

它使500个NVIDIA DGX H100系统能够实现40000个CPU系统的工作,运行所有部件并行计算光刻工艺,有助于减少电力需求和潜在环境影响。

在短期内,使用cuLitho的晶圆厂可以每天生产3-5倍以上的光掩模,芯片设计模板使用的功率比当前配置低9倍。之前一个光掩模所需的两周时间现在可以在一夜之间处理。从长远来看,cuLitho将提供更好的设计规则、更高的密度、更高的产量和人工智能光刻技术。

NVIDIA正在与主要合作伙伴合作,以推动这些新技术的快速采用。黄仁勋并预告台积电将把这套AI系统,在今年6月导入2纳米试产,用于提升2纳米制程良率,并缩短量产时程。

台积电CEO魏哲家表示,这一发展为TSMC在芯片制造中更广泛地部署光刻技术和深度学习等光刻解决方案提供了新的可能性,为半导体扩展的延续做出了重要贡献。

ASML首席执行官Peter Wennink表示,正计划将其集成到所有的计算光刻软件中,ASML与NVIDIA在GPU和cuLitho方面的合作,应该会给计算光刻带来巨大的好处,从而给半导体带来巨大的益处缩放比例,在高NA极紫外光刻的时代尤其如此。

Synopsys董事长兼首席执行官Aart de Geus表示,计算光刻,特别是光学邻近校正(OPC),正在突破界限,与NVIDIA合作,在cuLitho平台上运行Synopsys OPC软件,我们将性能从几周大幅提高到几天。

专为ChatGPT打造的H100 NVLINK

NVIDIA技术是AI的基础,黄仁勋讲述了NVIDIA如何在生成式AI变革初期就已参与进来。早在2016年,他就向OpenAl亲手交付了第一台NVIDIA DGX AI超级计算机一支持ChatGPT的大型语言模型突破背后的引擎。

去年年底推出的ChatGPT几乎在一夜之间爆火,吸引了超过1亿用户,成为有史以来增长最快的应用。黄仁勋认为“我们正处于Al的iPhone时刻”。在GTC大会上,他还宣布了专为ChatGPT设计的推理GPU(图形处理器)。

其中最主要的是H100 NVLINK,它将英伟达的两个H100 GPU拼接在一起,以部署像 ChatGPT这样的大型语言模型(LLM)。

黄仁勋表示,当前唯一可以实际处理ChatGPT的GPU是英伟达HGX A100。与前者相比,现在一台搭载四对H100和双NVLINK的标准服务器速度能快10倍,可以将大语言模型的处理成本降低一个数量级。

H100不是新的GPU,英伟达在一年前的GTC上展示了其Hopper架构,并在各种任务中加速AI推理(推理是机器学习程序部署的第二阶段,此时运行经过训练的程序以通过预测来回答问题)。英伟达表示,H100 NVL附带94GB内存,与上一代产品相比,H100的综合技术创新可以将大型语言模型的速度提高30倍。

据黄仁勋透露,H100 NVL预计将在今年下半年上市。

另外,为了加速企业使用生成式Al的工作,黄仁勋在此次大会上还发布了NVIDIA AI Foundations云服务系列,为需要构建、完善和运行自定义大型语言模型及生成式A的客户提供服务,他们通常使用专有数据进行训练并完成特定领域的任务。

Al Foundations服务包括NVIDIA NeMo,用于构建自定义语言文本-文本转换生成模型;Picasso视觉语言模型制作服务,适用于想要构建使用授权或专有内容训练而成的自定义模型的客户;以及BioNeMo,助力2万亿美元规模的药物研发行业的研究人员。

小结

在本次GTC开发者大会上,英伟达除了带来令人瞩目的计算光刻库cuLitho,专为ChatGPT打造的H100 NVLINK以及赋能生成式AI的NVIDIA AI Foundations云服务系列外,还带来了其他的技术进展,包括量子计算系统、视觉图像系统等。

新的AI技术和迅速蔓延的应用正在改变科学和各行各业,并为成千上万的新公司开辟新的疆域。在黄仁勋看来,这将是迄今为止最重要的一次GTC。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

gpu

+关注

关注

28文章

4795浏览量

129505 -

英伟达

+关注

关注

22文章

3857浏览量

92151

发布评论请先 登录

相关推荐

黄仁勋减持英伟达股票

在全球科技巨头市值竞争激烈的背景下,英伟达CEO黄仁勋近日做出了引人注目的投资决策。随着微软、苹果交替坐上全球股王的位置,且均创下了历史收盘

英伟达黄仁勋:坚守法规服务中国,展望人形机器人未来

在科技飞速发展的今天,英伟达作为图形处理器(GPU)领域的佼佼者,其一举一动都牵动着全球科技界的目光。近日,英伟

英伟达CEO黄仁勋展望AI与机器人新时代

在COMPUTEX 2024大会上,英伟达CEO黄仁勋发表了激动人心的演讲,他看好机器人即将跨入拥有更强感知能力和系统的全新时代。

英伟达CEO黄仁勋薪酬大涨60%,高达2.47亿元

据英伟达在5月15日发布的最新报告显示,黄仁勋在2024财年的薪酬高达2.47亿元,较前一财年的1.5亿元增长了惊人的60%。

英伟达黄仁勋:应对最坏情况,与台积电紧密合作

当日,第二届NVIDIA GPU技术会议正式启动。黄仁勋在此次国际记者会上,首先简要介绍了公司的供应链和产品组成情况。他指出,AI(人工智能

英伟达GPU打入芯片制造领域,cuLitho让光刻性能提升40倍!黄仁勋:我们正处在AI的iPhone时刻

英伟达GPU打入芯片制造领域,cuLitho让光刻性能提升40倍!黄仁勋:我们正处在AI的iPhone时刻

评论