前言

北京时间3月21日晚11点,一年一度的英伟达GPU技术大会GTC(Gpu Technology Conference)如期而至,吸引了超过25万名观众参与。

黄仁勋教主一如既往地穿着标志性的黑皮夹,进行了长达78分钟的主题演讲,逐一向观众披露了英伟达的最新产品——挑战芯片极限的计算光刻技术、ChatGPT专用GPU等,无一不是“核弹”级别的杀手锏。

黄仁勋表示,近40年以来,摩尔定律一直是引领计算机行业发展的重要规律,但在成本与功耗不变的情况下,这一定律已经逐渐放缓,各行各业都在寻找数字化转型,而英伟达要用技术重塑行业,“要成为颠覆者,而不是被颠覆者。要利用加速计算和AI,帮助企业应对这些挑战。”

野心勃勃的英伟达,不断用芯片推动AI技术,也正在用AI技术赋能芯片行业。

01

AI辅助制芯技术,将计算光刻提速40倍

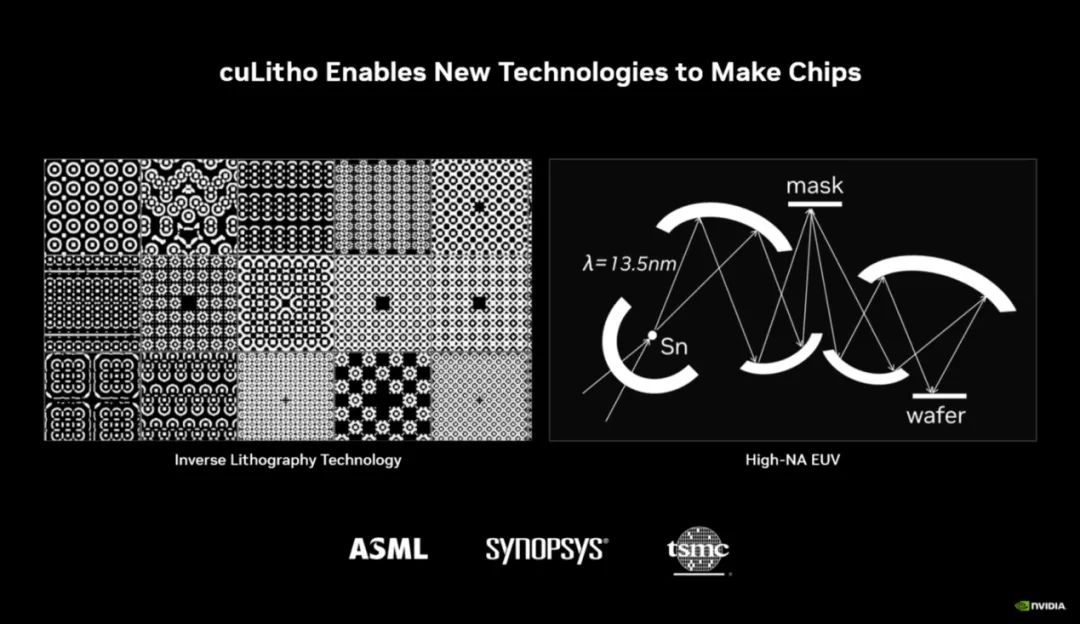

此次大会中,黄仁勋宣布了一项为芯片领域带来的重大突破——推出计算光刻软件库cuLitho,将加速计算带入计算光刻领域,使计算速度提升40倍。

黄仁勋称,英伟达经过与台积电、ASML、Synopsys(新思科技)三大半导体巨头的多年合作,终于推出了这一技术,大大降低芯片代工厂在这一工序上所消耗的时间和能耗,为2nm以及更先进制程的到来做好准备。

我们知道,光刻是芯片制造过程中的一个重要工艺,相当于用“光刀”在晶圆上“雕刻”出精细的电路图。这个图案首先要呈现在光掩膜(photomask)上。掩膜板就像是漏字板,激光一照,通过镜头,“漏字板”上的图案也就落到了硅片上,如下图:

晶体管、器件、互联线路都需要经过这样的光刻步骤。***巨头ASML也是靠着这一技术一直垄断着全球的EUV***。

ASML曾表示,计算光刻是其“铁三角”业务之一。计算光刻技术是通过模拟光通过光学元件并与光刻胶相互作用时的行为,应用逆物理算法来预测掩膜板上的图案,以便在晶圆上生成最终图案。

换言之,就是计算光刻是通过软件,对整个光刻过程来做建模和仿真,对工艺流程做优化,比如说形貌优化、掩膜板修正等。计算光刻目的是消除光刻过程中,小尺寸器件“模糊”的问题。

在芯片设计和制造领域中,计算光刻是最大的计算工作负载,每年都要消耗数百亿CPU小时。

随着晶体管和互联线宽的持续微缩,掩膜板的复杂度可能会越来越高。英伟达先进技术副总裁Vivek Singh说,foundry厂所需的数据中心规模扩张速度,会比摩尔定律本身的发展速度还要快;最终就是没有足够多的算力来解决问题。

“按照过去15年的趋势,如果某个foundry厂现有3座数据中心,那么未来10年内就需要100座这样的数据中心。”Vivek说道,“功耗方面,45兆瓦(MegaWatt)或许还行,但如果是45千兆瓦(GigaWatt),问题就比较大了。英伟达对此给出的回答是cuLitho。”

英伟达的新算法cuLitho,可以让日益复杂的计算光刻工作流程能够在GPU上并行执行,它不仅能使计算速度提升40倍,而且功耗也可以降低9倍之多。

举个例子,比如英伟达的H100在制造过程中需要89块掩膜板。如果用CPU进行处理的话,每个掩膜板都需要消耗两周的时间。

而如果在GPU上运行cuLitho,则只需8个小时即可处理完一个掩膜板。

而台积电也可以用500个DGX H100系统中的4,000个Hopper GPU,完成之前需要多达40,000台基于CPU的服务器才能搞定的工作,并且功率也会从35MW降至5MW。

英伟达抛出的这一技术,无疑相当于一枚芯片界的“核弹”,它使得2nm及更先进芯片的生产成为可能。未来,台积电、ASML、Synopsys也将引入这一技术,继续突破芯片制造的物理极限。台积电方面消息称,将于今年6月对cuLitho进行生产资格认证,加速2nm芯片试产。

02

ChatGPT专用GPU:H100 NVL——提速10倍

黄仁勋一直对AI和机器学习持倡导态,他曾公开表示AI技术已经来到拐点,押注AI十年也使得英伟达在ChatGPT浪潮中获得丰厚回报。对于大型语言模型而言,算力是其中最重要一环,因此高度依赖英伟达强大的GPU芯片。

针对算力需求巨大的 ChatGPT,英伟达发布了 NVIDIA H100 NVL,这是一种具有 94GB 内存和加速 Transformer Engine 的大语言模型(LLM)专用解决方案,配备了双 GPU NVLINK 的 PCIE H100 GPU。

黄仁勋的主题演讲中披露了该公司推出的全新GPU推理平台,该平台包括4种不同配置,针对不同工作负载进行优化,分别对应了AI视频加速、图像生成加速、大型语言模型(LLM)加速和推荐系统和LLM数据库。包括:L4 Tensor Core GPU、L40 GPU、H100 NVL GPU和Grace Hopper超级芯片。

其中最主要的是H100 NVL,它将英伟达的两个H100 GPU拼接在一起,以部署像ChatGPT这样的大型语言模型(LLM)。黄仁勋表示,“当前唯一可以实际处理ChatGPT的GPU是英伟达HGX A100。与前者相比,现在一台搭载四对H100和双NVLINK的标准服务器速度能快10倍,可以将大语言模型的处理成本降低一个数量级。”

据悉,H100 NVL附带94GB内存,与上一代产品相比,H100的综合技术创新可以将大型语言模型的速度提高30倍。据黄仁勋透露,H100 NVL预计将在今年下半年上市。

此外,用于AI Video的L4芯片,在视频解码和转码、视频内容审核、视频通话功能上做了优化。英伟达称其可以提供比CPU高120倍的AI视频性能,同时能效提高99%。

同时,英伟达还针对Omniverse、图形渲染以及文本转图像/视频等生成式AI推出了L40芯片。其性能是英伟达最受欢迎的云推理GPU T4的10倍。

英伟达推出的全新超级芯片Grace-Hopper,适用于推荐系统和大型语言模型的AI数据库,图推荐模型、向量数据库和图神经网络的理想选择,通过900GB/s的高速一致性芯片到芯片接口连接英伟达Grace CPU和Hopper GPU。

03

全球首个GPU加速量子计算系统

在21日的活动中,英伟达还官宣了一个使用 Quantum Machines 构建的新系统,该系统为从事高性能和低延迟量子经典计算的研究人员提供了一种革命性的新架构。

据黄仁勋介绍,NVIDIA DGX Quantum是全球首个GPU加速的量子计算系统,可以实现GPU和量子处理单元(QPU)之间的亚微秒级延迟。其将全球最强大的加速计算平台(由 NVIDIA Grace Hopper 超级芯片和 CUDA Quantum 开源编程模型实现)与全球最先进的量子控制平台 OPX(由 Quantum Machines 提供)相结合。这种组合使研究人员能够建立空前强大的应用,将量子计算与最先进的经典计算相结合,实现校准、控制、量子纠错和混合算法。

英伟达公司 HPC 和量子主管 Tim Costa 表示:“量子加速的超级计算有可能重塑科学和工业,英伟达 DGX Quantum 将使研究人员能够突破量子 - 经典计算的界限。“

对此,英伟达将高性能的 Hopper 架构 GPU 与该公司的新 Grace CPU 整合为”Grace Hopper“,为巨型 AI 和 HPC 应用提供了超强的动力。它为运行 TB 级数据的应用提供了高达 10 倍的性能,为量子 - 经典研究人员解决世界上最复杂的问题提供了更多动力。

总 结

在本次GTC大会上,黄仁勋说道,“加速计算并非易事,2012年,计算机视觉模型AlexNet动用了GeForce GTX 580,每秒可处理262 PetaFLOPS。该模型引发了AI技术的爆炸。”

“十年之后,Transformer出现了,GPT-3动用了323 ZettaFLOPS的算力,是AlexNet的100万倍,创造了ChatGPT这个震惊全世界的AI。崭新的计算平台出现了,AI的‘iPhone时刻’已经来临。”

显然,手握GPU算力技术的英伟达抓住了AI的关键时刻,在大模型军备竞赛中,英伟达赢得盆满钵满。ChatGPT在全球的爆火,就让英伟达股价飙升市值直接增加700多亿美元。

目前,英伟达市值为6400亿美元。而在Microsoft 365, Azure,Stable Diffusion,DALL-E……时下最红的AI产品中,英伟达都能分得一杯羹。

从大会发布的内容来看,英伟达对先进AI计算的支撑已经覆盖到从GPU、DPU等硬件到帮助企业加速构建定制生成式AI模型的云服务。或许正如黄仁勋所说,AI行业的”iPhone时刻“已来临,创业公司正在竞相建立颠覆式的商业模型,业界巨头也在寻找应对之道。

而英伟达正在成为AI“背后的巨人”。

审核编辑 :李倩

-

AI

+关注

关注

87文章

30857浏览量

269030 -

光刻技术

+关注

关注

1文章

146浏览量

15825 -

英伟达

+关注

关注

22文章

3775浏览量

91044

原文标题:黄教主深夜丢“核弹”,加速光刻领域2nm制程、最新GPU提速10倍……

文章出处:【微信号:WW_CGQJS,微信公众号:传感器技术】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

一文看懂光刻机的结构及双工件台技术

AI技术驱动半导体产业升级,芯原布局未来智能计算领域

《AI for Science:人工智能驱动科学创新》第二章AI for Science的技术支撑学习心得

光刻掩膜版制作流程

腾讯推出自主研发的AI引擎,工作效率提升超40倍

爱芯元智发布“爱芯通元AI处理器”

NextCentury利用芯科科技技术释放无线辅助计量潜力

斯坦福大学研发全新AI辅助全息成像技术

40 W SiC高压辅助电源SECO-HVDCDC1362-40W-GEVB数据手册

AI辅助制芯技术,将计算光刻提速40倍

AI辅助制芯技术,将计算光刻提速40倍

评论